感觉主要在于 point transformer layer层的设计和整个网络层的设计

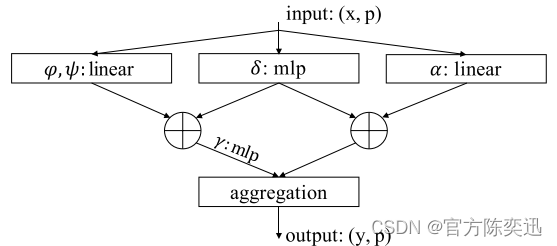

point transformer layer的设计

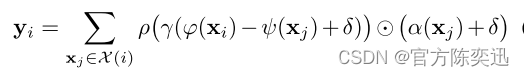

文章作者就提出了这样一个公式,其中X为该点的k个邻居,xj为第j个邻居,而ϕ(xi)为该点xi的q值,ψ(xj) 为邻居xj的k值,两者相减再加上δ(位置编码),得到的值进行一个mlp(即γ函数)得到attention中的权重,再利用ρ(例如softmax)进行归一化处理,而α(xj)为value值,加上位置编码后再与之前的值相乘就得到了点的重要程度。

MLP学习:包含关系

归一化处理和简化:减少训练消耗和达到更好的训练效果

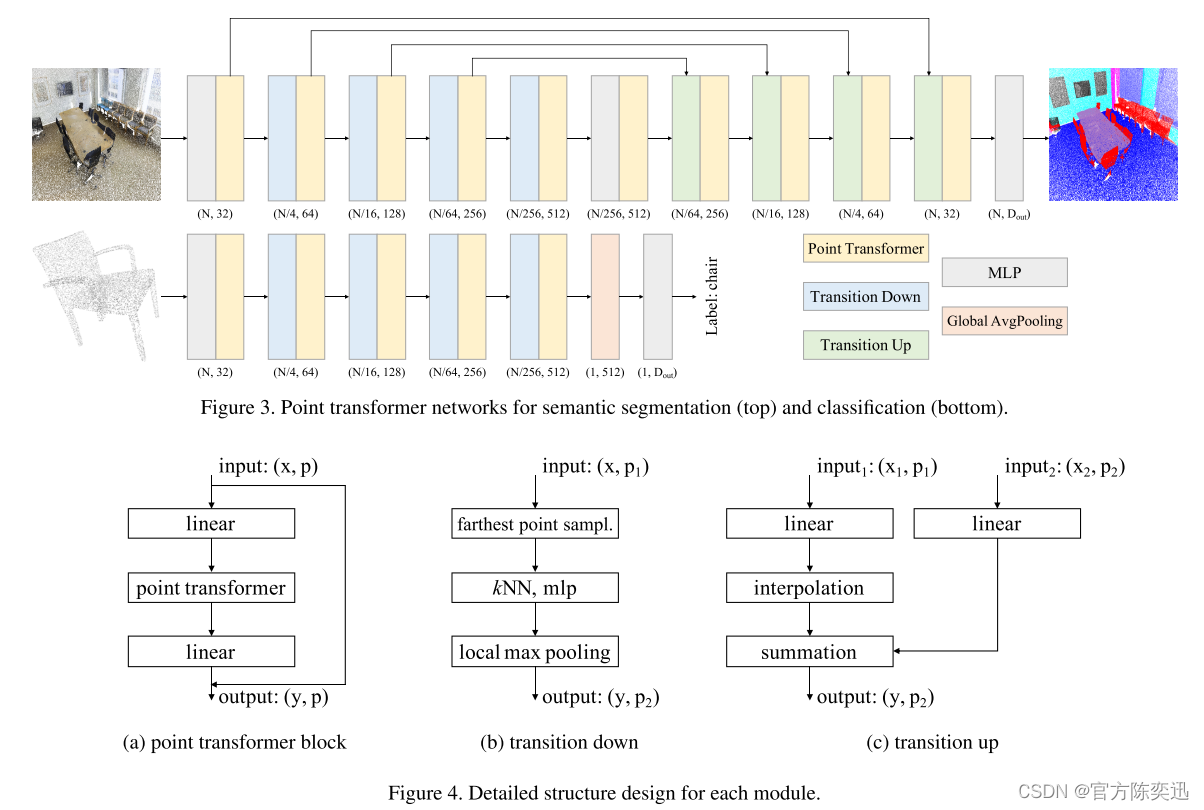

网络架构

transformer块

transformer down

transformer up

针对解决的问题

注意力机制的好处:自注意力本质上是一个集合操作符,位置信息作为元素的属性提供,这些元素被作为集合处理。由于3D点云本质上是具有位置属性的点集,因此自注意机制似乎特别适合于这类数据。

证明了位置编码在大尺度点云点云理解中的重要性。

为什么这样设计网络

点云的无序性和无规则性 天生的适合自注意力机制 将邻域点和中心点进行减法 ,提取出该特征来 送到MLP和非线性层 进行自注意力的池化,可以得到不同的邻域对于中心点的权重,实现自注意力机制,从而能够得到局部几何结构,由于这种机制是集合性质处理的,所以适合点云这种无序的数据。

如有不对 请多多指教

1368

1368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?