今天给大家带来 清华大学唐杰教授团队 最新的大模型综述论文。

本篇综述聚焦基础模型(FMs)的参数高效微调(PEFT)技术,且所有的文献清单已经给出链接(见文末),想要入坑的小伙伴们可以按照需要的分类去阅读学习。

文章开篇详述 FMs 的发展及分类,包括大语言模型、视觉基础模型等多种类型,同时介绍 PEFT 技术的兴起与核心类别,如选择性、添加性、提示、重参数化和混合 PEFT。

在技术方案上,对各类 PEFT 方法进行深入剖析,结合公式阐释其原理,并列举在不同 FMs 中的应用实例。

此外,文章指出当前 PEFT 存在超参数敏感、可解释性差和缺乏统一基准等问题,并提出跨学科融合、与持续学习结合、优化架构、探索缩放规律和借鉴大脑机制等未来研究方向。

本文亮点在于全面且系统地梳理了 PEFT 技术在各类 FMs 中的应用,为该领域研究人员提供了深入的见解和有价值的参考。

想要初步了解的可见推文,更推荐各位读者去阅读原文,本文非常适合该领域的研究人员反复阅读,从中寻找研究灵感。

【论文标题】

Parameter-Efficient Fine-Tuning for Foundation Models

【论文链接】https://arxiv.org/pdf/2501.13787v1

一、摘要

本文深入研究了基础模型(FMs)背景下的参数高效微调(PEFT)领域。

PEFT 是一种具有成本效益的微调技术,它在力求实现下游任务最佳性能的同时,尽量减少参数数量和计算复杂度。

诸如 ChatGPT、DALL-E 和 LLaVA 等基础模型,擅长语言理解、生成任务和多模态任务,它们在涵盖文本、图像和视频等多种类型的数据集上进行训练。基础模型的多样性决定了 PEFT 需采用多种适配策略。

因此,本文旨在全面概述应用于各类基础模型的 PEFT 技术,并解决在理解这些技术、趋势和应用方面存在的关键差距。

首先详细阐述了基础模型和 PEFT 的发展情况。

随后,系统回顾了跨不同基础模型的 PEFT 关键类别和核心机制,以提供对趋势的全面理解。

还探索了 PEFT 在各种基础模型中的最新应用,展示其通用性,阐明系统的 PEFT 方法与一系列基础模型的集成。

此外,识别出未来改进 PEFT 的潜在研发方向。对于希望理解和利用跨基础模型的 PEFT 能力的新手和专家而言,本综述提供了宝贵的资源。

二、背景

FMs在大规模数据集上进行预训练,可针对多种下游任务进行微调,广泛应用于语言理解、代码生成、图像与视频理解及生成等领域,

如 ChatGPT 用于语言任务,ChatGPT-4V 用于视觉语言任务。

在实际应用中,常需对基础模型在未见的下游数据集上微调以实现特定任务的性能提升。

参数高效微调技术在微调过程中展现出显著的成本效益,通过减少可训练参数和计算开销,有望达到接近全量微调的性能。

以 GPT-3 为例,全量微调涉及 1750 亿个参数,而 LoRA 只需训练 470 万或 3770 万个参数,节省超 99.97% 的参数,且结果相比全量微调有 0.1%-0.5% 的提升。

然而,基础模型的多样性导致 PEFT 的适配策略各不相同,例如提示调优中,不同类型的基础模型的可训练提示模块设计不同,LoRA 在不同架构的基础模型中的集成位置也不同。

因此,全面研究 PEFT 技术在不同基础模型中的应用至关重要。

同时,基础模型在结构、方法和应用方面快速迭代,推动 PEFT 领域不断发展。

通过统计过去五年各类基础模型中 PEFT 方法的总引用数作为趋势指标,发现该领域呈现显著增长,涵盖多种任务和基础模型;

大语言模型和视觉基础模型主导当前研究,视觉语言模型和视觉内容生成模型逐渐受到关注;

多模态基础模型相对研究较少,存在较大研究创新空间。

此外,虽已有相关综述,但这些综述对广义基础模型的见解较为分散,且缺乏对 PEFT 在各类基础模型中发展脉络的关注和统一直观的阐释,因此需要一篇结构清晰、全面的综述。

三、贡献

-

全面回顾了基础模型的发展趋势和 PEFT 的分类,详细介绍了不同类型基础模型(LLM、VFM、VLM、MFM 和 VGM)下的 PEFT 方法

包括选择性 PEFT、添加性 PEFT、提示 PEFT、重参数化 PEFT 和混合 PEFT,并分析了各方法的优缺点。

-

探讨了 PEFT 在不同下游任务和场景中的应用,分别阐述了在大语言模型、视觉基础模型和多模态基础模型中的具体应用情况。

-

对当前 PEFT 的研究趋势进行了观察,指出存在超参数敏感性、可解释性差和缺乏统一基准等问题,并提出了未来的研究方向

包括跨学科研究、持续学习与 PEFT 结合、优化 PEFT 架构、探索 PEFT 的缩放规律以及借鉴大脑机制改进 PEFT 等。

四、各种PEFT

4.1 选择性PEFT

选择性微调原始模型的部分参数或引入少量额外参数进行训练,分为特定选择和自动选择。

特定选择。如 Freeze Layers 仅微调基础模型的最后几层,BitFit 调整模型的部分或全部偏差项,PASTA 只更新特殊标记

特定选择。如 Freeze Layers 仅微调基础模型的最后几层,BitFit 调整模型的部分或全部偏差项,PASTA 只更新特殊标记

在自然语言理解任务中,PASTA 用 RoBERTa 训练仅 0.029% 的总参数,就能达到与全量微调相似的性能 。

自动选择。利用算法自动确定训练参数,如 Masking 基于直通估计器训练二进制掩码来选择性屏蔽参数;

Diff-Pruning 通过学习特定二进制任务,利用 Diff-vector 方法微调参数并通过 L0 范数正则化进行自适应剪枝;

FISH 创建 FISH 掩码选择具有最高 Fisher 信息的前 k 个参数进行更新;

AutoFreeze Layers 利用冻结模块和缓存模块加速模型微调;

CHILD-TUNING 基于策略识别子网络并生成掩码矩阵,公式为

其中 t 为迭代次数,w 是参数,是损失,是学习率,是掩码矩阵 。

在更多基础模型方面,Linear Probe 提出 CLIP 联合训练文本和图像编码器实现零样本预测;

FC-CLIP 利用共享冻结的卷积 CLIP 骨干构建单阶段开放词汇分割系统;

Tune-A-Video 提出文本-视频对调整和时空注意力机制用于文本到视频生成;

LayerNorm Tuning 仅调整注意力块内归一化层的权重,降低了 GPU 内存使用和可训练参数数量。

4.2 添加性PEFT

在基础模型层间插入小的适配器网络,核心思想是学习一组参数,以特定任务的方式将一层的输出转换为下一层的输入 。

在基础模型层间插入小的适配器网络,核心思想是学习一组参数,以特定任务的方式将一层的输出转换为下一层的输入 。

包括瓶颈适配器、多适配器和适配器稀疏性三种类型。

瓶颈适配器。受跨域图像分类任务中的 Residual Adapter 和 ResNet 启发

其结构是先下投影到较小维度,经过非线性激活函数,再上投影回原始维度,并存在残差连接 。

多适配器。通过添加更多适配器模块增强模型的可迁移性,如 Adapter Fusion 融合多个任务的适配器参数;

AdaMix 通过重建适配器结构融合知识;

MAD-X 包含可逆、语言和任务适配器,用于跨语言转移;

BAD-X 学习双语语言对适配器优化跨语言性能 。

适配器稀疏性。旨在充分利用适配器内部结构的参数效率,如 AdapterDrop 在训练时随机丢弃适配器以简化模型、减少计算和内存需求;

AdapterBias 引入与令牌相关的偏移;

SparseAdapter 从网络剪枝角度检查添加性 PEFT,在稀疏率达到 80% 时可实现与标准适配器相当甚至更好的性能;

LST 在预训练网络一侧训练小的变压器网络 。

在更多基础模型方面,LST 在 T5 和 CLIPT5 模型上评估,相比其他方法在相似参数使用下减少 69% 的内存成本;

Convpass 在 ViT 中引入卷积旁路作为视觉变压器适配器;

AdaptFormer 引入轻量级模块提升识别性能;

ViT-Adapter 增强标准 ViT 骨干的内在表示能力;

SAN 通过附加轻量级侧网络实现开放词汇语义分割;

CSN 利用紧凑侧网络解耦骨干网络的权重更新;

T2I-Adapter 学习轻量级适配器模式提升文本到图像模型性能;

IP-Adapter 使用图像提示和交叉注意力机制学习图像嵌入;

I2V-adapter 仅微调基础扩散模型 1% 的参数;

ControlNet 添加空间局部化条件;

ControlNeXt 引入轻量级条件控制模块;

LLaMA-Adapter V2 解锁更多可学习参数;

CLIP-Adapter 和 Tip-Adapter 等在固定 CLIP 模型中插入可训练适配器进行 VLM 微调。

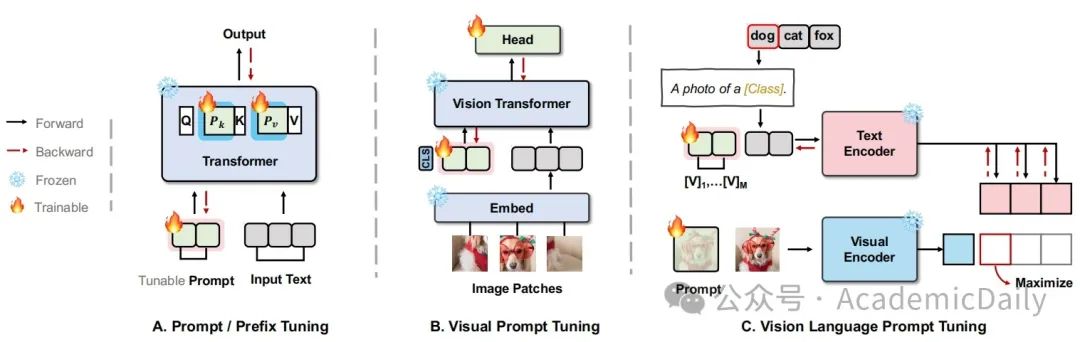

4.3 提示 PEFT

将精心设计的提示融入输入或变压器层,使输入分布与原始训练数据对齐,引导模型生成期望输出,包括硬提示、自动提示和软提示。

将精心设计的提示融入输入或变压器层,使输入分布与原始训练数据对齐,引导模型生成期望输出,包括硬提示、自动提示和软提示。

硬提示。通过手动指定模板并与输入连接来生成输出,如 PET 将输入示例重新表述为类似完形填空的句子,Null Prompts 使用 “input + [MASK]” 模板,但硬提示存在选择有效模板耗时费力、泛化能力有限的问题 。

自动提示。提出自动搜索提示的方法,通过探索性搜索自动生成提示,但生成的模板不一定是最优解 。

软提示。生成过程从离散的人为驱动转变为连续的机器驱动,如 Prefix Tuning 冻结基础模型参数,仅优化作为可微虚拟令牌的前缀;

Prompt Tuning 定义特定任务提示并附加到输入数据,还引入 Prompt Ensembling;

P-Tuning 将提示转换为可学习的嵌入层,通过 MLP 和 LSTM 结构处理;

P-Tuning v2 将提示扩展到模型的每一层,提高了可扩展性和通用性;

DART 将提示生成视为可微函数,实现基于梯度的优化;

PPT 通过自监督任务在大规模无标签语料库上预训练软提示;

SPoT 使用源任务训练的提示初始化目标任务提示;

Prompt Transfer 重用训练好的软提示进行零样本推理或继续训练 。

在更多基础模型方面,VP 通过在图像像素空间添加像素形式的提示使基础模型适应新任务;

VPT 在输入空间引入少于原始模型 1% 参数的可学习参数;

DAM-VP 通过自适应选择和优化视觉提示提升模型性能;

ILM-VP 引入迭代标签映射框架改进视觉提示;

EVP 将提示视为可学习实体,应用输入多样性和梯度归一化提高分类准确率;

LION 利用隐式平衡层实现高效视觉提示调优;

Textual Inversion 在 CLIP 的文本编码器中描述新概念以微调扩散模型;

CoOp 使用可学习向量对提示的上下文词进行建模;

OVSeg 通过添加掩码和彩色提示提高 VFM 微调性能;

Q-Former 通过轻量级投影弥合模态差距。

4.4 重参数化 PEFT

对初始模型参数的低维表示进行重新参数化训练,推理时将权重转换回原始形式,主要包括 LoRA 及其变体和 MPO。

LoRA 。利用机器学习问题中的低秩结构,为基础模型添加旁路,训练时仅更新低秩矩阵 A 和高秩矩阵 B,公式为

。

其变体。如 KronA 使用克罗内克积代替低秩矩阵,具有更强的表达能力;

QLoRA 通过使用冻结的 4 位量化基础模型,结合新的数据类型和优化器,实现在较小 GPU 上对大规模模型的微调;

LoRA-FA 冻结矩阵 A 的投影 - 下权重,仅更新矩阵 B 的投影-上权重,减少激活内存需求;

IncreLoRA 根据模块重要性动态添加可训练参数;

Delta-LoRA 不仅更新低秩矩阵,还调整预训练权重 。

MPO 。通过分解参数矩阵,仅训练低参数的辅助张量来适应下游任务 。

在更多基础模型方面,LoRand 利用低秩分解创建紧凑适配器;

LyCORIS 为微调 Stable Diffusion 模型提供工具;

DiffuseKronA 在扩散模型的注意力层中使用克罗内克积分解减少参数;

Mix-of-Show 提出 ED-LoRA 等方法用于训练单个概念和控制扩散模型;

LoRA-Sparse 为 LLaVA-1.5 开发低秩线性投影层增强多模态性能。

4.5 混合 PEFT

整合多种 PEFT 方法,如 UniPELT 集成适配器、前缀调优和 LoRA 的核心部分,通过门控机制调节各模块;

COMPACTER 创新适配器的放置和训练方法,基于低秩矩阵的克罗内克积引入轻量级适配器结构;

MAM adapter 研究适配器排列和软提示的使用,提出多头注意力适配器;

将层分为四组,应用不同的 PEFT 技术,在不同模型、尺寸和任务上表现优异。

在更多基础模型方面,NOAH 通过神经架构搜索设计提示模块,并将适配器、LoRA 和 VPT 集成到每个 Transformer 块中;

DiffFit 仅微调偏差项并引入缩放因子;

V-PEFT 基于视频任务对 PEFT 方法进行统一分析;

DreamBooth 利用少量图像和新的损失函数进行微调。

【项目链接】

https://awesome-peft-for-foundation-models.github.io/

【Github】

https://github.com/THUDM/Awesome-Parameter-Efficient-Fine-Tuning-for-Foundation-Models

五、如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方CSDN官方认证二维码,免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?