大语言模型 (LLM) 的兴起标志着人工智能 (AI) 时代的重大进步。在这一背景下,Paperspace + DigitalOcean 提供的云图形处理单元 (GPU) 已成为高质量 NVIDIA GPU 云服务的领先者,推动了计算技术的前沿发展。

NVIDIA 成立于 1993 年,由三位有远见的美国计算机科学家创立:Jen-Hsun (“Jensen”) Huang,LSI Logic 的前董事和 AMD 微处理器设计师;Sun Microsystems 的工程师 Chris Malachowsky;以及 IBM 和 Sun Microsystems 的高级工程师兼图形芯片设计师 Curtis Priem。他们专注于为游戏行业打造尖端图形硬件,这三位充满活力的专家和他们的热情为 NVIDIA 的非凡增长和创新奠定了基础。

随着技术的进步,NVIDIA 认识到 GPU 在游戏领域之外的潜力,开始探索并行处理的可能性。这促成了 2006 年 CUDA(计算统一设备架构)的开发,使全球开发人员能够利用 GPU 完成各种复杂的计算任务。这一创新为深度学习革命奠定了基础,也确立了 NVIDIA 在 AI 研发领域的领导地位。

NVIDIA 的 GPU 已成为 AI 不可或缺的一部分,为复杂的神经网络提供动力,并推动了自然语言处理、图像识别和自主系统等领域的突破。

H100 简介:NVIDIA 产品线的最新进展

随着 H100 GPU 的发布,NVIDIA 继续引领创新潮流。H100 GPU 代表了现代计算的巅峰之作,凭借其尖端的 Hopper 架构,将彻底改变深度学习领域,提供无与伦比的性能和效率。

NVIDIA H100 Tensor Core GPU 配备了 NVIDIA NVLink™ Switch System,允许多达 256 个 H100 GPU 连接在一起,以加速处理工作负载。此外,该 GPU 还配备了专用的 Transformer Engine,专为高效处理万亿参数的语言模型而设计。得益于这些技术进步,H100 的性能相比上一代提升了多达 30 倍,特别是在对话式 AI 中展现出尖端功能。

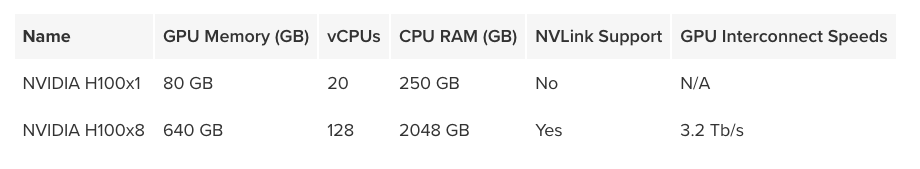

Tips:DigitalOcean 旗下 GPU 云服务平台 Paperspace 现已支持 NVIDIA H100,提供 NVIDIA H100x1 和 NVIDIA H100x8 两种选择,目前数据节点位于 NYC2。

有关 NVLink 的信息,请参阅 NVIDIA 的 NVLink 文档

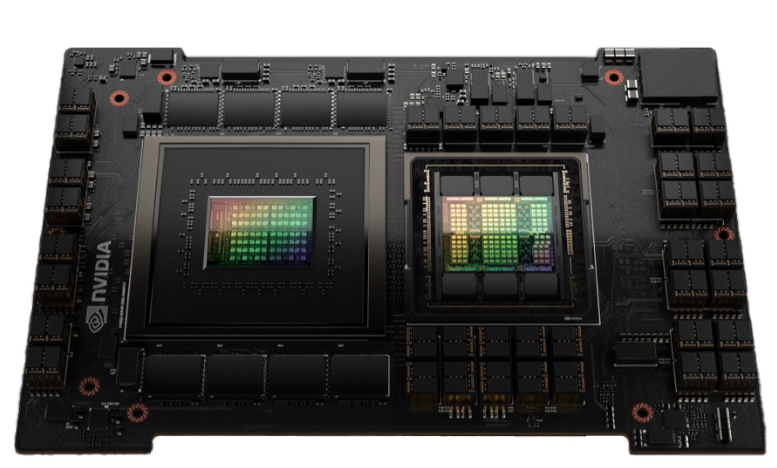

H100 的架构

NVIDIA Hopper GPU 架构为低延迟高性能计算而设计,旨在以数据中心规模运行。NVIDIA H100 Tensor Core GPU 基于 NVIDIA Hopper 架构,标志着 NVIDIA 数据中心平台计算性能的重大飞跃。H100 拥有 800 亿个晶体管,是 NVIDIA 有史以来最先进的芯片,并包含众多架构改进。

作为 NVIDIA 的第 9 代数据中心 GPU,H100 相较于之前的 A100 型号,为 AI 和 HPC 工作负载提供了显著的性能提升。通过 InfiniBand 互连,H100 为主流 AI 和 HPC 模型提供了高达 A100 30 倍的性能。全新的 NVLink Switch System还支持跨多个 GPU 的模型并行,以应对一些最具挑战性的计算任务。

格雷斯·霍珀超级芯片

- 基于 Hopper 架构的 H100 GPU 专为高性能计算和 AI 工作负载而设计。

- H100 提供第四代张量核心,与 A100 相比,可实现更快的芯片间通信。

- 结合软件和硬件优化,加速 Transformer 模型训练和推理,实现高达 9 倍的训练速度和 30 倍的推理速度。

- 第四代 NVLink 负责增加多 GPU 操作的带宽,提供 900 GB/秒的总带宽。

这些架构上的进步使 H100 GPU 在 AI 和 HPC 应用的性能和效率方面迈出了重要一步。

主要特点和创新

第四代 Tensor Cores:

- 第四代张量核心的芯片间通信速度比 A100 快 6 倍。

- 对于等效数据类型,每个流多处理器或 SM 提供 2 倍的矩阵乘法累加 (MMA) 计算速率。

- 与之前的 16 位浮点选项相比,使用新的 FP8 数据类型可提供 4 倍的 MMA 速率。

- 其中的稀疏性功能通过利用深度学习网络中的结构化稀疏性优化,使标准张量核心操作的性能提高一倍。

新的 DPX 指令:

- 与 A100 GPU 相比,动态规划算法的速度最高可提高 7 倍。

- 适用于基因组学的 Smith-Waterman 算法和动态环境中优化路线的 Floyd-Warshall 算法。

处理速度的提高:

- 由于更高的时钟和额外的 SM 数量,与 A100 相比,实现了 3 倍更快的 IEEE FP64 和 FP32 处理速度。

线程块集群特性:

- 扩展 CUDA 编程模型以包含线程、线程块、线程块群集和网格。

- 允许多个线程块在不同的 SM 之间同步和共享数据。

异步执行增强功能:

- 采用新的张量内存加速器 (TMA) 单元,可在全局内存和共享内存之间高效传输数据。

- 支持集群中线程块之间的异步数据复制。

- 引入异步事务屏障,实现原子数据移动和同步。

全新 Transformer 引擎:

- 将软件与定制的 Hopper Tensor Core 技术相结合,以加速 Transformer 模型的训练和推理。

- 使用 FP8 和 16 位精度自动管理计算,与 A100 相比,为大语言模型提供高达 9 倍的 AI 训练速度和 30 倍的 AI 推理速度。

HBM3 内存子系统:

- 提供的带宽几乎是上一代的两倍。

- H100 SXM5 GPU 是首款采用 HBM3 内存的 GPU,可提供 3 TB/秒的内存带宽。

增强型缓存和多实例 GPU 技术:

- 50 MB L2 缓存通过缓存大型模型和数据集部分来减少内存访问。

- 第二代多实例 GPU (MIG) 技术比 A100 提供大约 3 倍的计算能力和近 2 倍的内存带宽。

- MIG 支持最多七个 GPU 实例,每个实例都有用于视频解码和 JPEG 处理的专用单元。

机密计算和安全:

- 新增对机密计算的支持,以保护用户数据并防御攻击。

- 首个原生机密计算 GPU,为虚拟机 (VM) 提供更好的隔离和保护。

第四代 NVIDIA NVLink®:

- 与之前的 NVLink 版本相比,全归约操作的带宽增加了 3 倍,一般操作的带宽增加了 50%。

- 为多 GPU IO 提供 900 GB/秒的总带宽,性能比 PCIe Gen 5 高出 7 倍。

第三代 NVSwitch 技术:

- 通过改进的交换机吞吐量连接服务器和数据中心中的多个 GPU。

- 通过多播和网络内归约增强集体操作。

NVLink Switch System:

- 允许多达 256 个 GPU 通过 NVLink 连接,提供 57.6 TB/秒的带宽。

- 支持百亿亿次 FP8 稀疏 AI 计算。

PCIe Gen 5:

- 提供 128 GB/秒的总带宽,是 Gen 4 PCIe 带宽的两倍。

- 与高性能 CPU 和 SmartNIC/DPU 接口。

其他改进:

- 增强了强大的扩展能力,减少了延迟和开销,并简化了 GPU 编程。

数据中心创新:

- NVIDIA 加速数据中心部分讨论了基于 H100 的新型 DGX、HGX、融合加速器和 AI 超级计算系统。

- 有关 H100 GPU 架构和性能改进的详细信息将在专门的部分中进行深入介绍。

对 AI 未来的影响

在不断发展的 AI 领域中,GPU 已变得至关重要,尤其是在深度学习方面。H100 的并行处理和加速计算是其主要优势,其张量核心和架构显著提高了 AI 模型,特别是大语言模型 (LLM) 的性能,尤其在训练和推理过程中表现突出。这使得开发人员和研究人员能够更高效地处理复杂模型。

H100 的专用 Transformer Engine 优化了 Transformer 模型的训练和推理,这是许多现代 AI 应用(包括自然语言处理和计算机视觉)的基础。此功能加速了各个领域 AI 解决方案的研究和部署。

展望未来,blackwell 被视为 NVIDIA H100 和 H200 GPU 的继任者。未来的 GPU 更有可能专注于进一步提高效率和降低功耗,朝着更加可持续的方向迈进。此外,未来的 GPU 可能在平衡精度和性能方面提供更大的灵活性。

NVIDIA H100 GPU 被认为是 AI 和计算领域不可或缺的产品,正推动着 AI 技术的发展及 AI 在各行业的应用创新。

H100 在推进 AI 能力方面的作用

- 自动驾驶汽车和机器人:改进的处理能力和效率有助于开发 YOLO 等算法,使自动驾驶系统更加可靠,能够在复杂环境中运行。

- 金融服务:AI 驱动的金融模型和算法将受益于 H100 的性能提升,实现更快、更准确的风险评估、欺诈检测和市场预测。

- 娱乐和媒体:H100 在 AI 方面的进步将增强内容创建、虚拟现实和实时渲染,为游戏和娱乐带来更加沉浸和互动的体验。

- 研究和学术:处理大规模 AI 模型和数据集的能力,将使研究人员能够应对复杂的科学挑战,推动各学科的创新和发现。

- 人工智能与其他技术的融合:H100 的创新可能为边缘计算、物联网和 5G 铺平道路,实现更智能、更互联的设备和系统。

结论

NVIDIA H100 代表了 AI 和高性能计算领域的巨大飞跃。Hopper 架构和 Transformer Engine 成功树立了效率和功率的新标杆。展望未来,H100 对深度学习和 AI 的影响将继续推动创新,助力在医疗保健、自主系统和科学研究等领域取得更多突破,最终塑造下一个技术进步的时代。

目前 DigitalOcean 旗下 GPU 云服务平台 Paperspace 提供 NVIDIA H100 的实例,按秒计费,支持随时创建和取消 GPU 云实例。同时,Paperspace 还提供专用网络、云端备份,以及从模型训练到部署的一系列软件工具与服务,可大幅提升 AI 创业者们的开发与业务扩展效率。如需要详询更多产品方案细节以及目前库存情况,可联系 DigitalOcean 中国区独家战略合作伙伴卓普云。

85

85

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?