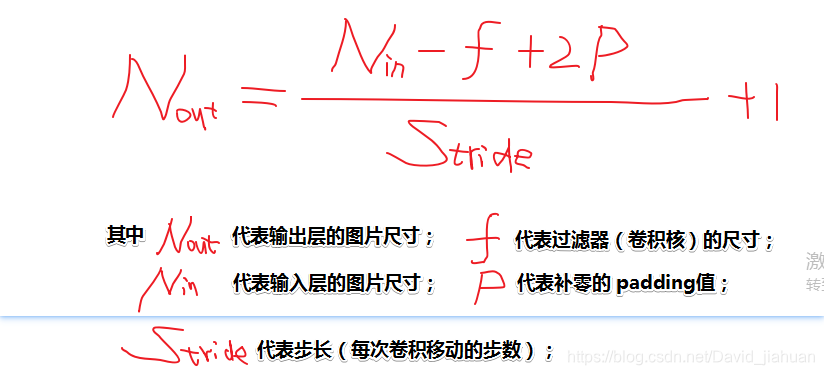

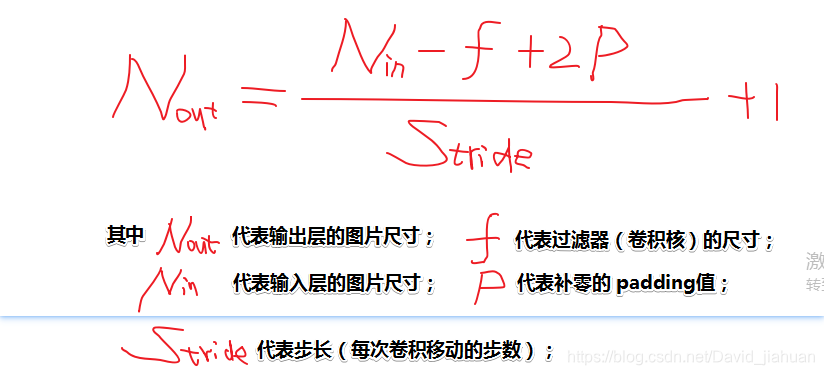

公式:

个人理解:

如果卷积时,设置padding的属性值是 SAME ,则表示【输出层尺寸 = 输入层尺寸】,此时我们就可以根据上面的公式来反推出padding的值(也就是 P 的值)!

例子:

如果卷积时,设置padding的属性值是 SAME ,则表示【输出层尺寸 = 输入层尺寸】,此时我们就可以根据上面的公式来反推出padding的值(也就是 P 的值)!

4004

4004

8990

8990

3532

3532

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?