原版论文是《Mastering the game of Go with deep neural networks and tree search》,有时间的还是建议读一读,没时间的可以看看我这篇笔记凑活一下。网上有一些分析AlphaGo的文章,但最经典的肯定还是原文,还是踏踏实实搞懂AlphaGo的基本原理我们再来吹牛逼吧。

需要的一些背景

对围棋不了解的,其实也不怎么影响,因为只有feature engineering用了点围棋的知识。这里有一篇《九张图告诉你围棋到底怎么下》可以简单看看。

对深度学习不怎么了解的,可以简单当作一个黑盒算法。但机器学习的基础知识还是必备的。没机器学习基础的估计看不太懂。

“深度学习是机器学习的一种,它是一台精密的流水线,整头猪从这边赶进去,香肠从那边出来就可以了。”蒙特卡罗方法

蒙特卡罗算法:采样越多,越近似最优解;

拉斯维加斯算法:采样越多,越有机会找到最优解;

举个例子,假如筐里有100个苹果,让我每次闭眼拿1个,挑出最大的。于是我随机拿1个,再随机拿1个跟它比,留下大的,再随机拿1个……我每拿一次,留下的苹果都至少不比上次的小。拿的次数越多,挑出的苹果就越大,但我除非拿100次,否则无法肯定挑出了最大的。这个挑苹果的算法,就属于蒙特卡罗算法——尽量找好的,但不保证是最好的。

作者:苏椰

链接:https://www.zhihu.com/question/20254139/answer/33572009蒙特卡罗树搜索(MCTS)

网上的文章要不拿蒙特卡罗方法忽悠过去;要不笼统提一下,不提细节;要不就以为只是树形的随机搜索,没啥好谈。但MCTS对于理解AlphaGo还是挺关键的。

MCTS这里的采样,是指一次从根节点到游戏结束的路径访问。只要采样次数够多,我们可以近似知道走那条路径比较好。貌似就是普通的蒙特卡罗方法?但对于树型结构,解空间太大,不可能完全随机去采样,有额外一些细节问题要解决:分支节点怎么选(宽度优化)?不选比较有效的分支会浪费大量的无谓搜索。评估节点是否一定要走到底得到游戏最终结果(深度优化)?怎么走?随机走?

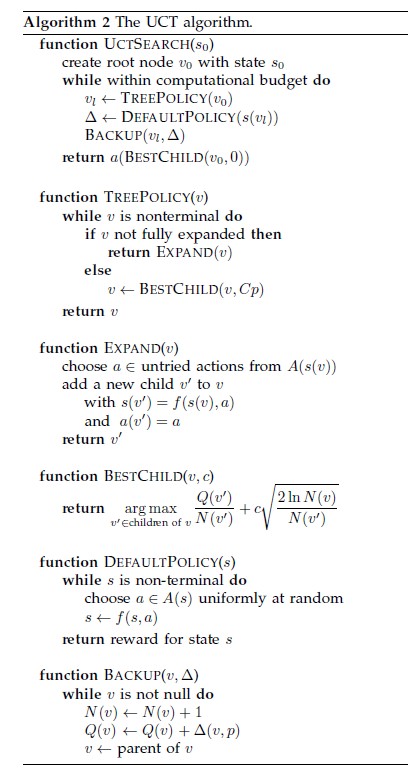

基本的MCTS有4个步骤Selection,Expansion,Simulation,Backpropagation(论文里是backup,还以为是备份的意思),论文里state,action,r(reward),Q 函数都是MCTS的术语。

图片展示了如何更新节点的胜率,选择胜率大的分支进行搜索(7/10->5/6->3/3),到了3/3叶子节点进行展开选择一个action,然后进行模拟,评估这个action的结果。然后把结果向上回溯到根节点。来自维基百科

具体的细节,可以参考UCT(Upper Confidence Bound for Trees) algorithm – the most popular algorithm in the MCTS family。从维基百科最下方那篇论文截的图。原文有点长,这里点到为止,足够理解AlphaGO即可。N是搜索次数,控制exploitation vs. exploration。免得一直搜那个最好的分支,错过边上其他次优分支上的好机会。

AlphaGo

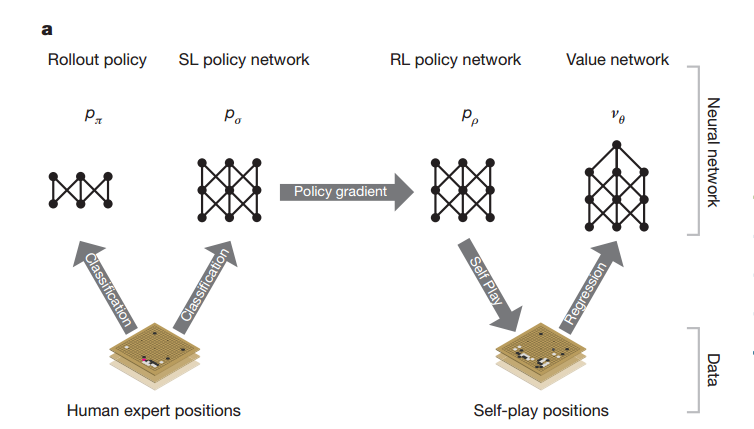

四大组件。最后只直接用了其中3个,间接用其中1个。

Policy Network ( Pσ )

Supervised learning(SL)学的objective是高手在当前棋面(state)选择的下法(action)。 Pσ=(a|s)

要点

1. 从棋局中随机抽取棋面(state/position)

2. 30 million positions from the KGS Go Server (KGS是一个围棋网站)。数据可以说是核心,所以说AI战胜人类还为时尚早,AlphaGo目前还是站在人类expert的肩膀上前进。

3. 棋盘当作19*19的黑白二值图像,然后用卷积层(13层)。比图像还好处理。rectifier nonlinearities

3. output all legal moves

4. raw input的准确率:55.7%。all input features:57.0%。后面methods有提到具体什么特征。需要一点围棋知识,比如liberties是气的意思

Fast Rollout Policy ( Pπ )

linear softmax + small pattern features 。对比前面Policy Network,

- 非线性 -> 线性

- 局部特征 -> 全棋盘

准确率降到24.2%,但是时间3ms-> 2μs。前面MCTS提到评估的时候需要走到底,速度快的优势就体现出来了。

Reinforcement Learning of Policy Networks ( Pρ )

要点

- 前面policy networks的结果作为初始值 ρ=μ

- 随机选前面某一轮的policy network来对决,降低过拟合。

- zt=±1 是最后的胜负。决出胜负之后,作为前面每一步的梯度优化方向,赢棋就增大预测的P,输棋就减少P。

- 校正最终objective是赢棋,而原始的SL Policy Networks预测的是跟expert走法一致的准确率。所以对决结果80%+胜出SL。

跟Pachi对决,胜率从原来当初SL Policy Networks的

本文基于《Mastering the game of Go with deep neural networks and tree search》论文,详细介绍了AlphaGo的核心技术,包括蒙特卡罗树搜索(MCTS)、Policy Network、Fast Rollout Policy和Value Network。通过深度学习和MCTS的结合,AlphaGo实现了对围棋的卓越表现。Policy Network使用监督学习预测高手棋路,Value Network则估算棋局的胜负概率。文中还讨论了SL与RL策略在网络搜索中的优势和差异。

本文基于《Mastering the game of Go with deep neural networks and tree search》论文,详细介绍了AlphaGo的核心技术,包括蒙特卡罗树搜索(MCTS)、Policy Network、Fast Rollout Policy和Value Network。通过深度学习和MCTS的结合,AlphaGo实现了对围棋的卓越表现。Policy Network使用监督学习预测高手棋路,Value Network则估算棋局的胜负概率。文中还讨论了SL与RL策略在网络搜索中的优势和差异。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?