【vibe算法介绍】

ViBe算法是一种高效的像素级视频背景建模和前景检测算法。以下是对该算法的详细介绍:

一、算法原理

ViBe算法的核心思想是通过为每个像素点存储一个样本集,利用该样本集与当前像素值进行比较,从而判断该像素是否属于背景。算法的主要步骤包括背景模型的初始化、前景检测过程和背景模型的更新方法。

- 背景模型的初始化:

- 在初始时刻(如第一帧图像),为每个像素点随机选择其邻域像素的像素值作为背景模型的样本值。这样可以确保背景模型在开始时即具有一定的鲁棒性。

- 前景检测过程:

- 对于后续的图像序列,算法会将每个新的像素值与背景模型中的样本进行比较。

- 如果新像素值与背景模型中的样本值差异小于预设的阈值,则该像素被判定为背景;否则,被判定为前景。

- 背景模型的更新方法:

- ViBe算法的更新策略具有时间和空间上的随机性。

- 在时间随机性方面,算法会随机选择一个背景模型进行更新,以模拟像素值随时间变化的不确定性。

- 在空间随机性方面,算法会在被判定为背景的像素点的邻域中随机选择一个像素值来更新背景模型,以模拟像素值在空间上的变化。

二、算法优点

- 内存占用少:由于每个像素只需存储一个样本集,因此内存占用较少。

- 性能优越:算法的性能优于混合高斯、参数化方法等传统方法,尤其在处理动态背景时表现出色。

- 无参数法:算法无需手动调整参数,可以直接应用于各种场景。

- 抗噪能力强:由于采用随机更新策略,算法对噪声具有较强的鲁棒性。

三、算法挑战与限制

- Ghost区域:在某些情况下,算法可能会出现误检,将前景物体误判为背景,形成所谓的“Ghost”区域。

- 环境变化适应性:算法需要能够适应环境的变化,如光照变化、相机抖动等。

- 密集物体检测:对于图像中密集出现的物体(如树叶、树干等),算法的检测效果可能受到一定影响。

综上所述,ViBe算法是一种高效、鲁棒的像素级视频背景建模和前景检测算法,具有广泛的应用前景。然而,在实际应用中仍需注意其挑战与限制,并进行相应的优化和改进。

【sort track算法介绍】

SORT(Simple Online and Realtime Tracking)算法是一种简单、高效且实用的多目标跟踪算法。以下是对SORT算法的介绍,内容将按照清晰的格式分点表示,并尽可能参考文章中的相关数字和信息:

一、算法概述

- 全称:Simple Online and Realtime Tracking(SORT)

- 特点:简单、高效、实时性强

- 应用领域:适用于各种需要实时多目标跟踪的场景,如监控视频分析、自动驾驶汽车感知、无人机追踪等

二、算法原理

1. 核心组件

- 卡尔曼滤波:用于预测目标在下一帧中的位置。卡尔曼滤波基于前一帧的目标位置和速度来预测当前帧的目标位置,并基于测量值(即检测到的目标位置)来更新预测值,以达到更精确的估计。

- 匈牙利算法:用于解决数据关联问题,即确定前后两帧中真正匹配的目标。匈牙利算法通过计算前后两帧目标之间的相似度矩阵,并求解该矩阵来找到最佳匹配。

2. 工作流程

- 目标检测:使用目标检测器(如Faster R-CNN)在每一帧中检测目标,得到目标框(Detections)。

- 预测:使用卡尔曼滤波器预测当前帧的轨迹(Tracks)。

- 匹配:将目标框(Detections)和轨迹(Tracks)进行IOU(Intersection over Union)匹配。匹配结果分为三种:

- Matched Track:成功匹配的目标和轨迹。

- Unmatched Tracks:未能成功匹配的目标轨迹,被认为是失配。如果失配持续了T次(T是一个预设的阈值),该目标ID将从待跟踪目标中删除。

- Unmatched Detections:未能成功匹配到轨迹的目标框,需要为其分配一个新的轨迹。

- 更新:卡尔曼滤波根据匹配的轨迹状态预测下一帧的目标框状态,并更新所有轨迹的状态。

三、算法特点

- 实时性强:由于算法复杂度低,SORT算法可以实现高速跟踪,据参考文章所述,追踪器可以实现260Hz的速度。

- 简单易用:代码结构清晰,依赖库少,便于理解和集成到其他项目中。

- 兼容性强:可在Windows和Linux环境下运行,适用范围广。

- 灵活性:提供参数调整,适应不同场景的需求。

四、优缺点

- 优点:

- 速度快:处理速度快,适用于实时应用。

- 准确性高:在没有遮挡的情况下,准确性较高。

- 缺点:

- 对遮挡处理不足:当目标被遮挡时,ID切换次数较高,可能导致跟踪不准确。

- 未考虑目标外观特征:仅使用检测框的位置和大小进行目标匹配,未考虑目标的外观特征。

五、总结

SORT算法以其简单、高效和实时性强的特点,在多目标跟踪领域具有广泛的应用前景。然而,在实际应用中仍需注意其处理遮挡和目标外观特征方面的限制,并根据具体需求进行相应的优化和改进。

【测试环境】

vs2019

opencv==4.8.0

x64 release(Debug暂时没测试通过)

【部分实现源码】

#define _CRT_SECURE_NO_WARNINGS

#include "tracker.hpp"

#include "trajectory.hpp"

#include "utils.hpp"

#include "vibe_sequential.hpp"

#include <array>

#include <chrono>

#include <cmath>

#include <cstddef>

#include <cstdio>

#include <cstdlib>

#include <memory>

#include <opencv2/core.hpp>

#include <opencv2/imgcodecs.hpp>

#include <opencv2/imgproc.hpp>

#include <opencv2/highgui.hpp>

#include <stdexcept>

#include <string>

#include <string_view>

#include <thread>

using namespace std;

using namespace cv;

int main(int argc, char* argv[]) {

int maxNumBlobs = 64;

VideoCapture capture("test.mp4");

if (!capture.isOpened())

return -1;

double fps = capture.get(cv::CAP_PROP_FPS); // 帧率

int width = capture.get(cv::CAP_PROP_FRAME_WIDTH); // 视频帧宽度

int height = capture.get(cv::CAP_PROP_FRAME_HEIGHT); // 视频帧高度

// Create vibe algorithm instance

auto vibe = std::make_unique<ViBeSequential>(height, width, 14, 20, 2, 5);

// Create tracker instance

auto tracker = std::make_unique<SortTracker>(3, 3);

auto detections = std::vector<cv::Rect2f>(8);

cv::Mat fgMask(height, width, CV_8U);

cv::Mat updateMask(height, width, CV_8U);

cv::Mat fgBlobLabels(height, width, CV_32S);

cv::Mat fgBlobCentroids(64, 2, CV_64F);

cv::Mat fgBlobStats(64, 5, CV_32S);

// Prepare structure elements for morphological filtering

cv::Mat se3x3 = cv::getStructuringElement(cv::MORPH_ELLIPSE, { 3, 3 });

cv::Mat se5x5 = cv::getStructuringElement(cv::MORPH_ELLIPSE, { 5, 5 });

cv::Mat se7x7 = cv::getStructuringElement(cv::MORPH_ELLIPSE, { 7, 7 });

// Prepare runtime measurement

auto tm = cv::TickMeter();

while (true)

{

Mat frame;

capture >> frame; // 从相机读取新一帧

if (frame.empty())

{

break;

}

/* Segmentation and update. */

tm.reset();

tm.start();

// Run background segmentation with ViBe

vibe->segment(frame, fgMask);

// Process update mask

cv::morphologyEx(fgMask, updateMask, cv::MORPH_OPEN, se3x3);

// Update ViBe

vibe->update(frame, updateMask);

// Post-processing on foreground mask

cv::morphologyEx(fgMask, fgMask, cv::MORPH_OPEN, se3x3);

cv::morphologyEx(fgMask, fgMask, cv::MORPH_CLOSE, se5x5);

tm.stop();

double vibeProcessTimeMs = tm.getTimeMilli();

// Find all connected components

int numFgBlobs = cv::connectedComponentsWithStats(

fgMask, fgBlobLabels, fgBlobStats, fgBlobCentroids);

if (numFgBlobs > maxNumBlobs) {

// Too many blobs, consider this frame invalid

tracker->clear();

continue;

}

detections.clear();

for (int i = 1; i < numFgBlobs; i++) {

auto* blobStat = fgBlobStats.ptr<int>(i);

int x = blobStat[cv::CC_STAT_LEFT] - 6;

int y = blobStat[cv::CC_STAT_TOP] - 6;

int w = blobStat[cv::CC_STAT_WIDTH] + 12;

int h = blobStat[cv::CC_STAT_HEIGHT] + 12;

// int a = blobStat[cv::CC_STAT_AREA];

// Add new bbox

detections.emplace_back(x, y, w, h);

// auto color = colors.row(i % colors.rows);

cv::rectangle(frame, { x, y, w, h }, { 255, 50, 0 }, 1);

}

tm.reset();

tm.start();

// Update tracker with newly detected bboxes

tracker->update(detections, frame);

tm.stop();

double trackingTimeMs = tm.getTimeMilli();

std::array<char, 64> str;

std::sprintf(str.data(),

"[PROCESS TIME] ViBe: %.2f ms, Tracking: %.2f",

vibeProcessTimeMs,

trackingTimeMs);

// Draw process time measurement result on current frame

cv::putText(frame,

str.data(),

{ 12, 30 },

cv::FONT_HERSHEY_SIMPLEX,

0.5,

{ 0, 0, 255 },

1,

cv::LINE_AA);

cv::imshow("frame", frame);

cv::imshow("fgmask", fgMask);

cv::imshow("update mask", updateMask);

if (char(waitKey(2)) == 'q')

{

break;

}

}

capture.release();

cv::destroyAllWindows();

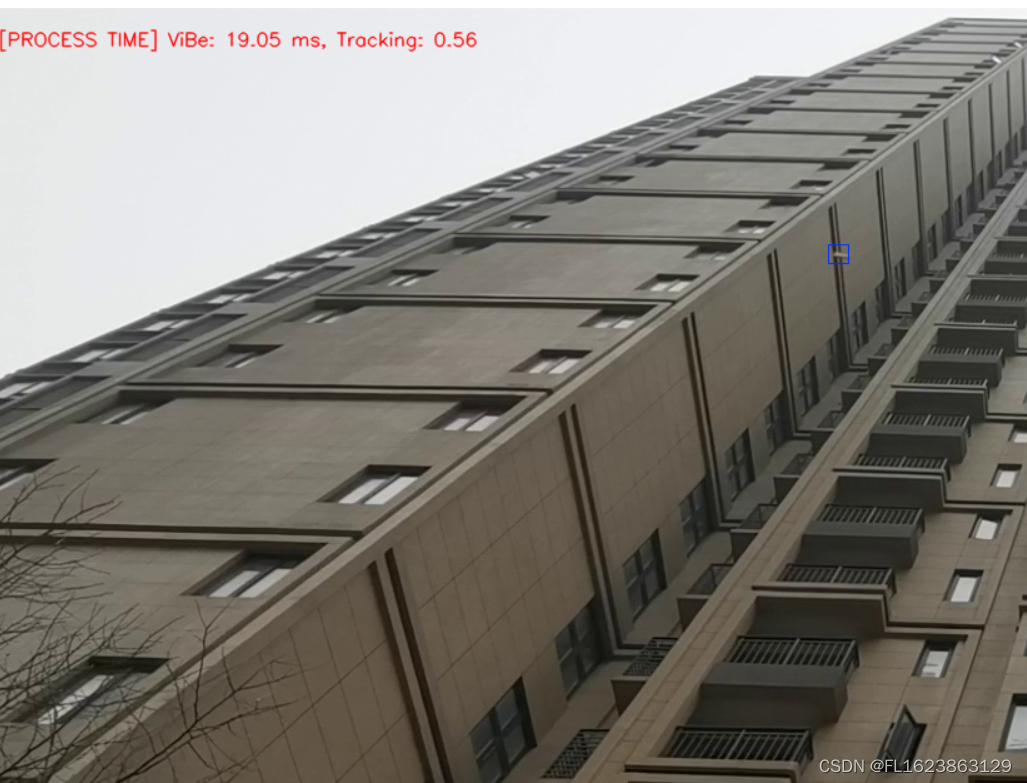

}【效果展示】

【视频演示】

【源码下载地址】https://download.csdn.net/download/FL1623863129/89403409

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?