2024 年 4 月 17 日,MiniMax 正式推出abab 6.5 系列模型。万亿 MoE 模型 abab 6.5, 在各类核心能力测试中,abab 6.5 开始接近 GPT-4, Claude 3 Opus, Gemini 1.5 Pro 等世界上最领先的大语言模型。

在 MoE 还没有成为行业共识时,MiniMax 花了 80% 以上的精力下注 MoE,并于今年 1 月,发布了国内首个基于 MoE 架构的 abab 6。在过去的三个月里,我们进一步地挖掘了 MoE 架构的潜力,研发出了更强大的 abab 6.5。

这个过程中,我们找到了越来越多加速实现 Scaling Laws 的途径,包括改进模型架构,重构数据 pipeline,训练算法及并行训练策略优化等。今天发布的 abab 6.5 和 abab 6.5s 是我们加速 Scaling Laws 过程的阶段性成果。

abab 6.5 系列包含两个模型:abab 6.5 和 abab 6.5s。abab 6.5 包含万亿参数,支持 200k tokens 的上下文长度;abab 6.5s 跟 abab 6.5 使用了同样的训练技术和数据,但是更高效,支持 200k tokens 的上下文长度,可以 1 秒内处理近 3 万字的文本。

核心能力测试

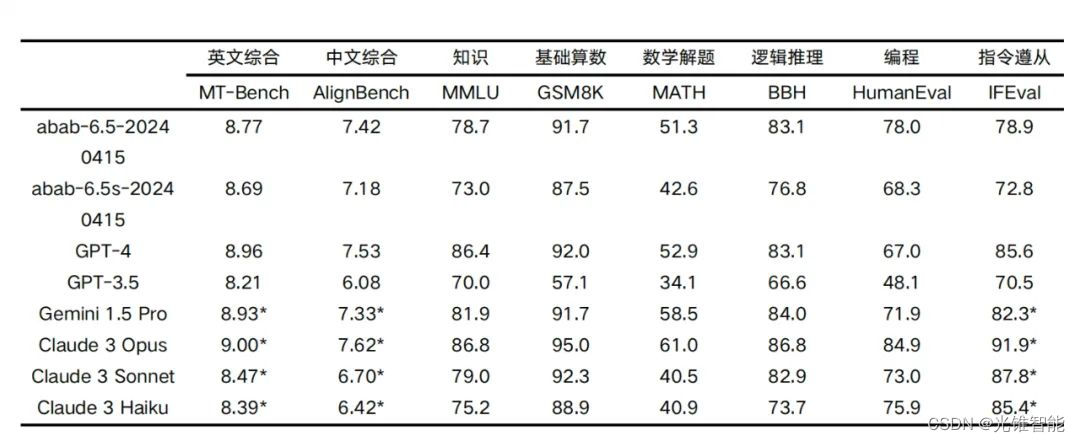

我们用业界标准的开源测试集来测试两个模型,在知识、推理、数学、编程、指令遵从等维度上和行业领先的语言模型进行了对比

标注星号的为我们调用API测试得到的结果,其余分数来自对应的技术报告

我们在 200k token 内进行了业界常用的“大海捞针”测试,即在很长的文本中放入一个和该文本无关的句子(针),然后通过自然语言提问模型,看模型是否准确将这个针回答出来。在 891 次测试中,abab 6.5 均能正确回答。

abab 6.5 和 abab 6.5s 会滚动更新到 MiniMax 旗下的产品中,包括生产力产品海螺 AI 和 MiniMax 开放平台上。欢迎大家使用。

MiniMax推出的新模型abab6.5在MoE架构上取得重大突破,其万亿参数版本在核心能力测试中接近GPT-4水平,展示了强大的知识和推理能力。abab6.5s作为高效版本,也加入了产品线,支持大规模文本处理。

MiniMax推出的新模型abab6.5在MoE架构上取得重大突破,其万亿参数版本在核心能力测试中接近GPT-4水平,展示了强大的知识和推理能力。abab6.5s作为高效版本,也加入了产品线,支持大规模文本处理。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?