前言

本期为大家介绍如何通过Ollama部署本地大模型,Dify如何接入Ollama部署的本地大模型,以及脱离Dify如何方便使用大模型。

本期具体内容包括

- Ollama下载安装

- 大模型部署(以deepseek为例)

- Dify接入本地大模型

- 通过chatbox使用本地大模型(额外内容)

如果只想本地部署大模型可以只看1、2,如果想要通过Dify接入本地大模型可以看1、2、3,如果想脱离Dify直接方便的使用本地大模型可以看1、2、4。

1、Ollama下载安装

大模型的本地部署方式有很多,可以直接部署,也可以借助其他工具进行部署,为了方便使用和管理,通常是借助其他工具进行部署,例如Ollama或者LM Studio,相比于LM Studio,Ollama下载模型方便且兼容性好,但是安装会稍微麻烦一点而且没有界面,不过这些都好解决。

首先进入Ollama的官网https://ollama.com/,然后点击Download即可,这一步可能需要挂vpn,否则会访问不了

下载好后,打开安装包即可安装,对于Windows用户来说一路点击下一步就好了,Ollama默认是安装到C盘,如果想迁移到其他路径可以期待下一期文章。

安装完成之后可以进行一下验证,打开cmd,输入ollama,如果像下面这样显示即表示安装成功了。

安装成功后可以在系统变量设置一下模型的下载路径,在桌面找到“此电脑”,右键“属性”,然后点击“高级系统设置”,找到“环境变量”,在系统变量下点击“新建”,在变量名输入“OLLAMA_MODELS”,在变量值输入自己想放置模型的路径。

重启一下Ollama,注意一定要重启,否则环境配置不生效,下载的模型还是默认在C盘。

2、大模型部署(以deepseek为例)

安装完Ollama后,即可依托Ollama进行大模型的部署,此处有两种办法,一种是在线安装,直接在Ollama的模型库里找,然后通过命令安装,Ollama会自动下载并部署模型;另一种是离线安装,离线安装是指从其他资源网站下载好模型(.gguf文件),例如从hugging face上下载模型,然后通过modlefile文件进行安装。此处以在线安装作为示例。

首先进入Ollama官网,点击Models,进入模型资源库。

随便选择一个模型,此处以deepseek-r1:1.5b为例,注意名称一定要和官网名称一致。

打开cmd,输入ollama run deepseek-r1:1.5b,即开始自动拉取模型,等待完成即可。

完成后即可开始对话,此时由于ollama没有界面,所以只能通过cmd进行对话。

后续可以通过打开cmd,输入ollama run 模型名称 使用,如果不清楚已经安装的模型具体名称,可以输入 ollama list 查看。

第3步将介绍怎么在Dify中接入和使用本地大模型,第4步将介绍通过chatbox在可视化的界面中使用大模型。

3、Dify接入本地大模型

完成大模型的本地部署后,暂时还不能在Dify中使用,还需要进行一些配置。

注:Dify的安装可以查看上一期文章

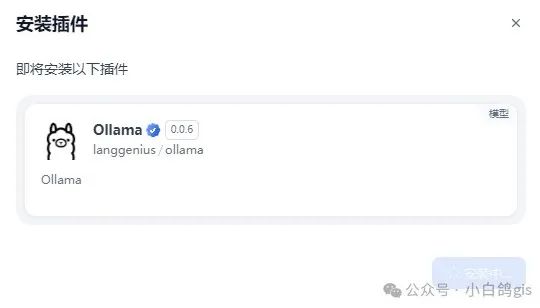

首先,打开浏览器,输入http://localhost/apps进入Dify,点击页面右上角头像的设置,在模型供应商中找到Ollama并点击安装。

等待安装完成后进行模型配置,此处配置包括两部分,一个是LLM模型配置,所谓LLM即是大语言模型,此处可以是deepseek的模型也可以是chatgpt的模型或者是其他模型,其主要作用就是对话;另一个是Text Embedding模型,也叫文本嵌入模型,它是应用于知识库的模型,其主要功能是把知识库中的文本转换成向量,因为计算机无法直接理解自然语言,但是当把自然语言转换成向量之后,就可以通过数学的方式去进行理解和计算,例如你输入一个问题,从知识库中获得结果,本质就是把问题转换成向量并在知识库中检索和问题相似度最高的向量。此处可以用deepseek-r1模型进行配置,也可以使用其他专门的模型进行配置。

在模型名称中填写上一步下载的模型,如果不知道模型名称可以打开cmd,输入ollama list查看已经安装的模型。基础URL代表的是Ollama 服务地址,Ollama是默认暴露11434端口进行API调用,如果Dify是通过Docker部署的话,在基础URL中填入http://host.docker.internal:11434即可,如果是其他方式部署的Dify,可以参考帮助文档:https://docs.dify.ai/zh-hans/development/models-integration/ollama。剩余参数保持默认即可。最后点击保存

如果保存按钮变成灰色并且迟迟没有保存成功,可以参考一下步骤重新启动Dify的Docker服务以及重新启动大模型。

进入到Dify的工程文件,找到docker文件夹里的.env文件,用记事本打开,并在最后添加以下内容:

#启用自定义模型

CUSTOM_MODEL_ENABLED=true

#指定ollama的API地址

OLLAMA_API_BASE_URL=host.docker.internal:11434

按照下图步骤重启docker服务,并且运行模型

完成配置后可以看到两个模型都处于开启状态,此时即可在Dify中使用本地大模型。

回到Dify的工作空间,在“工作室”中创建空白应用,此处以工作流为例,点击工作流,输入名称和描述创建。

在工作流中添加LLM节点,点击节点可以在右侧进行配置,点击模型可以切换为刚才安装的deepseek-r1:1.5b模型

4、通过chatbox使用本地大模型

仅通过Ollama部署的本地大模型如果不借助其他工具只能在cmd中进行对话使用,如果想在可视化的界面中使用本地大模型,可以考虑使用chatbox这类的AI客户端,chatbox的优点在于轻量化和高性能。

首先进入官网https://chatboxai.app/zh?ref=tian 下载chatbox,下载完成后一路点击下一步即可安装。

安装完成后打开软件,会弹出提示框,选择使用自己的API Key或本地模型,或者可以点击设置进入配置界面。

在模型栏填入API域名和模型名称,点击保存。

注意:配置前需要先启动Ollama并运行模型。

新建一个对话,此时可以看到配置的模型已经成功应用了。

后话

先运行模型: 无论是在Dify还是在chatbox中使用本地大模型,都需要先运行模型,运行方法是 ollama run 模型名称。

最后的最后

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1056

1056

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?