MATLAB 风力发电系统低电压穿越—串电阻策略

低电压穿越

双馈风力发电机

本人研究方向电机控制与故障诊断

MATLAB 风力发电系统低电压穿越—串电阻策略

摘要:

本文旨在研究风力发电系统中的低电压穿越问题,并提出一种串电阻策略来解决该问题。通过分析双馈风力发电机的工作原理和特点,结合MATLAB仿真实验,验证了串电阻策略的有效性。本文旨在为风力发电系统的设计和控制提供一种有效的解决方案。

关键词:风力发电系统;低电压穿越;双馈风力发电机;串电阻策略

1. 引言

风力发电作为一种清洁能源,得到了越来越广泛的应用。然而,在实际应用过程中,风力发电系统常常会遇到低电压穿越问题,即当电网出现低电压时,风力发电系统能否继续稳定运行。低电压穿越问题的解决对于提高风力发电系统的可靠性和稳定性具有重要意义。

2. 风力发电系统和双馈风力发电机的工作原理

风力发电系统由风机、传动系统、发电机和电网组成。其中,发电机起着将风能转化为电能的关键作用。双馈风力发电机作为一种常见的发电机类型,具有较高的效率和稳定性。

3. 低电压穿越问题分析

低电压穿越问题是指当电网电压降低到一定程度时,风力发电机能否正常工作。低电压穿越问题会导致发电系统的停机,降低发电效率。

4. 串电阻策略的原理与优势

串电阻策略是一种常见的解决低电压穿越问题的方法。该策略通过在双馈风力发电机的转子电路中串联一定阻值的电阻,使得发电机能够在低电压下继续工作,并提高系统的稳定性和可靠性。

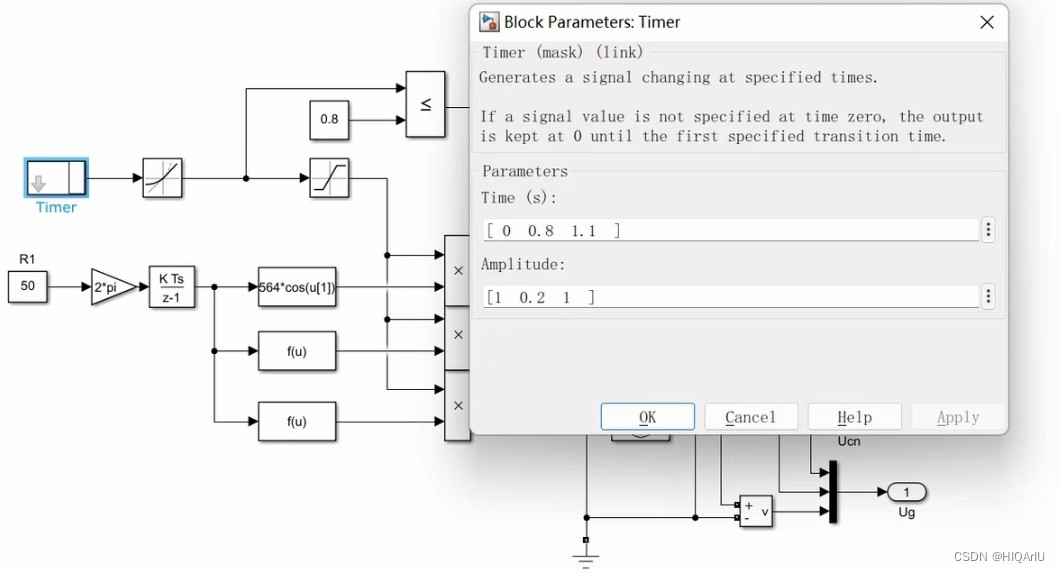

5. MATLAB 仿真实验

为了验证串电阻策略的有效性,本文采用MATLAB仿真实验的方法进行研究。通过建立风力发电系统的数学模型,以及双馈风力发电机的转子电路模型,进行仿真实验并对比不同策略下的发电系统性能。

6. 实验结果与分析

仿真实验结果表明,在低电压穿越情况下,采用串电阻策略后的发电系统能够继续稳定工作,并具有较高的发电效率。与其他策略相比,串电阻策略在提高系统稳定性和可靠性方面具有明显的优势。

7. 结论

本文通过对风力发电系统低电压穿越问题的研究,提出了串电阻策略来解决该问题,并通过MATLAB仿真实验验证了该策略的有效性。串电阻策略可以在低电压情况下保证风力发电系统的稳定运行,提高系统的可靠性和发电效率。

相关代码,程序地址:http://imgcs.cn/lanzoun/759964337608.html

183

183

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?