本文为人工智能研究员Patrick Mineault在美国国立卫生院(NIH)神经伦理工作小组的讲稿,有删改。大模型是AI发展的新产物,本文将简单介绍大模型,并着重讨论其在神经科学领域的应用与风险。

作者 · Author

Patrick Mineault

人工智能研究员和神经技术专家

Amaranth Foundation 的Neuro AI研究员。Mila人工智能研究所担任高级机器学习科学家。在麦吉尔大学视觉神经科学博士毕业,导师是Chris Pack,并在加州大学洛杉矶分校进行了博士后研究,导师是Dario Ringach。研究大脑如何创建可以驱动行为的有意义的视觉表征。曾经在谷歌工作,研究人们如何查看和与网页互动;并在脸书现实实验室担任脑机接口工程师,开发了一种可以通过大脑打字的脑机接口。共同创立有Blindsight Therapeutics公司,担任首席技术官并建立了知识产权组合,以帮助有皮质性失明的人通过Neuro AI取得突破。

无论是GPT、Llama这样的大语言模型,还是Stable Diffusion、Suno这样生成图片和音频的AI,大模型已经成为我们日常生活的一部分。此外,AlphaFold这种专门针对蛋白质结构的大模型,把它们的用途从日常扩展到了科研领域。

所以,究竟什么是大模型?

与其给出一个冗长、晦涩的严格定义,不如介绍一下大模型的几个标志,并看看大语言模型Llama 3.1-405B-Chat(以下写为Llama405)[1]是如何满足它们的:

(1)大模型一定要够大

这不仅仅只是模型本身的参数量要大,训练模型的数据集也要大。而这两者的大直接导致了大模型巨大的算力消耗。

Llama405有4050亿个参数,远远大于单个GPU的显存容量。它的训练集包含15.6万亿个token(被计算机分割后的信息片段)。这些数据量就算放到整个互联网上也相当可观,如果想让一个人把这些token全部写出来,那么他需要花上几万年。此外,Llama405还花费了大量算力,动用了16,000块H100 GPU,共花费3930万GPU小时。平均下来,每块GPU需工作差不多100天。获得这些算力的市场价是8千万美元,如果算上500个项目开发者的工资[2],成本大概率再翻一倍。

(2)大模型是模块化的

它们本身只会接受预训练,开发者可以根据自己的业务需要对模型进行微调。大模型也可以像乐高一样跟其他的AI模型进行拼接,实现全新的功能。

部署Llama405的人可以使用监督微调(SFT)和DPO对Llama405进行微调以适应不同场合。Llama本身也是一个拼接怪,比如它图片转文字的能力就来自于CLIP。CLIP自己就是一个独立的图片转文字大模型,它的训练集是25亿张具有文字标注的图片。

(3)对于大模型而言,数据比架构更重要

大模型会采用低归纳偏置(Inductive Bias)的通用架构,现在一般是Transformer。这类架构几乎不会对数据的性质做出任何预设,但是非常适用于大规模训练。因此,大模型的表现可以根据数据集大小、计算量、和模型大小进行预测,这就是大名鼎鼎的缩放定律(Scaling Laws)[3]。

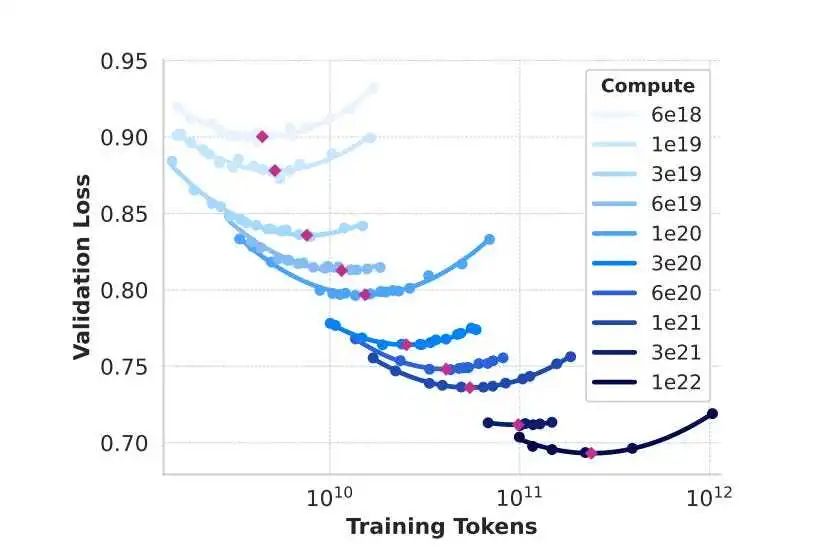

Llama405基于Transformer架构,架构本身较于旧版Llama区别不大。如果训练Llama的算力有限,那么开发者可以利用缩放定律,计算出大模型的最优数据量-参数量配比,将性能最大化。(图1)

▷图1. 根据缩放定律,我们可以计算出不同参数量的Llama,在不同的训练数据量和算力消耗下预期的表现。

(4)大模型能力会泛化

有时候大模型会获得不与训练任务直接相关的新能力,即能力泛化。如Llama405虽仅被训练于文本生成,但却涌现出逻辑推理、生成代码、数学计算的能力(图2)。

▷图2. Llama405在给定的训练任务(续写句子)以外的领域表现优秀。

大模型的开放程度各不相同。像****GPT4这样的闭源模型是最封闭的模型,其他人并不能获得模型,只能通过网页和API与其交互。最开放的模型叫做开源模型,除了模型以外,训练它的代码和数据集也可以被自由地获取,任何有足够算力的个人或机构都可以复现模型的训练过程。开放权重模型则介于二者之间:模型公开,但其代码和数据集则未必。Deepseek R1和Llama 3就属于此类。一些人把他们称为“开源模型”,实际上是一种误解。

大模型不同于普通AI的特征,给其带来了伦理上的全新挑战。首先,因为大模型对算力的庞大需求,普通的大学实验室不可能训练他们。有一种应对方式,是建立整合学界计算资源的大型机构,比如国家深度推理组织(National Deep Inference Fabric)[4]。另外一种办法则是将研究课题转向对算力需求不高的部分,也就是大模型的微调、评价与认识研究。因为单一量表不能完整覆盖大模型的工作范围,所以评价大模型不再是一件简单的工作。

而在认识大模型方面,因为模型过于庞大,理解模型的工作原理,或者将模型的一些性质对应到特定的结构上已经变得十分困难。为此,可解释性已经发展为一个完整的子学科,主要研究方法有“机制可解释性”和“表示工程”。一种流行的研究范式是将基础模型分解为能够解释的小模块,如Google Deepmind开发的Gemma Scope[5]。

**在学术圈以外,大模型的模块化特性、方便上手的大模型工程软件,和大量投入该领域的资本使大模型的发展日新月异。因此,要想保持与时俱进也会比以往更难。**博客、新闻通讯和播客,比如针对技术工作者的AI News[6]和普通观众的One Useful Thing[7]可以帮观众筛选来自arXiv(著名预印本网站)和学术会议的庞杂信息。

最后,人们很难完全掌握大数据库的数据内容。这就使得一些有害数据很容易混入其中,如LAION-5B图片数据库中就含有儿童性虐待内容[8]。

大模型的神经科学应用

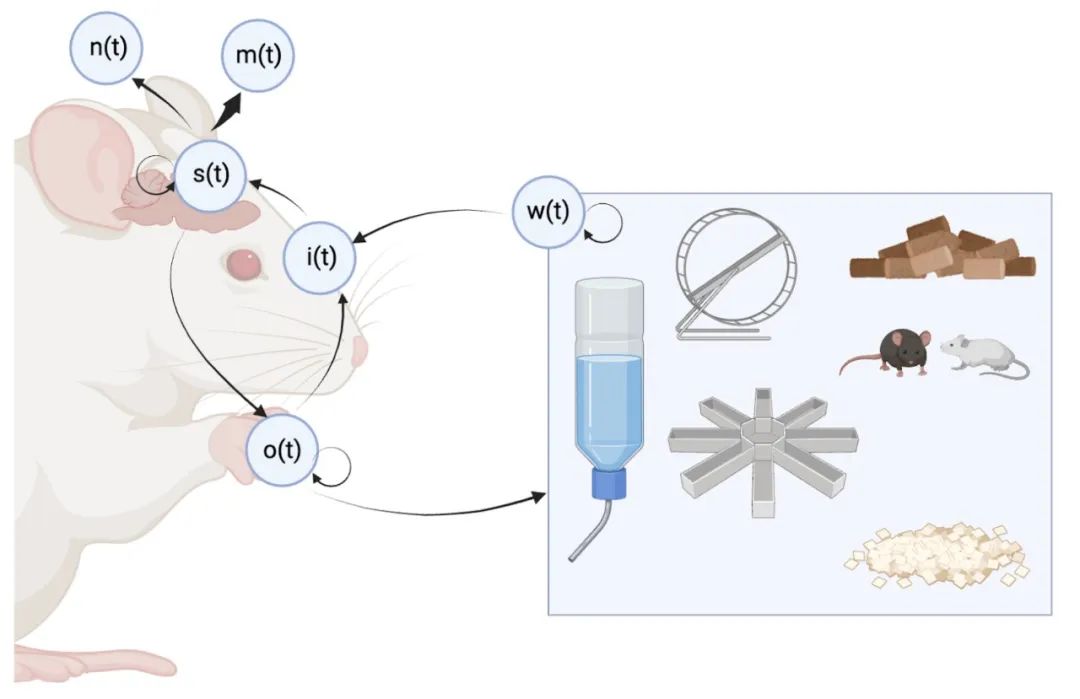

话题回到神经科学。类似上面的做法,本文只会介绍一些神经科学大模型,但不下定义。我们可以根据这些模型试图刻画的“生物体、大脑活动与环境”之间关系的具体维度,对其进行大致分类。参考以下这张沾点弗里斯顿(Karl Friston)框架的示意图:

▷图3. 描述意识与神经活动过程的数学框架

外部环境决定了感官输入,感官输入自外向内地驱动神经活动,神经活动和生物力学共同决定了小鼠的动作,小鼠的动作会同时改变环境状态与感觉输入,形成一个闭环。在整个过程中,可以用各种方式来捕捉神经信号。不同的神经科学模型会针对这个闭环内不同的部分。根据感官输入推断神经活动的AI模型称为编码模型。

**

**

**编码模型有三种设计思路:数据驱动、任务驱动、目的驱动。**第一种设计会从零开始,利用AI模型来发现感官输入与神经活动的对应关系。如果数据量较大而且精度达到单个神经元等级,这类模型可以代替真正的脑来进行模拟实验[9], [10],[11],所以有时候也叫做“数字孪生”。这种建模方法最常用于可以使用侵入性方式捕捉大量生理信号且感官输入可控的情况,如视觉研究。

后两种设计范式会针对特定的任务训练AI模型,并把训练出来的模型与大脑作类比,以增进对脑的认识。除了视觉研究,这种研究方法在声音和语言研究中也颇为流行。一般情况下,研究者会基于类似用途的大模型进行二次训练,比如用图像识别的大模型来处理视觉任务。但有少数时候,研究者会训练新的模型。不过,这种新的模型并不算大模型,所以本文不会讨论它们。

**“分布模型”**则用于学习神经活动数据本身的性质。直到最近我们才发明高通量技术,可以大规模获取神经活动数据,让开发分布模型成为可能。像LFADS这样的模型,它能将神经数据压缩至低维潜空间(latent space),实现去噪与数据解读[12]。此外,掩码与token预测也可以在不压缩数据的前提下,获得良好的潜表征(latent representation)。通过这种模型,我们既能对神经元活动用于联合平滑处理(如判断特定神经元的应有的活动趋势),也可仿照大语言模型根据上文猜下文的工作原理,实现对将来一段时间内神经活动的自回归预测。除了动作电位序列、钙离子成像、EEG(脑电图)、MEG(脑磁图)、fMRI这些普通的神经成像数据,结构更为复杂的数据也可以作为生理信号输入给大模型,如转录组与连接组。

与编码模型相反,**“解码模型”**的作用是通过神经活动反推感官输入,或者预测生物行为。解码模型在脑机接口的应用已有一段时间,但近期分布模型的新发展又给它打了一针鸡血。此外,如果解码模型的目的是为了还原结构化的感知,那么它可以利用大模型的模块化性质,借调功能相关的普通大模型。比如说,我们可以让图生成大模型根据fMRI生成受试者看见的东西,或利用大语言模型,把闭锁症患者的皮质脑电图“翻译”成他们想说的话[13]。

最后一类神经科学大模型是**“行为模型”**,如DeepCutLab。这个模型也体现了大模型的模块化特质:它以视觉大模型为底模,针对特定动物微调而来。DeepCutLab多动物同步追踪技术与适用于自然场景的人类行为模型,大幅提升了可追踪、量化、对比的行为内容,成为了神经行为学研究的重要工具。

值得一提的是,模型的分类是动态的,比如根据贝叶斯理论,一个编码模型很容易就能够被改造成一个解码模型。在这4种模型中,分布模型对数据的需求量最大,因此也最能体现神经科学领域中大模型的一些性质。下面是一个例子。

张艺紫(音译)等人研究了国际脑科学实验室(IBL)收集的小鼠脑活动数据[14]。这个数据库非常庞大,记录了小鼠决策时丘脑、海马体、视觉皮层等多个脑区数百小时的神经电信号,总共涉及39只小鼠的26,736个神经元。

这里有个关键问题:在以前,人们会采用无监督学习分析神经信号,比如经典的LFADS就是通过搭建VAE来训练一个循环神经网络(RNN),整理神经元活动的规律。此类方法虽高效,但存在解码器忽视潜空间性质、样本过度平滑、难以监测训练过程等问题。

无监督学习是一个问题,张艺紫以遮蔽自编码技术作答。他们隐藏了一部分神经信号,要求AI根据剩余部分“脑补”——就像玩拼图时,用现有的碎片推测缺失部分的图案。通过遮蔽自编码,无监督学习变成了监督学习,不仅上面的问题迎刃而解,算法的选择也变得自由灵活。本着大模型设计中“能调用模块就不要从头训练”的原则,他们的AI——神经活动的“通用翻译器”,借用了其他人的公开的Transformer模型NDT-1-stitch[15]。

▷4 A:AI根据其它部分推断被色块遮蔽的神经信号。B:VAE重构生理信号

(本段为模型技术细节,需要一定AI知识才能读懂,如读者理解困难可直接跳过)

Transformer的核心在于数据分块策略:将神经信号分割为独立token供Transformer层处理。NDT-1采用了简单直接的策略,每个时间段的神经信号对应一个token(NDT 10ms为一段,“通用翻译器”为20ms)。第二步,信号会经过任务对应的专用嵌入矩阵(session-specific embedding matrix),投射至固定维度的表征空间(fixed dimensional representation)。在这一步后,NDT会把1段2秒的神经信号将转化为200个token,而“通用翻译器”则是100个。标准Transformer层随后会通过全局注意力机制迭代处理数据。在模型的最后一层,token会被逆嵌入(unembed),用于重构神经信号输入——也就是“脑补”出被遮蔽的部分。“脑补”图像和原图像的差异会根据泊松损失(Poisson loss)进行计算,以量化生成图像的误差。

任务专用的嵌入矩阵有两大作用:一是支持不同神经元数量的数据集共用固定模型;二是把多个神经元在同一个潜空间中对齐,实现跨实验数据"缝合"。因为不同的被试不可能长着一模一样的神经元,产生一模一样的体素,所以这种对齐技术尤为关键。

▷图5. NDT-1根据时间给神经活动分区

“通用翻译器”作为神经科学大模型,跟Llama405一样,也表现出了一定的泛化能力。除了利用重构算法预测神经数据以外,若稍加调整,它也可以预判小鼠的行为,或者计算它们胡须运动的能量。这里的“稍加调整”指的是冻结模型参数,在潜表征层后叠加逻辑斯蒂回归执行下游解码任务;或在其之上接入线性解码器,并进行端到端微调。

▷图6. 左侧四组数据展示模型在直接执行重构任务的表现。右侧两组数据验证模型的泛化能力。下面的绿色图表代表更为简单的遮蔽策略表现。

除了泛化能力以外,论文团队还发现该模型 “性能随训练次数增加持续提升”,证明它符合缩放定律。

神经科学大模型量变引发质变

在过去,神经科学的大部分研究采用假说驱动型研究范式,即在实验室环境下,用控制变量法采集小规模数据,并进行分析。但现在可以换一个思路。一方面,最新的Neuropixels等高通量技术可以记录大量神经元的活动;另一方面,DandiHub等大型数据平台正在收纳越来越多、种类越来越丰富的公开神经数据集。然而这些数据集并不是为了训练大模型而建设的,因此传统的方法并不能挖掘出这些数据的价值。

为此,一些研究者正在探索对应的新型分析工具与工程办法。这些乐观者认为,**研究工具的匮乏堵上了神经科学的发展之门,而大数据训练的大模型正是碎门之钥。**回顾历史,大卫·休伯尔(David Hubel)对视觉皮层研究的诺奖级突破,正始于1957年发明的钨丝电极技术[16]。新工具终走进千家万户:大语言模型不仅性能远超传统自然语言处理模型,而且普通人也能快速上手使用。

相反,坚持假说驱动范式的**“传统派”则对此持保留意见:他们认为此类工作顶多“止步于工程技术改良”,甚至贬为“只会捞数据”。**许多教授也对AI的发展感到焦虑——资金受限的团队恐怕难以参与这场技术竞赛。《选择你的武器:困局中AI学者的生存策略》集中讨论了这一问题。[17]

我认为大模型带来的范式转变前景可期:大数据的“量变”会引发大模型的“质变”。

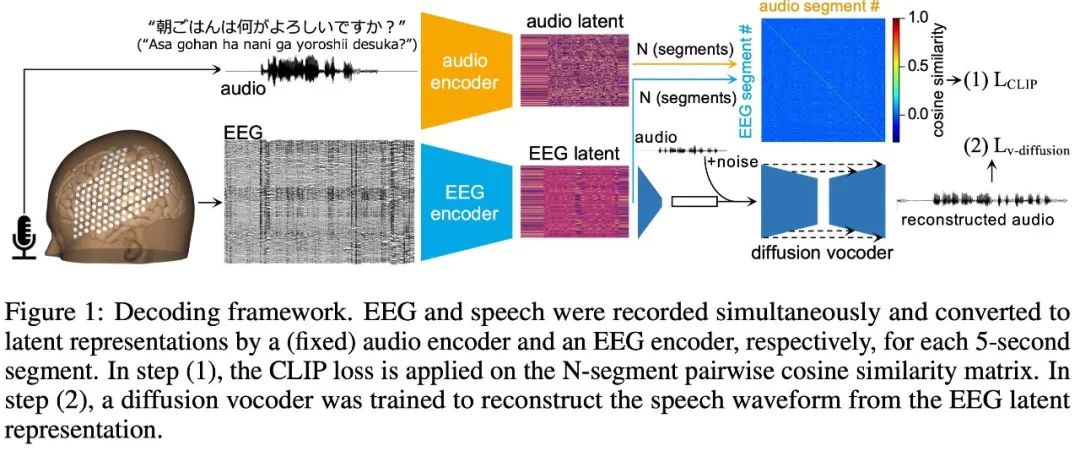

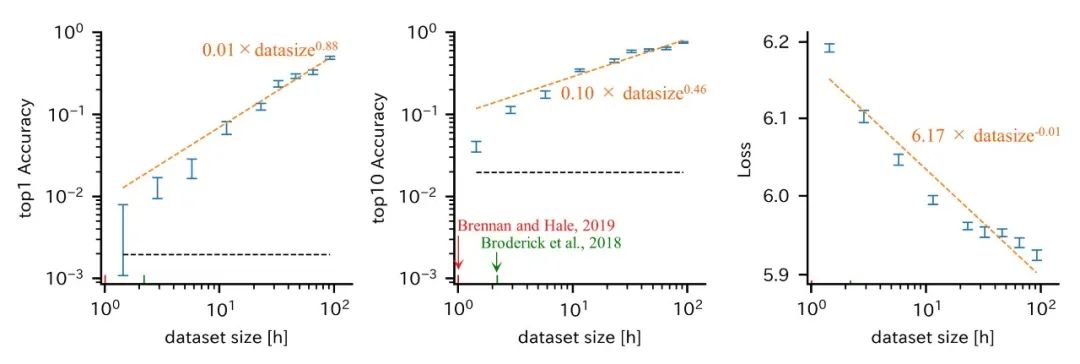

案例1:从EEG解码言语

佐藤元重(Motoshige Sato)等人希望从一个人的EEG信号推断他想说的话[18]。该实验方法上并无特别之处,只是单纯的堆量:他们为单个志愿者记录了长达175小时的脑电数据。志愿者的任务是朗读屏幕上的句子。为了不必反复清理头发根的EEG导电凝胶,他们甚至给志愿者剃了光头。

▷图7. 佐藤元重等人利用EEG推断志愿者的言语意图。

他们的EEG解码模型由多个被预训练的大模型模块组合而成,然后进行了端到端微调。在包含512类语句的高难度分类任务中,该模型达到了48%的top-1准确率(模型第1顺位预测与真实标签一致的比例)。它证实了通过非侵入式脑电信号解码大脑活动的可行性。如果AI学习到的数据特征可以跨受试者泛化,其应用前景更显广阔。这一进展有力扭转了人们对EEG技术易受噪声干扰且实用价值有限的固有认知。只可惜,没有谁愿意为校准EEG设备耗费数月时间,所以该方法暂不实用。

▷图8. 佐藤元重的EEG解码模型符合缩放定律:数据量与模型表现呈正相关。

案例2:从腕部肌电解码手势

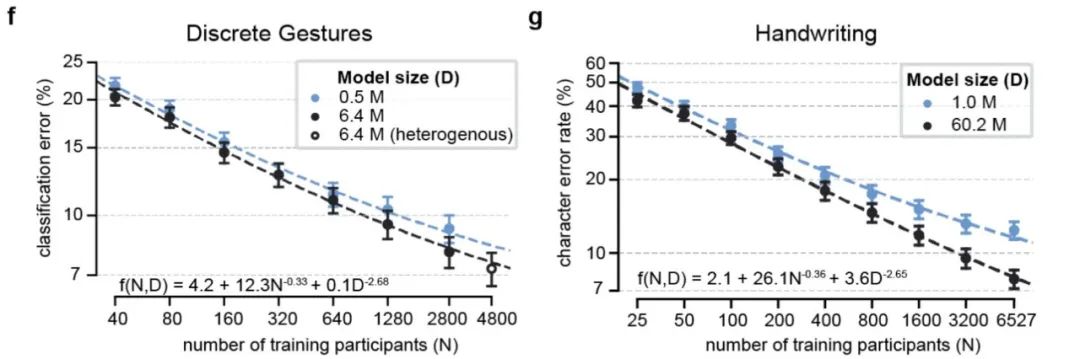

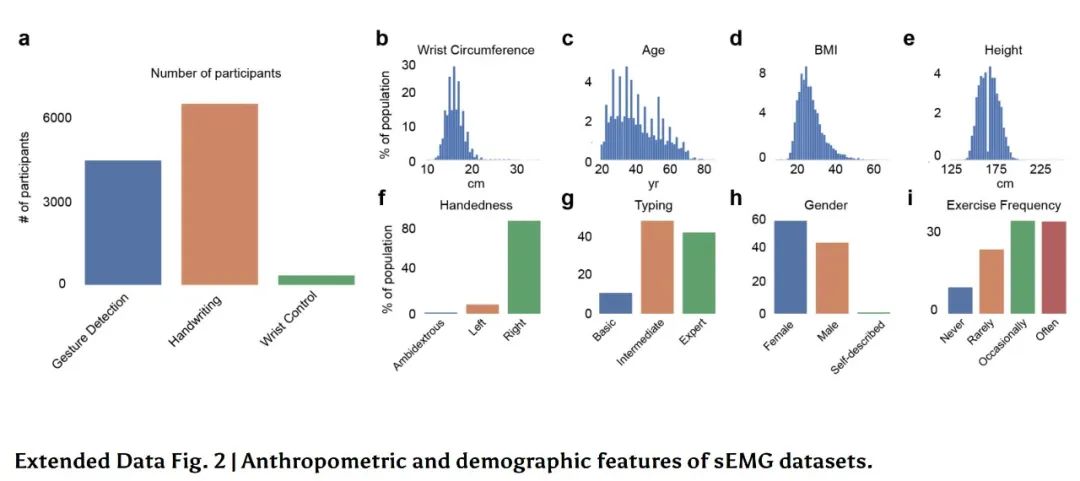

Meta Reality实验室近期发表的论文构建了利用表面腕部肌电(wrist-worn EMG)推断手部动作的解码模型[19]。与上文针对单个志愿者进行冗长实验的做法不同,Meta Reality选择了增加志愿者数量到数千名,但每个志愿者的参与时长仅略超1小时。这显然超出单个学术实验室的一般预算,但我们可以利用缩放定律计算小样本时的模型表现[20]。

▷图9 模型的错误随被试增加而减少。

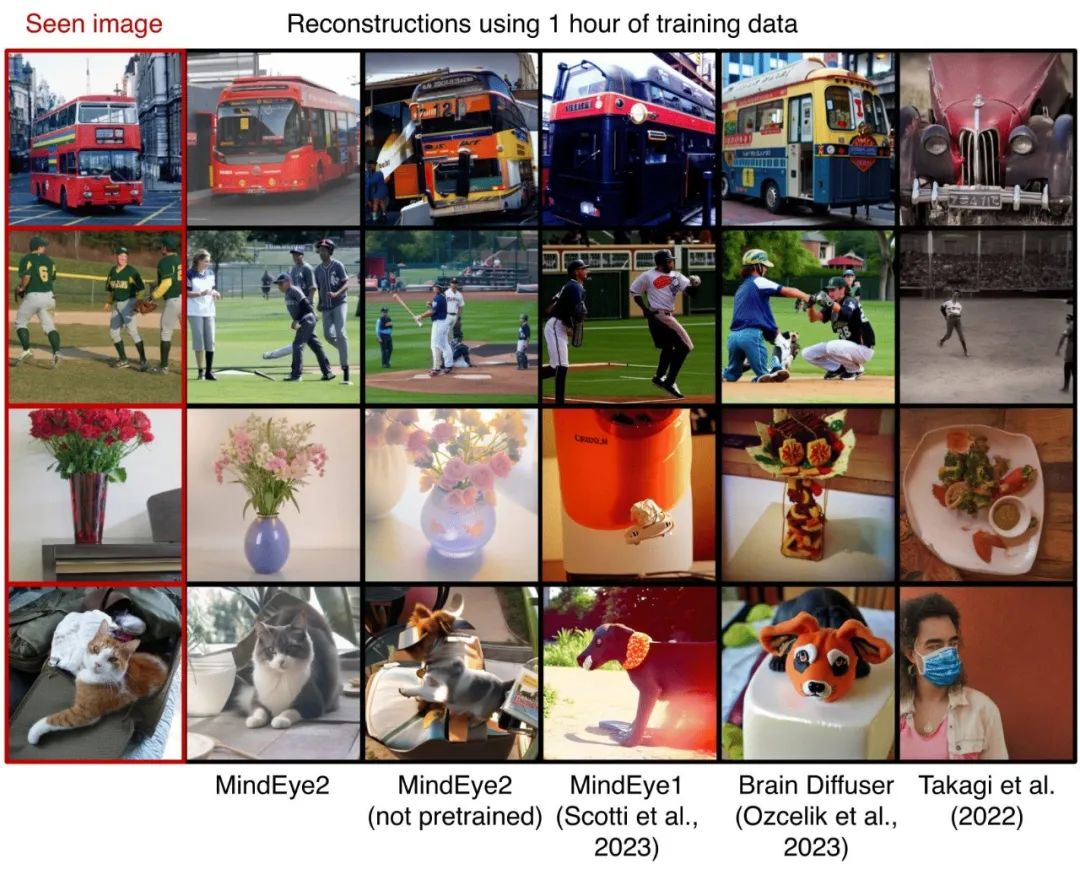

案例3:从视觉皮层解码输入图像

正如我之前在xcorr上说的[21],近期不少研究把fMRI的优质潜表征和扩散模型(diffusion models)的生图能力相结合,搭建出MindEye2这样的视觉解码模型。如果针对特定受试者进行1小时的微调,MindEye2即可根据fMRI成像数据,实现视觉感官输入的精确重建。

MindEye2作为大模型的特征非常明显:利用了模块化的,基于大规模数据进行预训练的强大生图模型,且能够针对个体微调。

▷图10. 从左到右分别为:受试看到的图片、针对个人微调后的MindEye 2结果、未针对个人微调的MindEye 2结果,和3个其他模型的输出。

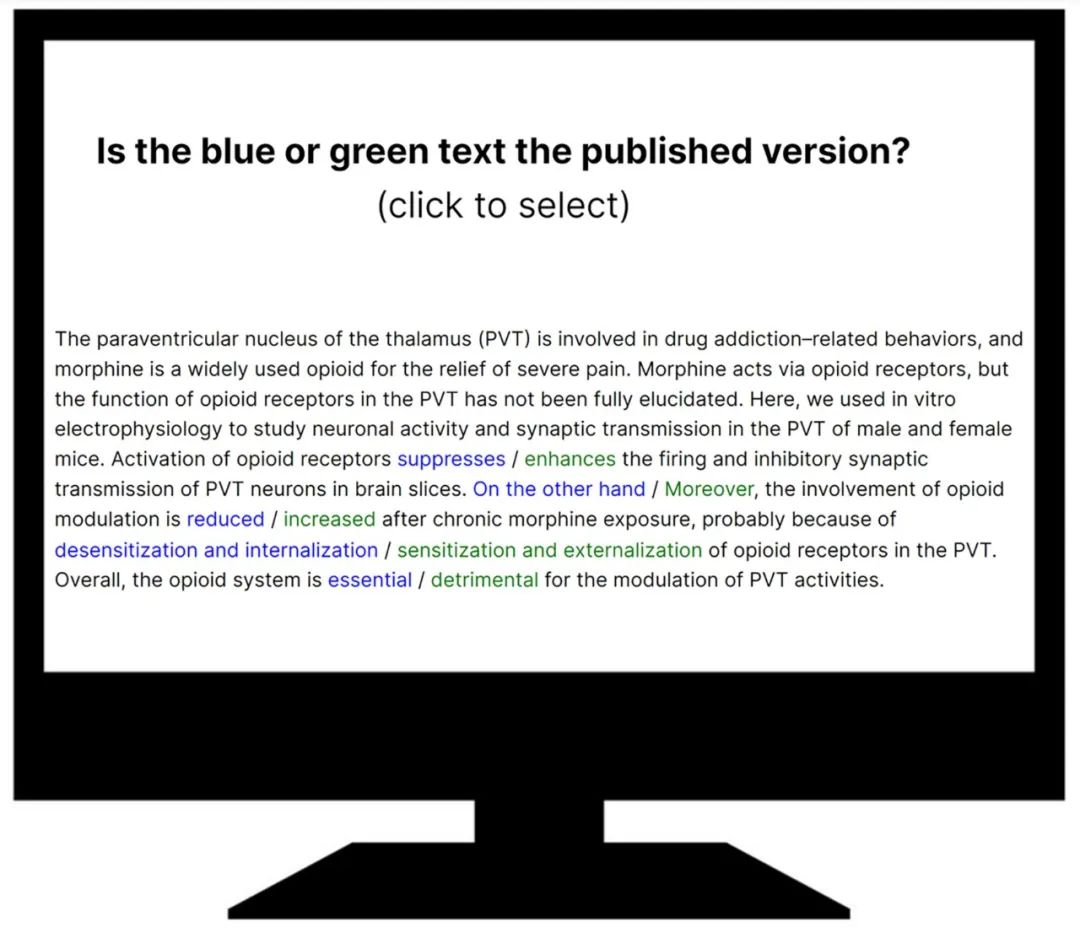

案例4:利用文字推理神经科学论文正确性

上文的3个案例展现了解码模型学习神经数据潜表征的能力:大模型可以整合海量的数据,而人类力不能及。

类似的,大语言模型也可以整合海量文本数据,识别论文中难以发现的错误。比如罗晓梁(音译)等人收集了2023年《神经科学杂志》(Journal of Neuroscience)上的文章摘要,并通过反转部分词义合成出虚假的摘要(图11),比如把“抑制”改为“促进”[22]。然后,他们直接使用大语言模型,根据生成下一个token时的模型困惑度(perplexity)来衡量摘要的真伪。

▷图11. 制造假摘要的方法。

结果发现,尽管大语言模型没有针对摘要进行微调,仍然精准地选中了超过80%的真摘要,比不能使用搜索引擎的神经科学博士生甚至教授都做得更好。有趣的是,也许是因为针对对话场景的微调损害了模型的精确度,基础模型的性能反而比对话模型更好。结果符合缩放定律,模型规模与性能呈正相关。

▷图12 模型通过连续变量(摘要整体困惑度,单位nats)量化判断置信度,置信度与准确度正相关。

该模型可以识别需要进一步验证的争议性假设,或探测文献中已被证实的旧假设。此项研究体现了"大语言模型+神经科学"的潮流,近期有一篇综述系统地整理了这个问题[23]。

大模型研究的困难

上文也许会给你一种错觉:神经科学的大模型研究就是找到足量的数据,然后扔给一个足够强大的模型,接着就可以躺平了。但实际上,这一过程有不少微妙的技术细节。

**大模型的算法仍存在问题。**有时候,它们会依赖偶然、脆弱的关联进行推断,即进行捷径学习(shortcut learning)。ResNet-50就是典中典,淡水鱼丁鱥因为经常成为钓鱼佬的战利品(图13),所以它的识别特征包含人类手指、面部及迷彩服。类似的,上文的EEG-言语解码模型极可能利用发声时面部肌肉的电信号来判断言语意图(而非单纯使用脑电),不过佐藤元重团队通过合成数据分析控制了此类干扰[18]。

▷图13. LENS[24]发现,ResNet-50会利用手指来检测丁鱥。

此外,人类只能够通过表面特征来判断生成式解码模型的能力,这容易给人类一种它比真实表现更好的错觉。例如,MindEye2还原的图像非常好看,会让人误以为它的能力很强。但这并不意味着它的结果与神经信号是真实对应的。优先追求视觉吸引力的模型易对输入分布过拟合,一旦面临新数据,表现将十分不理想[25]。

除了模型和算法本身的问题外,数据质量也是一个挑战:**垃圾输入,垃圾输出。**如果样本缺乏代表性,那么模型很可能也没用。虽然Meta团队构建了具有人口学代表性,能够反映各种人群特征的数据库(图14),但为此的资源投入远超单个大学实验室的能力。

▷图14. Meta Reality志愿者的人类学与人口学特征。

**谎言重复一百次就是真理。**化学失衡导致抑郁症是一个错误的假说,但这个错误因为重复传播至今仍有信众。在这一方面大语言模型跟人类无异。从无害的误解(如"掰手指致关节炎")到有害的伪科学言论(如反疫苗理论),它们同样会被数据库内高频的伪科学"事实"误导。

最后,**大数据与大规模训练并不能完全解决数据质量差的问题,数据标签准确性、信号维度与信噪比也很重要。**图15的研究根据当前的脑成像AI表现,预测了大规模样本(一百万个被试)下的情况[26]。结果为当头棒喝:即使耗资近十亿美元获取如此大量的MRI数据,抑郁症与正常人的分类准确率只比完全随机的0.5多了10%。缩放定律在此展现其严酷性——模型性能仅随数据规模呈对数线性提升。

▷图15. 就算把现有的MRI数据库扩展到百万级,模型的表现仍不理想。

神经科学大模型的机遇和挑战

跟在其他行业一样,神经科学的大模型也是依托更大规模的数据集,训练更复杂的模型。传统认知认为大模型只会带来量变,过去对神经科学中机器学习模型优劣的评价,在这种思路下也只会被同步放大。我对此持有不同的观点,我认为,更大的模型会引发质变。原因如下:

(1)大模型具有泛化能力和模块化特质,可实现快速迁移。面对新的需求,研究者只需利用少量算力微调现有的大模型,而不必从头开始训练新的模型。此外,大模型让开发AI不再需要从头开始设计架构,而是像逛超市一样从货架上选择需要的大模型模块,构建AI模型变得像搭乐高一样方便。

(2)DANDI、OpenNeuro、DABI等公共档案库中有着数十万小时的无标注数据,远比标注数据丰富。大模型可以利用这些海量的无标注数据。虽然元数据质量参差,但大语言模型可以提取、过滤数据。

(3)大模型可处理图数据、脉冲信号、转录组等传统大规模机器学习技术难以处理的模态。

(4)大“模型”一词其实有点误导性——**大模型的核心突破不在于模型本身的架构创新,而在于训练数据的规模与质量。**AI研究的范式应从模型中心转变为数据中心[27]。

在学术界,性能优秀、方便部署的大模型可以从现成的数据集中挖掘有价值的信息,加速科学发现。在工业界,大模型处理丰富数据(rich data)的能力可提升侵入式脑机接口的效率与非侵入式接口的精度。总之,大模型在神经科学的前景令人振奋。

但是,如同先前的专用机器学习模型,大模型在敏感医疗应用中存在放大社会偏见、削弱病人自主权、引发隐私关切的潜在风险。这些广泛存在的AI伦理问题已在多部著作中深入探讨,现有的AI伦理框架[28], [29]应能指导大模型的多数伦理问题。

▷图源:Björn Öberg

笔者作为技术人员而非生命伦理学家,我将侧重技术层面的风险探讨:

风险一:大模型的可解释性很差

评估模型在不同下游应用中的偏见,发现捷径学习,还是透明化训练数据,都是费时费力的工作。神经科学家不仅没有接受过这方面的训练,这类基础性工作还发不出论文,对他们的事业发展没有帮助。

以下为一些解决手段:(1)设立专项工具开发基金,雇佣数据科学家与工程师,开设大模型应用伦理课程[30]。(2)因为大模型是数据中心的,所以开发高质量的数据库和开发工具也可以解决问题。我们正在目睹这类项目的“寒武纪大爆发”——大量新型非营利研究组织与大规模学术项目正在进行,如e11bio、Forest Neurotech、FutureHouse、the Enigma project。

风险二:自动化悖论[31]

人机协作容易陷入两极分化:AI低效时完全依赖人力,高效时则完全依赖AI。比如说,如果我们把癫痫的检测交给AI,医生就不太会再去看原始脑电数据了。他们看脑电的专业能力就会随之弱化,不再能发现AI的错误诊断。

风险三:数据公平

神经科学大模型具有宝贵的商业价值,但训练大模型需要大量高度敏感的神经数据。在利用知识产权把大模型产品变现之前,我们需要解决有关数据所有权和隐私保护的问题,并建立让普通人不受剥削的机制。

尽管面临以上挑战,我仍坚信,通过建立适宜的监管与资助环境,这些风险可以得到有效控制。大模型在加速神经科学发现向临床转化方面的潜力令人振奋,它们为大规模解析复杂神经数据提供了前所未有的机遇,有望揭示传统方法难以捕捉的神经活动模式与关联。

译者后记

说来惭愧,因为光影告诉我有篇写的很好的神经科学基础模型的文章,我一开始以为这篇文章会介绍神经科学的基础理论框架,又在快速浏览的时候看到了那个Friston的小白鼠插图(图3),遂欣然接稿。翻译到中间才发现,那个小白鼠图就是全部的理论神经科学内容了,这篇文章讲的是大模型。

虽然如此,理论神经科学、NeuroAI、AI for Neuroscience,这三者共享着许多的思维方式与研究手法,所以我还是可以舒服地做完这篇稿子,并且有所收获。

解决有关数据所有权和隐私保护的问题,并建立让普通人不受剥削的机制。

尽管面临以上挑战,我仍坚信,通过建立适宜的监管与资助环境,这些风险可以得到有效控制。大模型在加速神经科学发现向临床转化方面的潜力令人振奋,它们为大规模解析复杂神经数据提供了前所未有的机遇,有望揭示传统方法难以捕捉的神经活动模式与关联。

[外链图片转存中…(img-wjOnHcXY-1747662768524)]

译者后记

说来惭愧,因为光影告诉我有篇写的很好的神经科学基础模型的文章,我一开始以为这篇文章会介绍神经科学的基础理论框架,又在快速浏览的时候看到了那个Friston的小白鼠插图(图3),遂欣然接稿。翻译到中间才发现,那个小白鼠图就是全部的理论神经科学内容了,这篇文章讲的是大模型。

虽然如此,理论神经科学、NeuroAI、AI for Neuroscience,这三者共享着许多的思维方式与研究手法,所以我还是可以舒服地做完这篇稿子,并且有所收获。

作为一名准博士生,我觉得也没必要只是死盯着自己的一亩三分地,看看相关的其他学科有什么新的进展,也是很好的。博士毕竟是“博”士嘛。

大模型岗位需求

大模型时代,企业对人才的需求变了,AIGC相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

可能大家都想学习AI大模型技术,也想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。为了让大家少走弯路,少碰壁,这里我直接把全套AI技术和大模型入门资料、操作变现玩法都打包整理好,希望能够真正帮助到大家。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

零基础入门AI大模型

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

内容包括:项目实战、面试招聘、源码解析、学习路线。

如果大家想领取完整的学习路线及大模型学习资料包,可以扫下方二维码获取

👉2.大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。(篇幅有限,仅展示部分)

大模型教程

👉3.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(篇幅有限,仅展示部分,公众号内领取)

电子书

👉4.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(篇幅有限,仅展示部分,公众号内领取)

大模型面试

**因篇幅有限,仅展示部分资料,**有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

**或扫描下方二维码领取 **

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?