有个问题我觉得有必要和大家说一下。这个问题网上找不到解决办法,我也试验了老半天才找原因所在:就是使用指令scrapy startproject <filename> 创建爬虫工程的时候,当前目录及其父目录及以上的所有目录绝对不能有scrapy.cfg配置文件。

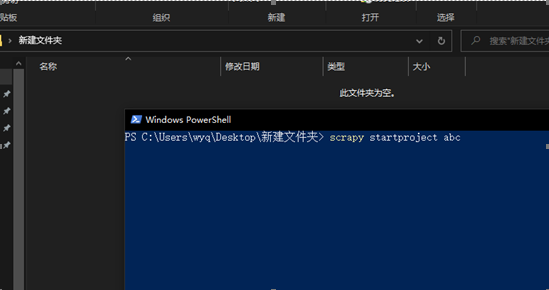

举个例子:我在桌面放了一个bilibiliSpider3里面的scrapy.cfg文件,然后新建一个文件夹:

然后我到这个文件夹 里面 ,在这个文件夹的目录下打开按shift +鼠标右键打开命令提示符, scrapy startproject abc:

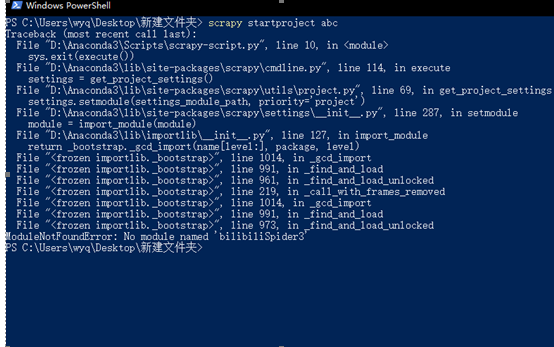

就会报错:

不明白的人可能以为少了一个模块,于是就是去conda install 啊pip install 啊 去官网找包啊,最后发现根本没这个module 。而到头来并不是Python库少这个模块,是因为这个文件夹的父目录(即我的桌面上)里有scrapy.cfg文件(而这个文件正是我从bilibiliSpider3工程里拿过来的)

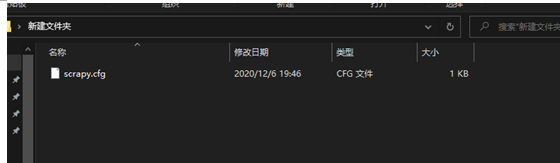

然后注意我说的“父目录及以上”,举个例子:我新建一个文件夹,然后在里面放入scrapy.cfg文件

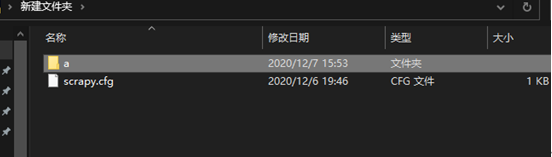

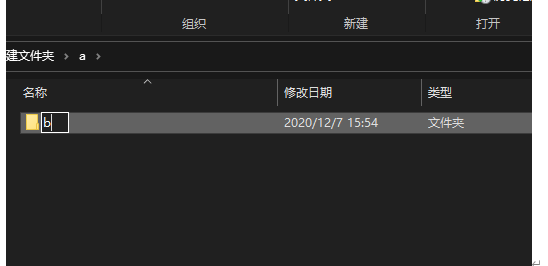

在这里新建一个文件夹a:

进入a,再新建一个文件夹b:

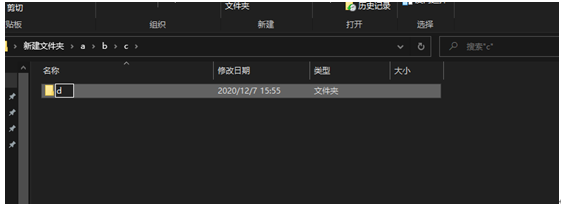

进入b再新建一个文件夹c:

进入c再新建一个文件夹d:

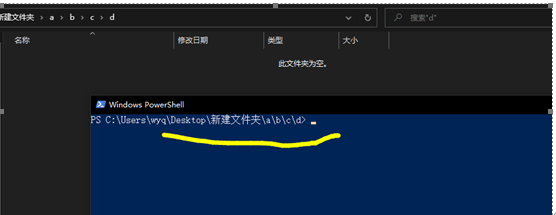

然后咱们进入d中,在此目录打开命令提示符(shift +右键可以找到)

输入scrapy startproject abaaba:

看!依然报错!

所以说创建爬虫的时候从当前目录向上一直到根目录都不能出现其他的scrapy.cfg文件(你没听错“根目录”,比如我在c盘放了一个scrapy.cfg,于是乎整个c盘下新建爬虫项目都会报这个错误!)

以上!

8302

8302

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?