【强化学习实战-05】Dueling DQN保姆级教程:以Cart Pole为例

Dueling DQN

参考文献:

- Dueling Network Architectures for Deep Reinforcement Learning https://arxiv.org/abs/1511.06581

- Wang Z, Schaul T, Hessel M, et al.

Dueling network architectures for deep reinforcement learning[C]//International conference on machine learning. PMLR, 2016: 1995-2003.

本笔记整理自 (作者: Shusen Wang):

https://www.bilibili.com/video/BV1rv41167yx?from=search&seid=18272266068137655483&spm_id_from=333.337.0.0

Note

- Dueling Network不仅可以用在DQN,还可以用在其他地方。

- Dueling Network是一种更好的网络结构。跟DQN相比,他只是在神经网络的网络结构上做了改进。

Dueling network是在2016年发表在PMLR上的论文Dueling Network Architectures for Deep Reinforcement Learning提出的,其作者为:Google 的DeepMind团队。作者包括:Ziyu Wang、Tom Schaul、Matteo Hessel、Hado van Hasselt、Marc Lanctot、Nando de Freitas。

这篇论文中提出了一个重要的概念:Advantage function (优势函数)。下面我们来详细介绍Dueling Network。

Advantage function (优势函数)

在介绍Advantage function (优势函数)之前,首先我们需要再次回顾相关概念。

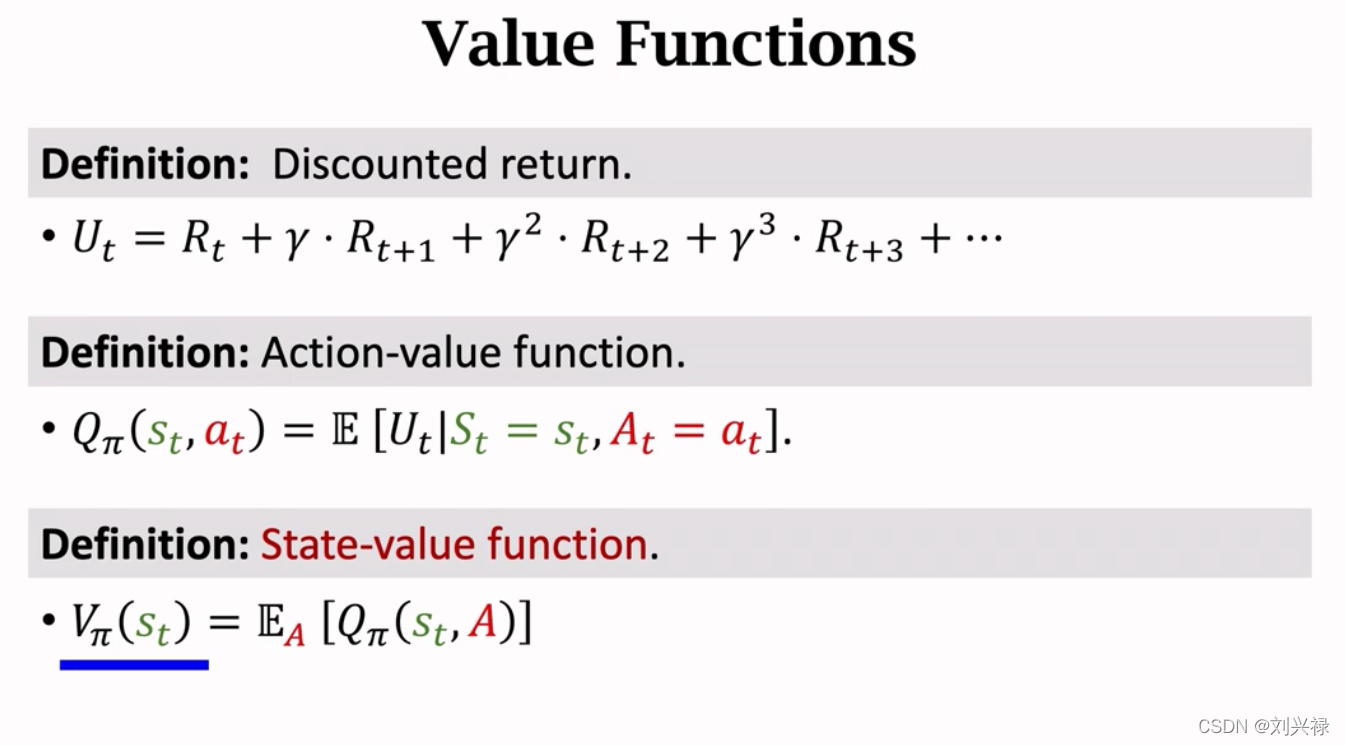

- 折扣回报(Discounted return): 也就是从 t t t时刻到结束的累计总回报。 U t = R t + γ ⋅ R t + 1 + γ 2 ⋅ R t + 2 + γ 3 ⋅ R t + 3 + ⋯ = ∑ k = 1 + ∞ γ k R t + k \begin{aligned} U_t &= R_t + \gamma \cdot R_{t+1} + \gamma^2 \cdot R_{t+2} + \gamma^3 \cdot R_{t+3} + \cdots \\ &= \sum_{k=1}^{+\infty}{\gamma^k R_{t+k}} \end{aligned} Ut=Rt+γ⋅Rt+1+γ2⋅Rt+2+γ3⋅Rt+3+⋯=k=1∑+∞γkRt+k

注意,大写字母都是随机变量。每一步的reward,也就是 R t , R t + 1 , R t + 2 , ⋯ R_t, R_{t+1}, R_{t+2}, \cdots Rt,Rt+1,Rt+2,⋯,全部是随机变量,因为我们并不知道真实、准确的reward function,只能是自己凭借经验去设置一个自己觉得合理的reward function。或者说,等待环境返回一个reward的观测值: r t r_t rt。

- 动作-价值函数(Action-value function): Q π ( s t , a t ) Q_{\pi}(s_t, a_t) Qπ(st,at),表示在策略 π \pi π下,状态为 s t s_t st时采取动作 a t a_t at,获得的总折扣回报 U t U_t Ut的期望。也就是 Q π ( s t , a t ) = E [ U t ∣ S t = s t , A t = a t ] Q_{\pi}(s_t, a_t) = \mathbb{E}[U_t | S_t = s_t, A_t = a_t] Qπ(st,at)=E[Ut∣St=st,At=at]

另外,在Policy based reinforcement learning中,我们是学习状态价值函数 V π ( s ) V_{\pi}(s) Vπ(s),且 V π ( s ) V_{\pi}(s) Vπ(s)等于

V π ( s t ) = E A [ Q π ( s t , A ) ] = ∑ a π ( a t ∣ s t ) ⋅ Q π ( s t , a t ) ≈ ∑ a π ( a t ∣ s t ; θ ) ⋅ q ( s t , a t ; w ) \begin{aligned} V_{\pi}(s_t) &= \mathbb{E}_{A}[Q_{\pi}(s_t, A)] \\ &=\sum_{a} \pi(a_t|s_t) \cdot Q_{\pi}(s_t, a_t) \approx \sum_{a} \pi(a_t|s_t; \theta) \cdot q(s_t, a_t; \mathbf{w}) \end{aligned} Vπ(st)=EA[Qπ(st,A)]=a∑π(at∣st)⋅Qπ(st,at)≈a∑π(at∣st;θ)⋅q(st,at;w)

最后,我们会同时得到:

策略网络(policy network),也就是 Actorπ ( a ∣ s ; θ ) \pi(a|s; \theta) π(a∣s;θ),和价值网络(value network),也就是Criticq ( s , a ; w ) q(s, a; \mathbf{w}) q(s,a;w)。注意这个价值网络 q ( s , a ; w ) q(s, a; \mathbf{w}) q(s,a;w)是不依赖于策略 π \pi π的,因为它就是一个唯一的神经网络而已, π \pi π变化,神经网络 q ( s , a ; w ) q(s, a; \mathbf{w}) q(s,a;w)不会变化。

虽然最后会同时得到策略网络(policy network) π ( a ∣ s ; θ ) \pi(a|s; \theta) π(a∣s;θ)和价值网络(value network) q ( s , a ; w ) q(s, a; \mathbf{w}) q(s,a;w),但是最后我们只是用策略网络(policy network) π ( a ∣ s ; θ ) \pi(a|s; \theta) π(a∣s;θ)去做动作(相当于去求解问题)。

因此,我们引出状态-价值函数 V π ( s t ) V_{\pi}(s_t) Vπ(st)

- 状态-价值函数(State-value function): V π ( s t ) V_{\pi}(s_t) Vπ(st),表示在策略 π \pi π下,状态为 s t s_t st时会获得的总折扣回报 U t U_t Ut的期望。也就是

V π ( s t ) = E A [ Q π ( s t , A ) ] = E a ∼ π ( s t ) [ Q π ( s t , a ) ] = ∑ a π ( a t ∣ s t ) ⋅ Q π ( s t , a t ) \begin{aligned} V_{\pi}(s_t) &= \mathbb{E}_{A}[Q_{\pi}(s_t, A)] \\ &= \mathbb{E}_{a \sim \pi(s_t)}[Q_{\pi}(s_t, a)] \\ &=\sum_{a} \pi(a_t|s_t) \cdot Q_{\pi}(s_t, a_t) \end{aligned} Vπ(st)=EA[Qπ(st,A)]=Ea∼π(st)[Qπ(st,a)]=a∑π(at∣st)⋅Qπ(st,at)

基于价值函数,我们因此最优价值函数的概念。

- 最优动作-价值函数(Optimal action-value function): Q ∗ ( s , a ) Q^{*}(s, a) Q∗(s,a),表示在所有可能的策略 π \pi π下,状态为 s t s_t st时采取动作 a t a_t at,获得的总折扣回报 U t U_t Ut的

期望的最大值。也就是 Q ∗ ( s t , a t ) = max π Q π ( s , a ) Q^{*}(s_t, a_t) = \underset{\pi}{\max \,\,}{Q_{\pi}(s, a)} Q∗(st,at)=πmaxQπ(s,a)

最优动作-价值函数(Optimal action-value function)可以直接指导Agent做动作。

- 最优状态-价值函数(Optimal state-value function): V ∗ ( s ) V^{*}(s) V∗(s),表示在所有可能的策略 π \pi π下,状态为 s t s_t st时会获得的总折扣回报 U t U_t Ut的

期望的最大值。也就是 V ∗ ( s ) = max π V π ( s ) V^{*}(s) = \underset{\pi}{\max \,\,}{V_{\pi}(s)} V∗(s)

【强化学习实战-05】Dueling DQN保姆级教程:以Cart Pole为例Dueling DQNAdvantage function (优势函数)Dueling DQN参考文献:Dueling Network Architectures for Deep Reinforcement Learning https://arxiv.org/abs/1511.06581Wang Z, Schaul T, Hessel M, et al. Dueling network architectures

【强化学习实战-05】Dueling DQN保姆级教程:以Cart Pole为例Dueling DQNAdvantage function (优势函数)Dueling DQN参考文献:Dueling Network Architectures for Deep Reinforcement Learning https://arxiv.org/abs/1511.06581Wang Z, Schaul T, Hessel M, et al. Dueling network architectures

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

849

849

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?