之前在公司做一个项目,项目需求是按照标签分类,去不同网站上爬取文章的内容,标题等。然后我就一个网站一个网站的去配xpath,可是网站特别多的时候,领导就会对我提出一个需求能不能,写一种程序然后用来解析所有的网站,也就是智能化解析。这对我一个刚刚做爬虫不久的新手就是很头疼了。于是各种网上找资料,于是发现了DIFFBOT这个东西。官网https://www.diffbot.com,注册后会有15天的免费使用的时间。注册后会发邮件给你一个token,通过token可以配置API请求然后获取json数据,代码示例:

import requests, json

url = 'https://api.diffbot.com/v3/article'

params = {

'token': 'your token', # 这里填写自己的token值

'url': 'https://mbd.baidu.com/newspage/data/landingsuper?context=%7B%22nid%22%3A%22news_9516827704589093644%22%7D&n_type=0&p_from=1',

'fields': 'meta'

}

response = requests.get(url, params=params)

print(json.dumps(response.json(), indent=2, ensure_ascii=False))

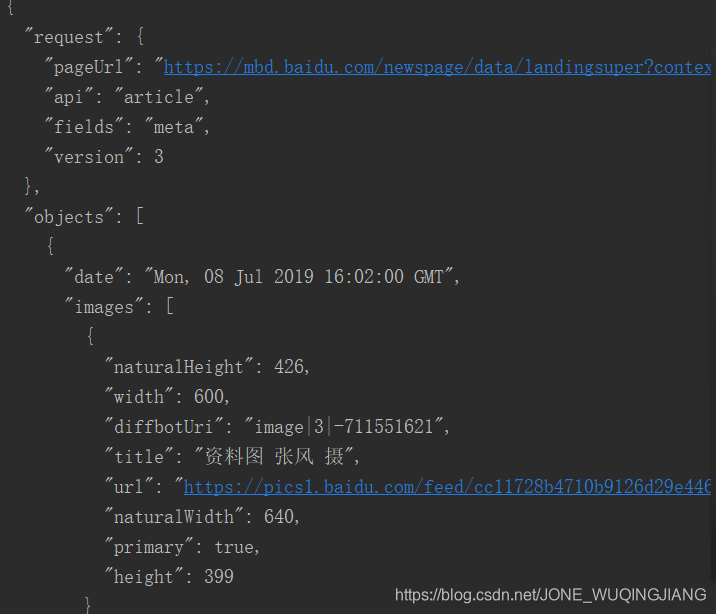

结果会获得一个json串

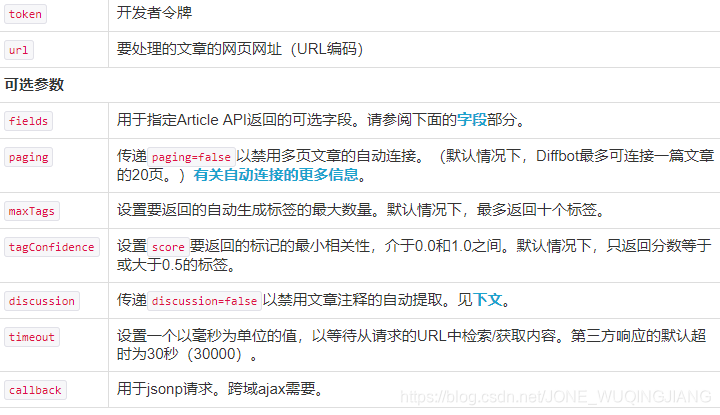

响应参数的一些说明:

如果说公司业务有这方面需求,但是自己却实现不了这种技术的,我觉得可以尝试使用,如果不需要,就当作一种了解。以后也可往人工智能的方向发展。谢谢浏览!有什么问题欢迎留言关注!

445

445

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?