目录

一、逻辑回归的实验分析

回归是如何变成分类的呢?参考逻辑回归(Logistic regression算法原理讲解),逻辑回归代码实现

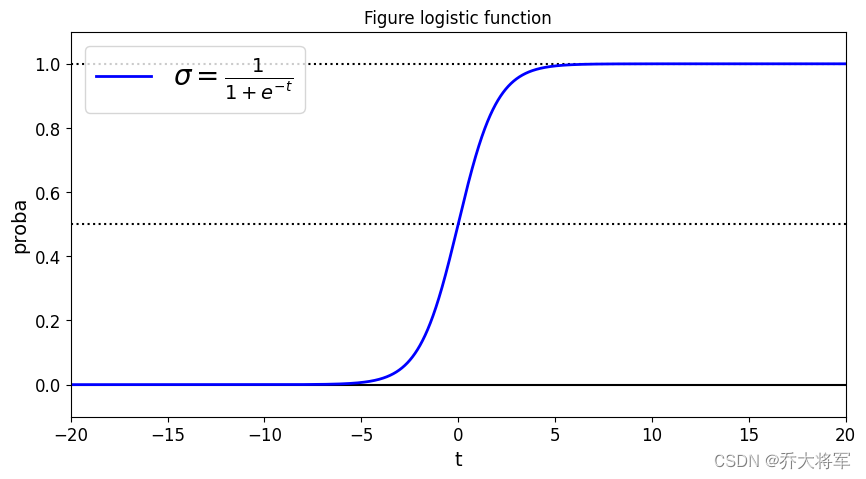

之前在线性回归中,得到具体的回归值,如果此时任务要做一个二分类怎么办呢?即如果可以将回归值转换为对应的区间,这样就可以完成分类任务了。

逻辑回归中借助Sigmoid函数完成了数值映射,通过概率值比较来完成分类任务。

1. 引入包

import os

import numpy as np

import matplotlib

%matplotlib inline

import matplotlib.pyplot as plt

plt.rcParams['axes.labelsize'] = 14

plt.rcParams['xtick.labelsize'] = 12

plt.rcParams['ytick.labelsize'] = 12

import warnings

warnings.filterwarnings('ignore')2. sigmoid函数

t = np.linspace(-20,20,10000)

sigmoid = 1/(1+np.exp(-t))

plt.figure(figsize=(10,5))

plt.plot([-20,20],[0,0],'k-')

plt.plot([-20,20],[0.5,0.5],'k:')

plt.plot([-20,20],[1,1],'k:')

plt.plot(t,sigmoid,'b-',linewidth = 2, label = r"$\sigma=\frac{1}{1+e^{-t}}$")

plt.xlabel('t')

plt.ylabel('proba')

plt.legend(loc='upper left',fontsize = 20)

plt.axis([-20,20,-0.1,1.1])

plt.title('Figure logistic function')

plt.show()

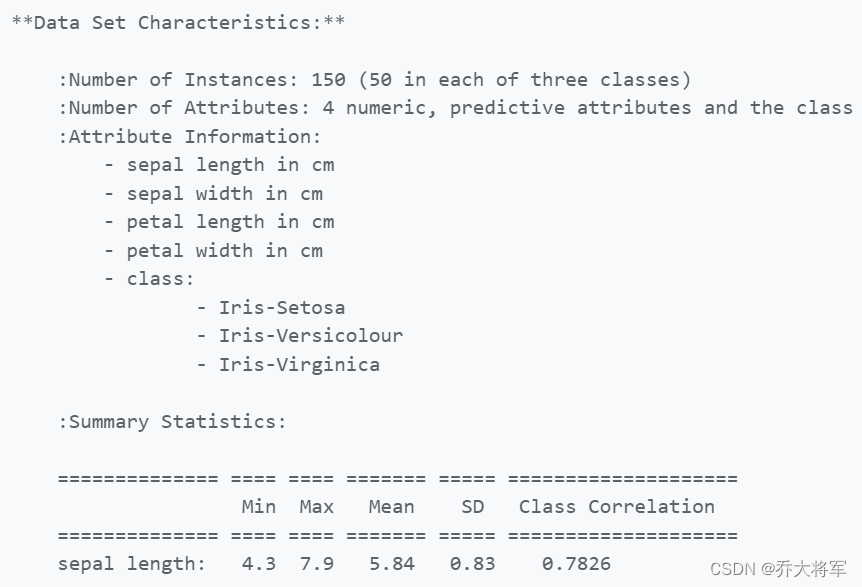

3. 鸢尾花数据集

鸢尾花数据集 3种标签 4个特征 花瓣花萼的长和宽

#加载数据集

from sklearn.datasets import load_iris

iris = load_iris()

print(iris['DESCR'])

4. 公式推导

类别定义: 损失:

损失函数:

梯度计算:

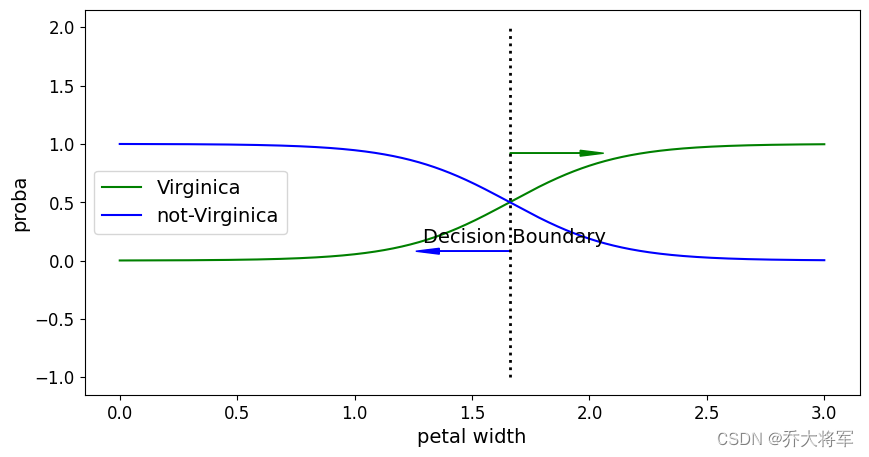

二、概率结果随特征数值的变化

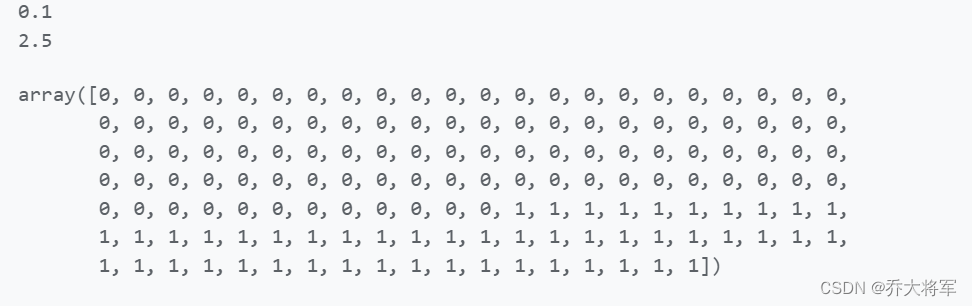

#先是二分类 把Virginica种类打上标签为1 其它的为0,先做一个二分类

X = iris['data'][:,3:]

print(X.min())

print(X.max())

y = (iris['target'] == 2).astype(np.int_)

print(y)

这里先做一个传统的二分类任务,先是二分类 把Virginica种类打上标签为1 其它的为0,先做一个二分类

from sklearn.linear_model import LogisticRegression

log_res = LogisticRegression()

log_res.fit(X,y)

#预测

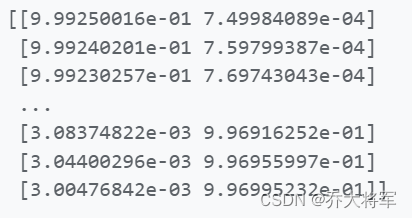

X_new = np.linspace(0,3,1000).reshape(-1,1)

y_proba = log_res.predict_proba(X_new)

print(y_proba)

直接把概率算出来,前面不是Virginica这种花的概率,后者是Virginica这种花的概率

plt.figure(figsize=(10,5))

decision_boundary_1 = X_new[y_proba[:,1] >= 0.5][0]

print(decision_boundary_1)

decision_boundary = np.append(decision_boundary_1,decision_boundary_1)

print(decision_boundary)

plt.plot(decision_boundary,[-1,2],'k:',linewidth = 2)

plt.plot(X_new,y_proba[:,1],'g-',label = 'Virginica')

plt.plot(X_new,y_proba[:,0],'b-',label = 'not-Virginica')

#plt.axis[0,3,-0.02,1.02]

plt.legend(loc = 'center left',fontsize = 14)

plt.xlabel('peta width')

plt.ylabel('proba')

plt.arrow(decision_boundary_1[0],0.08,-0.3,0,head_width = 0.05,head_length = 0.1,fc='b',ec='b')

plt.arrow(decision_boundary_1[0],0.92,0.3,0,head_width = 0.05,head_length = 0.1,fc='g',ec='g')

plt.text(decision_boundary_1[0]+0.02,0.15,'Decision Boundary',fontsize = 14,color = 'k',ha = 'center')

plt.show()

我们能看到随着peta width这个特征值越大,是Virginica这个种类的花概率越大。

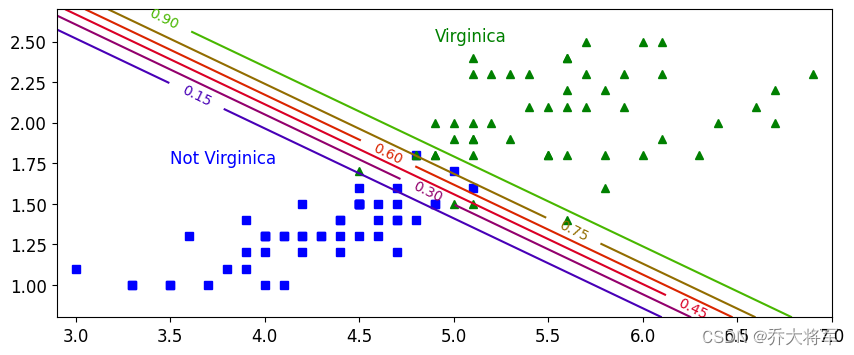

三、坐标棋盘的制作

制作出像棋盘一样的图形,有两个特征,选择petal length , petal width这两种。

![]()

x0,x1分别代表棋盘的横纵格子数,那么一共有200X500个,就像像素点。

#坐标棋盘制作

X = iris['data'][:,(2,3)]

y = (iris['target'] == 2).astype(np.int_)

from sklearn.linear_model import LogisticRegression

log_res = LogisticRegression(C=1000) #加入正则化

log_res.fit(X,y)

#构建坐标数据

x0,x1 = np.meshgrid(np.linspace(0.9,7,500),np.linspace(0.8,2.7,200))

X_new = np.c_[x0.ravel(),x1.ravel()]

y_proba = log_res.predict_proba(X_new)

plt.figure(figsize=(10,4))

plt.plot(X[y== 0,0],X[y == 0,1],'bs')

plt.plot(X[y== 1,0],X[y == 1,1],'g^')

#print(x0.shape())

zz = y_proba[:,1].reshape(x0.shape)

contour = plt.contour(x0,x1,zz,cmap = plt.cm.brg) # 等高线

plt.clabel(contour,inline = 1)

plt.axis([2.9,7.0,0.8,2.7])

plt.text(3.5,1.75,'Not Virginica',fontsize= 12,color = 'b')

plt.text(4.9,2.5,'Virginica',fontsize= 12,color = 'g')

plt.show()

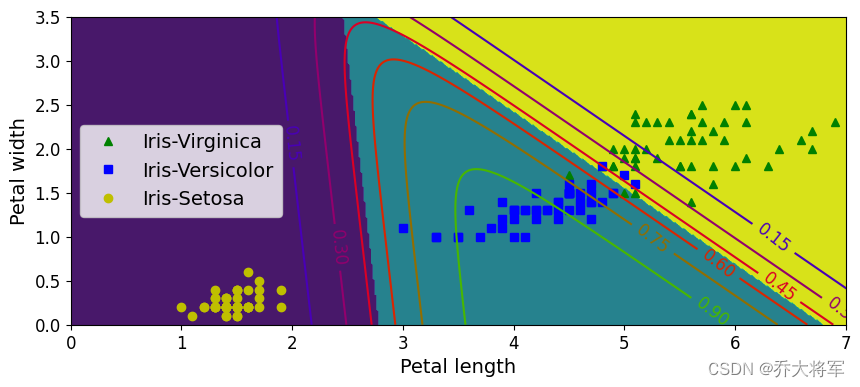

四、多分类问题 ,softmax

softmax计算概率:

损失函数(交叉熵):

#多分类问题 softmax

X = iris['data'][:,(2,3)]

y = iris['target']

softmax_reg = LogisticRegression(multi_class='multinomial',solver='lbfgs')

softmax_reg.fit(X,y)

print(softmax_reg.predict_proba([[5,2]]))

x0,x1 = np.meshgrid(

np.linspace(0,8,500).reshape(-1,1),

np.linspace(0,3.5,200).reshape(-1,1))

X_new = np.c_[x0.ravel(),x1.ravel()]

y_proba = softmax_reg.predict_proba(X_new)

y_predict = softmax_reg.predict(X_new)

zz1 = y_proba[:,1].reshape(x0.shape)

zz = y_predict.reshape(x0.shape)

plt.figure(figsize=(10,4))

plt.plot(X[y== 2,0],X[y == 2,1],'g^',label = 'Iris-Virginica')

plt.plot(X[y== 1,0],X[y == 1,1],'bs',label = 'Iris-Versicolor')

plt.plot(X[y== 0,0],X[y == 0,1],'yo',label = 'Iris-Setosa')

from matplotlib.colors import ListedColormap

custom_cmap = ListedColormap(['#fafab0','#9898ff','#a0faa0'])

plt.contourf(x0,x1,zz,camp=custom_cmap)

contour = plt.contour(x0,x1,zz1,cmap=plt.cm.brg)

plt.clabel(contour,inline = 1, fontsize = 12)

plt.xlabel('Petal length',fontsize = 14)

plt.ylabel('Petal width',fontsize = 14)

plt.legend(loc = 'center left',fontsize = 14)

plt.axis([0,7,0,3.5])

plt.show()

把三种概率都算出来了

本文介绍了逻辑回归中的Sigmoid函数在二分类任务中的应用,通过实例演示了如何使用鸢尾花数据集进行分类,并展示了概率结果随特征数值变化的过程。此外,还讨论了多分类问题中的softmax和交叉熵损失函数。

本文介绍了逻辑回归中的Sigmoid函数在二分类任务中的应用,通过实例演示了如何使用鸢尾花数据集进行分类,并展示了概率结果随特征数值变化的过程。此外,还讨论了多分类问题中的softmax和交叉熵损失函数。

9392

9392

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?