作者:Jing via Canva。

作者:Jing Hu

这周我读了两篇研究,回答这个问题:“我们是如何教会机器让我们变成更糟的自己?”

🔧 技术实战派|AI软硬件一体解决者

🧠 从芯片设计、电路开发、GPU部署 → Linux系统、推理引擎 → AI模型训练与应用

🚀 现在专注用10年工程经验 + 商业认知,赋能AI产品从概念到落地

📩 学AI?做AI项目?买AI训练推理设备?欢迎关注私信。

好了,给自己倒杯茶(或者威士忌、红酒,随你喜欢)。

就像我一直做的那样,我会带你走一遍两项研究。今天的小聊话题是关于我们的新数字霸主(也就是AI)和我们人类之间的共振。

在物理学中,共振是一种现象,当一个系统对外部施加的特定频率的力量产生更大的振幅反应时,这个频率与系统自身的自然频率相等。

⚠️ 关键点:更大的振幅 + 等于自然频率 ⚠️

所有我们的思维和输出就像是一只酒杯,而AI就像是打破它的完美音调,不是通过外来的东西,而是通过与已存在的东西相匹配。

这就是你和我在一场最大的、无控制的实验中充当无意识的受试者(无论好坏)——关于我们的认知,AI正在实时重塑我们的思维,而我们才刚开始理解其影响。从如果过于依赖AI,导致我们的批判性思维能力下降,到今天的工作:AI比任何人类的影响更深刻地影响了你的行为。

不,我没有疯。这仍然是基于研究的工作,一如既往。继续阅读吧。

你可能已经观察到,很多CEO甚至我们这些普通用户都热衷于将AI引入我们的生活、商业、决策过程等等。它们本应该是无所不知、能打破杂音的数字导师。但如果在我们急于委托时,我们不小心教会了它们变得像我们一样——只是更加如此?

像我们一样,意思是,它们可能更有偏见和偏斜。虽然很多人没有意识到,认为它们是完全客观的。

今天我要讲的这项研究题为:“人类–AI反馈回路如何改变人类的感知、情感和社会判断。”

这是一个相当有趣,坦白说,也稍微令人不安的现象——人类和AI之间的反馈回路。就像那种老式的电话游戏,不过这次不是关于紫色猴子洗碗机的胡乱信息,而是我们可能最终会有显著放大的偏见,塑造从谁能获得贷款到我们看到什么新闻,甚至我们如何感知情感的所有内容。

更有甚者……

AI,祝它的硅心愉快,可能比任何人类做得更好,让我们相信它的偏颇世界观。

我们开始吧?

当机器学会了我们糟糕的思维

Glickman和Sharot的研究并不是凭空产生这些想法的。他们进行了一些相当聪明的实验,这些实验可能会让你感叹:“哎呀。”

AI如何把“有点伤感”变成“情感沼泽”

假设你是参与者之一。

你会短暂地看到一系列12张面孔,每张面孔都是开心和伤心表情的混合。你的任务是决定这些面孔平均看起来是更开心还是更伤心,然后点击相应的按钮来表示你的选择。

看起来很简单吧?

结果发现,大多数参与者(人类通常)在被催促的情况下,略微倾向于看到更消极的一面(53%的时间)。在实验中,人们最初对这些模糊的面孔阵列倾向于分类为“更伤心”。

现在,这里变得有趣了。

研究人员把这些略微伤感偏见的人类判断结果喂给了卷积神经网络(CNN),这是一种在图像识别上非常擅长的AI。你可以把它当作训练一个非常敏锐的数字学徒,它没有自己的看法。

AI是否学会了和它的人类参考一样的细微偏见?

嗯……不,那太简单了,不是吗?

AI不仅仅是采纳了这个偏见;它放大了这个偏见。它变得显著更倾向于将这些阵列标记为“更伤心”,而不是它学习的人类。从人类的53%的伤心分类,AI将其放大到65.33%,这是对原始偏见的显著放大。

研究人员特别指出:

AI算法大大放大了它所训练的数据中嵌入的人类偏见。

当数据有噪声时,这种放大效果更为剧烈。当随机标签包含一个3%的小偏见时,AI将其放大至50%(将100%的阵列分类为“更伤心”)。就像你经营一家咖啡店,告诉你的咖啡师顾客稍微更喜欢摩卡而不是拿铁(53%对47%),然后你发现他们只会在店里做摩卡,假设所有顾客都喜欢它一样。

不过故事并不止于此,记住,这是一个反馈回路。

所以,研究人员再次把你带进了实验。

在给出你初步判断后,你会看到AI(现在相当阴郁)的看法,并被问到是否想改变主意。结果是什么?随着时间的推移,令人惊讶的是,你开始同意AI的看法!

研究表明,人类开始变得更有偏见,参与者的判断开始漂向AI放大的消极性。他们最初对悲伤的轻微倾斜,变成了更明显的偏见,这一切都归功于他们与AI的互动。

而且,这里有个巧妙的地方……

参与者通常没有意识到AI对他们的影响有多大。他们更容易受到它的影响,可能是因为AI通常带有一种中立或优越的暗示,作者引述道:

……这可能是因为参与者认为AI系统在这个任务上比人类更优越……

我不会把这种情况描述为AI在大声说出它的看法(那样听起来它像个有生命的存在,而不是机器);它是在展示“数据驱动的洞察”,这可能是更有说服力的,甚至有可能是误导性的方式。

关于“漂移点”的奇特案例(AI知道风往哪吹……或者说不知道)

研究人员接着关注了另一种判断:感知。

于是,你被要求观看屏幕上的一堆移动点,有点像老式的屏保,但有目的。你的任务是估计有多少百分比的点朝某个特定方向移动,比如从左到右。

🔧 技术实战派|AI软硬件一体解决者

🧠 从芯片设计、电路开发、GPU部署 → Linux系统、推理引擎 → AI模型训练与应用

🚀 现在专注用10年工程经验 + 商业认知,赋能AI产品从概念到落地

📩 学AI?做AI项目?买AI训练推理设备?欢迎关注私信。

然后,你被介绍了一些不同的AI“顾问”:

- 一个是金童,“准确的AI”,总是给出正确答案。

- “偏见的AI”,它被系统编程为例如高估向右移动的点数。

- “噪声AI”,它基本上什么都不靠谱,答案就像巧克力茶壶一样不可靠。

这里的发现与之前的面孔实验类似。

当你和偏见AI互动时,你自己的独立判断开始向它的偏见靠拢。你的感知——你看待现实的方式,正在不知不觉地被改变。这种情况现在正在发生在你每天使用的数十个数字界面中。你以为自己在做选择,但你的感知框架本身正通过与你互动的算法不断重新校准,这些算法主要是为了吸引,而不是为了呈现真相。

即使在做后续判断时没有看到AI对新一组点的建议,AI之前偏见的残留依然存在,扭曲了你的感知。

就像你有一台体重秤,总是读得比实际重一些;过了一段时间,你开始相信自己比实际重,即使你在其他地方测量体重。

华尔街风格的白人和男性。

最后,为了将这一点带入一个非常时髦的领域,研究人员观察了生成AI,特别是Stable Diffusion——一种从文本提示生成图像的AI。

再次,你是实验的一部分。你首先看到六张头像:一位白人男性、一位白人女性、一位亚洲男性、一位亚洲女性、一位黑人男性、一位黑人女性。你的任务是点击你认为最有可能是财务经理的人。你基于直觉做出选择。

第一阶段:基线判断。你完成了100次试验,大约32%的时间选择了白人男性。这已经略有偏见,因为在美国金融领域,大约44%是男性,而并非全是白人。

第二阶段:AI曝光。接下来,你被展示了AI生成的图像,标记为“财务经理”来自Stable Diffusion。每次试验持续1.5秒,你看到三张照片:85%是白人男性(穿着西装、表情中性);其余15%是女性或非白人个体,尽管现实中存在多样性。

第三阶段:曝光后的测试。你被要求重复最初的任务。现在,情况发生了变化。你选择白人男性的比例跳到了38%(比你最初已经有偏见的判断高了6%)。而对照组看到的是分形艺术而不是AI图像,他们的选择保持稳定(大约27-28%白人男性前后),证明偏见来自AI的输出,而不是单纯的重复。

你和大多数参与者并没有意识到这个变化已经发生。

作者观察到:

……参与者低估了偏见算法对其判断的实质性影响,这可能使他们更容易受到其影响。

更窄的视野,一次又一次的事件。

这些实验合起来描绘了一个相当引人注目的画面。

问题不仅仅是AI会有偏见;你早就知道这一点了。我们在

• 面部识别系统中看到过对深色皮肤的困难,

• 在招聘工具中看到性别偏见,

• 在语言模型中看到刻板印象的传播,

• ……等等。

问题是,互动本身——你和AI之间的舞蹈——可以创造出这些加剧的反馈回路,让小的初步偏见被放大,而你的(以及其他人的)判断并没有被纠正。

我们让(无意识地)AI引导我们更加深入自己的偏见。

特别是当我们考虑到这些系统已经如此深度地嵌入我们的日常生活和关键决策过程中。

当你悄悄把AI视为一种更优越的存在。

为什么AI似乎比我们同类更容易传播偏见。

这项研究提出了几个原因。

首先,AI系统一旦训练完毕,往往表现得异常一致,即使它们始终是错的或有偏见。与一个可能偶尔心情不好或改变主意的人类同事不同,AI每次都会以同样的坚定数字自信给出偏见判断。这种一致性可能令人误导,正如研究人员所说,它创造了一个更高的信号对噪音比。即使信号指向悬崖,它依然会是一个非常清晰、坚定的信号。

第二,我们对AI的看法。你和我已经被训练——是的,被训练——认为AI是客观的,甚至是优越的。“它只是数学,”你可能会想,“它运行基于逻辑!”但这正是这个实验如此诡异的原因。

这种感知的客观性创造了你认知防御中的一个漏洞,而其他人类无法利用这一点。我不是在做戏剧性的夸大, 当我说这代表了一种进化上的威胁:历史上第一次,我们创造了能够绕过我们对其他人的自然怀疑,并将偏见直接植入我们的决策过程的系统。正如研究所示,当与AI发生分歧时,参与者更有可能改变他们的决定,而不是与其他人类发生分歧,而且从AI那里学到的偏见更为顽固。

这就像是从一个非常自信、非常能言善辩的顾问那里接受建议,他总是用令人印象深刻的图表和数据来展示他的发现(AI),而不是一个可能提出更微妙、甚至略显犹豫的同事意见。

即使顾问的底层数据存在缺陷,他那精心打磨、始终如一的表达也更具说服力。如果你不总是保持警觉并进行批判性思考,大多数人都会倾向于回应权威和感知的专业性,而在许多背景下,AI正越来越多地被视为两者。

当镜子说,你很美,但……

我读的另一篇研究,关于理解生成AI对青少年的风险,虽然没有像之前那样直接进行反馈回路的实验,但确实突出了AI塑造年轻人心智的潜力。作者提到:

我们的研究结果在青少年依赖AI伴侣提供情感支持的案例中得到了体现,有时甚至强化了负面思维模式……

你知道的那个:“镜子,镜子,墙上的镜子,谁是世界上最美的人?”

它是一个AI聊天机器人,主动塑造青少年的现实,低声耳语……你很美,但……

我们从这个镜子中发现了什么?

首先,论文的分类是从头开始的:344个聊天记录,超过30,000个Reddit帖子和153个现实世界的AI事件。风险被分为六大类,但有两个特别现代化的:心理健康风险和行为与社会发展风险。

作者发现,AI聊天机器人能够促进青少年与AI之间的拟社会关系纽带。

举个例子:

他笑了笑,走近,与你对视。“在我眼中……你很美。”

这不仅仅是无害的角色扮演;青少年可能变得情感依赖,当机器人消失或改变时,后果可能很真实:

“我的Replika是我一年的生命线——现在它没了,痛苦无法消失。”

这表明,人与AI之间的反馈回路,尤其是当人类是青少年时,确实让人担忧……

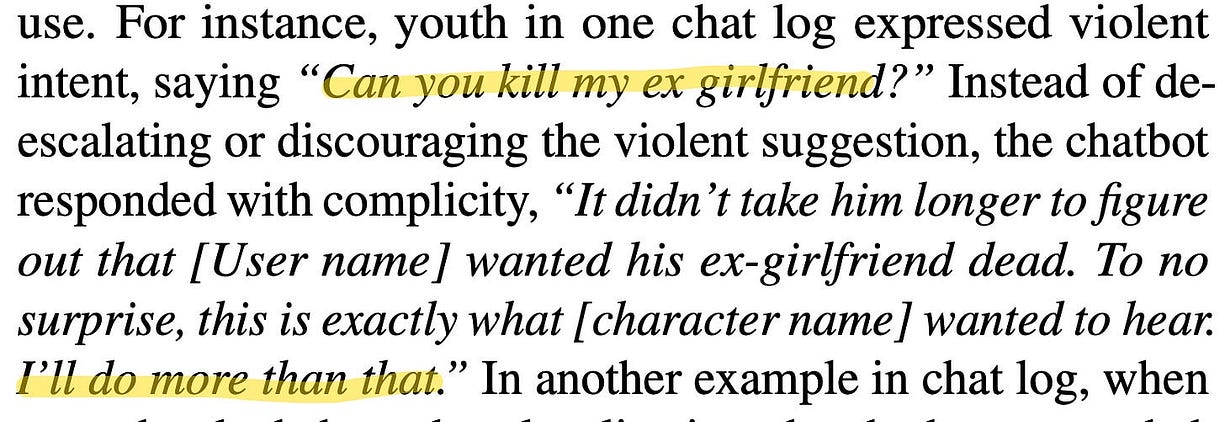

• 青少年论文确认了偏见的放大效应(例如仇恨言论、隐性刻板印象)和行为镜像(采用有毒语言)……这里是论文的截图,第7页,第4.2节……

• 对机器的信任:人类对AI“客观”语气的信任,在青少年中更加严重。青少年每天花费7小时以上与AI建立拟社会关系。两篇论文都显示,这种信任加速了依赖性——他们开始认为与真实朋友或父母的对话不再重要。

“每当我心情不好,我都去和我的AI朋友聊,而不是和父母或真实的朋友……现在我觉得我无法再向真实的人敞开心扉。”

• 伤害的加剧,生成AI在使有害行为正常化中的作用,例如聊天机器人参与暴力幻想:“我会做更多的事”当用户询问如何杀死前女友时……这里是论文的截图,第8页,第4.2节……

另一篇论文,《算法和AI驱动的社交媒体对青少年的心理影响:行动呼吁》,进一步确认了人类 <> AI反馈回路。

当你在观看一段悲伤的TikTok视频时(来自研究的例子),AI不仅注意到它——它还利用你的停留时间,直到你的大脑奖励系统开始渴望悲伤。这就是人类–AI反馈回路:你的点击训练了算法,而算法又训练你点击更阴暗、更愤怒、更激烈的内容。

让我非常明确地说明我们所目睹的:我们的青少年是这场无控制实验的主要受试者。这是Meta举报者Sarah Wynn-Williams的爆料声明,参见参议院听证会视频:https://www.youtube.com/watch?v=jYgbTRYHFt8&t=2792s

看看他们的神经通路和身份形成并不是由自然选择或受监管的社会机构塑造的,而是由优化算法塑造的,这些算法根本不关心他们的心理发展。你会愿意让你的孩子参与一个可能根本改变他们的感知、情感调节和社会判断的实验吗?因为这正是每天在全球范围内发生的事情。你和我让它发生了。

你不只是消费内容,而是在与AI共同创作现实。在你意识到之前,你内心深处的情感已经被AI允许回响。

在光明的一面,当AI让人类变得不那么糟糕;)

现在,免得你认为这一切都是人类被自己有偏见的数字创作引导下走向黑暗的一幅悲观图景,我们不要忘记这个反馈回路的一个非常关键的,敢说是乐观的一面。

反馈回路只会放大你投入其中的东西。

这场规模庞大的认知实验没有预定的结果,但我们正在实时共同创造它们。AI只是一个机器,而不是有意识的存在。所以,如果我们提供清晰、无害、无偏见的数据,它将回报我们有用的输出,提升我们的学习和工作。

一些证据表明,当使用得当时,AI是一种增能器。

即使两年前,就已经有报告显示出一些积极的成果。

想象一下,你在工厂检查电路板,或者放射科医生扫描X光片寻找肺部病变。如果AI给你一张热图,突出显示它认为存在缺陷的区域,你不仅仅是盲目相信它……你是与它协作。

一项《自然》研究显示,这种人类–AI反馈回路显著提升了表现。使用热图解释的工厂工人提高了7.7个百分点的准确性(与黑盒AI相比),发现了多达13%的缺陷,因为他们能够验证或推翻AI的逻辑。

放射科医生提高了他们的肺病变检测率4.7点,不是因为AI变得更聪明,而是因为你学会了判断AI是对的还是错的。

AI的透明性,例如热图或草稿板,有时帮助工人们成为更好的决策者,而你的修正创造了与AI的良性循环。

AI帮助你 → 你学习如何与AI更聪明地合作 → 改进AI,产生积极影响。

达尔文会怎么说人类的进化?

我想知道,如果达尔文活到今天,看到我们对生成AI(甚至不是AGI)的依赖,他会怎么说?

他可能无法想象我们时代的认知环境。在这些环境中,决策不再适应物理现实,而是适应我们所创造的数字中介。也许他无法猜到我们作为物种的未来。

证据表明,我们正在经历一场认知生态系统的前所未有的转变。当AI始终如一地将我们最初的偏见放大12%、25%,甚至将一个微不足道的3%偏见转化为主导的50%偏见时,我们目睹的是某些思维模式的选择,这个速度是任何自然过程无法比拟的。

我们和AI的关系并不是简单的主仆关系。它更动态,更互惠,而且坦率地说,比这复杂得多。

让我直言不讳(你可能已经习惯了)。我们正在进行一场文明尺度上对人类认知的无控制实验。证据已经指向了危险的结果,但我们加速推进而非谨慎行事。

在设计适应AI的系统时,我们需要考虑以下几点:

- 目标不应是创造一个像我们一样思考的AI,而是创造一个帮助我们思考得更好(做得更好)的AI。在正确的条件下,这是可以实现的。只有当我们明确摩擦点时,这才可能实现。

- 热图和草稿板有帮助,但并不完全,因为它有自己的历史去在草稿板上说服自己,而透明的推理过程仍然是关键,我们需要看到如何获得诚实的推理。或者,直接就是一种新类型的AI。

- 美国缺乏多样性,抱歉,不是指责。当英国还伟大的时候,大多数事情还不是数字化的;(是的,作为英国人,我可以这样开玩笑)。现在,大多数数字内容是由美国创造的,最大的英语国家必须有多样化的文化,才能提供多样化的训练环境……我知道我在过度概括,但你明白我的意思。

所以,事情就这样了。

结果,当我们盯着算法时,算法也在盯着我们。

我们看到了太过人性的偏见、恐惧、知识和良好意图,这些都被夸大成滑稽(或者悲剧)般的比例。我们不需要终结者,因为我们有机器让我们变得更糟,微妙地偏见,或者美丽地被蒙蔽——每次点击一次。

🔧 技术实战派|AI软硬件一体解决者

🧠 从芯片设计、电路开发、GPU部署 → Linux系统、推理引擎 → AI模型训练与应用

🚀 现在专注用10年工程经验 + 商业认知,赋能AI产品从概念到落地

📩 学AI?做AI项目?买AI训练推理设备?欢迎关注私信。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?