论文题目:A Neural Attention Model for Abstractive Sentence Summarization

论文地址:https://arxiv.org/abs/1509.00685

论文发表于:EMNLP 2015(CCF B类)

论文大体内容:

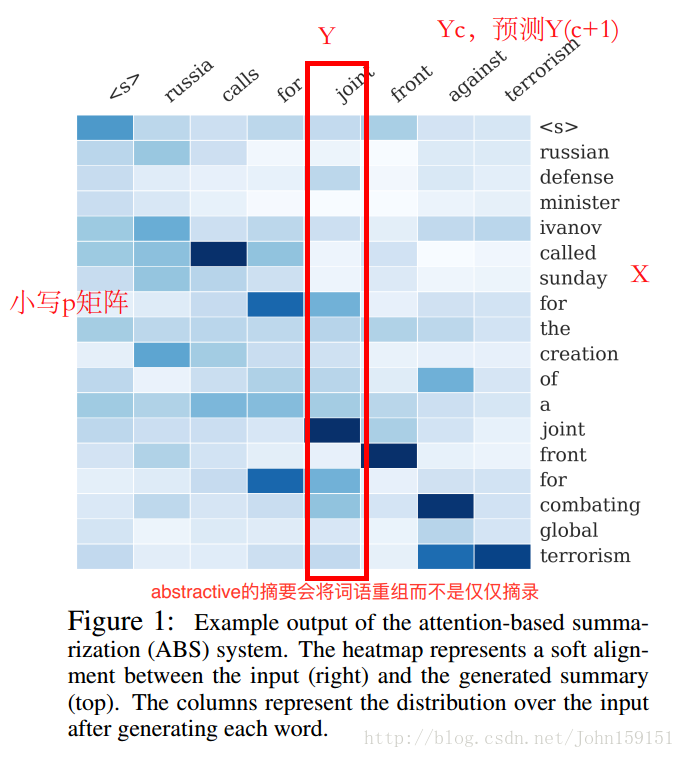

本文提出了一种data-driven的方法来做句子摘要,使用了一种基于局部注意力模型(local attention-based model),在给定输入句子的情况下,生成摘要的每个词。本文提出的模型结构简单,可以套用流行的end2end框架来训练,并且很容易扩展到大型训练数据集上。模型在DUC2004任务中效果优于几个不错的baselines。

1、本文关注点在于单个句子,进行abstractive式摘要;

2、输入X: X(1), X(2), …, X(M), 长度为M;

输出Y: Y(1), Y(2), …, Y(N), 长度为N, N大小固定;

词典V;

目标函数s(x, y);

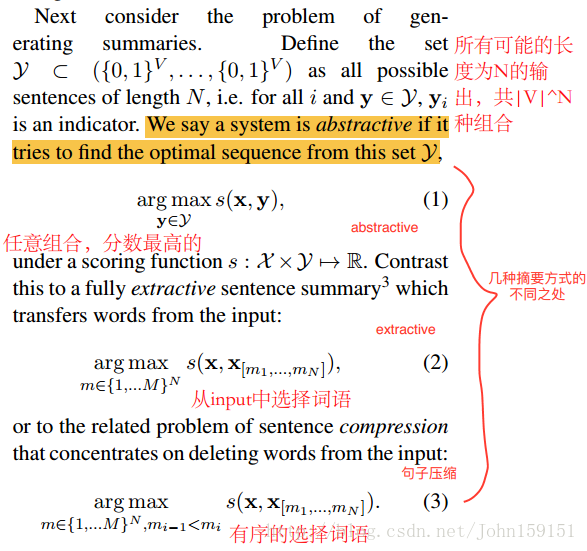

3、3种摘要方式的区别:

①Abstractive

②Extractive

③Sentence compression

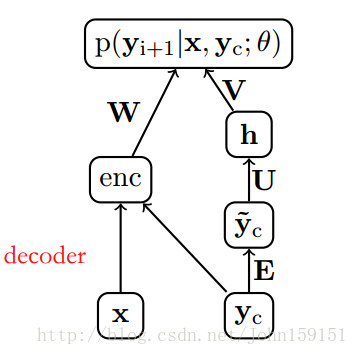

4、ABS(Attention-Based Summarization)的具体做法是:

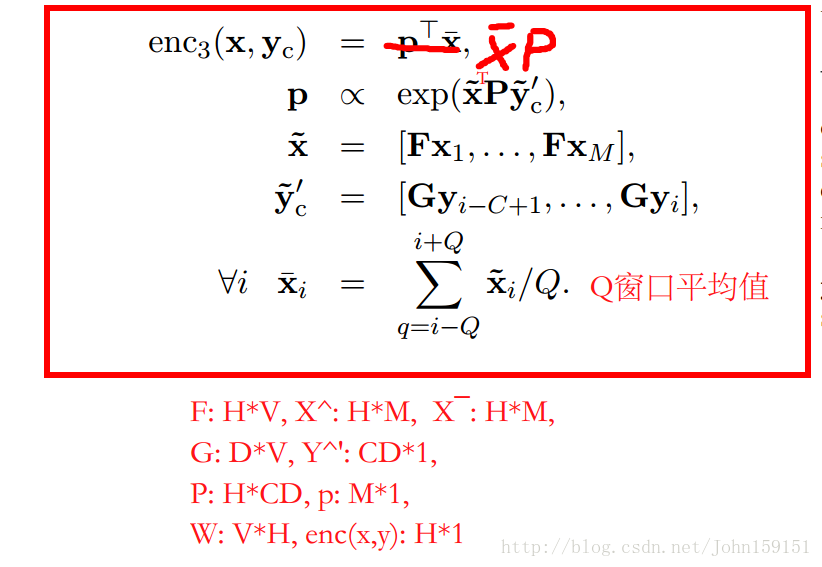

①维度:

F: H*V, X^: H*M,

E: D*V, Y^: CD*1,

U: H*CD, h: H*1, V: V*H

W: V*H, enc(x,y): H*1,

output: V*1(下一个词的选择)

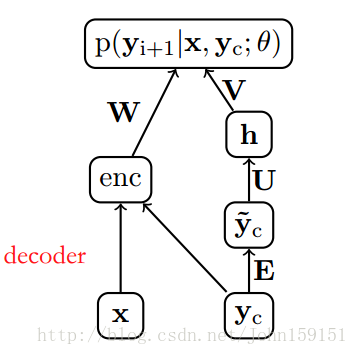

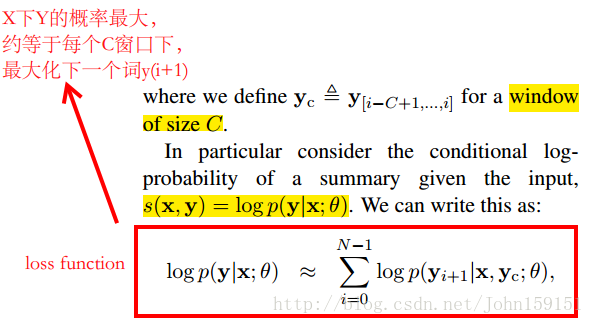

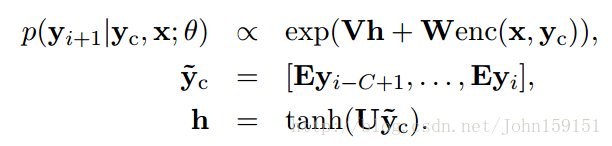

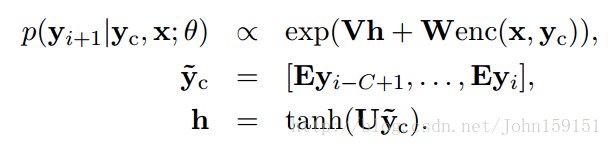

②目标是通过y(c)预测后一个词语y(i+1);

③先对x与y(c)进行encode成H*1的向量;

④将y(c)embedding,U乘,经过非线性变换,得到h(H*1)向量;

⑤继续非线性变换,得到V*1的向量,代表下一个词的概率;

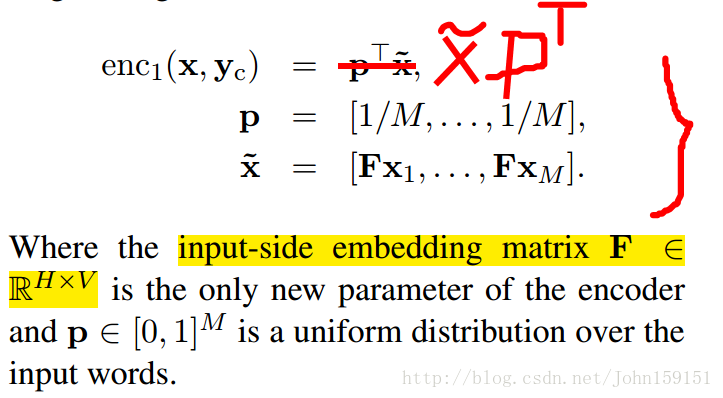

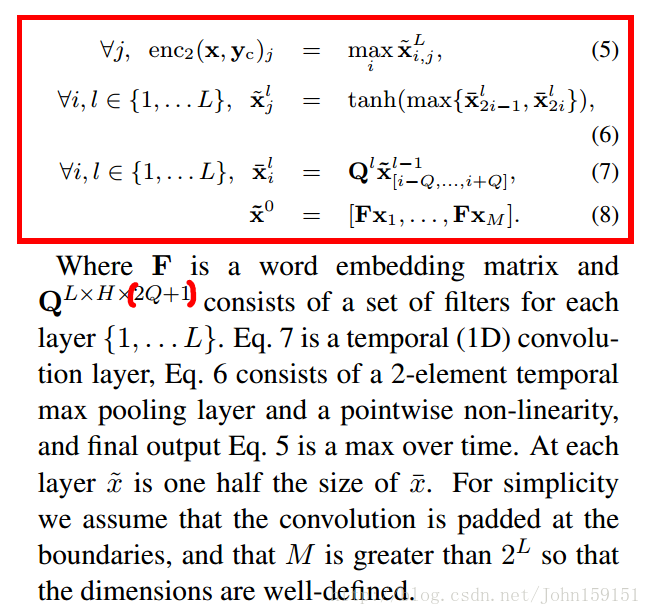

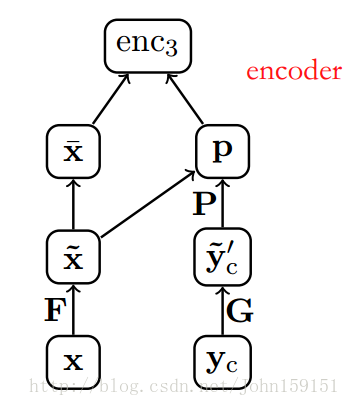

5、Encode的三种方式:

①enc1:Bag-of-Words Encoder

②enc2:Convolutional Encoder

CNN通过结合word embedding将句子表示成一个matrix,通过不同尺寸的卷积核来filter出句子中的feature。

③enc3:Attention-Based Encoder

6、Decoder

decoder的本质就是一个神经网络语言模型,本文用了2003年Bengio提出的NNLM。NNLM的模型是一个FNN(Feed-Forward Neural Network),通过上文(当前词的前N个词)来预测当前词,待求的参数是:

①word embedding矩阵E;

②输入层到隐藏层的权重矩阵U;

③隐藏层到decoder输出层的权重矩阵V;

④encoder输出层到decoder输出层的权重矩阵W;

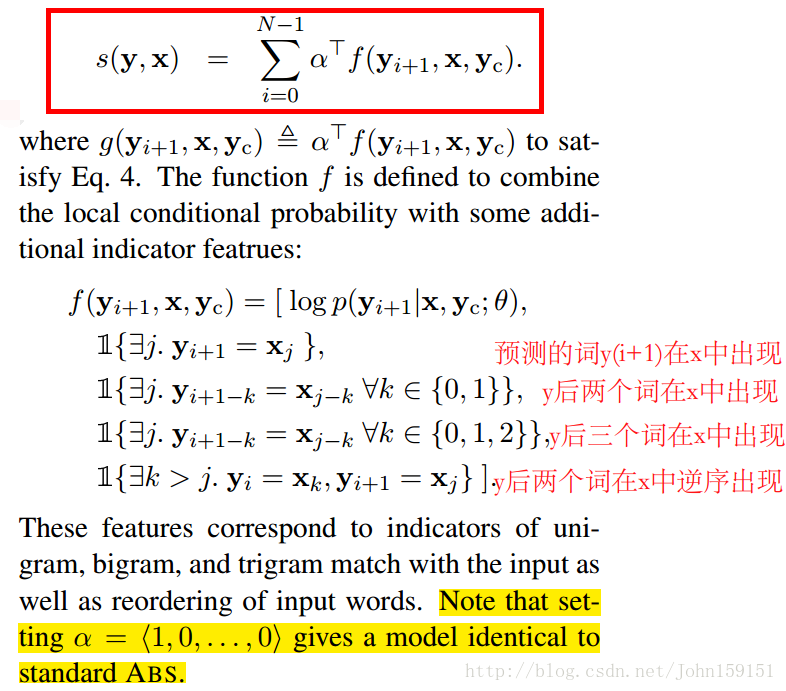

7、ABS+

作者在ABS的基础上,增加了一些统计的feature,形成ABS+;

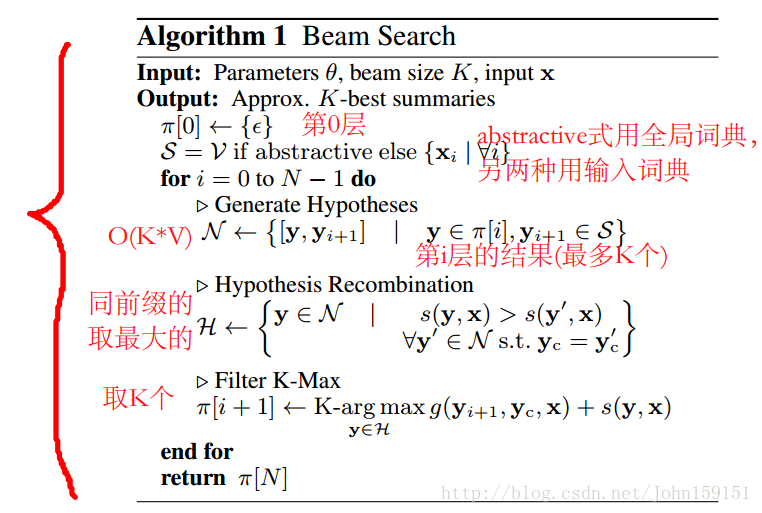

8、Generating Summaries

在测试集中,本文使用Beam Search的方法进行生成摘要,时间复杂度为O(KNV);

Beam Search(集束搜索)[2]使用广度优先策略建立搜索树,在树的每一层,按照启发代价对节点进行排序,然后仅留下预先确定的个数(Beam Width-集束宽度)的节点,仅这些节点在下一层次继续扩展,其他节点就被剪掉了。如果集束宽度无穷大,那该搜索就是宽度优先搜索。

①将初始节点插入到list中;

②将给节点出堆,如果该节点是目标节点,则算法结束;

③否则扩展该节点,取集束宽度的节点入堆。然后到第二步继续循环;

④算法结束的条件是找到最优解或者堆为空;

实验

9、Dataset

经过处理的约400万Gigaword数据集[3]作为训练集和验证集,在DUC2004数据集上进行评测;

10、评测方法

①ROUGE-1;

②ROUGE-2;

③ROUGE-L;

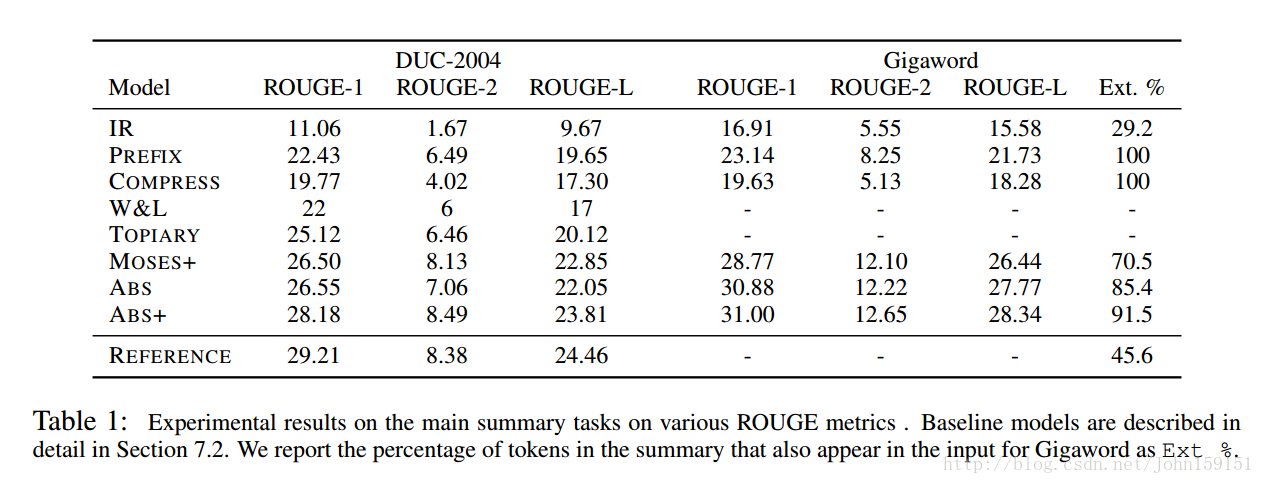

11、Baseline

①PREFIX:这个baseline是取输入的前75个字符作为headline;

②TOPIARY;

③COMPRESS;

④IR;

⑤W&L;

⑥MOSES+;

12、对比结果

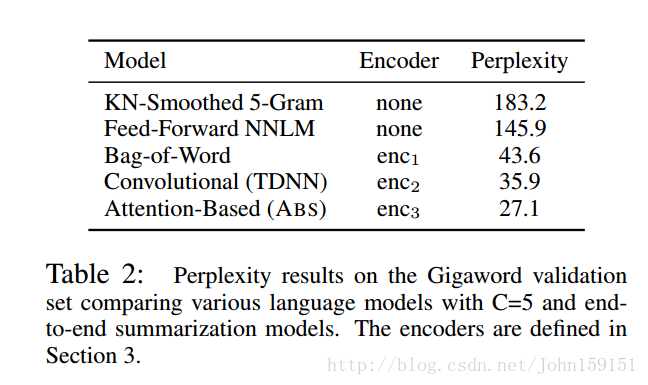

13、不同Encoder对比

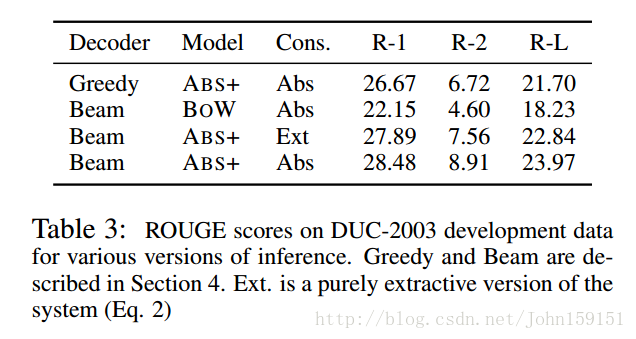

14、Generating Summaries方式对比

参考资料:

[1]、https://zhuanlan.zhihu.com/p/21388469

[2]、http://www.cnblogs.com/xxey/p/4277181.html

[3]、https://catalog.ldc.upenn.edu/LDC2012T21

以上均为个人见解,因本人水平有限,如发现有所错漏,敬请指出,谢谢!

1966

1966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?