题外话:这是一个“连载”,主要用于记录并监督我每周的Spark学习进程

一、初始化SparkContext【基于python】

1.新建一个py文件,用于存放python脚本(备注:我在桌面建了一个文件夹py,主要用来存放python脚本)

shell命令:

sudo vim "test.py"然后在test.py文本中输入以下程序:

from pyspark import SparkConf,SparkContext

conf=SparkConf().setMaster("local").setAppName("My App")

sc=SparkContext(conf=conf)

{

其中:

setMaster:用来指定spark如何连接到集群上,local为本地模式,是指让spark运行在单机单线程上而无需连接到集群

setAppName:用来设定应用名。本例中使用的是My App。当连接到一个集群时,这个值可以帮助你在集群管理器的用户界面中找到你的应用。(暂不太懂,文字取自《Spark快速大数据分析》

}

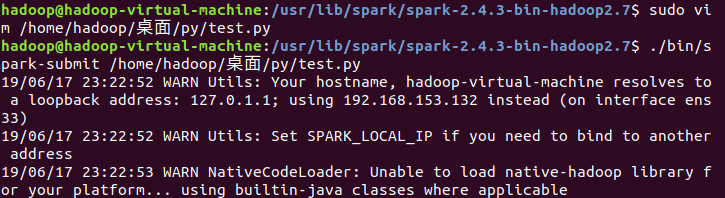

保存文件并退出,然后启动该程序。

shell命令:

cd /usr/lib/spark/spark-2.4.3-bin-hadoop2.7/ #进入spark目录

./bin/spark-submit /home/hadoop/桌面/py/test.py #运行

运行截图:

二、运行examples中自带的wordcount.py

spark目录下有个examples文件夹,里面附带python编写的各类示例,如下图所示:

同样,通过shell命令来运行wordcount.py

shell命令:

./bin/spark-submit ./examples/src/main/python/wordcount.py README.md运行截图:

821

821

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?