DeepSeek本地部署初体验记录

前言

最近,DeepSeek在AI圈已经杀疯了,正好最近有时间可以学习了解一下。参考了网络上一些资料,学习了本地部署DeepSeek。网络上的资料大致分为使用Olama或者LM Studio的方式,我这里使用了LMStudio进行部署。

一、LM Studio 安装

LM Studio是一个用于安装和管理大模型的工具,在界面显示方面相对于Olama更为优秀。

LM Studio官网:https://lmstudio.ai/

在官网选择合适的版本下载即可。

下载完成后直接打开安装即可。

二、模型下载

下载模型的时候可以通过在LM Studio的Discover中下载,也可通过在网站上下载模型后导入。根据自身电脑配置选择合适的模型下载,越大的模型需要的配置要求越高。在这里我选择了部署DeepSeek R1 7b。

方式一. LM Studio模型下载

直接打开LM Studio的Discover页面,选择响应模型下载即可。

但这个过程中可能因为一些特殊原因出现无法搜索到模型的情况,这里参考了以下链接进行解决,即更换镜像源。

但这个过程中可能因为一些特殊原因出现无法搜索到模型的情况,这里参考了以下链接进行解决,即更换镜像源。

链接: link

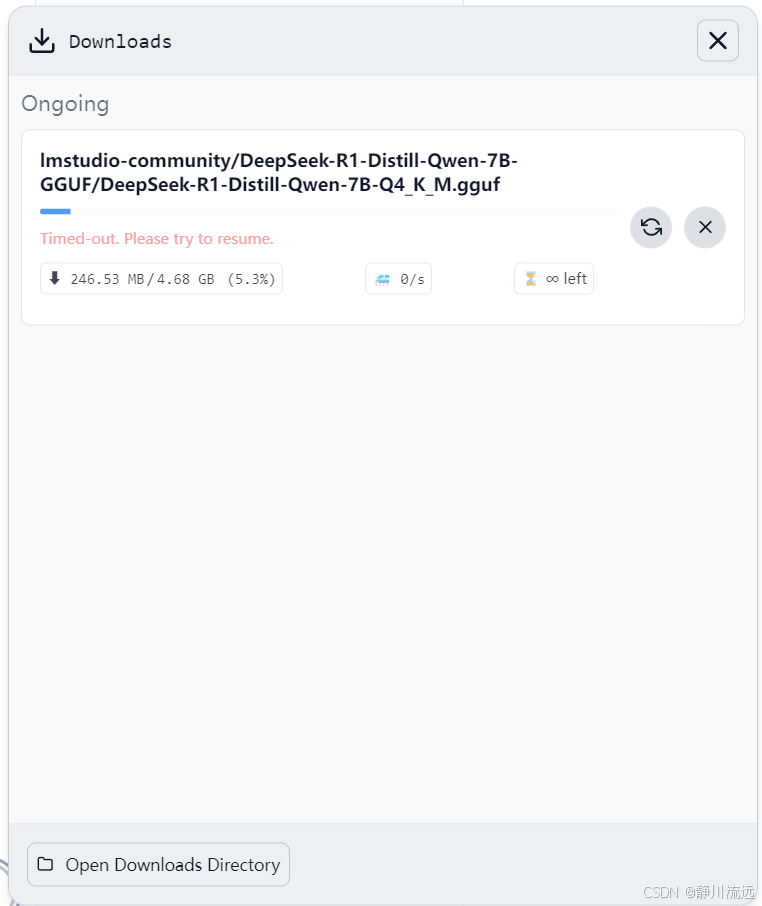

更换镜像源后便可以搜索并下载模型了。(但我在下载模型的时候经常会出现超时错误,这个问题并未解决,欢迎各位大佬指正。)

方式二. 离线模型下载

离线的方式时通过在网站上下载相应的模型,然后将模型文件移动到LM Studio管理的文件下即可。当然也可也通过LM Studio选择文件。

模型下载链接:link

三、模型加载

我是通过下载模型后再移动到LM Studio管理的文件,在这个过程中还有一个小坑,选择的文件路径是…\models,但实际上模型文件需要放在…\models\Publisher\Repository目录下LM Studio才会自动识别模型。

然后在对话栏中选择模型加载即可。

DeepSeek初体验:

1202

1202

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?