一、下载大模型工具Ollama

1、Ollama大模型简介

官网:https://ollama.com/

1> Ollama是一个用于部署和运行各种开源大模型的工具;【支持78种模型】

2> 它能够帮助用户快速在本地运行各种大模型,极大地简化了大模型在本地运行的过程。用户通过执行几条命令就能在本地运行开源大模型,如Llama 2等;

3> 综上,Ollama是一个大模型部署运行工具,在该工具里面可以部署运行各种大模型,方便开发者在本地搭建一套大模型运行环境;

2、下载大模型Ollama

下载:https://ollama.com/download

说明:Ollama的运行会受到所使用模型大小的影响;

1> 例如,运行一个7B(70亿参数)的模型至少需要8GB的可用内存(RAM),而运行一个13B(130亿参数)的模型需要16GB的内存,33B(330亿参数)的模型需要32GB的内存;

> 需要考虑有足够的磁盘空间,大模型的文件大小可能比较大,建议至少为Ollama和其模型预留50GB的磁盘空间;

3> 性能较高的CPU可以提供更好的运算速度和效率,多核处理器能够更好地处理并行任务,选择具有足够核心数的CPU;

4> 显卡(GPU):Ollama支持纯CPU运行,但如果电脑配备了NVIDIA GPU,可以利用GPU进行加速,提高模型的运行速度和性能;

3、安装大模型Ollama

1> 下载OllamaSetup.exe文件

2> 点击执行OllamaSetup.exe,安装Ollama工具

4、在 Ollama工具 上运行大模型

1> 以 管理员身份 打开 cmd 命令窗口

2> 在命令窗口运行大模型

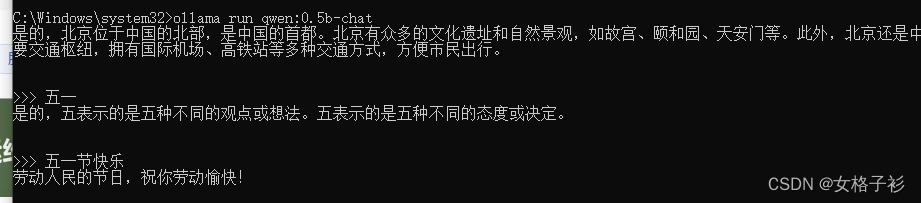

①千问 -- 执行命令: ollama run qwen:0.5b-chat 安装qwen:0.5b-chat大模型

②llama3 -- 执行命令: ollama run llama3:8b 安装llama3:8b大模型

千问和llama3是常用的大模型

备注:查看需要安装的模型和版本号:https//ollama.com/models

3> 查看模型列表命令:ollama list

4> 聊天对话

5、Ollama运行大模型的默认端口:11434

http://localhost:11434

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?