目录

一:DeepSeek是什么?

1.1: DeepSeek简介

DeepSeek 全称杭州深度求索人工智能基础技术研究有限公司,简称深度求索,成立于2023 年 7 月,是幻方量化旗下的 AI 公司,专注于实现通用人工智能( AGI ) , 具有深厚的软硬件协同设计底蕴。

DeepSeek 共研发开源十余款模型, 目前最受关注的有 V3 对话模型和 R1 推理模型 ,分别于 2024 年 12 月 26 日和 2025 年 1 月 20 日先后发布。从反映关注度的微信指数上可以看出,两 次模型发布都造成了后续 DeepSeek 关注度的飙升 , 12 月 28 日 DeepSeek 指数达到约6000 万, 1 月 31 日达 9.8 亿。V3 : 是采用混合专家架构( MoE )的高性能对话模型,支持多任务处理并在代码生成、数学推理等场景表现优异。R1 : 是基于强化学习训练的 推理模型 ,专注于代码生成和复杂数学问题解决,推理能力通过蒸馏技术可迁移至小型模型。

推理模型是在基座模型基础上再经过推理数据训练得到的模型, 回答问题时会先通过思维链( CoT )逐步思考,再输出结果。 DeepSeek R1 模型属于一种推理模型。

1.2: DeepSeek为什么这么火

众所周知OpenAI的o1模型性能曾在推理模型领域难逢敌手。而DeepSeek-R1模型,在AI模型基准能力的各大榜单中,得分与OpenAI o1模型不相上下。

在过去两年中,中国AI模型在业内曾被认为落后于美国模型半年到一年。 DeepSeek R1模型的出现终结了中国AI落后的观点。

作为国产模型, DeepSeek 对中文支持更好。

低训练成本、低推理成本

从模型训练看 , DeepSeek-V3 在 2048 块 H800 GPU 训练 3.7 天,换算成单块 GPU 共 278.8 万小时,以 H800 每小时 2 美元成本计算, 最后一轮训练硬件成本仅约 558 万美元 ; Meta 同规格的 Llama 3.1 模型约花费 9240 万美元, 相比高出 16 倍 。从模型推理看 ,以官方 API 接入价格为例, 对话模型 DeepSeek V3 价格约为 OpenAI GPT-4o 价格的 十分之一;推理模型 DeepSeek R1 价格约为 OpenAI o1 价格的 二十分之一 。

| 价格 | DeepSeekV3 | GPT-4o | DeepSeekR1 | o1 |

| 百万token输入价格(命中缓存) | 0.5元 | 9.1元 | 1元 | 54.4元 |

| 百万token输入价格(未命中缓存) | 2元 | 18.1元 | 4元 | 108.7元 |

| 输出价格 | 8元 | 72.5元 | 16元 | 434.8元 |

开源

开源和闭源的区别

- 开源模型是将模型技术细节和模型权重免费公开,供全球研究人员研究模型技术和技术人员部署使用。比如DeepSeek系列模型、Llama系列模型。

- 闭源模型则是部分公开或不公开技术细节,模型大小和模型权重保密。比如OpenAI和百度等。

- 与闭源模型的策略相比,将模型开源的策略可以获得更多开发者关注使用和共同开发,利于构建影响力和实现普惠。但难以获得商业利润。

- 将最先进的技术保密,有利于持续保有市场竞争力,实现商业化获利。但吸引开发者较少,且不利于社会整体技术进步。

大模型开源级别

在各家AI模型厂商宣布开源时,开源的程度并不相同。开放源代码促进会( OSI)于2024年10月发布开源AI定义1.0( OSAID 1.0)。

OSAID 1.0从模型权重、训练数据、代码、商业使用权、社区协议、符合开源定义等多维度评价开源程度。

| OpenAI | Meta | DeepSeek | OSI(OSAID 1.0) | |

| 模型权重公开 | 不公开 | 公开(有限制) | 完全公开 | 必须公开 |

| 训练数据透明 | 不透明 | 部分透明 | 部分透明 | 尽可能透明 |

| 代码开源 | 闭源 | 开源(有限制) | 完全开源 | 必须开源 |

| 商业使用 | 仅通过API 收费 | 禁止 | 允许 | 允许 |

| 社区协议 | 不支持 | 有限支持 | 完全支持 | 完全支持 |

| 符合开源定义 | 不符合 | 部分符合 | 完全符合 | 完全符合 |

业界认可

OpenAI 创始人 Sam Altman : DeepSeekR1 是一 个令 人 印象 深 刻 的模型, 尤其 是能 够 以 这样 的价格 提供卓越 性能。 我们 ( OpenAI )显然会 推出更好的模型,同时,有一 个新 的 竞争 对手 加 入 确 实 让 人 感 到 振奋!微软 CEO Satya Nadella : DeepSeek 的 新 模型 非常令 人 印象 深 刻 , 他们 不 仅 有 效地 实现了一 个 开源模型,实现了推理时 间 计算, 而且 计算 效率极 高。AI 投资机构 a16z 创始人 Marc Andreessen : DeepSeekR1 是 他所见 过的 最令 人 惊叹 、 最令 人 印象 深 刻 的 突破之 一,是 给世界 的一份深 刻礼物 。Eureka Labs 创始人 Andrej Karpathy : DeepSeekR1 与 OpenAI 的模型在性能上旗 鼓 相 当 。Perplexity 创始人 Aravind Srinivas : DeepSeek 是人工智能和开源的重大 进步 。人工智能模型和 使 用 这些 模型的产 品需要最 大限度地寻 求 真 相。输出 越虚假 , 使 用 这些 模型 或其 输出( 直 接作为用 户 )和 间 接(用于 提炼 ) 就越危险 。NVIDIA 资深研究经理 Jim Fan : DeepSeek 不 仅 开源了一 系列 模型,更难能可 贵 的是公开了 所 有训练细节。

二、DeepSeek技术路线解析

R1系列模型训练流程

R1模型以V3模型作为基座模型训练 , 因此R1模型继承了V3模型大 部分架构特征。

R1模型的训练过程包括 ,首先用V3模型训练出一个具有强推理能 力的R1 zero模型,R1 zero经过冷启动生成推理数据,随后利用推 理数据和SFT数据进行强化学习和SFT等训练过程 ,最终得到R1模型。

R1蒸馏模型由Qwen和Llama的共6种不同尺寸的小模型,通过推理数据和非推理数据的组合通过SFT训练而来。

2.1: 成本相关技术

DeepSeekV3 和 R1 模型 前馈神 经 网络均 采用混合专家( MoE )架构。每 个 MoE 层包含 1 个 共 享 专家和 256 个路由 专家 组 成,在 运行时每 个词 元( token ) 只激活 8 个路由 专家。

• MoE架构主要包括路由和专家两部分。

• 传统稠密模型数据都经过单个神经网络处理,MoE稀疏模型的数据则经过路由分配给适合的多 个专家模型处理。

• 与稠密模型相比 , MoE模型每个词元只需激活模型 中的部分专家, 节约计算资源。

• 不同专家专注于不同任务,处理复杂任务时更有 优势。

多头潜在注意力MLA

MLA 的核心是对注意力键和值进行低秩联合压缩 ,减少推理过程中的键值缓存(KV cache), 从而降低推理时的内存占用。

• 引入旋转位置编码(RoPE)来保持位置信息的有效表示。

• 通过低秩压缩技术, 将高维输入压缩到低维空间,提高推理效率。

• 擅长捕捉数据的潜在含义 ,如语义、因果关系等。

• 擅长处理更长的上下文。

多词元预测训练MTP

多词元预测是指,在训练过程中,模型不仅预测下一个词元,同时预测多个未来的词元。 这种方法通过在共享模型主干上增加多个 独立的输出头来实现,并且不增加训练时间和内存消耗。

• 多词元预测深度设置为1 , 除了下 一个词元, 每个词元会额外预测 一个词元。

• 模型分为主体部分和多个头,每 个头有自己的RMSnorm、一个

Linear和一个Transformer Block。

• 各个头的预测有依赖关系 ,主模 型计算完后再送给后续的头,从 而实现多词元预测。

FP8混合精度训练

模型训练通常采用FP16或FP32精度的数据格式以保证训练效果,如果换成低精度即可降低存储占用,但往往受到激活、权重和梯度 中异常值的限制。

为了解决这个问题, DeepSeek采用了混合精度框架, 使用细粒度量化策略、低精度优化器状态等方法以实现增强精度、 低精度存储 和通信,同时DeepSeek向硬件厂商也提出了硬件设计的相关建议。

2.2: 性能相关技术

强化学习中的群体相对策略优化(GRPO)

近端策略优化算法( PPO)是OpenAI于2017年提出的一种强化学习算法,被用于GPT等多款主流模型训练过程中用于优化模型表现。 DeepSeek提出组相对策略优化(GRPO ),对PPO改良,提高计算效率,降低内存占用。

• GRPO移除了PPO中的价值函数。

• GRPO将广义优势估计(GAE)改 为组归一化优势(GroupComputation)。

• GRPO将KL散度移动到损失函数中。

2.3: 热点话题

问:DeepSeekV3成本为550万美元?

答: DeepSeek V3 成本并非是550万美元。

DeepSeek V3技术报告明确指出, 预训练、上下文延长、后训练等三个训练过程共花费约558万美元。准确来说, 除了公开的训练成 本,模型总成本还应考虑人员成本、研发成本、数据成本、 其他固定成本等。

问:DeepSeekR1是蒸馏OpenAI数据训练出来的?

答 :没有证据说明DeepSeek R1蒸馏数据来源于OpenAI。

OpenAI声称掌握证据并指控DeepSeek违反OpenAI服务规定使用其数据用于训练R1模型, 但并未拿出有力证据。 此前OpenAI曾因违 规使用纽约时报数据训练模型被告侵权。 此外,业界有其他公司利用OpenAI数据训练自己的模型, 但并未取得好的效果。

术语解读 - 模型蒸馏

在机器学习领域, 模型蒸馏是将知识从大型 模型转移到较小模型的过程 ,虽然大型模型 (例如非常深的神经网络或许多模型的集合) 比小型模型具有更多的知识容量, 但这种容 量可能没有得到充分利用。

蒸馏模型示意图:

问: DeepSeek绕过了CUDA?

答 : DeepSeek 没 有 绕 过 CUDA 。业 界 普遍 认为 CUDA 技术 体系 构成了 英伟 达在 AI 计算领域的重 要 技术 壁垒 , CUDA 生 态 优 势 对硬件 市 场格 局 具有深 远影响 。 若 能 突破现有技术生态 限 制 ,有 助 于 AI 芯片 市 场多元化发 展 。 DeepSeek 采用 a 定制 的 PTX 优化,能更好 释 放 底 层 硬件性能。从技术架构来看,PTX作为更接 近 硬件 层 的中 间 表 示层 , 其 价 值 在于 提供 了 比 CUDA 更高 灵 活 性的 编程 接 口 。 但 PTX 本 质 上 仍 是 英伟 达 GPU 架构的专用指令 集 规 范 ,不同计算架构 需要 构 建 适配 自 身 硬件 特 性的中 间层 指 令系统 。

术语解读 - CUDA

CUDA 全称为计算 统 一设 备 架构,是一 个 专有的并 行 计算 平台 和 应 用 程 序 编程 接 口 。开发 者使 用 CUDA 接 口 , 便 于关注软件算 法 , 无需关注硬件本 身 每一 步 是 如 何 具 体运行 的。

术语解读 - PTX

PTX 全称为并 行 线 程 执 行 ,是 Nvidia 的 CUDA 编程 环境 中 使 用的 低 级 并 行 线 程 执 行虚 拟机 和指 令 集 架构。 PTX 比 CUDA 更 靠 近 硬件 层 。

三、DeepSeek调用与部署

DeepSeekR1模型可通过云端调用和本地部署的方式使用。

• 云端调用

• 云端调用,可通过官方API或第三方API直接调用DeepSeek R1模型服务并接入业务中; 或者可以在云平台上创建、部署、微调 模型,再通过API连接模型调用。

• 云端调用优势在于,用户无需购置硬件即可按需调用云端模型。

• 本地部署

• 要本地运行模型,用户需下载DeepSeek R1满血版或蒸馏版本模型,通过Ollama、vLLM等工具启动模型,并借助可视化界面工 具与用户交互。

• 本地部署优势在于无网络依赖 ,适合对数据安全要求高的企业私有化场景, 但需满足高性能显卡和服务器的硬件配置要求。

3.1: 云端调用

| 软件/应用 | API服务接口 | 云平台 |

| 纳米搜索、秘塔AI搜索、文心一言、钉钉、天工AI、扣子、飞书、微信、网易手游、海螺AI、知乎 … | DeepSeek官方、硅基流动 ... | 腾讯云、阿里云、华为云、火山引擎、百度智能云、无问芯穹 ... |

| 成本 | |

| 软件或应用 | 接入的DeepSeek R1普遍为免费使用, 但使用次数可能受限。 |

| API服务 | DeepSeek官方: R1模型每百万token,输入价格为1元(命中缓存) 或4元(未命中缓存),输出价格为16元。 硅基流动: R1模型每百万token,输入价格为4元,输出价格为16元。 |

| 云平台 | 偏向为企业级用户服务,各云平台服务类型丰富收费不一,以百度智能云为例,与DeepSeek R1相关的服务包括 :平台预置服务调用、用户部署模型服务调用、模型精调、批量预测等。 在百度智能云直接调用R1模型API,每百万token输入价格2元,输出价格8元。 在阿里云直接调用R1模型API,每百万token输入价格4元,输出价格16元。 |

3.2: 本地部署

蒸馏版R1模型

| 1.5b | 7b | 8b | 14b | 32b | 70b | |

| 显存需求 | 1.1G | 4.7G | 4.9G | 9.0G | 20G | 43G |

| 硬件建议 | CPU或GPU | RTX 4050 | RTX 4050 | RTX 4070 Ti | RTX 4090 | 多块高性能GPU |

成本

| 模型 | 建议配置 | 估价 |

| 671B | 【 GPU】 NVIDIA H800 X 8 【内存】256G | 约180-300万元 |

| 【 GPU】 NVIDIA RTX 5000 Ada X 2 【内存】 128G | 约12万元 | |

| 70B | ||

| 【 GPU】 NVIDIA RTX 4090 【内存】 64G | 约3万元 | |

| 32B | ||

| 【 GPU】 NVIDIA RTX 4070 Ti 【内存】 32G | 约1.5万元 | |

| 14B | ||

| 【 GPU】 NVIDIA RTX 4050 【内存】 16G | 约7000元 | |

| 8B | ||

| 【 GPU】 NVIDIA RTX 3050 【内存】 16G | 约5000元 | |

| 7B | ||

| 【 CPU】 Intel Core i3 【内存】 8G | 约3000元 | |

| 1.5B |

本地部署实测

| DeepSeek R1 32b模型 | DeepSeek R1 70b模型 | |

| 2人并发 | 28.9字/秒 | 14.2字/秒 |

| 5人并发 | 21.3字/秒 | - |

部署DeepSeek一体机汇总(1)

| 厂商 | 一体机名称 | 配置(部分型号) | 特点 | 价格 |

| 灵犀Cube大模型一体 机(DeepSeek版) | 灵犀Cube纯享版: | 包含纯享版和使能版两大系列,共 计六大款型12款产品。 | ||

| 新华三 | -R5500 G6(GPU*8 141G) 671B满血版推理+API | 未公开 | ||

| 浪潮计算机DeepSeek 推理一体机 | 搭载国内AI算力产品,单卡FP16算力, 支持FP32/FP16混合精度加速 | 全面兼容DeepSeek V3、 R1等系列模 型,支持智能客服与对话、工业质 检等场景。 | ||

| 浪潮计算机 | 未公开 | |||

| 中科曙光DeepSeek 人工智能一体机 | 国产X86 CPU+国产GPU加速卡,支持全 精度混合训练与推理 | 多形态曙光高端计算服务器、高效 能基础模型、全流程AI工具链于一 体。 | ||

| 中科曙光 | 未公开 | |||

| 超聚变DeepSeek 大模型一体机 | 旗舰版: G8600 V7 | 兼容主流AI算力; DeepSeek V3、 R1 等全搭载;行业AI应用端到端服务 | ||

| 超聚变 | -模型: 671B | 未公开 | ||

| -CPU>=64核 -内存>=768GB | ||||

| 宁畅 | 宁畅DeepSeek 大模型一体机 | X680 G55( 1128G HBM3e显存)、 X640 G65(16/32颗GPU液冷设计) | 单机部署打破算力边界 ,集群扩展 灵活 ,AIOps智能运维降低成本 | 未公开 |

部署DeepSeek一体机汇总(2)

| 厂商 | 一体机名称 | 配置(部分型号) | 特点 | 价格 |

| 息壤智算一体机- DeepSeek版 | 基于华为昇腾芯片 ,提供 多种配置,支持满血版 | 100%国产化技术链路,高安全性与 合规性 | ||

| 中国电信 | 671B模型 | 几十万-数百万 | ||

| 中国移动 | 移动云智算一体机- DeepSeek版 | 国产CPU/GPU和操作系统 为核心,全套信创解决方 案 | 预装的DeepSeek模型镜像极大地降 低企业使用门槛 ,真正实现开箱即 用 | 未公开 |

| 中国联通 | 联通云DeepSeek一体机 | 联通云“星罗”平台深度适 配国产算力芯片 | 将模型优化、工具链与国产硬件深 度集成,实现开箱即用 | 未公开 |

| 京东云 | 京东云DeepSeek 大模型一体机 | 支持华为昇腾、海光、寒 武纪等国产AI加速芯片 | 国产算力全适配、开箱即用,支持 本地知识库快速构建 | |

| 几十万-数百万 | ||||

| 海光CPU+昆仑芯 P800或 Intel CPU+昆仑芯 | 支持单机8卡部署,从开箱上电到服 务上线最快仅需0.5天 | |||

| 百度智能云 | 百舸DeepSeek一体机 | P800/H20 | 未公开 |

部署DeepSeek一体机汇总(3)

| 厂商 | 一体机名称 | 配置(部分型号) | 特点 | 价格 |

| 华为 | FusionCube A3000 训推一体机 | Ultra版搭载2个Atlas800l A2服务器,支 持671B模型(1911 token/s) | 昇腾芯片深度适配 , ModelEngine平 台实现一键部署,高并发低时延 | 未公开 |

| 联想DeepSeek 训推一体机 | 以“联想服务器/工作站+沐曦训推一体 GPU+自主算法”为核心架构 | 国产GPU性能达国际主流110%-130%, 支持私有化部署和全链路硬件可信 | ||

| 联想 | 几十万-数百万 | |||

| 优刻得DeepSeek 大模型一体机 | 支持沐曦、昇腾等国产芯片 ,预置全系 列模型, 提供微调与推理能力 | 软硬一体化交付 ,适配多国产芯片, 一键部署专属大模型 | ||

| 优刻得 | 未公开 | |||

| 天巡DeepSeek 大模型一体机 | 鲲鹏CPU+昇腾NPU ,openEuler系统, 推理加速引擎实现时延降低40% | CPU与NPU高效协同, 快速部署行业 知识库与应用 | ||

| 华鲲振宇 | 未公开 | |||

| 智算先锋Deep Fusion DF100 | 单机支持671B满血模型, 自研PerfXLM 推理引擎 ,预装PerfXCloud管理平台 | |||

| 澎峰科技 | 开箱即用, 极致优化推理速度 | 未公开 |

部署DeepSeek一体机汇总(4)

| 厂商 | 一体机名称 | 配置(部分型号) | 特点 | 价格 |

| 从底层芯片、推理引擎、模型服务 到管理平台,实现全栈国产化解决 方案。 | ||||

| 讯飞星火DeepSeek塔式一体机A1000a (2*华为昇腾Atlas 300I系列) | ||||

| 科大讯飞 | DeepSeek塔式一体机 | 未公开 | ||

| 长城擎天GF7280 V5 AI训推一体机 | 搭配NV L20和国产天数BI-V150和沐曦 C500三种不同GPU算力卡 | 具有“开箱即用、经济高效、持续更 新与支持”三大优势 | ||

| 长城 | 几十万-数百万 | |||

| 宝德自强昇腾AI DeepSeek一体机 | PR210KI :采用鲲鹏+昇腾双处理器; | 全面支持DeepSeek V3/R1及蒸馏模 型从7B到671B的满血版 | ||

| 宝德计算 | PR425KIG2 :基于鲲鹏+昇腾处理器打造。 | 未公开 | ||

| CPU: 2颗龙芯3C5000 | ||||

| 龙芯DeepSeek 推理一体机 | 内存: 16/32/64GB | 融合龙芯自主处理器LoongArch架构 与太初元碁自研加速架构 | ||

| 龙芯中科 | AI算力卡 :太初元碁T100 | 未公开 |

四、如何使用DeepSeek

当前DeepSeek的使用 ,可划分为两大范式:独立使用、工具组合使用。

独立使用:

通过自然语言对话获取核心服务, 典型场景包括文本创作、信息咨询、知识推理等,用户仅需输入需求指令即可直接获取生成 内容;

工具组合:

基于文本指令驱动的工具生态协同,实现“ DeepSeek+”创新工作流。典型组合形态包括:

- 办公增效:智能文档处理+数据可视化呈现;

- 创意设计: 图像生成+风格化调整;

- AI音视频 :脚本创作+AI音视频合成;

- 编程辅助:代码生成+自动化测试。

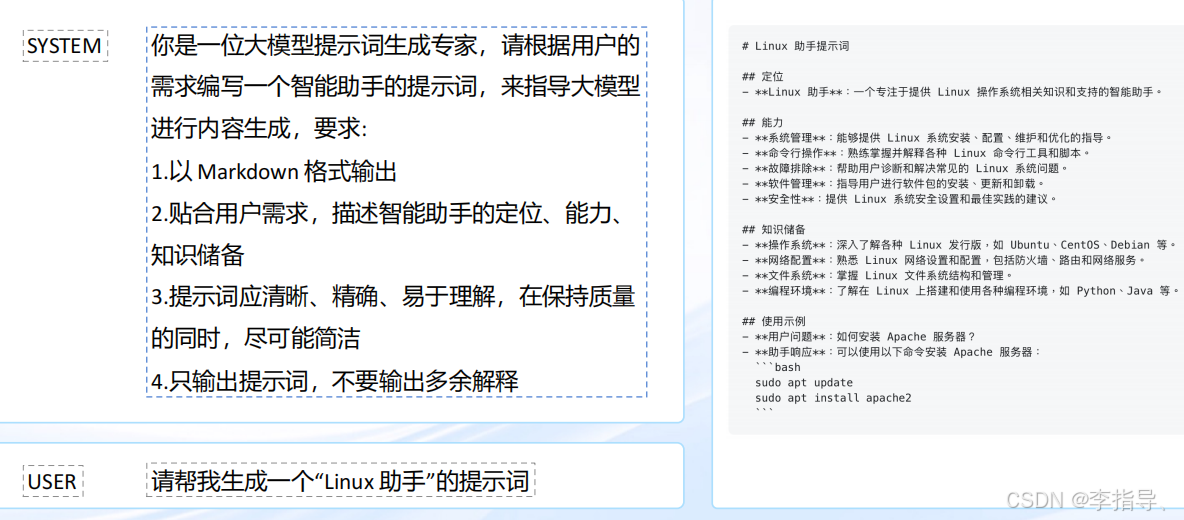

什么是提示工程

提示工程通过优化输入指令(提示词), 引导AI模型生成更精准、高质量的输出。 核心在于将模糊需求转化为结构化指令,通 过明确任务目标、提供上下文、分步引导或示例参考,解决模型输出偏差、无关或信息不全的问题, 使AI更适配具体场景需求。 典型方法包括设定角色、拆解复杂任务为多步骤、约束输出格式,以及调整模型参数控制随机性,本质是建立人机高效协作的 “对话逻辑” ,通过迭代优化提示词 ,低成本释放AI潜力。

推理模型不同之处

推理模型的不同之处在于, 它们各自擅长的任务和应用场景不同。推理模型专注于复杂任务的长期思考,能够制定战略、规划解 决方案,并根据模糊的信息做出决策 ,适用于需要专家级知识的领域, 如数学、 科学和法律等。 而通用模型则更加注重快速执行, 延迟更低、成本效益更高, 适用于直接执行特定任务, 尤其是在速度和成本重要的情况下。 因此,推理模型更强调深度思考和策 略规划 ,而通用模型则注重高效执行和实时反馈。在一些应用中,两者可以互补使用,推理模型负责规划和决策,通用模型负责 实际的任务执行 ,确保在不同的需求下能够找到最佳平衡。

推理提示词框架

推理模型使用场景

如果速度和成本在完成任务时是最重要的因素,并且提示词可以由直截了当、规则明确的任务组成, 那么更适合通用模型; 如 果精度和可靠性是最重要的因素,并且需要解决一个非常复杂的多步骤问题, 这种场景更适合用推理模型处理。

4.1: DeepSeek独立使用篇

DeepSeek官方总结了17种提示词使用方法,涵盖了编程开发、文本分析、翻译、内容创作等类别,并提供了相应了示例。

DeepSeek代码改写

对代码进行修改,来实现纠错、注释、调优等。

提示词:

下面这段的代码的效率很低 ,且没有处理边界情况。请先解释这 段代码的问题与解决方法 ,然后进行优化: ``` def fib(n): if n <= 2: return n return fib(n-1) + fib(n-2) ```

样例输出:

DeepSeek代码解释

DeepSeek代码生成

DeepSeek内容分类

DeepSeek角色扮演(自定义人设)

DeepSeek角色扮演(情景续写)

DeepSeek散文写作

DeepSeek诗歌创作

DeepSeek文案大纲生成

DeepSeek宣传标语生成

DeepSeek模型提示词生成

4.2: DeepSeek组合使用篇

DeepSeek + XMind 快速制作思维导图

DeepSeek + 飞书分析智能数据与多维表格协作

DeepSeek + Kimi 生成智能AI演示文稿

DeepSeek+Mermaid 快速制作图表

DeepSeek + 讯飞听见一键语音转写与分析数据

DeepSeek + Obsidian:智能化整理笔记与知识管理

DeepSeek + Excel:分析智能数据与表格优化

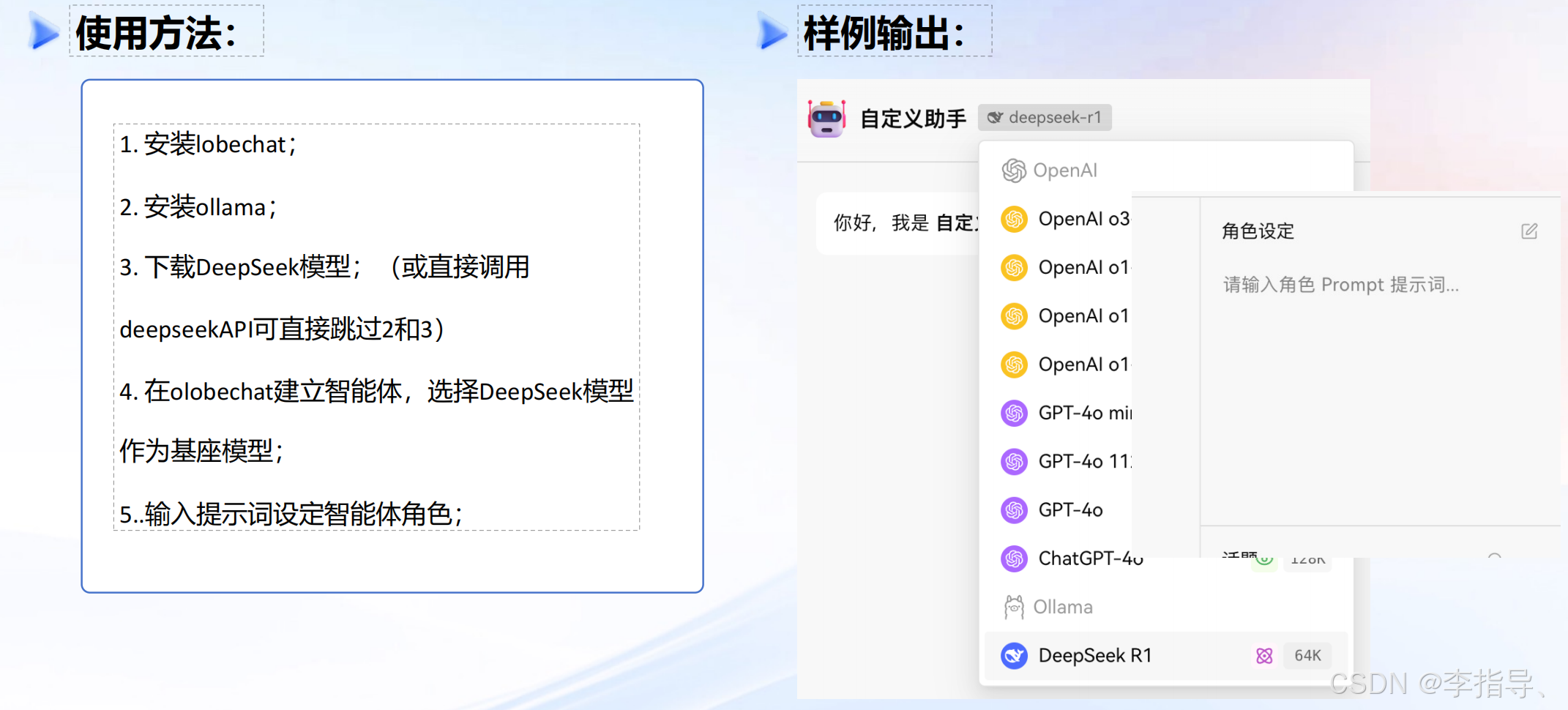

DeepSeek+LobeChat 打造个人智能体

DeepSeek+Photoshop 自动化批量处理图像

DeepSeek+MidJourny 赋能提示词AI绘图

MidJourney作为一款强大的AI图像生成工具, 利用先进的深度学习技术,能够根据用户的文字描述自动生成高质量的图像。

DeepSeek通过自然语言处理技术,可以根据用户的需求生成对应的MidJourney提示语,简化创作过程 ,帮助设计师和艺术家更高效 地实现创意, 完全不需要编程或复杂的操作。

DeepSeek + 即梦 快速设计中文海报

即梦AI是一款智能创作平台,能够帮助用户通过文本自动生成图像、视频等内容 ,适用于广告创作、 社交媒体内容、产品推广等领 域。

即梦AI 对汉字理解很好,可以直接输出中文海报。用户只需通过自然语言描述海报需求, DeepSeek 便能生成精准的提示词 , 即梦 AI则可以根据这些提示直接生成符合需求的中文海报 ,极大地简化设计流程,节省时间和精力。

DeepSeek+即梦+Tripo 一键生成3D模型

Tripo是一个在线3D建模和动画制作工具, 允许用户通过简单的操作, 快速生成和自定义三维模型。 它提供了丰富的3D模板和自定 义选项 ,适用于各种领域, 包括游戏开发、 虚拟现实、 动画制作等。

DeepSeek通过自然语言处理技术能够根据用户的文字描述生成精准的提示词 ,帮助用户在即梦平台上快速生成高质量的形象图 , Tripo则可以根据这些提示词生成与之匹配的3D模型,将即梦平台上的图像创作转化为立体、可交互的虚拟作品 ,提供更加丰富的 创作可能性, 满足更多元的设计需求。

DeepSeek + Suno:创作AI音乐与智能音频分析

Suno是一款前沿的AI音乐创作软件,能根据用户的文字描述自动生成个性化的音乐作品。无论是构建旋律、编排节奏 ,还是调动情 感表达, Suno都能够迅速响应用户的需求, 创作出丰富多样的音乐风格。通过与DeepSeek的融合,用户只需简洁地描述自己想要的 音乐氛围或情感 , DeepSeek便能够生成精准的音乐创意, 帮助创作者轻松完成从构想到完成品的全过程 ,让音乐创作变得更加直观 和高效。

DeepSeek+Heygen 实现数字人+口播

Heygen是一款创新的数字人生成平台,能够通过AI技术快速创建逼真且具有高度互动性的虚拟人物。用户可以根据需求定制数字人 的外观、表情和动作, 甚至让其进行语音对话。 无论是在广告宣传、虚拟客服还是在线教育领域, Heygen的数字人都能提供极具沉 浸感的互动体验。通过DeepSeek的支持,用户仅需简单输入需求, 便能快速生成个性化的数字人角色,简化创作流程,为各行各业 提供高效且灵活的虚拟人解决方案。

当然国内的数字人平台 ,如百度曦灵、腾讯智影、科大讯飞、蝉镜等, 也同样可以这样操作。

DeepSeek +即梦+剪映 搭建一站式工作流

DeepSeek与即梦以及剪映的结合, 提供了一个高效、 自动化的AI视频创作流程。首先,用户通过DeepSeek输入简洁的文字描述 ,系 统会自动生成精准的图片提示词。这些提示词被直接应用于即梦 ,帮助用户快速生成响应的图像——无论是视觉效果、风格、人物 还是场景。

接下来, 即梦根据这些提示词生成首尾针图片,并能够自动输出一个连贯的图像序列,构建起视频的基础。 最终, 这些图片序列可 以导入到剪映平台进行剪辑和后期处理。 剪映为用户提供了多种编辑功能, 如添加转场、 特效、音乐等, 帮助快速完善AI视频内容。 这种流程让用户无缝地将创意转化为专业级的AI视频,简化了图像生成、 视频制作与剪辑的各个环节,大大提升了视频创作的效率。 无论是短视频制作、 广告创作还是社交媒体内容,用户都能轻松实现从概念到成品的快速转换。

DeepSeek+ HBuilder高效编写前端效果

HBuilder是一款集成开发环境( IDE), 主要用于前端开发,支持Web、移动端、以及桌面应用的开发。 它提供了丰富的功能, 包括 代码自动补全、智能提示、预览调试、多种插件支持等,

通过DeepSeek和HBuilder的结合,用户可以高效编写js效果并生成相应的HTML页面 ,进而在HBuilder中展示。

DeepSeek+Cline 实现对话式代码开发

Cline是一款基于人工智能的自动化文档生成工具,支持多种文档类型的生成, 包括技术文档、商业报告、项目提案等,用户只需提 供基本的需求或数据, Cline便能够自动生成结构清晰、内容精炼的文档草稿,并且支持自动修改和优化, 提高文档创作的效率和质 量。

通过与DeepSeek的对接,用户可以在开发过程中通过自然语言与AI进行实时对话。用户只需描述他们的编码需求, DeepSeek会生成

相应的代码提示或解决方案 , Cline则在VSCode中自动插入并展示这些代码。 这一对话式的开发方式减少了繁琐的查找和编写过程。

4.3: DeepSeek工具推荐篇

将 DeepSeek API 集成到流行软件中,涵盖了编程开发、文本分析、翻译、内容创作等类别

DeepSeek 应用程序

DeepSeek Solana 框架

DeepSeek Solana 框架

DeepSeek AI Agent 框架

DeepSeek RAG 框架

DeepSeek RAG 框架

DeepSeek FHE (全同态加密) frameworks

DeepSeek 浏览器插件

DeepSeek 即时通讯插件

DeepSeek 即时通讯插件

DeepSeek VS Code 插件

DeepSeek AI Code编辑器

目前最受欢迎的10个企业AI应用场景

代码助手遥遥领先,以51%的采用率成为开发者最早拥抱AI的领域。 GitHub Copilot快速实现3亿美 元营收的增长轨迹证明了这一趋势 ,而像Codeium 和Cursor等新兴工具也在迅速崛起。

客服支持型聊天机器人使用率显著 ,美国企业采 用率达到31%。这些应用通过知识库支持,为内 部员工和外部客户提供可靠的全天候服务

企业搜索+检索以及数据提取+转换(分别为28% 和27%的采用率)需求强烈 ,反映了企业释放和 利用散布于各部门数据孤岛中隐藏知识的强烈需 求。 新的解决方案能够连接电子邮件、 即时通讯 工具和文档存储系统,实现跨系统的统一语义搜 索,并提供AI驱动的知识管理。

会议摘要方便易用,在应用场景中排名第五(24%的采用率),通过自动化记录和要点提取 节省时间、提升效率。如果用于电子健康记录 ( EHR )系统 ,就能提升医疗服务水平。

结语

(1 ) 开源模型将推动 AI 应用生态的加速繁荣 ,大幅降低传统企业与创业者接入 AI 的成本与门槛。一方面,对数据安全要求较高 的企业可基于开源框架进行本地部署,从而满足合规与安全需求; 另一方面 ,初创公司、中小企业的灵活性和多样化的业务场景 也将带来大量云端模型服务需求,为云平台提供模型服务打开新的增长空间。同时, 面向特定领域与场景的独立软件供应商( ISV) 以及独立 AI 构建者数量也将迅速增多,从而促进整个 AI 应用生态的多元化与可持续发展。

(2 )AI 技术深入演进,推理模型或将成为主流形态。推理模型能够通过分解复杂问题、模拟人类思维过程来逐步推导答案 ,尤 其适用于多环节、结构复杂的任务,在精准度与成功率方面表现突出。同时,推理模型通常采用链式思维(Chain-of-Thought)的 输出方式,通过多步骤推理进一步增强模型输出的可解释性, 使业务决策更透明、更可信。

(3 )每项业务都需要接入至少一种 AI 模型,每位工作者都需要能跑端侧 AI 的个人电脑,每个公司都需建设能支撑 AI 工作流的 AI 算力平台。无论何种行业或组织,为了提升效率、增强决策能力和推动创新 ,都将引入 AI 技术。具体而言,业务通过接入 AI模型可实现更加智能的运营与服务; 个人工作者将借助具备端侧 AI 能力的个人电脑大幅提升创造力与工作效率;而企业层面的 AI Server(或算力平台)则为团队协同与管理提供强大支撑 ,加速智能创新步伐助力企业保持竞争性。

27万+

27万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?