软边界svm一般形式

前面Hard-Margin svm 的一个缺点就是 会产生过拟合现象。特别是当使用核函数或者对偶的svm的时候,如果要求必须把数据点都区分的话,就会很任意发生过拟合现象。

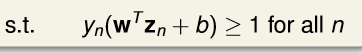

由于有的数据是有噪声的,可能还是离群点,如果一定要求所有的点都必须分对的话,即

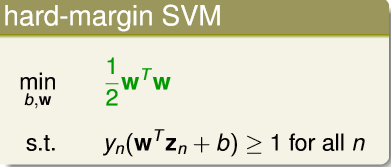

我们原来的Hard-Margin svm表达形式为

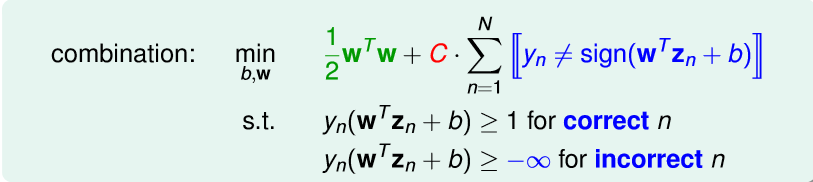

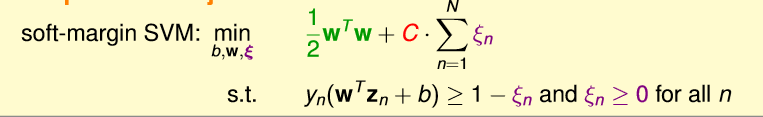

我们借鉴pocket的表达式,就是错一点没什么,但是不要太多。则我们可以转化为

其中C是用来权衡 是要边界大,还是要误差容忍度大。

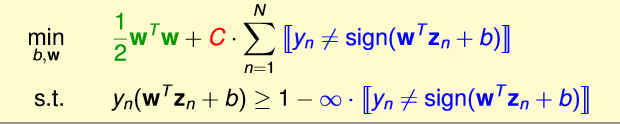

可将上式化简为

可是,对于

这样就很好的处理了问题,原因是

其中

εn

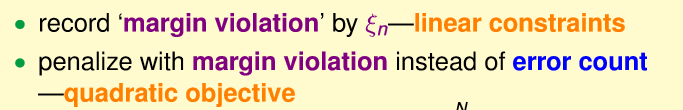

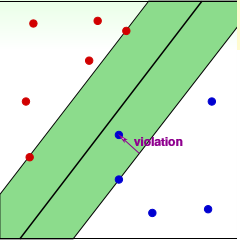

紫色线部分violation

其中C是用来权衡 是要边界大,还是要误差容忍度大。

C越大,误差容忍度就越小,要求的边界越大,就可能会过拟合。

C越小,误差容忍度就越大,要求的边界越小,就可能会欠拟合。

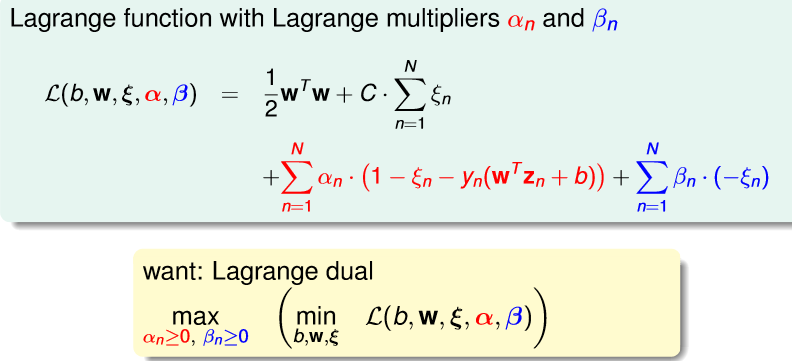

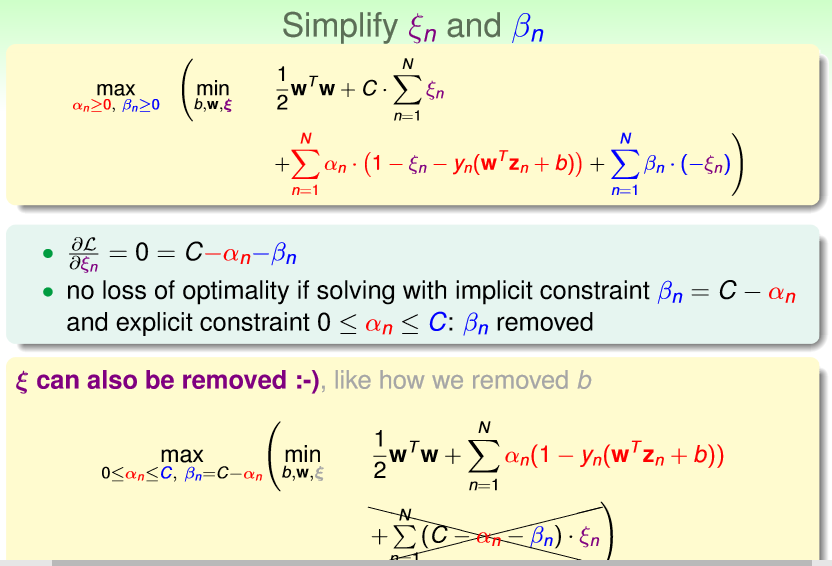

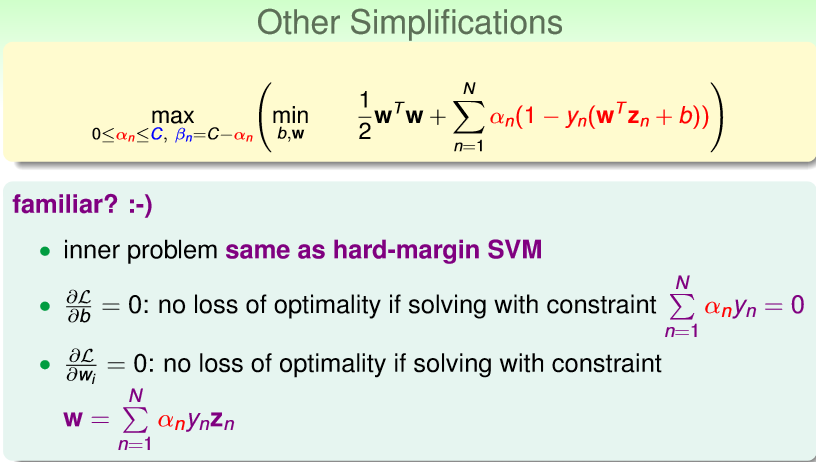

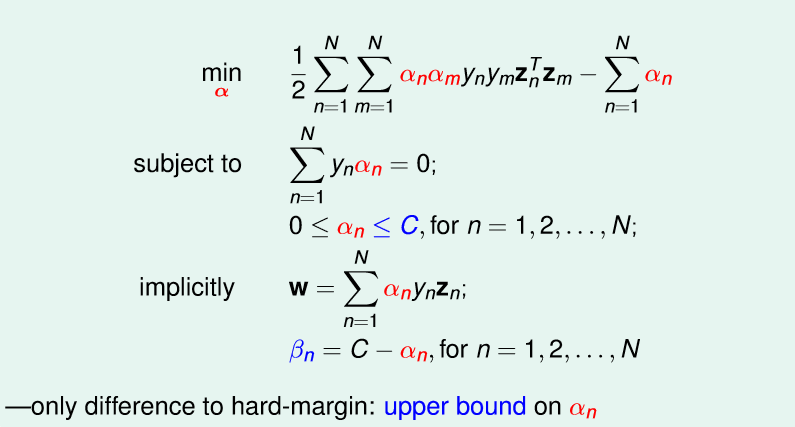

软边界svm的对偶式

我们得到软边界svm的基本形式,现在用之前的步骤将其转化对偶形式。

具体步骤

最终结果为

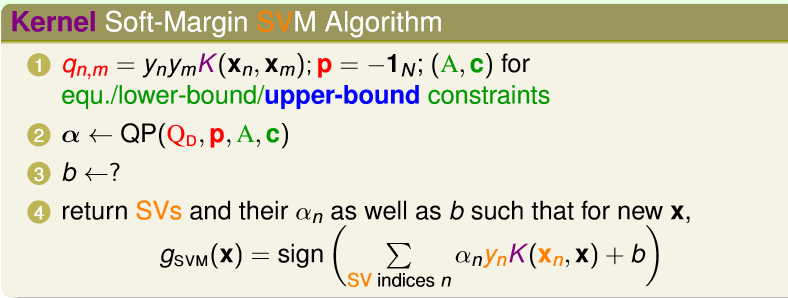

软边界svm的kernel函数

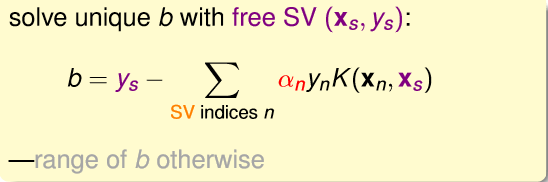

与之前的类似,就是b的求解可能有点问题。

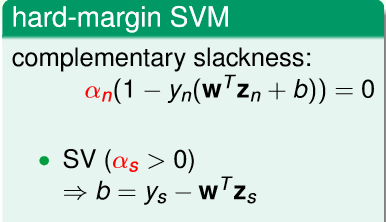

Hard margin svm 的b的求解为

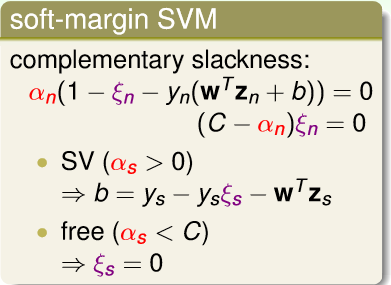

而现在的b的求解为

即不仅仅要求

αn<0

,还要求

αn>=0

即最终有

其实即使这样,依然会导致一定程度的过拟合,所以要小心的调节参数。

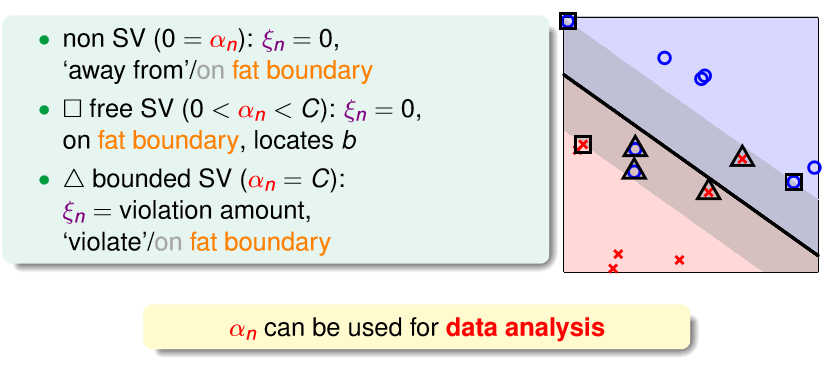

αn

的物理意义

其实

αn

的取值范围,可以反应出其对应点所处的位置。

最后,

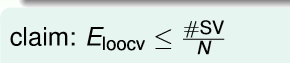

我们通过交叉验证的方法选择参数,要记住

不过他仅仅是上限,不是很精确,只是在运算量很大时,近似估计一下。

748

748

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?