目录

下载IDEA

官网链接:IntelliJ IDEA – The IDE for Professional Development in Java and Kotlin

官网中下载链接:Download IntelliJ IDEA – The IDE for Professional Development in Java and Kotlin

在页面中点击 Download 进行下载,右边图片底下显示版本信息等。

图为下载好的安装包。

卸载旧版本的IDEA

在安装最新的IDEA前,建议先卸载电脑上已安装的旧版本(如果有的话)。

Win11系统:设置 --> 应用 --> 安装的应用 --> 找到对应软件,点右边的三个点 --> 卸载

勾选图中2个选项后,点击 Uninstall 按钮。

中文为:

卸载完成后,点击 Close (关闭)按钮完成卸载。

安装IDEA

双击图中已下载好的安装包。

进入安装程序弹窗,点击 下一步 按钮。

选择安装位置(路径),图里为默认位置,可在 浏览 按钮中,选择你想安装的位置,点击 下一步

勾选创建桌面快捷方式,点击 下一步。

点击 安装。

正在安装。

勾选运行 IntelliJ IDEA,点击 完成 按钮,完成安装。

安装CodeGPT

打开 IntelliJ IDEA,鼠标点击左上角导航栏,File --> Settings

在 Settings 界面中,点击 Plugins,在右侧的 Marketplace 下的搜索框中搜索 CodeGPT。

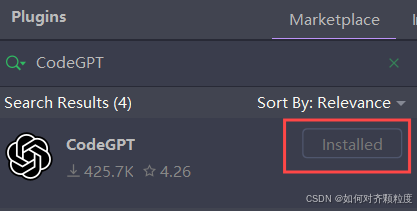

搜到图中的插件,点击 Install 按钮,进行下载安装。

搜到图中的插件,点击 Install 按钮,进行下载安装。

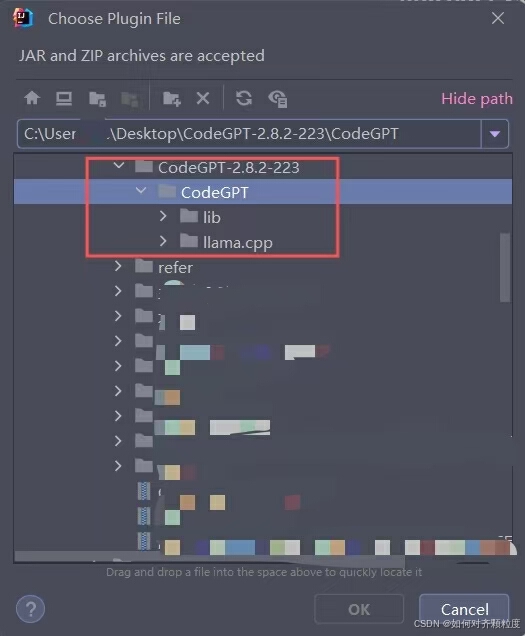

若没有搜索到该 CodeGPT 插件,可以点击旁边的 设置 按钮,选择 Install Plugin from Disk 进行本地安装。

【注】CodeGPT插件的压缩包在我主页的资源中即可下载。

图中显示已完成安装。

安装完成后,重启 IntelliJ IDEA,使插件生效。

进行配置

打开 IntelliJ IDEA,鼠标点击左上角导航栏,File --> Settings

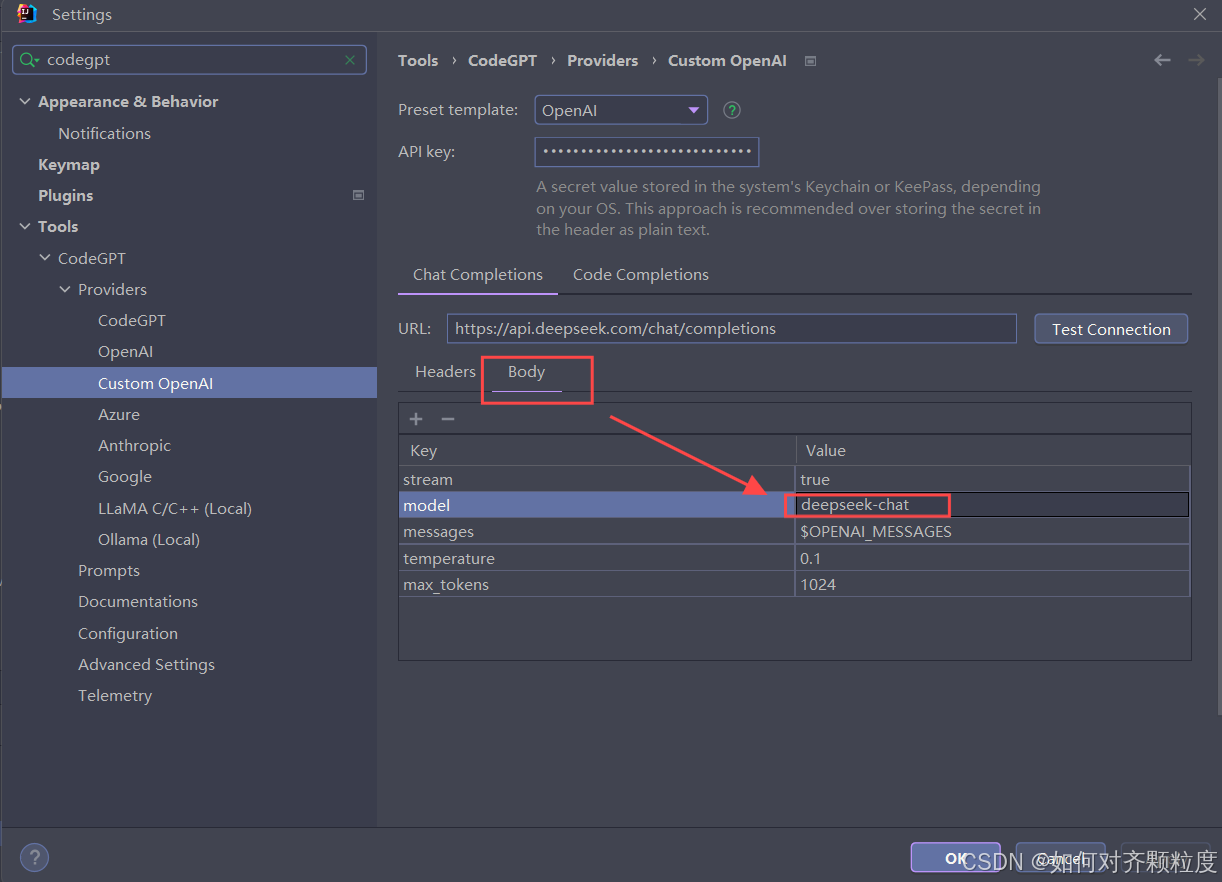

在 Settings 界面中的搜索框中,搜索 CodeGPT,路径 Tools --> CodeGPT --> Providers --> Custom OpenAI 。保留该页面,稍后会回到该页面进行配置。

调用DeepSeek的API

来到DeepSeek官网,链接:https://www.deepseek.com/

点击右上角的 API 开发平台。

选择登录方式。

来到开放平台主界面,新注册的用户会赠送10元的余额,约500万tokens,有效期1个月多。

最新有关价格调整的公告。

查看配置文档。链接:首次调用 API | DeepSeek API Docs

查看配置文档。链接:首次调用 API | DeepSeek API Docs

点击蓝色字体的 API key。即可在跳转的页面中创建 API keys,但请妥善保管自己的 API key,为了保护账号的安全,不要与他人共享,以及泄露等行为。

返回 IDEA 界面。

API key:将创建好的 API key 复制进来。

在 Chat Completions 下。

URL:填写 https://api.deepseek.com/chat/completions

然后点击 Body,修改下面的模型 model 改为:deepseek-chat。

依次点击 Apply 和 ok 按钮。

点击 IDEA 界面最右侧竖状导航栏中的 CodeGPT。即可开始使用。

在 Code Completions 下。

勾选 Enable code completions 和 Parse response as Chat Completions

FIM template:选择 DeepSeek Coder

URL:填写 https://api.deepseek.com/beta/completions

然后点击 Body,修改下面的模型 model 改为:deepseek-reasoner。

点击 IDEA 界面最右侧竖状导航栏中的 CodeGPT。即可开始使用。

点击这里可进行模型的切换,切换成 DeepSeek Coder V2后使用即可。

至此,完成将DeepSeek集成在IDEA中。

Deepseek的简单使用

鼠标选中一段代码后,鼠标右键,鼠标移动到 CodeGPT,右侧即显示可用的相关功能。

Ask Question:在代码编辑器中选中代码或描述问题,点击 Ask Question,deepseek会根据问题给出相关建议和解决方案。

Find Bugs:Deepseek会分析选中的这段代码并分析出代码中的bug。

Write Tests:为选中的代码编写出测试用例。

Explain:对于一些复杂难懂的代码,Deepseek会解读代码的功能逻辑,帮助开发人员理解。

Refactor:重构选中的代码。

Optimize:优化选中的代码。

查看DeepSeek用量统计

登录 DeepSeek 开放平台官网。

链接:https://platform.deepseek.com/sign_in

点击用量信息即可查看。

可以查看到:

每月用量统计以及换算成的消费金额。

deepseek-chat模型的使用量,包括API请求次数、Tokens使用量。

4021

4021

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?