知识星球已更新100+节点,每个节点详解讲解并且给出示例工作流,现阶段门票只需50元,欢迎大家加入很向我提问!!!!!!

知识星球ID:71297236

前言:

ComfyUI的学习是一场持久战,当你掌握ComfyUI的安装和运行之后,会出现琳琅满目的节点,当各种各样的工作流映入眼帘,往往难以接受纷繁复杂的节点种类,本篇文章将以通俗易懂的语言,对ComfyUI的各种核心节点进行系统的梳理和参数的详解,祝愿大家在学习的过程中掌握自我思考的能力,并且切实的掌握和理解各个节点的用法与功能。

目录:

一、Load Checkpoint节点

二、Load Checkpoint with config节点

三、CLIP Set Last Layer节点

四、CLIP Text Encode (Prompt)节点

五、KSampler节点

六、Empty Latent image节点

七、VAE Decode节点

八、Preview image节点

文生图示例工作流

一、Load Checkpoint节点

节点功能:该节点用来加载checkpoint大模型,常用的大模型有sd1.0,sd1.5,sd2.0,sdxl等等。

输入:

扩散模型的路径 **假如配置好了路径文件,模型可自行选择**

输出:

MODEL -> 该模型用于对潜空间图片进行去噪 CLIP -> 该模型用于对Prompt进行编码 VAE -> 该模型用于对潜在空间的图像进行编码和解码

注意:StableDIffusion大模型(checkpoint)内置有CLIP和VAE模型。

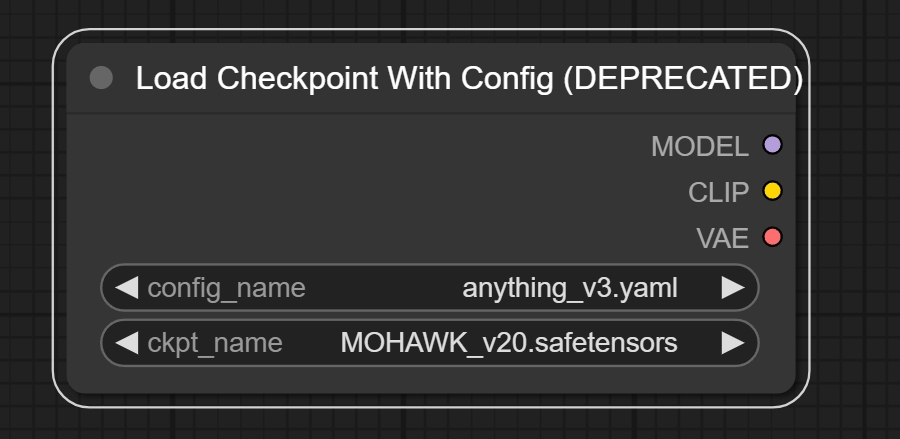

二、Load Checkpoint with config节点

节点功能:该节点用来加载checkpoint大模型,常用的大模型有sd1.0,sd1.5,sd2.0,sdxl等等。

输入:

模型的配置文件,根据配置文件加载模型 **配置文件放在../models/configs文件夹内** 扩散模型的路径 **假如配置好了路径文件,模型可自行选择**

输出:

MODEL -> 该模型用于对潜空间图片进行去噪 CLIP -> 该模型用于对Prompt进行编码 VAE -> 该模型用于对潜在空间的图像进行编码和解码

注意:常规的Load Checkpoint节点,可以自行搜索并加载相应的配置文件。

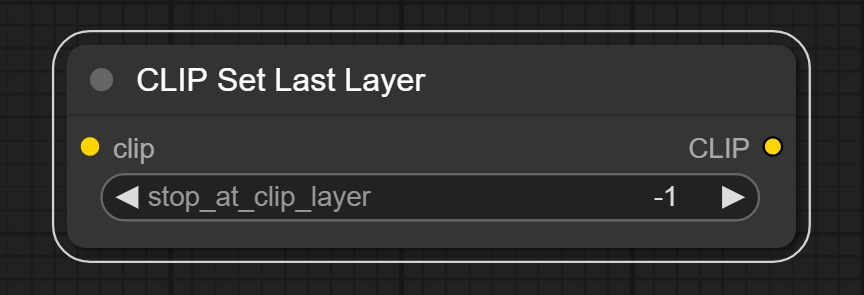

三、CLIP Set Last Layer节点

节点功能:该节点用来设置选择CLIP模型在第几层的输出数据。

输入:

clip -> 接收用于对prompt进行编码的CLIP模型 **比如来自Checkpoint的CLIP模型**

参数:

stop_at_clip_layer -> 设置CLIP模型在第几层进行数据输出

注意:CLIP模型对prompt进行编码的过程中,可以理解为对原始文本进行层层编码,该参数就是选择我们需要的一层编码信息,去引导模型扩散。

输出:

CLIP -> 具有新设置的输出层的CLIP模型。

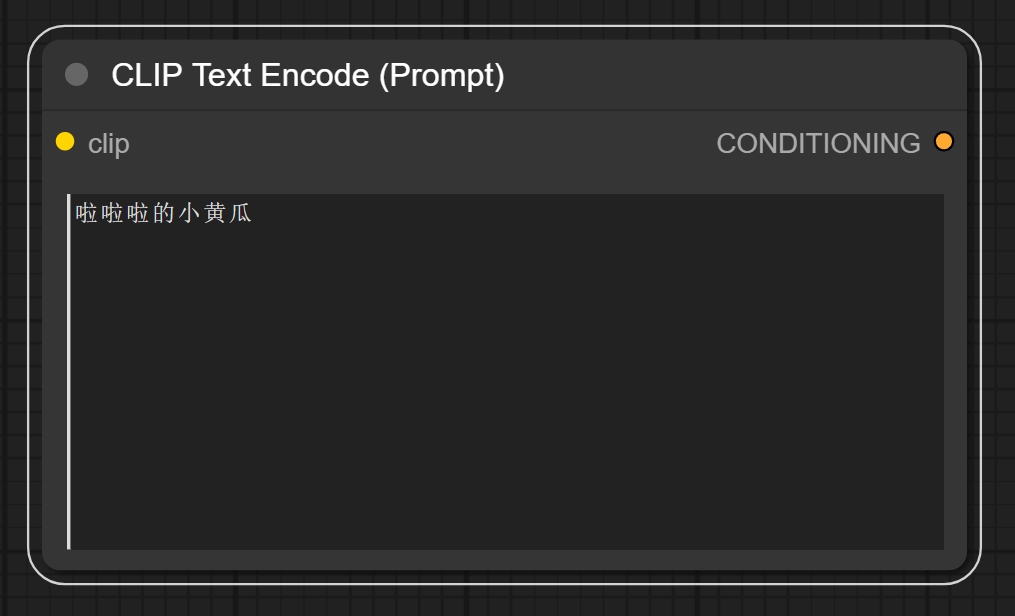

四、CLIP Text Encode (Prompt)节点

节点功能:该节点用来输入正反向提示词,也就是“文生图”,“文生视频”中“文”的输入位置。

输入:

clip -> 接收用于对prompt进行编码的CLIP模型

参数:

文本输入框 -> 输入需要模型生成的文本信息 **正/反向提示词**

输出:

COMDITIONING -> 将文本信息通过CLIP模型编码,形成引导模型扩散的条件信息

注意:当前prompt仅支持英文的输入。

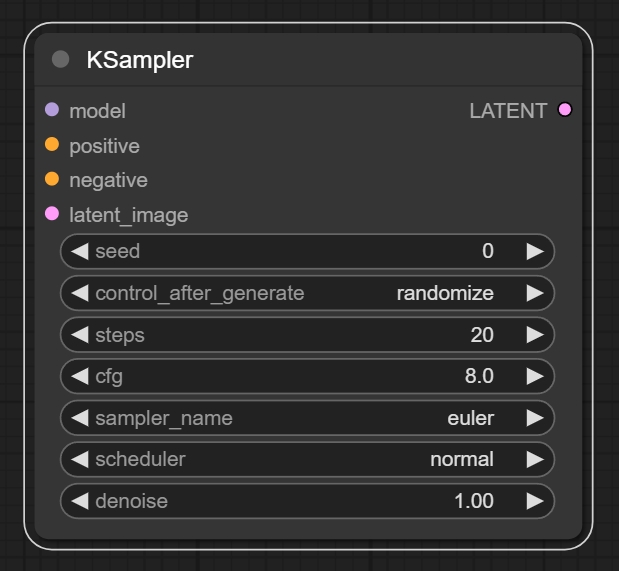

五、KSampler节点

节点功能:该节点用来对潜空间噪声图进行逐步去噪的操作。 **注意去噪的过程是在潜空间进行处理**

输入:

model -> 接收来自大模型的数据流 positive -> 接收经过clip编码后的正向提示词的条件信息 **注意是条件信息,即COMDITIONING** negative -> 接收经过clip编码后的反向提示词的条件信息 **注意是条件信息,即COMDITIONING** latent_image -> 接收潜空间图像信息

参数:

seed -> 该参数表示去噪过程中,噪声生成使用的随机数种子 **种子数有上限** control_after_generate -> 表示产生seed之后的控制方式,fixed代表固定种子,increment代表每次 增加1,decrement代表每次减少1,randomize表示种子随机选择。 steps -> 该参数表示对潜空间图像进行指定步数的去噪。 cfg -> 该参数为提示词引导系数,即提示词对最终结果会产生多大的影响。 **过高会产生负面影响** sampler_name -> 该参数表示您所选择的采样器名称 **采样器种类多且杂,大家可以自行实验验证结果** scheduler -> 该参数表示您所选择调度器的名称 **采样器和调度器的选择可以使用推荐配置** denoise -> 该参数表示去噪幅度/重绘幅度,值越大对图片产生的影响和变化越大 **高清修复一般使用较低的值**

输出:

LATENT -> 经过KSampler采样器进行去噪后的潜空间图像

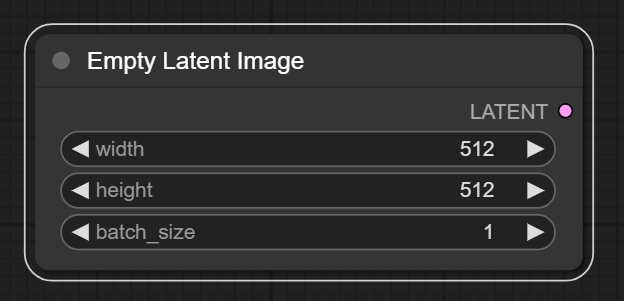

六、Empty Latent image节点

节点功能:该节点用来生成纯噪声的潜空间图像,并且设置图像的比例。

参数:

width -> 要生成潜空间图像的宽度 height -> 要生成潜空间图像的高度 batch_size -> 需要生成多少张潜空间图像

注意:SD1.0,SD1.5等模型最常使用512*512的尺寸。 SDXL,SD turbo等最常使用1024*1024的尺寸。

输出:

LATENT -> 输出指定形状和数量的潜空间图像

七、VAE Decode节点

节点功能:该节点用来将潜空间图像解码到像素级的图像。

输入:

samples -> 接收经过KSampler采样器处理后的潜空间图像 vae -> 接收对潜空间图像解码使用的vae模型 **大部分checkpoint自带vae**

输出:

IMAGE -> 输出经过vae解码后的像素级图像

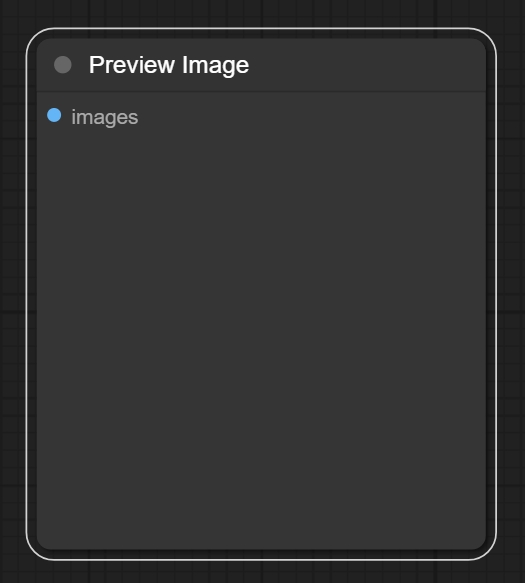

八、Preview image节点

节点功能:该节点用来预览image图像。

输入:

images -> 预览图像

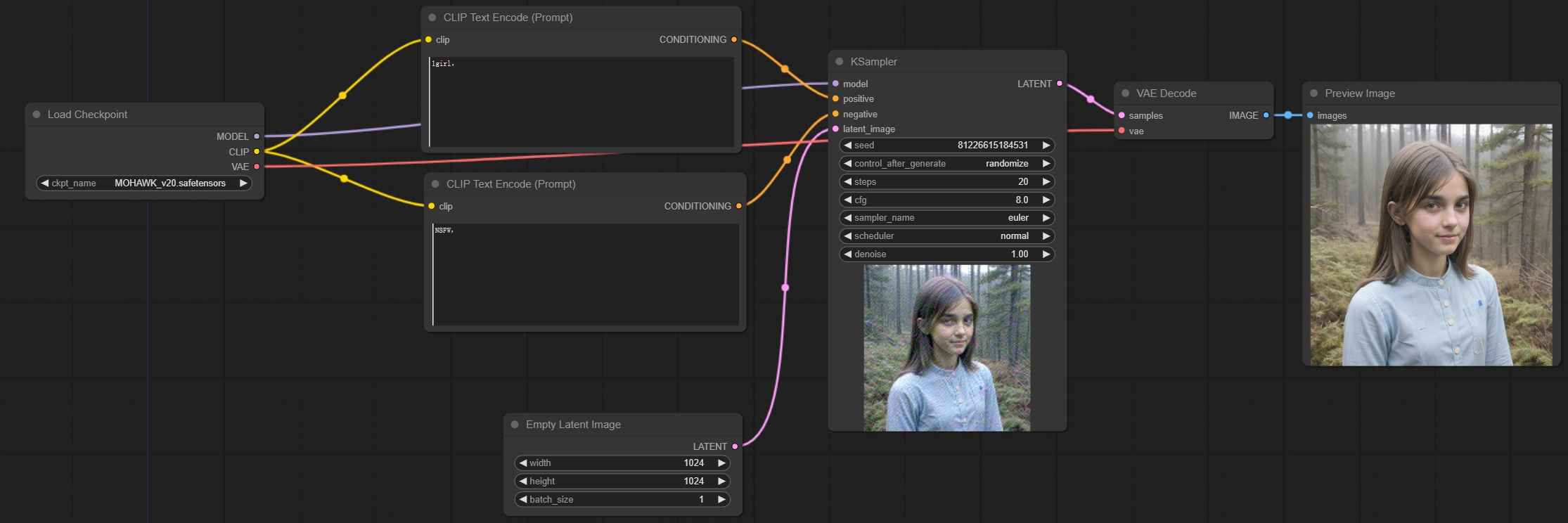

文生图示例工作流:

学习完以上节点,您就可以搭建第一个“文生图”工作流了

这里使用了SDXL的大模型,所以latent图像设置1024*1024,正向提示词输入1girl,反向提示词输入NSFW避免出现不能播的内容,采样器使用默认设置,最终出图如下:

孜孜不倦,方能登峰造极。坚持不懈,乃是成功关键。

本文详细介绍了ComfyUI的8个核心节点,包括Load Checkpoint、Load Checkpoint with config、CLIP Set Last Layer等,提供了节点的功能、输入输出参数说明,帮助用户理解并掌握在文生图工作流中的应用。

本文详细介绍了ComfyUI的8个核心节点,包括Load Checkpoint、Load Checkpoint with config、CLIP Set Last Layer等,提供了节点的功能、输入输出参数说明,帮助用户理解并掌握在文生图工作流中的应用。

3966

3966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?