论文名字:FHDe2Net: Full High Definition Demoireing Network

论文下载地址:https://www.ecva.net/papers/eccv_2020/papers_ECCV/papers/123670715.pdf

论文代码地址:https://github.com/PKU-IMRE/FHDe2Net

论文主要解决的问题:高分辨率图像的去摩尔问题

高分辨率图像去摩尔纹面临以下问题:

- 高分辨率扩展了模式的尺度,以往深度网络感受野过小

- 去摩尔纹容易导致过平滑和伪影,忽略高频子带中周期图案和边缘之间的差异

- 数据集低分辨率,此基础上训练出来的模型面对高分辨率图像的泛化能力有限

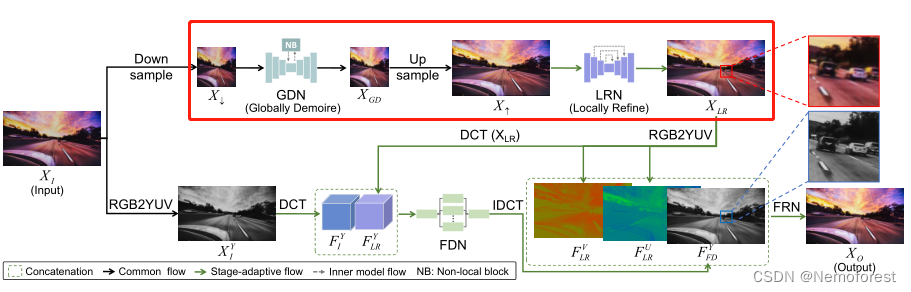

整体框架如上所示:

1.红色框框内为:全局去除模块 级联 局部细化模块,前者旨在加大感受野,去除全局的摩尔纹图案,后者旨在消除摩尔纹的残留。

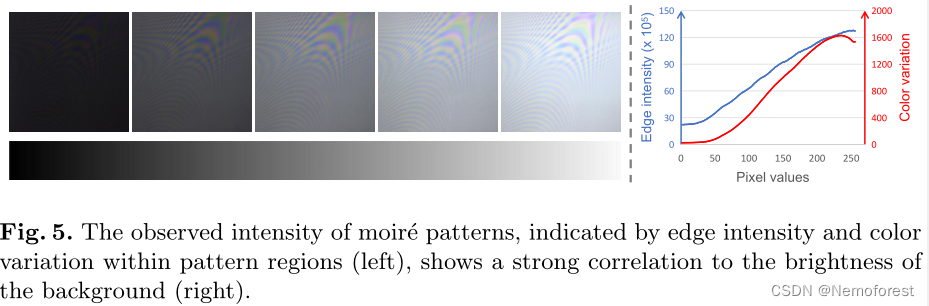

由上述观察可得:摩尔纹图案得边缘强度和颜色变化(蓝、红)与背景亮度(横坐标)有很强的相关性。借助这个性质,在局部细化模块中使用基于掩码的选择算法加快学习以更好的收敛。

解决了问题1,但是下采样会导致信息丢失,细节处发生退化。

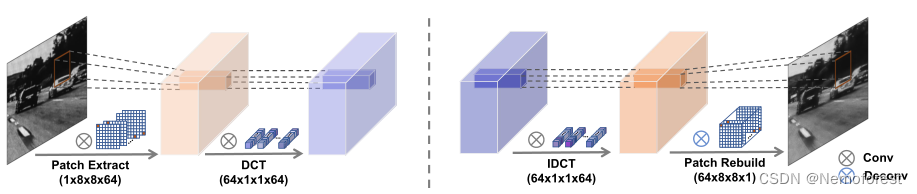

2.解决细节退化问题。需要将原图的高频信息从摩尔纹图案中分离出来,由于局部摩尔纹可以看作是统一方向排列紧密的周期性细线,因此在频域中能较容易地分离。

通过卷积实现DCT,将图片转换到频域,处理完后再转换回时域(实现过程不太理解还需要看代码)。

3.由于数据集其中的数据对是没有对齐的,并且全局到局部去摩尔纹 和 高频细节的提取 直接叠加会导致移位和伪影等问题,因此在最后加入一个融合网络,帮助两个分支的结果相互融合。

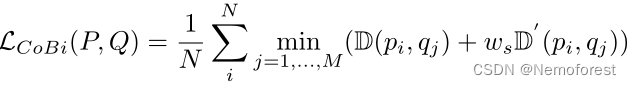

损失函数:

因为数据对有错位,因此作者选择使用双边损失(CoBi)来解决,它匹配两张图像之间的特征以衡量之间的相似性(新思路),具体表达式如下:

其中的D代表cosine距离,D’代表L2距离,P代表输出图像,Q代表GT。

总结

1.设计了一个新的数据集,高分辨率,但数据对不对齐

2.去摩尔纹框架为四部分:全局去摩尔纹 级联 局部去摩尔纹,通过DCT将局部的高频细节和摩尔纹分离保留的模块,融合模块

3.由于数据对未对齐,因此损失函数比较的是两者的相似性

4.以上谨代表个人观点

3361

3361

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?