#-*- coding:utf-8 -*-

import json

from pyspark.sql import SparkSession

#连接集群

spark = SparkSession.builder.master("yarn-client").appName("test").getOrCreate()

#读取数据,数据位置‘hdfs://bd01:8020/a/b/part*.parquet’

df=spark.read.format('parquet').load('hdfs://bd01:8020/a/b/part*.parquet')

print df.show()

#写数据到‘data_result_path’位置,overwrite方式可更改

data.write.mode('overwrite').parquet(data_result_path)

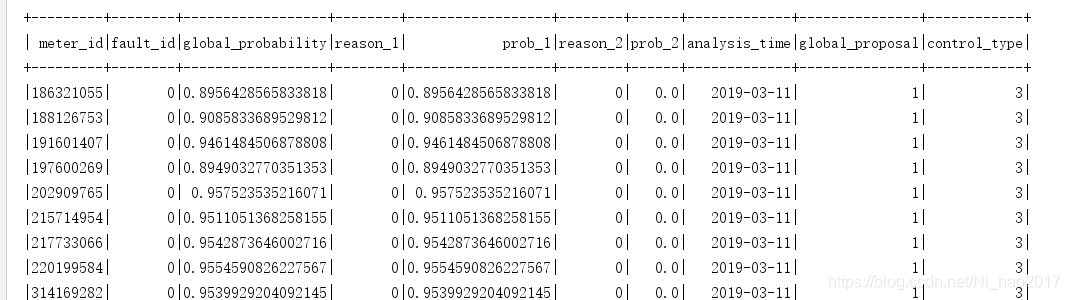

df:

9707

9707

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?