背 景

在现代网络环境中,网络安全面临着日益复杂的挑战,包括新兴的勒索软件、多变的木马病毒以及其他先进的持续威胁。这些威胁不断演变,要求安全解决方案不仅要快速反应,还要能在前所未有的规模上进行精确识别和拦截。

针对日益增多的各类恶意程序的网络攻击,火绒安全建立了多层次主动防御系统来有效应对,在病毒检测方面,基于传统模式匹配和行为分析技术已取得了一定的成效。然而,随着恶意软件技术的快速进步,传统方法面临着速度慢、误报率高和适应新威胁的能力不足的问题。为了应对这些挑战,火绒安全采用了基于深度学习的算法来增强其病毒检测能力以及检测效率。这种方法的优点在于其能够持续学习和适应新出现的恶意行为,大大提高了检测的精确度和速度。

OpenVINO™是英特尔推出的针对深度学习模型进行优化、推理加速以及快速部署的开源工具套件。利用OpenVINO™工具套件,针对病毒检测深度学习模型,火绒安全能够实现

模型的优化与推理加速。OpenVINO™提供了一系列的模型优化工具,可以有效减小模型尺寸并加快推理速度,从而更有效地在用户端实现实时威胁检测。

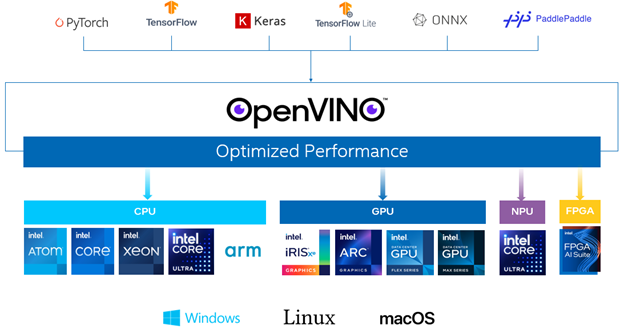

模型跨平台的快速部署,以及推理负载的轻松切换。通过OpenVINO™具有的“一次编写,任意部署”的特点,火绒安全的病毒检测深度学习模型可以很方便地部署在多个硬件设备上,并可以在不同的设备上快速地进行推理负载的切换。通过利用英特尔酷睿Ultra平台中的神经处理单元(NPU),火绒安全可以将计算密集型的病毒扫描任务迁移到这些专用硬件上。这不仅减轻了主CPU的负担,还降低了整体系统的功耗,同时保持了扫描任务的高效率和低延迟。

更快速更省力的软件开发。目前,OpenVINO™已经同时支持英特尔®架构以及ARM架构的CPU作为运行深度学习模型推理的硬件,同时,也支持英特尔的集成显卡、独立显卡、以及NPU、FPGA上的模型部署。由于这种跨平台多架构硬件设备的支持,火绒安全也可以利用OpenVINO™缩短病毒扫描监测软件在跨平台上的开发时间,同时大大减少了开发的工作量。

火绒安全携手OpenVINO™工具套件以及英特尔新一代酷睿Ultra处理器,这种软硬件协同的方法不仅提高了终端安全的效率,也为用户创造了更为安全和高效的计算环境。

OpenVINO™

基于OpenVINO™的病毒扫描监测模型的优化与推理加速

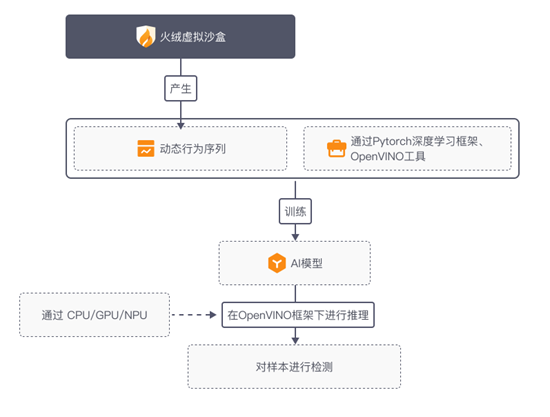

为了应对恶意软件和病毒技术快速进步带来的挑战,火绒安全采用了基于深度学习的算法来增强其病毒检测能力以及检测效率,流程图如下图所示。

利用虚拟沙盒中进行病毒扫描而收集到的动态行为序列组成的数据集,火绒安全基于PyTorch深度学习框架进行模型训练,并获得了可高效高准确度进行病毒检测的AI模型。接着,火绒安全利用OpenVINO™工具套件,实现了模型优化、并将该模型根据不同用户使用的硬件平台进行简单快速的部署。

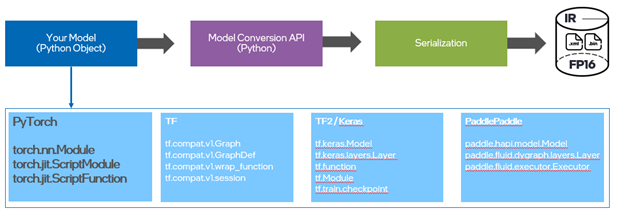

首先,利用OpenVINO™提供的模型优化工具,例如模型转换工具、神经网络压缩框架(NNCF)等,火绒安全可以将训练好的病毒扫描监测模型由原始的PyTorch模型格式转化为OpenVINO 中间表达格式(IR格式),实现对模型的优化压缩。经OpenVINO™模型转换与优化压缩后,相对于PyTorch以及ONNX的模型格式,模型占用体积可以减小50%左右。由此,模型在运行推理时的推理速度也可以提到显著提升,提升幅度达到20%以上。使得火绒安全的病毒检测算法能够实现更快的响应时间和更高效的运行,显著提升病毒的检出速度和准确度。

OpenVINO™

基于OpenVINO™的病毒扫描监测模型快速部署

OpenVINO™的另一个重要特点是其支持跨平台的模型部署能力,无需重写大量代码,可以实现深度学习模型的无缝迁移,达到“一次编写,任意部署”,这对于快速响应新出现的网络威胁尤为重要。特别是针对新一代酷睿Ultra处理器中的NPU(神经处理单元)的支持。这使得火绒安全可以轻松将优化后的深度学习模型部署到各种硬件平台上,包括但不限于英特尔和ARM架构的CPU以及英特尔的GPU。自OpenVINO™ 2024.0的版本开始,深度学习模型可以很方便的部署在英特尔酷睿Ultra平台中的NPU上。由于NPU具有低功耗的特点,火绒安全的深度学习模型可以在NPU上持续进行病毒的扫描和监测、且保持较低的耗电量,为搭载了酷睿Ultra的用户设备提供较高的能效利用率。同时,将深度学习模型推理迁移到NPU上,也很好地释放了CPU上的工作负载,使得CPU的占用率在病毒持续扫描监测时仍然保持较低的水平,从而使得用户对病毒扫描无感、对其它的工作负载不会造成影响。

OpenVINO™

异构架构支持,开发省时省力

OpenVINO支持包括英特尔X86和ARM在内的多种CPU架构,这为开发人员提供了极大的灵活性和便利。异构架构的支持意味着开发者可以编写一次代码,然后将其部署到多种硬件平台上,无论是在个人电脑、服务器还是移动设备上。这种能力不仅简化了开发流程,也使得火绒安全可以轻松适应各种硬件环境,保证软件的广泛兼容性和高效性。此外,这种支持也使得火绒安全能够更好地利用不同设备的特定硬件加速功能,进一步提高其产品的性能和效率。

展望未来,火绒安全计划继续深化与英特尔的技术合作,通过不断的技术研发和创新,旨在为用户提供更为高效、智能的安全解决方案。随着AI技术的不断进步和应用的深化,火绒安全与包括OpenVINO™工具套件、酷睿Ultra处理器在内的英特尔软硬件技术的合作不仅提升了病毒扫描的效率,还为终端用户提供了一个更加安全、快速且能效优越的解决方案。

--END--

点击下方图片,让我们一起成为“Issues 猎手”,共创百万用户开源生态!你也许想了解(点击蓝字查看)⬇️➡️ OpenVINO™ 助力 Qwen 2 —— 开启大语言模型新时代➡️ 揭秘XPU架构下AIGC的推理加速艺术--AI PC 新纪元:将 AI 引入 NPU,实现快速低功耗推理➡️ 隆重介绍 OpenVINO™ 2024.0: 为开发者提供更强性能和扩展支持➡️ 隆重推出 OpenVINO 2023.3 ™ 最新长期支持版本➡️ OpenVINO™ 2023.2 发布:让生成式 AI 在实际场景中更易用➡️ 开发者实战 | 介绍OpenVINO™ 2023.1:在边缘端赋能生成式AI➡️ 5周年更新 | OpenVINO™ 2023.0,让AI部署和加速更容易➡️ OpenVINO™5周年重头戏!2023.0版本持续升级AI部署和加速性能➡️ 开发者实战系列资源包来啦!扫描下方二维码立即体验

OpenVINO™ 工具套件 2024.1点击 阅读原文 获取工具套件,评论区已开放,欢迎大家留言评论!

文章这么精彩,你有没有“在看”?

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?