激活函数的公式根据不同的函数类型而有所不同。以下是一些常见的激活函数及其数学公式:

- Sigmoid函数:

- 公式:f(x)=

- 特性:输出范围在0到1之间,常用于二分类问题,将输出转换为概率值。但存在梯度消失问题,尤其在输入值较大或较小时。

- 公式:f(x)=

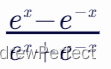

- Tanh函数(双曲正切函数):

- 公式:f(x)=

- 特性:输出范围在-1到1之间,具有更广的取值范围,且均值为0,可以中心化输入信号。但也存在梯度消失问题。

- 公式:f(x)=

- ReLU(Rectified Linear Unit)函数:

- 公式:f(x)=max(0,x)

- 特性:当x<0时,输出为0;当x>0时,输出为x。ReLU函数计算简单,速度快,且解决了梯度消失问题(在x>0的区域)。但存在“死区”问题,即当x<0时,梯度为0。这时候输入的梯度贡献为0,这意味着在反向传播过程中,该神经元不会对其输入层产生梯度信号。

- 在0点的梯度怎么处理?(在0处是不可导的)大多数深度学习框架(如TensorFlow、PyTorch等)默认选择右侧导数(即1)作为ReLU在x=0时的梯度。

- Leaky ReLU函数:

- 公式:f(x)=max(αx,x)(其中α是一个很小的正数,如0.1)

- 特性:Leaky ReLU函数试图解决ReLU的“死区”问题,当x<0时,输出为αx而不是0。

- Softmax函数:

- 公式:softmax(xi)=

(其中xi是输入向量中的第i个元素,N是输入向量的维度)

(其中xi是输入向量中的第i个元素,N是输入向量的维度) - 特性:Softmax函数是多分类任务中常用的激活函数,它将每个类别的输出转换为概率分布。

- 公式:softmax(xi)=

以上这些激活函数在神经网络中起着至关重要的作用,它们通过添加非线性因素,使得神经网络能够学习和拟合复杂的真实世界系统。

3108

3108

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?