一、介绍

Qwen2 是由阿里云通义千问团队研发的新一代大型语言模型系列,它在多个方面实现了技术的飞跃和性能的显著提升。以下是对 Qwen2 的详细介绍:

(1)模型概述

- 名称 :Qwen2

- 研发团队 :阿里云通义千问团队

- 类型 :大型语言模型

- 特点 :多版本、多规模,满足不同计算需求;全面支持 PAI 平台;整体性能代际飞跃

(2)模型版本与规模

Qwen2 系列提供了多个不同规模的模型,以满足不同场景和计算资源的需求。具体包括:

- Qwen2-0.5B

- Qwen2-1.5B

- Qwen2-7B:Qwen2-7B-Instruct · 模型库 (modelscope.cn)

- Qwen2-57B-A14B(混合专家模型,MoE)

- Qwen2-72B

这些模型在参数数量上从数亿到数百亿不等,为用户提供了丰富的选择。

(3)技术特点与优势

- 性能提升 :相比前代模型 Qwen1.5,Qwen2 在代码、数学、推理、指令遵循、多语言理解等多个方面实现了性能的显著提升。

- 多语言支持 :在原有的中文和英文基础上,Qwen2 新增了 27 种语言的高质量数据,使得模型在多语言处理上更加出色。

- 超长上下文处理 :特别是 Qwen2-72B-Instruct 模型,支持处理长达 128K tokens 的上下文,这在大型文档理解和复杂对话处理中尤为重要。

- GQA 机制 :所有尺寸的 Qwen2 模型都使用了 GQA(分组查询注意力)机制,以降低计算复杂度、提高计算效率,并带来推理加速和显存占用降低的优势。

- 技术架构 :Qwen2 采用了 Transformer 架构,并引入了 SwiGLU 激活函数、QKV bias、Mixture of SWA and Full Attention 等技术改进点,以提升模型的性能。

(4)应用场景

Qwen2 系列模型可以广泛应用于自然语言处理的多个领域,包括但不限于:

- 文本生成:如文章创作、摘要生成等。

- 问答系统:回答用户提出的各种问题。

- 对话系统:构建智能聊天机器人,与用户进行自然流畅的对话。

- 代码理解与编写:辅助程序员编写代码、理解代码逻辑等。

- 数学推理与问题解决:在数学、物理等领域提供解题思路和答案。

二、容器构建

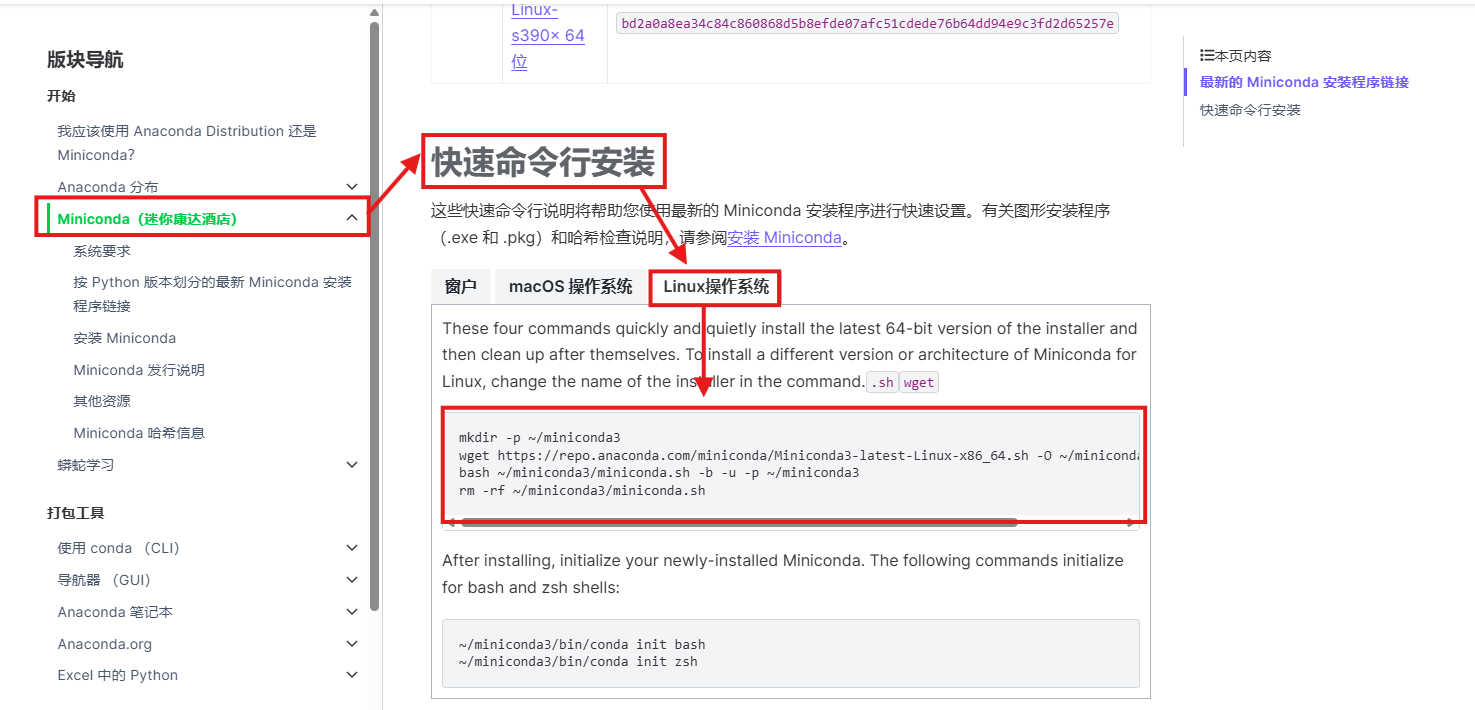

(1)安装 miniconda

进入 Anaconda 官网:

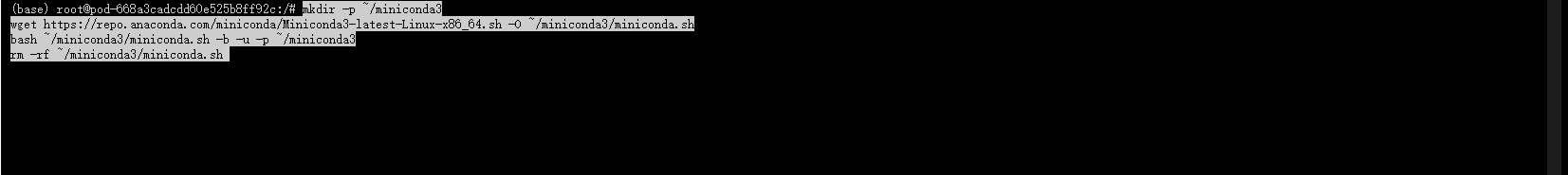

找到快速命令行安装,选择 Linux 系统,复制代码进入终端中进行安装。

等待安装完成。

(2) 安装并更新基础命令,供后续使用更快捷: lsof、git、git-lfs

apt-get update

apt-get install -y lsof

apt-get install -y git

apt-get install -y git-lfs

(3)项目配置

网页交互可以使用 Text-Generation-WebUI,具体参考 WebUI 部署文档,将用于配置本项目Qwen2-7B-Instruct

最简单的运行 TGW(Text Generation WebUI)的方法是使用 repo 中提供的 Shell 脚本。

1. 首先,克隆 repo 并进去文件夹中:

git-lfs clone https://github.com/oobabooga/text-generation-webui

cd text-generation-webui

你可以根据你的操作系统直接运行相应的脚本,例如在 Linux 系统上运行start_linux.sh,在 Windows 系统上运行start_windows.bat,在 MacOS 系统上运行start_macos.sh,或者在 Windows 子系统 Linux(WSL)上运行start_wsl.bat。另外,你也可以选择手动在 conda 环境中安装所需的依赖项。这里以 linux系统为例进行实践操作。

2. 创建并激活虚拟环境,安装相应的torch(建议清华镜像源)

为了安装速度更快可以将 pip 进行永久换源

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

conda create -n Qwen2 python=3.11

conda activate Qwen2

pip install torch torchvision torchaudio

接下来,您可以根据您的操作系统执行 pip install -r命令来安装相应的依赖项

pip install -r requirements_apple_silicon.txt

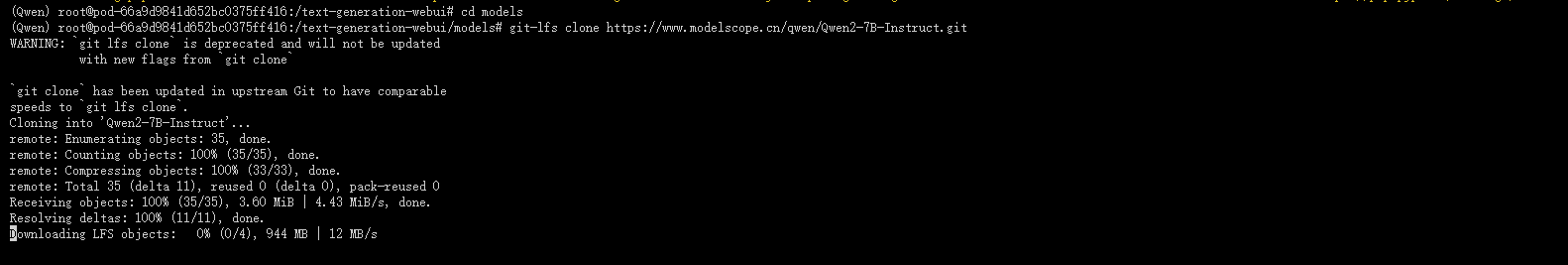

3. 在完成所需包的安装之后,需要准备模型Qwen2-7B-Instruct,将模型文件或目录放在./models文件夹中

cd models

# 大文件clone不下来就手动上传进行覆盖

git-lfs clone https://www.modelscope.cn/qwen/Qwen2-7B-Instruct.git

等待下载完成

您应按照以下方式将 Qwen2-7B-Instruct 的 transformers 模型目录放置到相应位置。

text-generation-webui

├── models

│ ├── Qwen2-7B-Instruct

│ │ ├── config.json

│ │ ├── generation_config.json

│ │ ├── model-00001-of-00004.safetensor

│ │ ├── model-00002-of-00004.safetensor

│ │ ├── model-00003-of-00004.safetensor

│ │ ├── model-00004-of-00004.safetensor

│ │ ├── model.safetensor.index.json

│ │ ├── merges.txt

│ │ ├── tokenizer_config.json

│ │ └── vocab.json

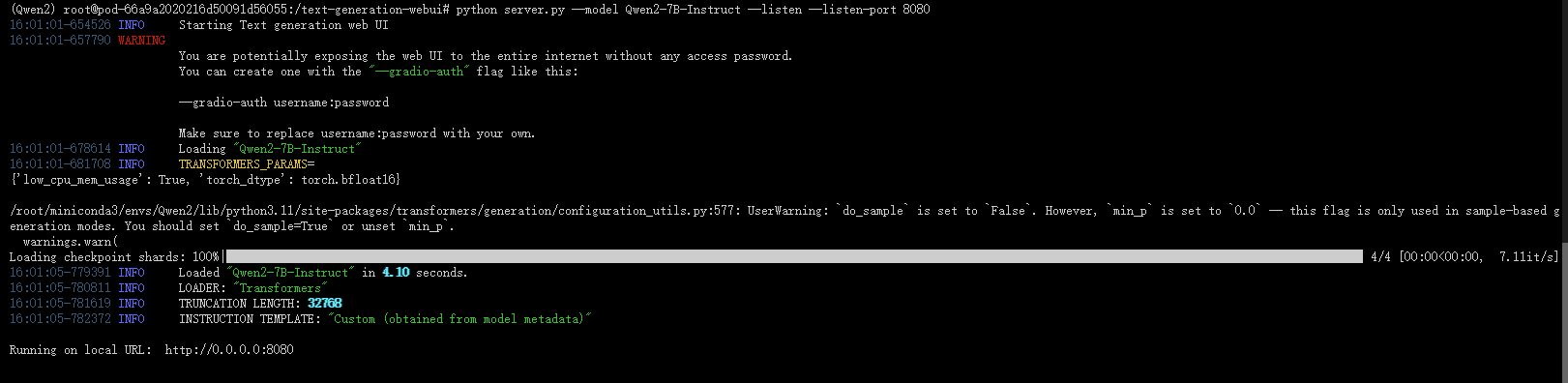

4. 返回text-generation-webui目录,指定端口,运行 server.py 文件

cd /text-generation-webui

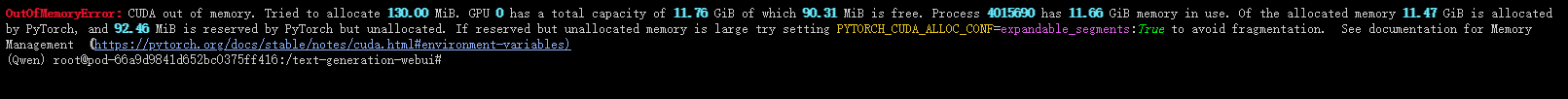

python server.py --model Qwen2-7B-Instruct --listen --listen-port 8080

使用RTX3060+12g显卡出现显存不够情况

使用RTX3090+24g显卡,运行出现以下界面代表成功运行

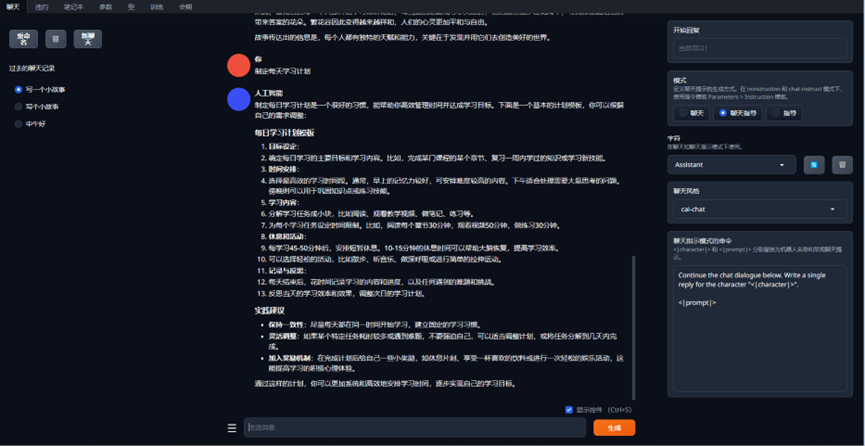

三、网页展示

运行成功后获取访问链接,进入 webUI 界面后即可操作:

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?