如何通过Web查看hadoop的运行状态

一共有几小部分组成,但是前提你得先在集群系统的hosts文件中添加集群IP映射不难,上操作

首先得关闭虚拟机(hadoop集群)的防火墙,以下是代码,直接复制粘贴即可

systemctl stop firewalld //关闭防火墙

systemctl disable firewalld //禁止开机自启动

其次就是IP映射以及查看本机ip地址,我这里使用的是集群1中的ip进行演示

如何配置ip映射?

vi /etc/hosts //进入文件后按i编辑,在最后另起一行写入你需要映射的IP地址

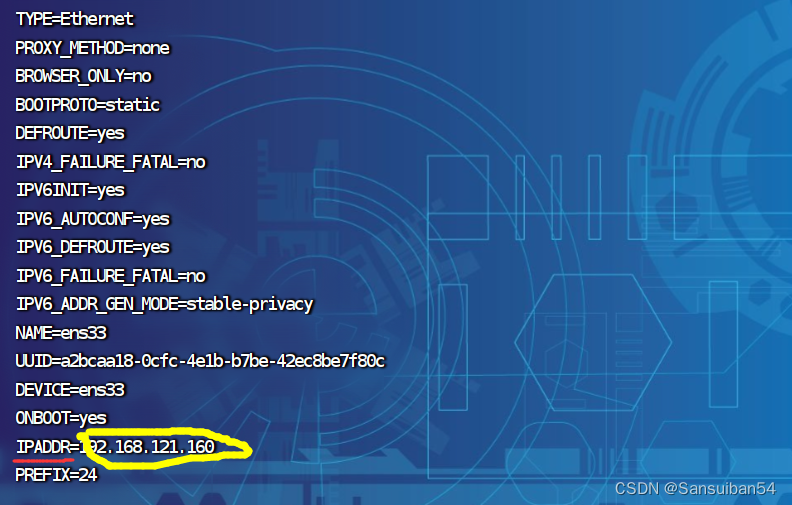

如何在etc/sysconfig/network-scripts/ifcfg-ens33中编辑IP?进入文件后按照如图红色/黄色画线进行添加,最后对所有代码进行检查

vi /etc/sysconfig/network-scripts/ifcfg-ens33

修改后别忘记重启网卡

nmcli c reload //重新加载配置文件

nmcli c up ens33 //重新启动ens33网卡

查看IP地址

ip add //或者 fconfig 也可以

在输入命令后,在下方找到inet,后面的就是你的ip地址

最后一步,也是最重要的一步来啦

在计算机浏览器中输入http://<刚刚查询到自己的IP>:8088/cluster

和http://<自己IP>:50070/dfshealth.html#tab-overview

如果我的:

http://192.168.000.000:8088/cluster

http://192.168.000.000:50070/dfshealth.html#tab-overview

如何进行上传下载测试

如何上传?

首先我们手动设置 Hadoop 环境变量,具体方法如下

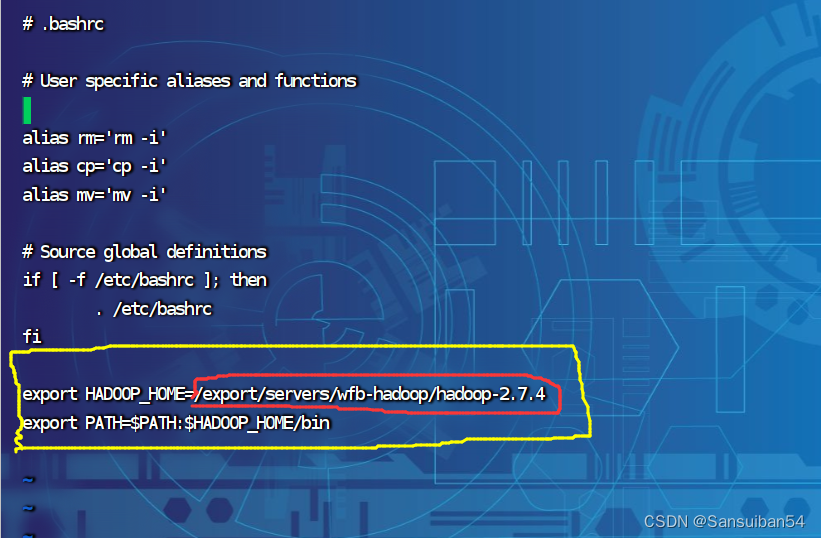

在Hadoop的安装目录下修改环境变量

vi ~/.bashrc

在打开的文件末尾添加

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

其中/usr/local/hadoop是你自己的hadoop安装路径,列如我的是 /export/servers/wfb-hadoop/hadoop-2.7.4,那就替换我自己的路径即可,害怕出错的可以参考一下图片

保存并退出文件。然后执行以下命令使配置生效

source ~/.bashrc

然后尝试使用 hdfs 命令上传文件在hadoop目录下的bin目录里运行

hdfs dfs -put <自己需要上传的文件的地址> /path/to/hdfs/directory/

** 如果在上传过程中出现“ls: `.': No such file or directory”如何处理?**

== 这个错误提示表明目标路径 /path/to/hdfs/directory/ 不存在。你需要确保该路径是正确的,并且在 HDFS 中已经存在。==

==如果该路径不存在,可以使用 hdfs dfs -mkdir 命令创建该路径。例如,以下命令可以在 HDFS 中创建一个名为 /path/to/hdfs/directory 的目录 ==

hdfs dfs -mkdir -p /path/to/hdfs/directory

如何在进行上传即可

如何下载?

要从 HDFS 下载文件,可以使用 hdfs dfs -get 命令。该命令的语法如下

hdfs dfs -get <需要下载文件的目录> <下载到的目录>

可能会出现的问题,实例:“get: `/path/to/hdfs/directory/123/321/556.txt’: No such file or directory”应该如何解决

** 这个错误提示表明 HDFS 中的目标文件路径不存在。可能原因是你指定的路径不正确,或者文件在上传过程中出现了错误。**

**你可以通过运行 hdfs dfs -ls 命令来检查目标路径是否存在,并查看路径下的文件列表。例如,以下命令可以列出 /path/to/hdfs/directory/ 目录下的所有文件 **

hdfs dfs -ls /path/to/hdfs/directory/

/path/to/hdfs/directory/是我个人的文件目录,各位根据自身情况进行更改

over!over!over!关注走起!!!!

5052

5052

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?