1、Pytorch

1.1 Pytorch介绍

pytorch 是一个基于numpy的科学计算包,两大功能:

1,作为numpy的替代者,强大的GPU功能

2,作为深度学习的平台,向用户提供最大的灵活度和速度

基本元素操作:

Tensors张量:张量的概念类似Numpy中的ndarray数据结构,区别在于Tensor可以利用GPU的加速功能

pytorch核心:Tensors Numpy核心:ndarray

导包:

from __future__ import print_function

import torch

#创建一个没有初始化的矩阵

x = torch.empty(5,3)

print(x) #返回脏数据

#创建一个有初始化的矩阵

x = torch.rand(5,3) #rand随机

print(x) #返回均匀分布[0,1]之间的随机数

对比有无初始化的数据:

对于未初始化的矩阵,本身不包含任何确切的值,分配给矩阵的内存中有什么数值就赋值给这个矩阵,本质是毫无意义的数据

#创建一个全零的矩阵,并指定数据元素类型为long

x = torch.zeros(5,3,dtype=torch.long)

print(x)

#直接通过数据创建张量

y = torch.tensor([2.2,3.2])

print(y)

#通过已有的一个张量创建相同尺寸的新张量

x = x.new_ones(5,3,dtype = torch.double)

print(x) #5行3列的1

#利用randn_like方法得到相同尺寸张量,随机初始化方法赋值

y = torch.randn_like(x,dtype=torch.float)

print(y)

#采用.size来得到张量的尺寸

print(x.size())

a,b = x.size() #本质返回的是一个tuple,支持元组的操作

print(a,b)

创建矩阵:

- 未初始化的矩阵:torch.empty()

- 初始化矩阵:torch.randn()

- 全零矩阵:torch.zeros(size,dtype)

- tensor张量:torch.tensor()

- 创建现状相同的张量:tensor.New_ones(size) 与torch.randn_like()

1.2 基本运算操作

#三种加法

print(x+y)

print(torch.add(x,y))

result = torch.empty(5,3)

torch.add(x,y,out=result)

print(result)

y.add_(x)

print(y) #x+y存到y中去

pytorch的基本运算:

加法举例:

- x+y

- torch.add(x,y)

- torch.add(x,y,out)

- y.add_(x)

改变形状:torch.view()

#改变张量的形状

x = torch.randn(4,4)

y = x.view(16)

z = x.view(-1,8) #-1指自动匹配数值

print(x.size(),y.size(),z.size()) #输出:torch.size([16]) torch.size([2,8]) torch.size([4,4])

如果张量中只有一个元素,x.item可以将其取出,多于一个元素时,x.item报错

x = torch.randn(1)

print(x) #输出:tensor([-1.028])

print(x.item) #输出:-1.028

x = torch.randn(2,2)

print(x.item) #报错

print(a.tolist()) #列表形式

print(a[0,0].tolist()) #输出第一行第一列的元素

1.3 torch Tensor 和Numpy array之间转换

torch Tensor 和Numpy array底层的内存空间共享,改变一个另一个也随之改变

a = torch.ones(5)

b = a.numpy() #转换

print(b) #输出:[1,1,1,1,1]

a.add_(1) #所有元素加一

print(a) #输出:[2,2,2,2,2]

print(b) #输出:[2,2,2,2,2]

a = np.ones(5)

b = torch.from_numpy(a) #转换

print(a) #输出:[1,1,1,1,1]

print(b) #输出:[1,1,1,1,1]

np.add(a,1,out=a)

print(a) #输出:[2,2,2,2,2]

print(b) #输出:[2,2,2,2,2]

tensor和array之间的转化:

- tensor ->array : tensor.numpy()

- array ->tensor: torch.from_numpy()

所有在CPU上的Tensors,除了charTensor,都可以转换为Numpy array并可以反向

关于Cuda Tensor :Tensors可以用.to()方法来将其转移到任意设备上

在GPU上,vim demo1.py 进入编辑命令

#服务器上已经安装了GPU 和CUDA

if torch.cuda.is_available():

#定义设备,将设备指定为GPU

device = torch.device('cuda')

#直接在GPU上创建张量y,在CPU上创建张量x

x = torch.randn(1) #在CPU上

y = torch.ones_like(x,device=device)

#将x转移到GPU上

x = x.to(device)

#此时x和y都在GPU上,才可以执行加法运算

z = x+y

#z此时在GPU上

print(z)

#再将z转移到CPU上进行打印

print(z.to('cpu',torch.double))

:wq—保存退出

python demo1.py --执行

设备转移函数:.to()

GPU :‘cuda’ CPU :‘cpu’

首先进行判断是否有可用的GPU,若有可以进行数据迁移。数据必须在同一设备上才能进行运算

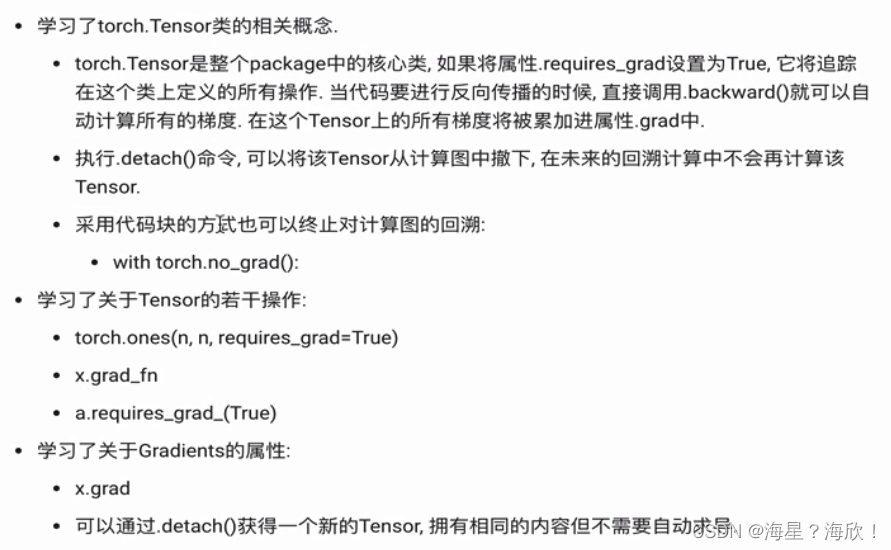

1.4 Pytorch中的autograd

在整个pytorch框架中,所有的神经网络本质上都是一个autograd package(自动求导工具包)

Torch.tensor中属性:

- .requires_grad = True —表示要进行所有操作的追踪

- 要进行反向传播: .backward() 前提: .requires_grad属性设置成True

- 计算之后的梯度存放: .grad() (累加的)

- 要想终止一个tensor的反向传播 .detach()

- 终止整个的反向传播过程, with torch.no_grad() -->预测阶段

- 用户自己定义的tensor张量 grad_fn is None

x1 = torch.ones(3,3)

print(x1)

x = torch.ones(2,2,requires_grad = True)

print(x)

y = x+2

print(y)

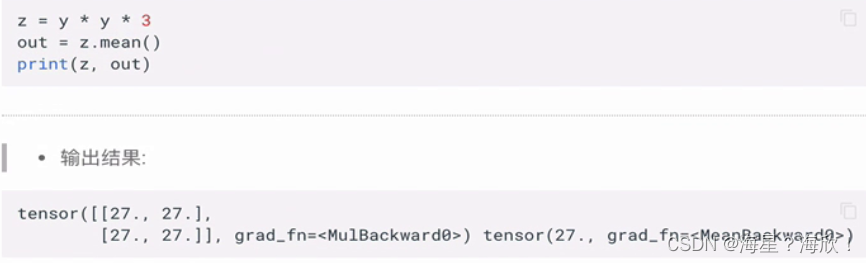

z = x*2

print(x.grad_fn) #输出:None 因为不是运算出来的

print(y.grad_fn) #输出:AddBackward0

print(z.grad_fn) #输出:MulBackward0

.requires_grad_() --可以原地改变Tensor的属性.requires_grad的值

tensor操作:

- 用户自定义的张量:requires_grad = False(默认值)

- 如果想要原地改变 requires_grad_(True)

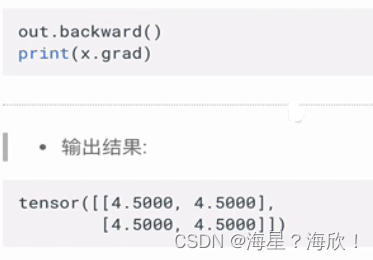

在Pytorch中,反向传播是依靠.backward()实现的

自动求导的属性设置:可以通过设置.requires_grad = True来执行自动求导,也可以通过代码块的限制来停止自动求导

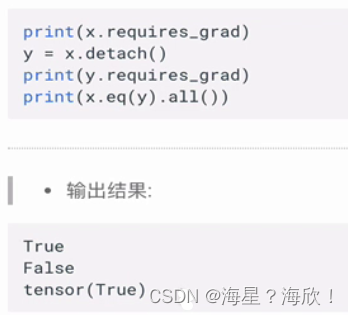

可以通过.detach()获得一个新的Tensor,拥有相同的内容但不需要自动求导

1.5 总结

4746

4746

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?