这篇文章对Mixup增强方法及其应用进行了全面的综述。主要内容包括:

-

引言:介绍了深度神经网络(DNN)在数据增强(DA)中的重要性,特别是当大规模标注数据不可用时。Mixup方法通过线性插值生成虚拟数据,显著提高了模型性能,并易于迁移到各种领域。

-

预备知识:定义了文章中使用的符号和缩写,并详细介绍了Mixup方法的框架模块,包括初始化、样本混合策略、标签混合策略、采样和通道混合策略。

-

Mixup方法在计算机视觉任务中的应用:

-

监督学习(SL):介绍了静态线性、特征基、切割基等多种混合策略,并详细讨论了每种策略的具体方法。

-

自监督学习(SSL):包括对比学习(CL)和掩码图像建模(MIM),介绍了如何利用Mixup生成多样化的样本以提高模型性能。

-

半监督学习(Semi-SL):讨论了如何利用Mixup结合有标签和无标签数据来提高模型性能。

-

计算机视觉下游任务:包括回归、长尾分布、分割和目标检测,介绍了Mixup在这些任务中的应用。

-

-

Mixup在其他应用中的应用:

-

训练范式:包括联邦学习(FL)、对抗攻击与训练、领域适应、知识蒸馏和多模态学习。

-

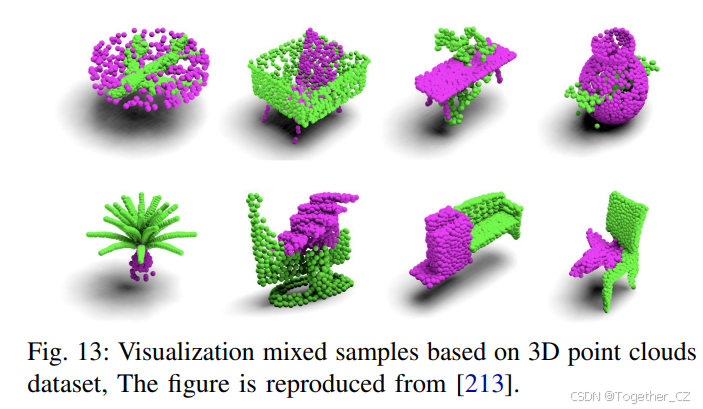

超越视觉的应用:包括自然语言处理(NLP)、图神经网络(GNN)、3D点云、音频等。

-

-

分析与定理:总结了Mixup方法中超参数和策略的影响,以及Mixup对模型正则化、鲁棒性和泛化能力的影响。

-

讨论:指出了Mixup方法面临的挑战和未来的工作方向,包括混合样本生成与选择、混合标签改进、性能与效率的权衡、缓解流形入侵与OOD检测、以及向统一Mixup框架的转移。

-

结论:总结了Mixup方法的技术细节和在各种任务中的应用,并讨论了现有问题和未来研究方向。

文章还提供了详细的参考文献和附录,帮助读者深入理解Mixup方法及其应用。这里是自己的论文阅读记录,感兴趣的话可以参考一下,如果需要阅读原文的话可以看这里,如下所示:

摘要

随着深度神经网络在过去十年中取得了惊人的突破,数据增强作为一种正则化技术,在缺乏大量标注数据的情况下受到了越来越多的关注。在现有的增强方法中,Mixup及其相关数据混合方法因其通过生成数据依赖的虚拟数据并轻松迁移到各种领域而广泛采用,从而实现了高性能。本调查对基础的Mixup方法及其应用进行了全面的回顾。我们首先详细阐述了使用Mixup增强的训练流程,将其作为一个包含模块的统一框架。一个重新制定的框架可以包含各种Mixup方法,并给出直观的操作程序。然后,我们系统地研究了Mixup增强在视觉下游任务、各种数据模态以及Mixup的一些分析和定理中的应用。同时,我们总结了当前Mixup研究的现状和局限性,并指出了进一步实现有效和高效的Mixup增强的工作方向。本调查可以为研究人员提供当前Mixup方法的最新状态,并在Mixup领域提供一些见解和指导作用。与本调查相关的在线项目在这里,如下所示:

引言

深度神经网络(DNNs),如卷积神经网络(CNNs)和Transformer,由于其强大的特征表示能力,已成功应用于各种任务,如图像分类、目标检测和自然语言处理(NLP)等。为了完成越来越具有挑战性的任务,DNNs采用了大量的可学习参数,这意味着如果没有大量的训练数据,模型很容易过拟合,无法泛化。然而,在某些场景中,训练数据是不可用且难以收集的。使DNNs在有限的训练数据之外泛化是深度学习的基本问题之一。

为了解决数据饥饿问题,研究人员提出了数据增强(DA)技术。与“模型中心”和正则化方法相比,DA是一种“数据中心”的正则化技术,通过合成虚拟训练数据来防止过拟合。DA可以通过构建同一样本的不同版本来引入有用的不变特征。DA增加数据集规模和归纳偏置,也能实现一些正则化效果,缓解过拟合问题。最近,数据增强已被证明可以提高深度学习模型的泛化能力,并成为实现最先进性能的关键因素。数据增强可以通过对比组合、混合和生成来合成新数据。

在本调查中,我们关注一个新兴领域——Mixup。Mixup [1] 通过插值两个样本及其独热标签生成增强样本。本质上,基于Mixup的方法通过混合多个样本来生成增强数据。相比之下,大多数现有的增强技术在不改变其唯一标签的情况下修改单个样本。与这些方法不同,Mixup从两个或多个示例生成增强样本,导致多个标签更好地反映现实世界条件。此外,Mixup在不同数据集和领域之间表现出强大的可迁移性。相比之下,替代的组合方法通常需要大量时间来识别合适的增强策略。生成方法难以应用于大型数据集,因为它需要额外的生成器和判别器,阻碍了可迁移性并限制了应用场景。相比之下,Mixup不依赖于标签保留操作,而是使用可学习的方法来创建更有效的增强样本。与处理单个样本的传统数据增强方法不同,Mixup通过组合多个样本生成虚拟训练数据,无需领域知识即可生成大量训练数据。目前,Mixup已成功应用于各种任务和训练范式,包括监督学习(SL)、自监督学习(SSL)、半监督学习(Semi-SL)、NLP、图和语音。在图1中,我们总结了在这些训练范式和数据模态下一些主流方法的时间线:

SL(样本)。2018年,Mixup [1] 提出了一种静态线性插值方式来混合样本。2019年,CutMix [2] 和Manifold Mixup [3] 将Mixup改进为基于切割和特征的方式。这些是特定方法。但从2020年到2023年,许多方法进一步改进了静态线性、基于切割和特征的方式,并转向自适应方式。直到2024年,DiffuseMix [4] 结合了生成模型和Mixup方法。

SL(标签)。2019年,AdaMixup [5] 发现混合比例λ影响模型性能,称为“流形入侵”。因此,从2020年到2024年,许多方法涌现出来,基于CNN或视觉Transformer(ViTs)优化这些比例。此外,2021年的CAMixup [6] 和2023年的RankMixup [7] 等技术被引入以增强模型校准。

SSL(CL)& SSL(MIM)。对比学习(CL)在图像分类任务中显示出强大的能力。为了提高模型性能,研究人员提出了许多带有Mixup的CL方法,这些方法使用Mixup获得的“半正样本”来捕捉更多特征。CL + Mixup通常修改其损失项以适应SSL任务。掩码图像建模(MIM)从混合样本中重建样本,认为混合样本将共享更多特征,可以学习一些高维信息。MixMAE [8] 和MixedAE [9] 在2023年证明了这一点。

半监督学习(Semi-SL)。可以利用标注和未标注信息。2019年,MixMatch [10] 使用这种方式来提高模型性能并变得更加鲁棒,因为混合样本可以用作带有噪声的干净图像。对于PUL,P3Mix [11] 在2021年通过混合接近决策边界的样本获得了更好的准确性。DecoupledMix [12] 在2023年提出解耦其中一个样本的预测以获得更干净的伪标签。

数据模态。不仅为图像设计。对于NLP,WordMixup & SemMixup [13] 在2019年提出了两种混合方式,基于句子或嵌入进行混合。基于这两种基本方式,许多方法被提出并进行了具体修改。例如,SeqMix [14] 在2021年提出了基于其显著性的嵌入混合,TreeMix [15] 提出通过使用成分句法分析将句子分解为子结构,并通过混合重新组合成新句子。对于图,2021年和2022年,GraphMix [16] 和ProGCL [17] 提出了基于Mixup方法的图分类,并提出了一些新的损失项,结合Mixup和图进行困难样本挖掘。GraphMixup [18]、G-Mixup [19] 和iGraphMix [20] 通过显著性信息获得混合图样本,以提高模型的分类能力和鲁棒性。对于语音,BC [21] 和Contrastive-mixup [22] 直接通过线性插值混合语音数据。

总的来说,与已发表的三篇关于Mixup的调查 [23, 24] 和 [25] 相比,我们的贡献包括:

-

我们及时提供了文献综述,并提出了一个全面的框架,以概念化Mixup方法的两种不同改进策略(样本和标签),以SL为例。这两种策略可以对应不同的训练范式和数据模态。

-

我们仔细回顾和讨论了各种类别Mixup方法的技术细节,如静态线性、基于显著性、基于注意力等,以给研究人员提供更好的方法概述,从而进一步理解和洞察。

-

我们报告了Mixup方法在下游任务中的系统调查,提出了技术挑战,并进一步展示了其在视觉任务之外的其他模态和领域的广泛适用性,如音频、语音、图形、生物学等。

-

我们将Mixup方法进一步总结为一个可训练的范式,与其他将其作为DA工具和方法的调查相比。此外,我们呼吁研究人员为Mixup贡献一个统一框架,以解决各种任务,而不是离散的任务特定修改。

预备知识

符号

表1和表A1列出了本调查中使用的符号和缩写。我们将总样本集定义为X∈R^(C×W×H),相应的标签集为Y∈R^k。在计算机视觉(CV)任务中,x∈X^(C×W×H),在NLP任务中,x∈X^(C×L),其中L表示原始句子,在图神经网络(GNN)任务中,v表示一个节点,V表示其邻域的分布。在Mixup方法中,x̂ 和 ŷ 分别表示混合样本和标签,λ表示从Beta或均匀分布中采样的混合比例。此外,我们使用M∈{0,1}表示从某些特定或自适应方法获得的掩码。训练模型表示为f_θ(·),其中θ是可学习参数。f'(·)表示预训练或教师模型,f*_θ(·)表示从f_θ(·)固定的优化模型。在自监督学习或半监督学习中,τ表示用于Sharpen函数或伪标签缩放的温度。

Mixup框架模块

在本小节中,我们将详细说明Mixup方法管道中每个模块的功能,如图2所示。

-

初始化。在进行Mixup之前,一些方法在mini-batch中选择原始样本来过滤适合混合的样本,例如Co-Mix [26] 在mini-batch中选择适合的样本来最大化获得的混合样本的多样性。除了过滤样本外,一些基于显著性的方法利用预训练模型来定位和获取样本的特征图。最后,每种方法从Beta分布中获得混合比例λ。

-

样本混合策略。在监督学习中,我们将策略分为9类,并在图A1中详细说明这些类别。静态线性方法使用λ基于插值线性混合两个或更多样本。基于特征方法使用通过f_θ(·)获得的原始样本特征图,并在插值线性中混合它们。基于切割方法以各种方式使用切割、调整大小或堆叠来混合样本,混合比例λ来自掩码区域。K样本混合方法使用超过2个样本进行混合。随机策略方法结合了许多不同的增强方法和一些手工制作的Mixup方法,策略由每种方法的权重因子选择。基于风格方法通过额外的风格提取器从其风格和内容混合样本。基于显著性方法使用样本特征图来定位其显著性信息,并获得最大特征混合样本。基于注意力方法与基于显著性方法类似,利用注意力分数而不是显著性图。生成样本使用一些生成模型,如基于GAN的模型 [27] 和基于扩散的模型 [28] 生成混合样本。

-

标签混合策略。我们在SL中分为8类,并在图A1中详细说明。优化校准方法使用ECE指标对混合样本进行排序,并选择它们以提高分类性能和模型校准。基于区域方法使用掩码区域重新定义混合比例λ。损失对象方法重新定义了新的Mixup分类损失或提出了新的损失作为正则化方法。随机策略方法将其他增强方法与Mixup方法结合,或提出了新的训练策略用于Mixup。优化混合比例方法使用可学习参数作为λ,通过不同的混合样本来获得可靠的混合比例。生成标签方法通过混合样本来生成混合标签,而不是使用独热标签。注意力分数方法使用原始样本的注意力图来获得比例,或使用混合样本的注意力图通过每个样本的分数来计算混合比例。显著性标记方法使用每个原始样本的显著性图,并将其分为标记,通过标记计算混合比例。

-

采样。一些方法仅关注样本策略以提高模型性能和能力。它们采用了其他策略来固定比例λ或标签,一些方法计算掩码上的所有像素并固定λ,而其他方法为混合样本设置权重因子。

-

通道混合策略。与样本或标签不同,通道具有大量的高级特征。Manifold Mixup [3] 通过插值线性获得混合样本,Catch-up Mix [29] 通过选择一些特征图进一步提高滤波器容量。

Mixup方法的主要步骤

如图2顶部所示,Mixup方法遵循以下步骤:(i) 从训练数据集中加载mini-batch原始样本;(ii) 对于一些下游任务,包括选择原始样本和保留可靠样本,一些基于显著性或注意力的方法通过加载预训练模型获得特征区域或标记。然后,定义混合比例λ,从Beta分布或均匀分布中采样。(iii) 初始化后,原始样本通过样本混合策略与其他样本混合。我们在3.1小节中说明了这些策略。(iv) 当获得混合样本x̂ 时,有两种选择:一种是采样,一些方法通过掩码M的总像素更新混合比例,一些方法选择混合样本来保留更多多样性或挑战性样本,一些方法重新定义混合比例。另一种是标签混合策略,我们在3.2小节中说明了这些策略,并进一步挖掘标签ŷ。(v) 最后一步是通道混合策略,混合样本x̂ 通过网络编码并映射到高潜在空间,一些方法相互插值或选择特征图以获得高维特征ẑ。然后,继续对特征向量进行不同任务的编码,根据不同的损失函数优化网络。

用于CV任务的Mixup方法

本节重点介绍用于CV任务的Mixup方法。我们广泛回顾了这些方法,并将其分为四类:(1) 监督学习,(2) 自监督学习,(3) 半监督学习,以及(4) CV中的一些主流下游任务:回归、长尾、分割和目标检测。图3和图6总结了SL任务中的一些Mixup方法。

样本混合策略在SL中的应用

静态线性

静态线性方法使用比例在全球范围内线性插值以获得混合样本。Mixup [1] 是基于Mixup方法的开创性工作,如公式1所示,这种即插即用、数据独立、模型不可知、高效且简单的方法可以立即提高模型性能。同时,BC [21] 也提出了类似的过程来Mixup。与从Beta分布中获得混合比例λ的Mixup不同,BC选择从均匀分布中接收λ。

AdaMixup [5] 和Local Mixup [30] 进一步考虑了“流形入侵”问题。AdaMixup使用可学习的比例来获得可靠的混合样本,Local Mixup通过权重训练损失的混合样本来挖掘混合样本对(x_i, x_j)。每个混合样本的权重取决于(x_i, x_j)对应点之间的距离,用于避免在输入样本中插值太远的样本。

基于特征

基于特征方法将Mixup方法从像素级转移到潜在级。Manifold Mixup [3] 使用比例λ线性混合通过模型编码的输入样本特征:

ẑ = λ * f_θ(x_i) + (1 - λ) * f_θ(x_j)

其中f_θ(·)表示模型编码器,ẑ 表示混合特征。然而,PatchUp [31] 选择使用生成的掩码以两种方式掩码特征:硬PatchUp和软PatchUp。硬PatchUp表示掩码是二进制的,软PatchUp方式表示掩码是λ值的:

{ M_h = 1, 硬PatchUp

{ M_s = λ, 软PatchUp

ẑ = M_h/s ⊙ f_θ(x_i) + (1 - M_h/s) ⊙ f_θ(x_j)

其中M_h/s表示从公式3中获得的掩码,⊙是逐元素乘法。

MoEx [32] 在特征空间中对训练图像进行操作,交换图像之间学习到的特征的时刻,并使用混合常数λ结合Mixup交叉熵(MCE)损失函数。这个过程旨在从时刻中提取额外的训练信号。研究表明,从实例和位置归一化中提取的时刻可以近似捕捉图像的风格和形状信息。

L_MCE = λ * L(z_i^(j), y_i) + (1 - λ) * L(z_i^(j), y_j)

其中z_i^(j)表示注入了x_j时刻的x_i的特征表示。另一种方法中,Catch-up Mix [29] 发现一些CNN训练会产生一些强大的滤波器,模型将倾向于选择它们的特征。丢弃一些较慢学习的滤波器将限制模型的性能。Catch-up Mix提出了一种过滤模块,混合由较差滤波器学习的特征以获得混合特征,从而进一步提高它们的能力。

基于切割

基于切割方法使用一些掩码来混合样本。与Cutout在样本中丢弃一个补丁不同,CutMix [2] 随机生成矩形二进制掩码M,并根据公式6混合样本:

x̂ = M ⊙ x_i + (1 - M) ⊙ x_j

其中M ∈ r_w * r_h / WH,r_w = W√(1 - λ),r_h = H√(1 - λ)。GridMix [35] 和MixedExamples [36] 使用类似于GridMask的网格掩码而不是单个补丁来获得混合样本。SmoothMix [37] 提出了一个平滑掩码,用于混合样本和平滑边界。类似地,StarMix [38] 使用平滑掩码混合样本用于静脉识别任务。SuperGridMix [39] 使用Superpixel分割方法获得掩码。MSDA [40] 使用MixUp和CutMix获得混合样本。ResizeMix [41] 认为无论选择何种切割或研磨方式,由于随机性,源样本的特征可能会丢失。然而,调整大小方式旨在保留源样本的完整信息,同时最大限度地保留混合样本的特征信息:

x̂ = P(T(x_i, λ_τ), x_j), ŷ = λ * y_i + (1 - λ) * y_j

其中T(·)表示调整大小函数,比例率λ_τ从均匀分布λ_τ ∼ U(α, β)中采样,α和β分别表示范围的下限和上限。P(·)表示将得分样本x_i粘贴到目标样本x_j。λ由补丁和目标样本的大小比例定义。

与在像素级混合不同。FMix [42] 认为有效的特征在图像中往往是连续的,因此样本通过傅里叶变换从RGB通道转换到傅里叶空间,采样高&低频信息生成二进制掩码。Pani MixUp [43] 通过GNNs插值混合来构建样本补丁之间的关系。具体来说,首先构建补丁集,然后使用补丁的相似性进一步构建k近邻集,并线性插值相似补丁以获得混合样本。

此外,与使用一些基于掩码的方式不同,一些工作,如StackMix [44]、RICAP [45]、YOCO [46] 直接堆叠样本。一些基于切割的Mixup方法如图5所示。

K样本混合

许多Mixup方法专注于两个样本混合,缺乏对混合超过两个样本对模型性能影响的分析和设计。k-mixup [47] 通过在Wasserstein度量下插值样本,在其他K样本方面扰动k-批次,创建更多混合样本。DCutMix [48] 通过多次应用CutMix获得混合样本。对多混合样本的实验分析表明,多样本混合的Landspace引导模型走向最宽(最平坦)和最深的局部最小值。MixMo [49] 提出了一种多输入、多输出模型(MIMO模型),将MixUp与集成MIMO模型融合,旨在找到最佳混合模块来处理多个子网络。

一些工作如RICAP、Cut-thumbnail [50] 和Mosaic [51] 通过堆叠或切割多样本获得混合样本,以提高模型性能。

随机策略

RandomMix [52] 将MixUp、CutMix、ResizeMix和FMix组合成一个策略集,随机选择其中一个及其权重以获得混合样本。此外,AugRMixAT [53] 添加了额外的策略,如增强方法和对抗攻击,旨在获得更鲁棒的模型。

基于风格

静态方式。AugMix [54] 旨在提高模型鲁棒性和不确定性估计。使用随机性和多种增强方法混合多个样本来获得混合样本,模型使用Jensen-Shannon损失的一致性进行训练:

x̂ = λ * (w_i * A(x_i) + w_j * A(x_j)) + (1 - λ) * x_z

其中w_i和w_j是从Dirichlet分布中随机生成的权重。PixMix [55] 和IPMix [56] 通过将额外的分形数据集与样本混合,混合A(x),并重复几次以获得最终混合样本。这用于解决一些分布外(OOD)场景并提高模型鲁棒性。DJMix [57] 也通过使用输入图像和离散化图像的混合扩展了AugMix,旨在提高CNN的鲁棒性。

动态方式。StyleMix [58] 提出了区分和混合输入图像对的内容和风格特征的概念,以创建更丰富和鲁棒的样本。具体来说,StyleMix使用自适应实例归一化层(AdaIN) [33] 交换图像x_i和x_j的风格(公式9)。为了获得新的混合图像x̂,StyleMix使用内容比例λ_c和风格比例λ_s线性插值特征图(公式10)。

z_i,j = σ(z_j) (z_i - μ(z_i) / σ(z_i)) + μ(z_j)

x̂ = De(ν(z_i) + (1 - λ_c - λ_s + t)z_j + (λ_c - ν)z_i,j + (λ_s - ν)z_j,i)

其中z_i,j具有x_i的内容成分和x_j的风格,De(·)是预训练的风格解码器,ν ∈ [max(0, λ_c + λ_s - 1), min(λ_c, λ_s)]是一个变量。MixStyle [59] 受到AdaIN的启发,有效地结合了风格转移和跨源域的Mixup。与StyleMix [58] 不同,MixStyle不包括附加的图像生成解码器,而是扰动源域训练实例的风格信息以隐式合成新域。具体来说,MixStyle通过公式11计算混合特征统计z_i,j^σ和z_i,j^μ,并利用它们对风格归一化的x进行风格归一化:

z_i,j^σ = λ * σ(x_i) + (1 - λ) * σ(x_j)

z_i,j^μ = λ * μ(x_i) + (1 - λ) * μ(x_j)

MixStyle(x) = z_i,j^σ (x - μ(x) / σ(x)) + z_i,j^μ

其中x = [x_i, x_j]从域i和域j中采样。

AlignMixup [60] 通过使用分配矩阵M_R获得混合特征图,Sinkhorn-Knopp [61] 在相似矩阵e^(-M/τ)上获得M_R。z_j根据M_R对齐到z_i,得到z'_j = M_R(z_j),然后插值z_i和z'_j。MultiMix [62] 通过额外的注意力和λ逐元素乘法矩阵M_a获得增强特征图,并通过公式13获得混合特征图:

ẑ = norm(M_a(A_i, λ)) ⊙ z_i + norm(M_a(A_j, 1 - λ) ⊙ z_j

其中norm(·)表示归一化,A是从z经过GAP(全局平均池化)或z经过CAM(类激活图)[63] 计算后获得的。

基于显著性

基于显著性方法使用额外的特征提取器或通过反向梯度获得的显著性图 [64] 定位特征位置以指导掩码M生成。

额外特征提取器。SaliencyMix [65] 使用特征提取器从源图像的显著性图中选择峰值显著区域,并将源补丁与目标图像混合。Attentive-CutMix [66] 使用预训练的分类模型f_θ^l(·)作为教师模型,旨在生成源样本特征补丁的掩码,首先获得源图像的热图(通常是7×7网格图),然后从该7×7网格中选择前N个补丁作为注意力区域补丁,从源图像中切割。类似地,FocusMix [67] 使用CAM生成混合样本的掩码。AttributeMix [68] 构建了一个K-字典,以获得每个样本的不同特征并混合用于细粒度分类任务。GraSalMix [69] 发现基于网络梯度定位样本中的特征区域比CAM更准确,并使用基于切割的混合进行每个网络阶段的z获得。RecursiveMix [70] 建议保留历史样本进行混合。使用感兴趣区域(RoI) [71] 和ResizeMix进行混合样本与原始样本重新混合。

PuzzleMix [72] 首先将样本输入模型以获得梯度,然后反向梯度以获得样本的显著性图。它根据显著性图将样本分成多个补丁,并生成与补丁数量对应的λ掩码。为了防止由于两个样本特征在同一位置的问题,Kim等人提出了一种优化传输算法,以最大化样本特征的保留。类似地,他们提出了Co-Mix [26]。Co-Mix不是局限于在样本对(x_i, x_j)之间混合,而是通过在mini-batch中找到多个样本进行混合,并将寻找最佳混合方法变成一个优化问题,通过多个混合样本。为了提高混合样本的多样性,引入了一个正则化损失来惩罚生成过于相似的图像,使混合样本更加多样化。GuidedMixup [73] 提出了一种贪婪配对算法,以在mini-batch图像中找到具有显著区域之间大距离的最佳集合,并将标记级别转移到像素级别以最大化显著性。混合比例通过像素进行调整,以获得更多细节和更平滑的混合。SuperMix [74] 使用预训练模型作为教师模型采样和生成一组从Dirichlet分布获得的掩码,并使用牛顿方法优化掩码。LGCOAMix [75] 使用Superpixel方法获得混合样本,并通过特征图重新计算λ。LGCOAMix还使用Superpixel池化和自注意力模块获得局部分类损失和Superpixel对比损失。

端到端方式。使用显著性或梯度信息通常会产生额外的时间开销,AutoMix [76] 使用端到端方法获得在时间开销和网络性能方面最优的混合样本。AutoMix提出了一种轻量级生成器Mixblock,根据公式14自动生成掩码:

x̂ = M_θ(z_i,λ^l, z_j,1-λ^l) ⊙ x_i + (1 - M_θ(z_i,λ^l, z_j,1-λ^l)) ⊙ x_j

其中z_i,λ^l表示在l-th层嵌入的λ特征图。M_θ表示带有可学习参数θ的Mixblock模块。SAMix [77] 进一步改进了Mixblock,并将AutoMix在监督学习任务中扩展到自监督任务。TransformMix [78] 使用教师模型获得样本的CAMs,并通过新的混合模块进行混合。AdAutoMix [79] 使用对抗训练获得更具挑战性的样本,并提高分类模型的能力。它引入了一个新的Mixblock,可以混合N个样本而不是两个。

基于注意力

受Vision Transformer(ViT) [80] 的启发,注意力分数图也可以作为CAM或梯度的度量。TransMix [81] 通过每个样本的区域注意力分数重新计算λ。TokenMixup [82] 和TokenMix [83] 从样本的注意力图中选择前N个高得分标记作为掩码,N = λN。TokenMixup使用ScoreNet在输入步骤选择样本混合。

ScoreMix [84] 和SMMix [85] 使用样本注意力图的最大和最小注意力区域混合样本。这些方法切割目标样本的最大区域并将其粘贴到源样本的最小区域,以保留更多特征信息。

生成样本

AAE [86] 通过使用GANs模型获得混合样本,首先生成类似于Manifold Mixup的混合特征图,然后使用解码器生成混合样本,ẑ = λ * En(x_i) + (1 - λ) * En(x_j),x̂ = De(ẑ)。与GANs类似,AAE使用判别器获得对抗损失和总损失:

L_total = L_rec(||x - x̂||_2) + L_adv(log Dis(ẑ) + (1 - (log Dis(ẑ))))

其中L_rec表示重建损失,L_adv表示对抗损失。类似地,AMR [87]、ACAI [88]、AutoMixup [89] 和VarMixup [90] 都使用生成模型,如AE、VAE [91] 和GAN,在潜在空间中插值特征图,然后通过解码器获得生成的混合样本。受Text-to-Image模型的启发,DiffuseMix [4] 使用基于Stable Diffusion的多语言模型InstructPix2Pix [28],通过定义的提示获得初始增强样本,然后使用YOCO和PixMix方法获得最终混合样本。

标签混合策略在SL中的应用

优化校准

校准是衡量模型置信度与其准确性一致性的指标。模型既不应过于自信也不应过于不自信,因为这可能导致错误的决策。预期校准误差(ECE)是评估模型校准的关键指标。Manifold Mixup发现MixUp显著提高了网络置信度,但也指出过度自信是不可取的。CAMixup [6] 发现简单应用MixUp与交叉熵(CE)增加了模型的ECE,这与当前的一般直觉相反。Wen等人使用标签平滑进行实验,验证这是一个标签问题。CAMixup根据类分类的平均准确率和置信度差异调整混合比例λ。

通常,模型在预测更简单的类时更有信心。对于更难的类,鼓励模型不那么自信。RankMixup [7] 提出了一种基于Mixup的排名损失(MRL):

L_MRL = max(0, max p̂_i^k - max p_i^k + m)

其中p̂_i^k是混合样本x̂_i的类k的预测概率,边际m确定原始和增强样本置信度之间的可接受差异。它鼓励混合样本的置信度低于原始样本,以保持排名关系。期望是较高的置信度值有利于较大的混合样本λ,以便置信度值和混合比例的顺序成比例。SmoothMixup [92] 使用平滑分类器的固有鲁棒性来识别语义非分类样本,并提高分类器的性能。

基于区域

RICAP [45] 使用混合样本中每个样本的区域来计算λ。一些手工方法如CutMix、Smooth、GridMix和StackMix等使用掩码区域计算λ。RecursiveMix同样使用历史区域计算λ_i = ∑M_i以获得混合标签。

损失对象

在描述相关方法之前,重要的是理解Mixup任务中的损失函数:

L_MCE = λL_CE(f_θ(x̂), y_i) + (1 - λ)L_CE(f_θ(x̂), y_j)

在Mixup任务中,由于有2个或更多样本和标签,Softmax将削弱其中一个类的信息。当其中一个λ太高时,它将产生高熵,但置信度可能很低,严重影响单个类的预测。Liu等人提出了DecoupledMix [12],一种适用于Mixup方法的有效损失函数,具有解耦正则化,可以自适应地使用“硬样本”挖掘特征。具体来说,DecoupledMix解耦了Mixup中的两个类,当最终预测为softmax时,去除其概率p在分母中,并使用双热进行正则化:

ϕ(z_(i,j))^a,b = exp(z_a^(i,j)) / (exp(z_b^(i,j)) + ∑c≠b exp(z_c^(i,j)))

L_DM = -y_i,j^T log(ϕ(z(i,j))) y_i,j

其中ϕ(·)是提出的解耦Softmax,(a, b)表示混合样本的类,y_i,j是双热标签编码。

MixupE [93] 分析了主流Mixup方法,发现Mixup隐式正则化了无限多方向导数的所有阶数,这与流行的信念相反,即这可以被二阶正则化取代。因此,MixupE提出了一种改进方法,通过增强Mixup对方向导数的隐式正则化效果。

随机策略

为了解决Mixup收敛缓慢和选择α困难的问题,Yu等人提出了Mixup Without hesitation (mWh) [94] 方法,通过定期关闭Mixup方式加速Mixup。mWh通过实验分析和演示,Mixup在前几个epochs中有效,而在后几个epochs中可能对学习方法有害。因此,MixUp逐渐被基本数据增强方法取代,模型训练逐渐从探索转向利用。RegMixup [95] 同样分析了训练模型时α对Mixup的影响,发现不同的α对模型产生的熵有影响,还发现MCE损失在与独热CE损失结合使用时带来互补效果。

优化混合比例

AdaMixup [5] 认为简单插值获得混合样本与其他类的原始样本相同,导致“流形入侵”。实验发现,模型性能在λ=0.5时最受影响。因此,AdaMixup提出了一种学习λ的方法。引入两个神经网络来生成混合比例λ,并判断混合样本是否导致“流形入侵”。MetaMixup [96] 使用元学习优化Mixup。目标是双优化:模型f_θ(·)和混合比例λ。在这种情况下,Train-State使用学习到的λ用混合样本训练模型。获得的梯度优化模型参数θ,并传递给Meta-State,使用验证集获得梯度以修改混合比例λ。

LUMix [97] LUMix与之前的方法不同,解决Mixup过程中的标签噪声问题。它提出两种方法:从输入中检测显著目标,并从均匀分布中添加随机样本到标签分布以模拟标签不确定性,最终比例为λ = λ_0 * (1 - ν_s - ν_τ) + λ_s * ν_s + λ_τ * ν_τ。λ_0是手动设置的,λ_s根据预测分布计算,λ_τ从Beta(α, α)中采样。

p̂_i = exp(p_i) / ∑_c=1^k exp(p_c), λ_s = p̂_i / (p̂_i + p̂_j)

SUMix [98] 与LUMix类似,假设可以在预测中建模以获得适当的λ。此外,SUMix将度量学习的思想应用于正则化损失函数,通过捕捉样本中的不确定性。

生成标签

简单线性插值样本可能导致“流形入侵”问题,GenLabel [99] 提出重新标记混合样本。首先,使用生成模型为每个类c学习类条件数据分布,表示为p_c(x)。然后,基于从每个类c中提取的混合样本的似然p_c(x̂),通过获得相似性重新生成混合样本,标签为y^gen:

y^gen = ∑_c=1^k p_c(x̂) / ∑_c'=1^k p_c'(x̂) e_c

其中p_c(x̂)表示输入特征x∈X的生成模型估计的密度,条件为类c∈[k],k是总类数。

注意力分数

在使用ViTs进行分类任务时,通常会添加一个类标记,最终预测基于该类标记与其他标记的相关性。然而,这种方式使用的特征有限,因为仅使用最后一个类标记,而在原始图像中生成了许多特征标记。因此,监督效果显著降低。Token Labeling [100] 为ViTs中的所有标记进行分类任务标记。与原始损失函数相比,Token Labeling的损失函数增加了标记的分类损失。

L_total = L_CE(p^cls, y) + w * 1 / N ∑_i=1^N L_CE(token_i, y_i)

其中p^cls表示类标记的预测,token_i表示i-index标记的预测。TokenMix [83] 和TokenMixup [82] 使用原始样本的注意力分数计算类的λ。Mixpro [101] 认为模型在早期阶段的注意力分数不准确,给出错误信息,因此提出了一种渐进因子。Mixpro结合区域和注意力分数计算λ。与MixPro不同,TL-Align [102] 将混合样本输入ViTs时,每层通过M_Q * M_K^T计算注意力图,并将注意力图与标签结合。TL-Align的标签首先通过标记调整大小为矩阵,然后与注意力图和残差相乘,以获得对齐的标签,然后在ViTs的每层中使标签对齐以获得最终混合标签。

显著性标记

SnapMix [103] 使用CAM获得原始样本的特征图,然后与随机生成的掩码混合,基于掩码区域中的特征信息和整个区域比例计算比例λ,导致SnapMix中两个样本的比例之和不为1。Saliency Grafting [104] 通过预训练的CNN提取样本中的显著性图,获得的显著性图经过softmax函数和阈值决策得到初步二进制掩码,阈值从显著性图的均值获得。然后,最终掩码M通过S''_t和相同维度的区域独立随机伯努利矩阵P∼Bern(p_B)的Hadamard积构建:M = P * S''_t。

自监督学习

对比学习

对比学习(CL)已成为SSL中一种突出的训练范式,其目标是将相似的“正”样本映射到表示空间中接近“锚点”的位置,而将不同的“负”样本映射到更远的位置。Mixup方法已被广泛用于CL中,以生成多样或具有挑战性的样本。图7显示了普通CL方法和带有Mixup的CL方法的流程。

损失对象改进。在改进方面,MixCo [105] 认为具有半正样本特征的混合样本有助于学习更好的表示,使用CL与正样本和负样本以及混合样本的目标可以缓解实例判别问题,使模型学习正样本和负样本之间的隐含关系,如公式22所示:

L_MixCo = -∑_i=1^N (λ * log(exp(ẑ_i z_ik / τ) / ∑_n=1^N exp(ẑ_i z_kn / τ)) + (1 - λ) * log(exp(ẑ_i z_ik / τ) / ∑_n=1^N exp(ẑ_i z_kn / τ)))

其中τ表示相似性对数的软化温度,N是混合样本的数量。与MixCo不同,i-Mix [106] 提出在批次大小中插入虚拟标签和混合样本,并在输入级别和标签级别分别插入相应的虚拟标签。将无监督损失函数转换为监督损失(如CE损失),如公式23和公式24所示:

L_SimCLR = -log exp(s(ẑ_i, z_(N+i) mod 2N) / τ) / ∑_k=1,k≠i^2N exp(s(ẑ_i, z_k) / τ)

L_N-pair = -∑_n=1^N w_i,n log exp(s(ẑ_i, z_n) / τ) / ∑_k=1^N exp(s(ẑ_i, z_k) / τ)

其中N是批次大小。类似地,基于标签平滑的原则,MCL [107] 提出了一种CL框架,旨在通过使用Mixup生成新样本来提高临床医学时间序列数据的分类效果。

SAMix [77] 提出了改进的infoNCE,L_+和L_-,用于基于Mixup的SSL。L_+称为局部项,因为将另一类的特征添加到原始infoNCE损失中;L_-称为全局项,是混合的infoNCE,如公式25所示:

L_+ = -λ log p̂_i - (1 - λ) log p̂_j

p̂_i = exp(ẑ z_i / τ) / (exp(ẑ z_i / τ) + exp(ẑ z_j / τ))

由于SimSiam [108] 仅依赖于同一样本的随机增强对,具有大量相同信息,可能会降低图像的判别力,Guo等人提出了MixSiam [109]。它通过输入到编码器并获得通过聚合操作的最大显著性表示来最大化两个增强样本的显著性。另一分支使用混合样本作为输入,并期望模型预测接近判别表示。因此,Guo等人认为模型可以访问更多变量样本,并预测其最显著的特征表示。

困难样本挖掘。在CL中,使用困难样本进行训练可以进一步提高模型性能。MoCHi [110] 通过编码原始样本来获得表示,然后计算并排序与正样本的特征相似性,取N个低相似性的特征进行Manifold Mixup。这个过程产生更具挑战性的负样本。类似地,Co-Tuning [111] 提出了一种对比正则化方法,用于生成样本对以挖掘困难样本对。BSIM [112] 通过测量两个原始样本和混合样本之间的联合相似性(即半正对)改进了分类。Chu等人认为,学习联合相似性有助于在特征在潜在空间中更均匀分布时提高性能。FT [113] 提出了正外推和负插值,以改进MoCo [114]。正外推进行Manifold Mixup,将原始正对转换为增加“记忆库”硬度的变换;负插值使用Mixup生成混合样本,增强负样本的多样性。

在图CL中,如果仅根据锚点与自身的相似性选择最具挑战性的负样本,可能会将正样本分类为困难负样本。ProGCL [17] 表示相似性不能用于评估负样本的难度,并提出了ProGCL-weight以避免将正样本分类为困难负样本。然后提出了ProGCL-mix,以获得更多真正的负样本。与ProGCL仅限于图任务不同,DACL [115] 提出了一种域不可知的CL方法,通过混合样本使用噪声样本来生成具有挑战性的样本对。CL公式使用随机样本x_r满足条件s(z_i, ẑ) > s(z_i, z_r),其中s(·)是两个向量之间的余弦相似性函数。

应用与Mixup和CL。CoMix [116] 和MixSSL [117] 使用类似的想法进行DA,通过在对比自监督学习框架中混合来自不同域的样本来进行视频和医学图像的对比自监督学习,m-Mix [118] 提出混合多个样本并动态分配不同的λ以挖掘困难负样本。Un-Mix [119] 认为DA仅改变样本之间的距离,但在训练期间标签保持不变。然而,Mixup方法将调整样本和标签空间,并且变化程度是可控的,可以进一步从未标记样本和模型中捕捉更多细节特征。

基于一些裁剪和切割方式。PCEA [120] 提出使用来自几种不同增强操作的4个样本进行粘贴,然后裁剪成4个单独的样本,随机选择2个进行CL训练。类似地,Li等人提出了中心局部图像混合(CLIM) [121] 方法,该方法位于CL框架内。在识别聚类中心后,使用CutMix在同一类和同一图像的不同分辨率图像之间混合不同的图像,这些被认为是正样本对。CropMix [122] 通过使用不同的裁剪比例多次裁剪图像,从而确保捕捉多尺度信息并解决单次随机裁剪导致信息丢失的问题。随后,通过混合多个裁剪视图形成新的输入分布,从而增强输入并减少标签不匹配。CL主要编码器不仅基于CNNs,还可以基于ViTs。PatchMix [123] 认为现有的对比框架忽略了实例间的相似性。例如,图像的不同视图可以被用作潜在的正样本。根据ViTs的性质,PatchMix随机组合来自小批次的多幅图像的补丁级别,为ViTs生成一系列混合图像补丁,从而模拟自然图像中观察到的丰富的实例间相似性。同样,为了提高ViTs的性能,SDMP [124] 将这些视为SSL中的额外正对,通过建模混合样本之间的语义关系,共享相同源样本的混合样本。

掩码图像建模

掩码自动编码器(MAE) [125] 使用掩码图像建模(MIM)方法,将标记映射到语义空间使用编码器,同时使用解码器在原始空间中重建像素。MAE方法 [126] 展示了编码器和解码器的强大特征提取和重建能力。i-MAE [127] 旨在研究两个主要问题:(a) 掩码自动编码器中的潜在空间表示是否线性可分?(b) MAE在潜在特征空间中编码的语义程度如何?i-MAE表明,使用两个独立的线性层重建掩码混合样本是可能的。弱点是难以重建语义相似性,并且需要高层次视觉概念知识进行类内分离。同时,实验发现MAE在潜在特征空间中非常强大。

MixMAE [8] 结合了SimMIM [128] 和MAE的优点,提出编码和解码补丁级别的混合样本,使用编码中的有限信息而不是丢弃所有和在解码中非自补丁掩码以防止在解码期间两个特征纠缠。提出了补丁合并模块以合并特征信息。类似地,MixedAE [9] 将数量从两个增加到四个,并提出了多头同质注意力模块,还使用同质对比方法进行编码和解码。同质注意力模块通过强制注意力到最高质量的关键补丁使用top-N来识别相同补丁。同质对比旨在通过监督比较增强相同补丁的特征相似性。图8显示了普通MAE方法和带有Mixup的MAE方法的流程。

半监督学习

在深度学习任务中,找到大量的未标记样本x_u很容易。制作标签非常昂贵。因此,研究人员将大量的未标记样本x_u与有限的标记样本x结合起来进行训练,期望提高模型性能,从而产生了半监督学习(Semi-SL)。半监督学习避免了资源的浪费,同时解决了监督学习中模型泛化能力差和无监督学习中模型不准确的问题。图9显示了Mixup方法在Semi-SL任务中的流程。

半监督学习。MixMatch [10] 能够猜测数据增强的未标记示例的低熵标签,并使用额外的锐化函数减少标签分布p的熵(公式26)。这些“猜测”标签可以用于计算未标记损失L_u,作为与标记损失L组合的损失L的一部分,以形成Semi-SL的损失(公式27)。MixMatch使用Mixup混合标记和未标记数据,这是一种新颖的方法。

Sharpen(p, τ)_i = p_i^(1/τ) / ∑_i=1^L p_i^(1/τ)

L = L + w_u L_u

其中温度τ是一个超参数,τ的减少鼓励模型产生较低熵的预测。ReMixMatch [129] 引入了两种新技术,即“分布对齐”和“增强锚定”,叠加在MixMatch算法之上。分布对齐的目标是确保未标记数据的预测边际分布与地面真实标签的边际分布紧密对齐。增强锚定涉及将多个强增强的输入版本引入模型,旨在鼓励每个输出接近弱增强版本的预测。ICT [130] 通过比较未标记样本的混合样本的预测和原始样本的预测来计算一致性损失。

与之前的方法仅考虑预测和伪标签不同,CowMask [131] 使用教师模型为原始样本生成伪标签,并使用CowMix通过学生模型获得混合样本的预测,以获得一致性损失|p̂_s - p_t|^2。不同的是,CowMask通过执行伪标签和掩码均值(作为λ)的混合来获得最终伪标签。emu [132] 混合标记和未标记样本来获得增强样本,而不是直接将Mixup的标签与λ相关联,而是使用超参数λ_eps调整Mixup的标签。DCPA [133] 通过教师模型预测伪标签,使用混合样本的监督损失,以及使用两个不同解码器捕捉特征变异性的对比损失,通过锐化操作加强一致性约束,弥合不同解码器输出之间的差距,并指导模型的学习方向。MUM [134] 开发了一种新的半监督对象检测方法,解决了传统数据增强方式的局限性,旨在保留边界框的位置信息。MixPL [135] 提出通过MixUp和Mosaic方式组合伪标记数据,以软化未检测到的负面影响,并在不同尺度上平衡模型的学习。

标签噪声学习。与大多数现有的标签噪声学习(LNL)方法不同,DivideMix [136] 丢弃最可能带有噪声的样本的标签,并使用这些噪声样本作为未标记数据来正则化模型,避免过拟合并提高泛化性能。此外,两个网络同时训练,通过共同划分保持两个网络发散,以便可以过滤不同类型的错误,避免自训练中的确认偏差。Manifold DivideMix [137] 进一步改进了DivideMix,通过选择OOD样本和基于分类损失分布选择噪声样本来找到干净/噪声样本,构建标记/未标记数据集。

正和未标记学习。正和未标记学习(PUL)是一种半监督学习的分支,仅使用正类和未标记数据训练二分类器。类似地,一些基于Mixup的方法可以用于提高PUL任务中网络的性能。MixPUL [138] 结合了监督和无监督一致性训练来创建增强样本。为了促进监督一致性,MixPUL进一步通过减轻监督问题,从未标记集中识别可靠的负样本子集来奖励未标记样本之间的一致性。在PUL任务中,决策边界往往偏向正类,导致一些可能的正样本被错误标记为负样本。这个问题导致PUL中的决策边界偏差现象。P3Mix [11] 通过混合未标记样本和接近边界的正样本进行更准确的监督。

四、CV下游任务

在本节中,我们将讨论应用于CV下游任务的mixup方法。我们回顾了这些方法,并将其分为四个类别:(1)回归,(2)长尾分布,(3)分割,以及**(4)目标检测**。图3和图6总结了SL任务中的一些mixup方法。

4.1 回归

回归任务与分类任务不同,它们需要相对准确的预测结果,而不是类别的概率。这意味着直接混合两个随机样本并不能确保混合样本对模型有效,在某些情况下甚至可能有害。MixRL [139] 提出使用验证集来学习每个样本“应该混合多少个最近邻以获得最佳模型性能”。类似于AutoAugment [140],使用强化学习(RL)在验证集上找到最低的模型损失来确定这一点。具体来说,使用RNN模型来确定样本的最佳KNN数量,然后使用MLP来选择所有样本。

C-Mixup [141] 根据标签的相似性调整采样概率,然后选择标签相似的样本对进行混合。简单地实现vanilla MixUp会导致噪声样本和标签。对于已经选择的样本,C-Mixup使用对称高斯核计算另一个样本的采样概率,其中更接近的样本更有可能被采样。此外,使用低维标签相似性进行计算将减少开销。类似地,ADA [142] 使用先验分布来选择样本和标签,UMAP Mixup [143] 使用统一流形近似和投影(UMAP)方法作为正则化器,以鼓励并确保mixup生成的混合样本位于特征和标签数据的流形上。ExtraMix [144] 提出了一种可以外推的mixup技术,扩展了潜在空间和标签分布。与现有的mixup方法相比,ExtraMix最小化了标签不平衡。此外,使用cVAE [145] 在混合中优化伪标签,以应对在材料科学中,具有优异性能的新材料通常位于标签分布的尾部。Warped Mix [146] 提出了一种框架,在插值时考虑相似性而不降低多样性;Warped Mix认为相似性应该影响插值比率λ,而不是选择。高相似性应该导致强λ,低相似性应该导致基本不变。SupReMix [74] 旨在更好地利用输入之间的固有“顺序”关系,以促进创建“更难”的对比对。目标是促进连续性以及局部线性。

4.2 长尾分布

在自然界中,数据往往呈现出长尾分布。在深度学习中,一个优秀的模型应该能够很好地处理长尾分布。由于mixup方法生成的增强样本存在两种不同的特征信息,因此似乎非常适合处理长尾分布问题。Remix [147] 通过为少数类提供更高的权重来促进少数类的标签。在构建混合样本时,允许特征和标签在λ上有所不同,以在多数类和少数类之间提供更好的权衡。UniMix [148] 使用改进的混合λ和一个促进少数类的采样器。固定的λ通过UniMix因子重新校正,基于先验知识采样更适合长尾任务的混合方法。

OBMix [149] 使用两个独立的采样器S1和S2来采样数据集中的所有数据类,生成一个类别均匀分布的mini-batch,然后进行混合,以在多数类和少数类之间实现平衡。DBN-Mix [150] 结合了由均匀采样器和再平衡采样器模块初始生成的两个样本,以改进少数类的表示学习。还使用了按类别温度缩放来减少分类器对多数类的偏见。由于DBN-Mix生成的样本位于少数类区域的边界附近,这些数据点分布稀疏,因此用于更好地捕捉少数类的分布。

4.3 分割

图像分割是CV中一个非常重要的研究和应用领域,通过特定的模型将图像中的像素划分为不同的部分并标记不同的标签。mixup方法保留了具有多样特征的样本,使其适合用于提高分割任务中的模型性能。ClassMix [151] 使用预训练模型作为教师模型,获取每个标签的掩码,并混合从样本中获取的不同特征。为了解决一些具有高度对称性的地点(如机场)的问题,ChessMix [152] 提出以棋盘状网格混合样本上的补丁,通过混合两个不同位置的补丁而不是直接相邻的补丁,以避免空间中断问题。SA-MixNet [153] 通过将一个图像的道路区域粘贴到另一个图像上。与其他mixup方法相比,SA-MixNet保留了道路结构的完整性。此外,设计了一种基于判别器的正则化方法,以增加道路连通性同时保持道路结构。在自动驾驶任务中,LaserMix [154] 和UniMix [155] 使用激光雷达数据集来混合样本。

分割方法也广泛应用于医学图像中。CycleMix [156] 提出使用PuzzleMix来混合样本,并进一步随机遮挡补丁。与一些基于切割的方法不同,InsMix [157] 应用形态学约束来保持临床核先验。此外,提出了背景扰动以利用背景像素冗余。SmoothGAN被提出以协调原始核和模板核之间的上下文信息。DCPA [133] 和MiDSS [158] 使用预训练模型作为教师模型来获取伪标签(一些掩码)以混合样本。DCPA中的学生模型使用两个不同的解码器来捕捉特征之间的变异性,通过Sharpen操作来获得对比损失,加强一致性约束,覆盖不同解码器输出之间的差距,并指导模型的学习方向。ModelMix [159] 提出通过不同编码器的卷积参数的凸组合来构建虚拟模型。然后对模型集进行正则化,以最小化跨任务邻接的风险,以无监督和涂鸦监督的方式。

4.4 目标检测

MUM [134](Mix & UnMix)提出通过混合图像块并在特征空间中重建它们来改进半监督教师-学生框架的性能。样本传递给教师模型以生成伪标签。学生模型在特征提取后将混合特征图基于其掩码进行恢复,恢复的特征图生成预测标签并与伪标签进行比较以获得损失函数。MixPL [135] 使用教师模型为mixup和mosaic生成两种不同的混合样本进行训练。与获取混合样本不同,MS-DETR [160] 提出了一种新的目标检测架构,通过一对一和一对多的监督来改进模型性能。

五、其他应用

在本节中,我们将讨论应用于其他任务的基于mixup的方法。如图10所示,我们将其分为两个主要小节:训练范式和超越视觉。

5.1 训练范式

5.1.1 联邦学习

联邦学习(FL)是一种分散的机器学习解决方案,最初由Google在2016年提出。它旨在通过在分布在众多终端上的数据上进行训练,开发高质量的集中式机器学习模型,以解决数据孤岛问题。为了解决用户生成数据在设备和标签之间分布的同质分布数据问题,Shin等人提出了XOR Mixup [161],它收集来自其他设备的编码数据,并仅使用每个设备的数据进行解码。解码提供合成但现实的样本,诱导同质分布数据集进行模型训练。XOR Mixup的关键思想是利用不相交操作属性:(xi ⊕ xj) ⊕ xj = xi,xi和xj来自两个单独的设备。

FedMix [162] 提出了一个简单的框架,即均值增强联邦学习(MAFL),其中客户端根据目标应用的隐私要求发送和接收本地平均数据。为了缓解由于客户端之间本地数据的不相似性增加而导致的性能下降,基于联邦学习蒸馏(FLD)和MixUp,提出了Mix2FLD [163]。具体来说,Mix2FLD中的每个设备在FL中上传其本地模型输出,并在FD中下载模型参数,从而应对上行链路和下行链路通道不对称性。在上下行链路之间,服务器运行知识蒸馏,将教师的知识转移到未训练的学生模型(即全局模型)。然而,这种输出到模型的转换需要从设备收集额外的训练样本,导致显著的通信开销,同时违反了本地数据隐私。StatMix [164] 计算单个节点的图像统计数据,即每个颜色通道的均值和标准差,作为内容和风格;通过中央服务器将计算的统计数据分发给所有节点;并在单个节点中使用这些统计数据进行风格传递。

5.1.2 对抗攻击与对抗训练

对抗攻击与训练 [165] 可以显著增强模型鲁棒性,因为它鼓励模型探索一些未见区域和OOD,而mixup方法进一步增强了模型性能,并防止任务中的模型过拟合。为了提高模型鲁棒性,M-TLAT [166] 使用MixUp以及随机生成的虚拟标签,通过分类器组合混合样本及其标签以获得梯度扰动噪声δ,然后混合噪声和混合样本以获得最终的增强样本和标签,如公式28所示:

MI [169] 通过将源样本与通过对抗攻击添加噪声的目标样本进行线性混合,将训练阶段转换为推理阶段,并在推理阶段发现MI与直接使用对抗攻击相比是最优的。与MI不同,AVMixup [170] 在输入级别添加扰动噪声,并分析软标签在对抗特征过拟合(AFO)中的有效性。IAT [171] 结合干净样本损失和对抗攻击样本损失来训练模型,并获得更好的鲁棒性和准确性平衡。类似地,Mixup-SSAT [172] 探索了车辆轨迹预测的鲁棒性,并提出了一种用于轨迹预测的对抗攻击训练方法。通过添加人为扰动的历史轨迹,改进了模型对极端情况的鲁棒性和决策能力。

AMP [173]、AOM [174] 和 AMDA [175] 提出了用于文本分类任务的方法。Liu等人认为,输入空间下Vanilla MixUp施加的线性限制往往会导致欠拟合,特别是在训练样本太少的情况下。因此,他们提出了对抗混合策略(AMP),在混合比率上添加对抗性扰动,以放松线性限制。AOM结合了mixup方法和PGD对抗优化,旨在以牺牲少量准确性为代价获得更鲁棒的分类模型。Si等人认为,在NLP任务中,简单对抗训练创建的样本搜索空间捕捉不佳。AMDA提出在预训练模型的潜在空间中进行混合,并使用生成的样本来添加到模型的训练阶段,这样可以更充分地覆盖样本空间,并更接近原始样本的分布。

5.1.3 域适应

在特定域上训练的模型在转移到另一个域时通常表现较差。为了解决这个问题,域适应策略将模型知识从标签丰富的源域转移到另一个标签稀缺的目标域。在无监督域适应(UDA)[116, 117, 176, 177, 178, 179, 180] 和部分域适应(PDA)[181] 的背景下,通过利用mixup方法进行域内或域间数据混合,显著提高了模型的有效性。

基于域混合的域适应(DM-ADA)[179] 同样确保潜在空间的域不变性,通过在VAE-GAN [182] 的基础上改进对抗网络,不仅在源域和目标域上约束域不变性,还在两个域之间的中间表示上约束域不变性。与DMRL [177] 不同,DM-ADA在域间数据样本和潜在空间混合中实现,并在域判别器中使用软标签进行评估。IIMT [178] 在对抗学习框架内同时进行域内和域间混合,以实施训练约束。SLM [181] 通过去除异常源样本并通过对样本进行标记和混合来学习判别不变特征,改进了PDA算法,消除了负迁移。CoMix [116] 提出了一种用于学习无监督视频域适应判别不变特征表示的对比学习框架。这是通过背景混合实现的,背景混合允许每个锚点有额外的正样本,从而使对比学习能够利用两个域之间共享的动作语义。

在医学图像领域,Mixup自监督学习(MixSSL)[117] 框架用于对比无关的视觉表示学习,通过混合医学训练图像样本和自然图像样本来增强医学图像分类模型的鲁棒性。SAMixup [180] 利用域距离调制光谱敏感性(DoDiSS)在图像阶段提取跨域的敏感特征。此外,它利用DoDiSS图zs和对抗学习参数λθ作为跨域阶段混合操作的加权因子:

5.1.4 知识蒸馏

知识蒸馏(KD)使用预训练的教师模型来训练学生模型。这种知识转移方法代表了深度神经网络高效训练的有前途的范式,能够在较少数据和时间内获得鲁棒模型。为了有效转移鲁棒性,MixACM [183] 通过鲁棒教师和学生传递混合样本以获得中间特征,然后通过映射函数获得激活的通道图。最后,学生模型最小化网络间损失以完成知识转移。

5.1.5 多模态

多模态(MM)学习是一种结合传统单模态数据(如文本、图像、信号)进行联合训练的方法,以获得具有强大表示能力的模型。VLMixer [186] 提出结合跨模态CutMix(CMC)和对比学习,将单模态文本转换为多模态文本和图像,以更好地实现不同模态之间的实例级对齐。CMC将自然句子中的视觉词汇(如狗、猫等)随机替换为具有相似语义的不同图像块。数据多样性增加,同时保持语义完整性。MixGen [187] 旨在生成新的图像-文本对,通过MixUp增强图像并将文本连接起来以保留语义关系。

Oh等人发现,尽管CLIP [188] 的学习目标设计为显式对齐图像和文本嵌入,但它为每种模态保留了两个单独的子空间,并且它们之间存在大量未探索的间隙,并且在微调CLIP后也保持了较差的均匀性和对齐性。这种缺乏对齐和一致性可能会限制嵌入的可转移性和鲁棒性。m2-Mix [189] 提出通过在超球面上生成硬负样本来混合图像和文本嵌入。然后在硬负样本以及原始样本和正样本上对模型进行微调,并使用对比损失。PowMix [190] 是MultiMix的改进,由五个组件组成:1)生成不同数量的混合样本,2)混合因子重新加权,3)各向异性混合,4)动态混合,5)跨模态标签混合。它从单模态数据变为多模态数据。为了解决生成模型在创建正确的前景对象时难以确保多样化的背景的问题,Wang等人提出了一种称为DiffMix [191] 的跨类数据增强方法,通过在类之间执行图像变换来丰富数据集。

5.2 超越视觉

5.2.1 自然语言处理

自然语言处理(NLP)是人工智能的一个重要子领域,使计算机能够理解、解释和生成人类语言。mixup方法已广泛应用于CV,并在一定程度上探索了NLP,通过在样本、标记和隐藏空间级别上混合来增强文本数据。

文本分类。WordMixup & SemMixup [13] 提出了两种方法,WordMixup通过在输入级别上进行线性插值来获得混合样本,而SemMixup通过在潜在空间中的差异进行混合,如图11所示。由于一些句子具有不同的大小,WordMixup将两个句子填充到相同大小,然后对每个句子中的每个词的每个维度进行插值。SeqMix [14] 在每次迭代中搜索匹配的序列对,并在特征空间和标签空间中混合它们;使用判别器来确定生成的序列是否合理。该判别器计算所有创建的候选序列的困惑度分数,并选择低困惑度的序列作为合理序列。类似地,Mixup-Transformer [192] 将两个句子通过Transformer获得其表示,然后进行线性插值以获得混合样本进行分类。Seq-level Mix [193] 通过随机组合两个子部分的句子部分来获得软混合样本。这防止模型记忆子部分,并激励模型依赖子部分的组合来预测输出。

MixText [195] 作为一种半监督方法,通过在潜在空间中混合标记和未标记文本生成大量增强样本。此外,它最小化标记、未标记和增强样本的分类损失,以及伪标签和真实标签之间的一致性损失。类似地,EMix [196] 使用词嵌入和潜在层表示的插值在句子分类任务中构建虚拟示例,从而缓解模型过拟合。值得注意的是,EMix利用文本的标准差σ定义比率λt,从而进行考虑文本能量差异的混合计算:

其中L是句子x的长度,|t|是子句的长度,K是其他的长度。L_{i} - |t_{i}^{K}|个单词来自x_{i}被保留,|t_{j}^{L}|个单词来自x_{j}被插入新句子中。

由于文本由可变长度的离散标记组成,因此在NLP任务中应用MixUp存在问题。Yoon等人提出了SSMix [197],该方法通过在输入级别而不是像之前方法那样在潜在空间中混合来优化NLP任务。SSMix通过基于显著性信息的跨度混合来合成句子,同时保留两个原始文本的局部性。max(mix(λ * xi, xj), 1)找到相同长度的标记进行替换。与WordMix不同,Nonlinear Mixup [198] 为给定句子中的每个词的每个维度使用唯一的混合λ,将样本和标签更改为非线性插值,标签混合基于输入通过自适应学习。具体来说,对于由x ∈ R^{N×C}表示的句子,Nonlinear Mixup的混合策略是一个矩阵λ ∈ R^{N×C},其中λ的每个元素独立地从Beta分布中采样。

神经机器翻译。神经机器翻译(NMT)在提高机器翻译质量方面取得了显著成功。与基于建模视角的传统多样化生成翻译不同,MixDiversity [199] 是一种数据驱动的方法,通过在解码过程中将训练集中的不同句子对与源句子混合,生成不同翻译,以提高翻译多样性。AdvAug [200] 在NMT任务中提出了一种对抗增强方法。该方法通过替换句子中的词来形成对抗样本,然后从域中选择样本进行对齐词嵌入的凸组合。AdvAug通过混合不同来源的观察句子来增强对抗样本的多样性,并提高NMT模型的鲁棒性。Multilingual Mix [201] 通过引入多语言交叉编码器-解码器来生成交叉示例,这些示例继承了不同语言对组合的特征,从而更好地利用跨语言信号。在跨域翻译任务中,通常存在翻译文本倾向于添加噪声的问题。X-Mixup [202] 提出使用_Scheduled Sampling_和_Mixup Ratio_分别处理分布偏移问题和数据噪声问题。

其他。STEMM [204] 提出将语音样本通过w2t和CNN获得其语义表示,将文本样本分为标记并通过嵌入层获得表示;由于语音表示的维度往往大于文本表示,作者使用标记级别的强制来处理它们。LADA [205] 提出了一种基于局部可加性的数据增强方法,用于半监督命名实体识别任务,类似于MixText [195],通过在隐藏空间中对一个句子或不同句子中的标记进行插值。该方法创建了无限量的标记数据,从而改进了实体和上下文学习。由于过度参数化的预训练语言模型在微调过程中可能会遇到分布内和OOD数据之间的显著校准误差。为了解决这个问题,CLFT [206] 通过在数据流形内插值生成伪流形样本。这种方法旨在施加平滑正则化,增强分布内数据的校准。同时,CLFT鼓励模型为伪非流形样本生成均匀分布,缓解OOD数据的过度自信问题。HypMix [207] 认为在欧几里得空间中的插值会引入失真和噪声,因此提出了一种在黎曼双曲空间的潜在空间中混合数据的新方法。该方法更有效地捕捉输入和隐藏状态层次结构中固有的复杂几何结构。

5.2.2 图神经网络

图卷积网络(GCN)因其独特的计算能力而受到关注和研究,现已成为深度学习领域的主要分支。一些传统的深度学习模型在欧几里得空间数据(如文本、图像、视频等)上取得了良好的效果,但在处理非欧几里得空间数据(如社交网络、信息网络等)时存在一些局限性。为了解决这个问题,研究人员引入了图论中的抽象图来表示非欧几里得结构数据。GNNs用于处理来自图的数据,以深入探索其特征和模式。Xue等人提出了三种GNN的增强方法 [208]:NodeAug-I、NodeAug-N和NodeAug-S。NodeAug-I通过随机采样两个节点的特征信息和标签来获得新的虚拟节点v。由于NodeAug-I忽略了虚拟节点vp的边,因此进一步提出了NodeAug-N和NodeAug-S。NodeAug-N通过选择概率为λ的vi和概率为1 - λ的vj来获得虚拟边;由于虚拟边是有向的,它们不会影响现有节点的推理。NodeAug-S通过聚合vi的所有邻居的有向边并按λ缩放,以及聚合vj的所有邻居的有向边并按1 - λ缩放来获得新的虚拟边。

与Xue等人不同,MixGNN [209] 使用随机配对的节点来混合其接收域子图。MixGNN提出了一种双分支混合图卷积网络(GCN)来插值不规则图拓扑。在每一层,GCN根据配对节点的拓扑在两个分支中进行,然后从两个分支中插值聚合表示,在下一层之前。NodeAug-I和MixGNN在输入级别混合,没有考虑到图样本中一些少数类往往稀疏,这不利于直接混合以获得样本。PMRGNN [210] 是一种基于PageRank的方法,用于解决节点分类任务中难以扩展邻域的问题。通过设计一种基于PageRank的随机增强策略,结合两个编码器来补充特征之间的跨表示,并设计一个正则化项来从邻域节点中找到更多特征,从而提高模型的性能。Graph Transplant [211] 提出在图级别进行混合,选择两个样本中具有最大显著性信息(从梯度获得)的节点和边,然后混合它们以创建新边,从而在数据级别混合不规则图。

GraphMix [16] 是一种基于GNN的半监督对象分类的正则化方法。它采用Manifold Mixup作为数据增强工具应用于隐藏层,其中参数直接在全连接网络(FCN)和GNN之间共享。这促进了从FCN到GNN的判别节点表示的转移。GraphSMOTE [212] 提出通过GNN编码器将稀疏图转换为高维密集表示,随机选择少数样本xi,假设嵌入为节点zi,然后找到相同标签样本的最近邻节点zn,然后混合它们之间的差异以获得新节点v^v^,并使用解码器来预测新边u。在GraphSMOTE中,合成少数过采样技术(SMOTE)策略通过为少数类创建伪示例来解决这个问题,以平衡训练数据。类似地,在解决节点分类中的类别不平衡问题时,GraphMixup [18] 提出在语义级别特征混合,并引入强化混合机制,自适应决定将生成多少少数类的混合样本。iGraphMix [20] 提出解决图节点分类的不规则性和对齐问题。它聚合采样的邻域节点,而不是仅插值节点特征。此外,它分析了理论并展示了更好的泛化差距。

5.2.3 3D点云

3D点云数据与RGB图像不同,由多个3D坐标集数据组成。它广泛应用于自动驾驶和3D重建任务。由于点云没有两个不同对象的点之间的一对一对应关系,因此不能直接使用MixUp。PointMixup [214] 回顾了数据与方法之间的关系,并定义了点云数据的增强为使用地球移动者距离 [215] 计算所需的最小总移位来匹配相应点的最短路径的线性插值。然后通过最佳分配路径函数在两个点云之间创建混合样本。

对于特定的网络架构,如PointNet++ [216]、RS-CNN [217] 等,更关注局部特征,PointMixup很容易陷入局部模糊和不自然的陷阱,PointCutMix [213] 通过创建新子集,然后切割和粘贴两个样本来实现自然混合。RSMix [218] 通过将掩码区域的概念从2D扩展到3D,使用kNN来保持点云的形状并找到相似的邻居;然后从每个样本中提取RS以混合样本;可以在保持原始样本的3D形状的同时混合两个样本,保留部分原始样本的形状。与RSMix和PointCutMix类似,PA-AUG [219] 将整个数据分为4或8个块,并随机应用五种增强方法,如点Dropout、CutMix、CutMix & MixUp、稀疏采样和随机噪声创建。与这些手工方法不同,Point MixSwap [220] 提出了一种可学习的注意力模块,将点云分解为几个不相交的点子集,称为分区,其中每个分区在另一个点云中有相应的分区。增强点云通过交换这些匹配来合成,从而生成高度多样化的输出。

5.2.4 其他

由于mixup方法是一种以数据为中心的工具,它可以服务于任何以模型为中心的任务。

信号数据类型。Constrastive-mixup [22] 在语音识别任务中使用mixup,其中两个语音样本在输入级别混合,然后进行分类,与大多数mixup损失Lmce不同,Constrastive-mixup使用infoNCE损失进行训练。LLM [221] 提出了一种可学习的损失函数,通过混合样本和随机噪声来获得增强样本。Octave Mix [222] 提出通过频率分解交叉处理低频波形和高频波形,提取xi和xj的高低频信息,分别交叉混合它们,然后通过线性插值混合它们。

度量学习。为了解决大多数对比学习中采样方法对模型施加的偏见和额外硬负样本的开销,EE [223] 提出了一种在嵌入空间中学习损失的扩展方法,通过组合特征点创建包含增强信息的合成点,并挖掘硬负对以获得最具信息量的特征表示。Metrix [224] 提出了一种包含现有度量学习损失函数的广义公式,并对其进行修改以适应MixUp,并引入_度量利用_,通过在训练期间混合样本来探索训练类空间区域之外的区域,从而展示区域的改进。

生物学AI。DNABERT-S [225] 能够高效地聚类和分离嵌入空间中的不同物种。这一改进得益于提出的MI-Mix损失和课程对比学习(C2LR)策略。对比学习使模型能够区分相似和不相似的DNA序列,而课程学习逐步呈现更具挑战性的训练样本,促进更好的学习和泛化。

低级任务。Yoo等人发现,在超分辨率任务中,空间关系非常重要,之前使用丢弃或处理像素或特征的方法严重阻碍了图像恢复,并提出了CutBlur [226],将低分辨率(LR)补丁切割并粘贴到相应的高分辨率(HR)区域。CutBlur的关键直觉是使模型不仅学习“如何”进行超分辨率,还学习“在哪里”进行超分辨率。SV-Mitxup [227] 设计了一个可学习的选择模块,从两个视频中选择最具信息量的体积,并混合这些体积以获得新的训练视频用于视频动作识别。

SiMix [228] 混合来自同一mini-batch的两个正样本。混合样本形成一个虚拟批次,然后用于训练。在无监督连续学习(UCL)任务中,通常会遇到灾难性遗忘,LUMP [229] 通过从缓冲区中选择一个已用样本,与当前时刻的样本混合,然后使用当前增强样本来进行无监督学习,从而提高模型性能。ContextMix [230] 结合了mixup方法和静态调整大小的替换,以提高性能。

六、分析与定理

mixup方法在CV和NLP等领域的发展中做出了显著贡献。对这一方法的深入研究和探索仍在由研究人员不断探索和发现。在本节中,我们总结了一些关于mixup的分析和定理,重点关注三个主题:(1)一些mixup方法中的超参数和策略,如λ选择、掩码优化和Beta分布中的Alpha选择。(2)mixup方法对模型正则化的影响,如鲁棒性和泛化性。(3)mixup方法对模型校准的改进。

6.1 虚拟风险最小化

监督学习旨在在高维空间中找到一个映射函数f(·),该函数可以对输入随机x和输出随机y之间的联合分布P(x, y)进行建模。为了保持函数f不断近似,提出了损失函数LL来衡量模型预测f(x)与真实标签y之间的差异。还需要一个优化算法来最小化损失函数L在联合分布P上的平均值,以获得最优函数f*(·):

6.2 超参数与策略

在mixup方法中,许多超参数可以显著影响模型的性能,如混合比率λ、掩码MM和Beta分布中的α。

混合比率与Beta分布。Guo等人发现不同的混合比率会影响模型的性能,导致“流形入侵”问题,并在MINIST [232] 数据集的实验中发现,当λ=0.5时,模型性能比其他混合比率更差。AdaMixup [5] 提出使用两个独立模型来创建混合比率λ,并确定混合样本是否导致“流形入侵”问题。实验表明,“流形入侵”问题可以减少。混合比率λ从Beta(α, α)分布中采样,不同的超参数α代表不同的曲线。RegMixup [95] 探索了α设置与模型性能之间的关系,并提出结合CE损失和MCE损失以进一步提高性能,其中MCE损失作为正则化器。

掩码策略与训练策略。Park等人提出了一个统一的混合样本数据增强(MSDA)理论分析,如MixUp和CutMix。理论结果表明,无论选择哪种混合策略,输入梯度和Hessians的正则化都得到了证明。MSDA [40] 结合了MixUp和CutMix的优势,设计了HMix和GMix(全局混合和局部混合)。为了解决mixup的缓慢收敛和α选择的困难,Yu等人提出了mixup Without hesitation(mWh)策略 [94]。它通过定期关闭混合操作来加速mixup。mWh通过实验分析证明,mixup在前几个epoch中有效,而在后几个epoch中可能有害。因此,逐渐使用基本数据增强方法替换MixUp,模型训练逐渐从探索转向利用。United MixUp [233] 认为mixup方法类似于对抗训练。对抗训练从空间中采样随机噪声并将其添加到源样本训练模型,使模型学习源样本分布邻域的特征。类似地,MixUp是从已知“噪声”中采样并将其添加到源样本进行训练。为了扰动实例xi,DAT选择一个随机实例xj,从规定的分布中选择一个随机λ,并通过(1 - λ)倍的距离从xi到xj扰动xi。

6.3 鲁棒性与泛化性

Mixup帮助模型学习更鲁棒的特征,从而防止过拟合。由于mixup混合了多个样本,它迫使模型学习能够同时识别多种类别的特征。创建涵盖可能分布的多样化样本,提高了模型在未见数据上的泛化能力,使其在未见数据上表现更好。

Liang等人 [234] 认为,理解mixup训练有两种观点。一种观点表示mixup使用不同类别的样本的线性插值来创建混合样本。不同的线性插值创建了不同的样本,这为模型提供了更多采样特征的机会,避免了过拟合。这表明mixup是一种数据增强方法。另一种观点表示mixup允许模型学习多个样本并避免多个样本之间的混淆,从而使两个不同类别可以轻松分离。这表明mixup是一种正则化方法。对于mixup如何提高鲁棒性和泛化性的研究,Zhang等人提供了理论分析。对于鲁棒性,[235] 表明最小化的mixup损失是标准经验损失的正则化版本,导致二阶泰勒展开的上界,以提高对抗鲁棒性。对于泛化性,mixup是一种特殊的数据自适应正则化,控制Rademacher复杂性类以减少过拟合。类似地,[237] 表明mixup可以评估为标准经验风险最小化估计器,并且使用mixup进行训练类似于在填充有结构化噪声的修改数据上学习。

Liu等人报告了mixup训练中的一个现象:在许多通用数据集上,使用大量epoch训练的mixup模型性能开始下降,形成一个“U”形曲线。当数据集样本减少时,这种性能进一步加剧。为了理解mixup的性能,[238] 理论认为mixup训练在混合样本中添加了标签噪声。Mixup通过早期拟合干净特征来提高泛化性,但在后期过拟合噪声。由于标签噪声,训练早期由干净特征驱动,但噪声在后期占主导地位,将模型参数从正确解推开。Teney等人发现选择性mixup [239] 和重采样之间的等价性。确定了前者的局限性,确认了后者的有效性,并找到了它们各自优势的更好组合,即选择性mixup是重采样的变体,除了选择性mixup可以跨域执行,它们的最终目标是平滑分布。

6.4 模型校准

对于一些高风险应用,机器学习模型对其预测的置信度至关重要。模型校准是保持模型预测概率与真实经验概率一致的过程。其中ECE [240] 是一个关键指标。Manifold Mixup发现mixup可以有效提高模型校准 [241]:

Thulasidasan等人认为,由于标签都是one-hot,模型存在过度自信或不自信的问题。通过在小规模和大规模图像样本以及NLP样本的实验,[242] 发现使用mixup会导致标签平滑的形式,这提供了超越高精度的额外好处,导致更好的校准模型和改进的过度自信。这种方法比其他标签平滑方法具有优势。Zhang等人从理论上证明了mixup在高维空间中提高了校准,通过研究自然统计模型,校准收益随着模型规模的增加而增加。该理论得到了主流架构和数据集实验的支持。Mixup提高了校准,特别是在参数数量超过样本数量时。此外,[238] 研究了mixup如何提高半监督学习中的校准。虽然混合未标记样本使模型校准不佳,但添加mixup训练可以缓解这个问题。实验表明,伪标签化损害了校准。然而,结合mixup和伪标签化可以改善校准。

七、讨论

本节基于以下两点讨论mixup方法:挑战问题与未来工作。

7.1 挑战问题

Mixup主要关注基于监督学习的图像分类任务。然后扩展到其他训练范式(如自监督学习、半监督学习、联邦学习、知识蒸馏、多模态等),不仅限于图像分类,还应用于文本、语音、图、3D点云分类任务。然而,mixup在所有这些任务中展示了出色的鲁棒性和泛化性,并提高了模型性能。然而,当前的mixup方法在特定任务和场景中仍存在一些问题,值得研究人员进一步探索和解决。

-

混合样本生成与选择。可靠的混合样本是图像分类任务中主流方法的关注点,但在下游任务(如检测、分割和多模态VQA等)中更难以分析或评估,这些方法只能通过使用基本的MixUp + CutMix来扩展训练样本,对于回归任务,选择“真实”样本进行模型训练非常重要。因此,如何扩展mixup方法以生成或选择可靠的混合样本用于下游任务是进一步提高模型性能的重点。

-

混合标签改进。混合比率决定了样本和标签之间的关系以及在mixup方法中计算损失。DecoupledMix [12] 中发现了其重要性。在样本级别,可学习方法迫使掩码服从比率λ,在标签级别,掩码用于重新计算λ。似乎没有指标来衡量两者之间是否正确/可靠。同时,如何改进mixup标签的质量可能是实现通用、高性能和高效mixup方法的重要观点,比修改mixup样本生成更经济。

-

性能与效率的权衡。尽管AutoMix [76] 实现了良好的权衡,但问题仍然存在。这不仅存在于mixup中,也存在于一些一般的数据增强方法中。一些离线方法可以减少开销,但不能泛化到其他场景;相反,一些在线方法可以自适应地泛化到其他场景,但也增加了模型训练的开销。是否有更好的权衡方法?数据增强的最佳方法是花费更少的时间获得更多的收益,并泛化到更多任务。

-

缓解流形入侵与OOD检测。由于mixup具有两个或更多类别的特征,因此容易导致“流形入侵”,在高维空间中破坏数据流形,导致模型鲁棒性和可靠性降低。对于OOD,一些mixup方法使用额外的图像作为“噪声”来提高OOD检测能力,然而,这是基于输入级别的,并且受限于手动设计。如何减少“流形入侵”的情况并设计更自适应的方法用于OOD检测值得进一步探索。

-

转移到统一的mixup框架。尽管在不同任务和场景中有许多mixup方法,但这些方法主要为特定任务提出,难以转移到其他任务。主流mixup方法是为图像分类提出的,并在目标检测或分割中进行了一些下游任务转移实验。然而,这些方法基于图像模态,对其他模态(如文本、语音和蛋白质)无效。因此,如何将mixup方法转移到统一框架是一个值得探索和研究的问题。

7.2 未来工作

作为一种增强方法,mixup可以应用于许多任务。考虑到最新技术和发现,哪些具体任务可以作为“数据中心”方法的一部分,我们概述了一些机会。

-

混合样本的数量。大多数mixup方法使用两个样本混合。在图像分类中,Co-Mix [26]、AdAutoMix [79] 选择混合2-3个样本以提高模型性能。然而,对于其他任务,没有选择混合多个样本的选项。混合多个样本可以进一步增加增强样本的多样性,同时增加样本的难度。因此,研究并选择相应任务的混合样本数量是值得的。

-

应用于MLLMs和Mixup。多模态大语言模型(MLLMs)展示了强大的能力。m2-Mix使用文本和图像模态混合来改进CLIP [188]。不同数据模态具有各种特征,可以带来更多特征并减少不同模态之间的差距,当使用图像、文本和音频混合样本进行训练时,可以增强模型的鲁棒性和泛化性。

-

基于生成模型的样本生成。GAN [27]、VAE [91]、扩散模型(DM) [243] 可以生成高质量的样本,一些当前工作如DiffuseMix [4]、DiffMix [191] 已经证明生成模型可以用作数据增强方法。然而,DM需要大量时间来生成样本。GAN和VAE可以快速生成样本,但生成样本的质量难以保证。如何权衡效率和质量是值得研究的。

-

采用统一的Mixup框架。Mixup作为一种即插即用、简单且有效的数据增强工具,最初被设计为可训练和端到端的方式。我们认为mixup不应再被视为工具,而应被视为训练框架。然而,大多数研究人员仍然存在偏见,认为mixup是一种数据增强方法,根据他们需要执行的任务进行设计。我们呼吁将mixup作为一种统一框架来实现更多具体任务。

八、结论

在本调查中,我们将mixup方法重新表述为一个统一框架,并总结了从2018年到2024年在各种任务上的技术细节和数据模态。此外,我们将mixup分为两个主要类别:样本混合策略和标签混合策略,这些类别可以包含不同改进版本的mixup,并将本调查中的所有mixup方法总结为两个图:图A1和图A2。此外,我们总结了mixup方法中经常使用的各种类型的数据集,主流模型在常用数据集上的图像分类任务的分类结果显示在表A2、表A3和表A4中。最后,我们讨论了现有问题和值得未来工作的想法,以给研究人员在这个领域提供一些先进的想法和思考。

1118

1118

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?