引言:

✅ NLP 研 2 选手的学习笔记

笔者简介:Wang Linyong,NPU,2023级,计算机技术

研究方向:文本生成、大语言模型

论文链接:https://aclanthology.org/2024.lrec-main.1192.pdf,2024 COLING CCF-B

项目链接:无

中文标题:《个性化对话生成的最新趋势:数据集、方法和评估综述》

文章目录

0 摘要(Abstract)

● 通过对话代理(agents)的个性化来增强用户参与度已经变得非常重要,特别是随着可以生成流利回复的大型语言模型(LLMs)的出现。然而,个性化对话生成是多方面的,其定义各不相同——从在代理中灌输角色到捕捉用户的显式(explicit)和隐式(implicit)线索。本文尝试系统地调查个性化对话生成的最新情况,包括采用的数据集、开发的方法和应用的评估指标。本文重点介绍了基准数据集和具有额外特征的较新的数据集,涵盖了 22 个数据集。进一步分析了 2021-2023 年间顶级会议上的 17 项开创性工作,并确定了 5 种不同类型的问题。还阐明了 LLMs 在个性化对话生成方面的最新进展。我们的评估部分提供了这些工作中使用的评估方面和指标的全面总结。最后,讨论了个性化对话生成面临的挑战,并对未来研究的方向进行了展望。

● 关键词: 个性化对话系统,个性化回复生成,基于角色的对话

1 前言(Introduction)

● 个性化可以增强用户与会话代理的参与度(Zhang等人,2018a;Kwon等人,2023)。大型语言模型(LLMs)的能力(OpenAI, 2023;Touvron等人,2023)为了对人类查询产生流畅和连贯的回复,强调了建立比以往任何时候都更迎合每个人背景和偏好的个性化系统的重要性。

● 然而,个性化仍然是一个开放的问题,不同的人有不同的定义。图 1 展示了目前个性化对话生成研究中正在探索的 3 种场景。这可能涉及给代理赋予角色,对另一方的角色进行建模,或者两者兼而有之。在这里,人物角色是指塑造用户或代理身份或个性的个人背景、兴趣或行为等特征。个性化回复生成可以被视为一个条件文本生成任务,其中回复是根据给定的上下文生成的,并以说话者明确提供的角色或嵌入在对话历史中的隐式(explicitly)属性为条件。

图1:个性化对话生成概述。假设对话是由两个说话者执行的,即智能体

A

A

A 和用户

U

U

U,目标是根据对话上下文

C

C

C 或最后的话语

Q

Q

Q,加上智能体或用户的角色(

P

A

P_A

PA 或

P

U

P_U

PU)(显式),或他们的话语历史(

H

A

H_A

HA 或

H

U

H_U

HU)(隐式)生成回复

R

R

R。

● 本文旨在发现什么是个性化的(数据集),对话系统如何实现个性化(方法),以及之前的研究如何评估本系统调查中的个性化(评价)。在数据集部分(第 2 节),介绍了 22 个数据集,包括在以前的个性化对话研究中经常使用的基准数据集,以及最近发布的数据集,这些数据集建议在现有的基础上添加更多的特征。在方法论部分(第 3 节),根据关键字搜索和每篇论文中的相关工作,重点介绍了近三年(2021年至2023年10月)在顶级会议上发表的 17 篇工作,包括 ACL, NAACL, EMNLP, AAAI 等。在评估部分(第 4 节),我们总结了每项工作的评估方面和评估指标。

● 在讨论部分(第 5 节)中讨论了数据集、方法和评估方面的挑战和潜在未来轨迹。认为当前数据集的主要问题围绕其规模、质量和多样性。在方法论方面,强调需要严格审查支持个性化方法的假设。最后,倡导一个配备先进指标的标准化评估基准(benchmark),以提供对该领域贡献的公平评估。

2 数据集(Datasets)

● 在本节中,我们首先回顾了在个性化对话生成文献中使用的数据集。讨论了数据集的特征,重点是人物角色表示以及领域和语言偏差。

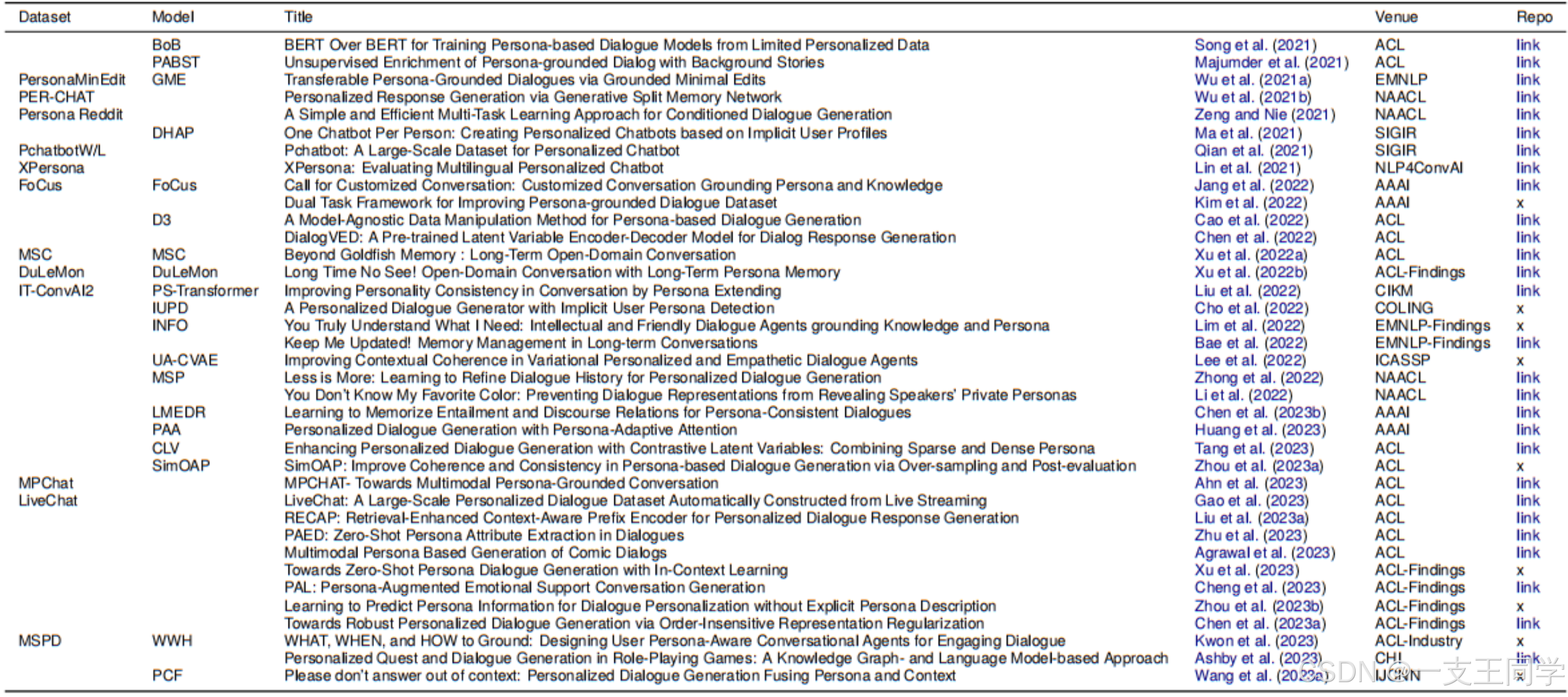

表1:数据集汇总。人物角色可以用描述性语句(Description)或 key-value 字典(KV)表示。数据来源主要来自众包(Crowd)和 Reddit (包括Reddit的子版块社交新闻网站) (H: happy, O: offmychest, A: AskReddit, 648*: from 648 个Reddit的子版块社交新闻网站)。D:对话数。U/D:每段对话的平均话语量。人与人之间的对话。H-A:人-代理的对话。 △ \triangle △:可按要求提供。人物角色基础(P Ground.)是指每个话语都有其所依据的人物角色句子的标签。KG:知识。EMP:同理心。OOD:分发外角色。我们添加了背景色来强调不太常见的选项。

2.1 数据集回顾(Datasets Review)

● 表 1 总结了这些数据集。个性化对话研究中最早和最广泛使用的数据集之一是 PersonaChat 数据集(Zhang et al., 2018a),它也被用于第二届对话智能挑战(ConvAI2) (Dinan et al., 2020)。第 3 节介绍的 18 个作品中有 9 个在 PersonaChat/ConvAI2 上评估了他们的系统。PersonaChat 共包含 10.9K 个英语对话,通过众包的方式收集。在 PersonaChat 中,每个对话由两个试图了解对方的人类说话者组成,每个说话者大约有 5 个角色描述句。

● FoCus 数据集(Jang等人,2022)引入了人物角色基础,表明每个话语都锚定到特定的人物角色句子。通过角色基础标签,模型可以学习从角色中提取最相关的个人信息。MPChat (Ahn等人,2023)、DuLeMon (Xu等人,2022b)和 MSPD (Kwon等人,2023)等数据集也包含人物角色的信息(persona grounding)。

● 一些数据集引入了多会话对话。MSC 数据集(Xu et al., 2022a)类似于 PersonaChat,不同的是 MSC 对同一对发言者有 4 到 5 个会话。DuLeMon (Xu et al., 2022b)和 MSPD (Kwon et al., 2023)也将 多轮会话(multi-session) 引入了他们的数据集。

● 一些数据集还用其他特征(如知识、同理心和视野)增强了人物信息。BlendedSkillTalk (BST) 数据集(Smith et al., 2020)与PersonaChat 的不同之处在于,BST 通过将 PersonaChat 与维基百科的 Wizard (Dinan et al., 2019)和 Empathetic Dialogues(同理心对话,Rashkin et al., 2019)相结合,赋予代理人物角色、知识(knowledge,KG)和同理心(empathy,EMP)。每个智能体被赋予两个角色句,每个话语都被标记为它们基于的偏见类型(角色、知识图谱或EMP)。Persona-based Empathetic Conversation(PEC)数据集(Zhong et al., 2020)也研究了角色对移情回复的影响。PEC 与 BST 在从 Reddit 中提取人物角色方面有所不同。MPChat 数据集(Ahn等人,2023)引入了第一个多模态人物角色,其中人物角色不仅是文本描述,还与图像配对。

● 由于众包数据集的规模有限,现实世界数据中人物角色的分布往往超过数据集。PersonaMinEdit (Wu et al., 2021a)和 Inadequate-Tiny-ConvAI2 (IT-ConvAI2) (Liu et al., 2022)专门设计用于测试基于未见过的人物角色的生成。具体来说,这些数据集确保它们的测试集只包含未见过的角色,回复应该以这些角色为条件。

2.2 部分数据集(Facets)

2.2.1 人物角色代表(Persona Representation)

● 角色信息应该如何表示并不明显。通过文献调研,我们发现不同的数据集采用不同的方式来表示角色信息,角色表示可以分为三类:(1)角色描述,(2)键值属性,(3)用户ID和评论历史。

● 大多数数据集采用 描述性句子(descriptive sentences) 作为人物角色表示(Dinan等人,2020;Mazaré等,2018;Smith等人,2020;钟等,2020;Wu等,2021a;徐等,2022a,b;Liu等人,2022;Jang等人,2022;Ahn等人,2023;Kwon等人,2023)。例如,PersonaChat (Zhang et al., 2018a)为每个说话者包含 5 个描述性句子。这些数据集主要根据给定的角色描述招募注释者进行聊天,从而避免了隐私问题。Mazaré等人(2018)使用启发式规则从Reddit中提取人物描述,以收集大型数据集,Zhong等人(2020)和 Ahn 等人(2023)也采用了这种方法。

● 一些数据集使用 稀疏的键值属性(sparse key-value attributes) 来表示个人信息(Qian等人,2018;郑等人,2019;吴等人,2021b;Gao等人,2023)。表 2 显示了键值属性的例子。例如,WD-PB (Qian et al., 2018)定义了 6 个属性键,如性别、位置和年龄,这些键对应的值被记录为每个用户的角色信息。除了键值属性之外,livchat (Gao等人,2023)还提供了密集的人物描述,该描述是通过类似于 Mazaré 等人(2018)的基于规则的方法提取的,而 PER-CHAT (Wu等人,2021b)提供了由预训练的IR系统提取的与查询相关的评论历史作为额外的个人信息。他们首先定义想要提取的属性类型,然后使用正则表达式从帖子/回复中收集结果(Qian et al., 2018;Wu et al., 2021b),来自用户提供的配置文件(Zheng et al., 2019;Gao等人,2023),或招募注释者从给定的上下文进行标记(Gao等人,2023)。

● 一些从社交平台上收集的数据集只提供 演讲者/用户 IDs(speaker/user IDs) 作为用户信息(Zhang等人,2020;Qian等人,2021;曾和聂,2021)。他们假设演讲者 IDs 用于检索社交平台中相应用户的评论历史记录。说话人 IDs 也被用于其他任务,如说话人识别。它们认为同一个用户的话语包含隐式的个人信息,其个性化可以通过生成的回复与真实回复之间的相似性来衡量。

2.2.2 领域和语言偏差(Domain and Language Biases)

● 个性化对话生成是一项开放领域的任务:人类说话者可以谈论他们喜欢的任何主题。然而,通过文献调研,我们发现数据集之间存在领域差异。PchatbotL (Qian et al., 2021)收集自中国司法论坛。从 Reddit 版块 AskMeQuestion 爬取的 PER-CHAT (Wu et al., 2021b)更类似于问答(QA)数据集。FoCus (Jang等人,2022)要求标注者讨论 谷歌地标数据集第二版(Google Landmarks Dataset v2) 中的地标(Weyand等人,2020)。它更像是一个对话式问答数据集,用户提出有关地标的问题,然后代理进行回答,而不是人类之间的自然对话。LiveChat (Gao et al., 2023)收集了抖音(中国 TikTok)上的直播数据。可能有很多人(多方)回复主播,而主播只回复一个人,这就形成了一对一的对话。

● 此外,角色对话生成并不局限于特定的语言;然而,数据集的语言有很大的偏差。XPersona(多语言人物聊天)(Lin et al., 2021)将一部分人物聊天翻译成汉语、法语、印度尼西亚语、意大利语、韩语和日语。然而,每种语言的对话数量非常有限。例如,意大利语只有 280 个对话。还有 PersonaChat 的其他翻译,如日语(Sugiyama等人,2021年)和韩语。除了翻译之外,百度还构建并发布了类似于 PersonaChat 的中文 PersonaChat dataset。DuLeMon (Xu et al., 2022b)和多会话个性化对话(Multi-Session Personalized Dialogue,MSPD) (Kwon et al., 2023)是 多会话聊天(Multi-Session Chat,MSC) 的中国和韩国版本(Xu et al., 2022a)。

3 方法(Methodology)

● 本节首先介绍个性化对话生成的任务定义,讨论 2021 年至 2023 年在顶级会议上发表的个性化对话生成的最新方法进展。最后,回顾了最近在个性化对话生成中大型语言模型的研究。

3.1 问题陈述(Problem Statement)

● 在本调查中,我们关注双边对话,即双方之间的对话。如图 1 所示,我们将两个说话者定义为代理

A

A

A 和用户

U

U

U,当前对话上下文为

C

C

C,其中

C

C

C 的最后一句话定义为用户

U

U

U 说出的查询

Q

Q

Q。还可能存在过去的对话历史

H

H

H,其中代理

A

A

A 和用户

U

U

U 的历史话语分别表示为

H

A

H_A

HA 和

H

U

H_U

HU。

● 个性化对话生成的目标是生成一个回复

R

R

R,作为一个以输入对话

D

D

D 和角色

P

P

P 为条件的代理。输入对话

D

D

D 可以是单个查询

Q

Q

Q(即用户的最后一句话)或对话上下文

C

C

C。角色

P

P

P 可以以各种表示格式,如描述性句子和稀疏的键值属性,如第 2 节所示。代理

A

A

A 的角色

P

P

P 表示为

P

A

P_A

PA,用户

U

U

U 的角色表示为

P

U

P_U

PU。

● 个性化对话生成有两大主流。一个方向赋予智能体自己的角色 P A P_A PA,并专注于生成与角色 P A P_A PA 一致、与对话上下文 C C C 一致的 R R R。大多数研究明确地将 P A P_A PA 作为输入;一个例外是 Ma等人(2021),其中没有提供 P A P_A PA,并且代理的历史回复 H A H_A HA 被视为角色信息。

● 另一个方向旨在对用户的角色 P U P_U PU 进行建模,以生成更符合用户需求的回复。重点通常是从所提供的 P U P_U PU 中选择与 Q Q Q 最相关的段,或者在没有直接给出 P U P_U PU 时建立 P U P_U PU。在 P U P_U PU 不存在的情况下,可以从用户的对话历史 H U H_U HU 推导出显式或隐式 P U P_U PU,也可以通过条件变分推理推导出隐式 P U P_U PU。

3.2 方法(Approaches)

● 通过调查发现,最近的个性化对话生成方法可以根据动机和目标问题分为 5 类:一致性和一致性、角色-情境平衡、相关角色选择、未知角色建模和数据稀缺。请注意,一篇论文可能涵盖这些问题中的多个。

旁注:尽管与此密切相关的研究侧重于从对话中提取人物角色,如 Zhu 等人(2023),但它超出了本文的范围,该范围主要集中在个性化对话生成。

3.2.1 逻辑一致(Consistency and Coherence)

● 正如在上一节中提到的,大多数关于赋予模型人物角色的研究都集中在生成与给定人物角色同时与上下文一致的回复。

● 不确定性感知的 CVAE (UA-CVAE) (Lee等人,2022)使用条件变分自编码器(VAE)训练解决了一致性问题。他们建议以上下文 C C C、主体角色 P A P_A PA 和潜变量 z z z 为条件生成回复 R R R。潜变量 z z z 从潜高斯分布 p ( z ∣ C , P A ) p(z|C, P_A) p(z∣C,PA) 中采样,其中 z z z 的方差作为输入 ( C , P A ) (C, P_A) (C,PA) 中的不确定性的近似值。

● 自然语言推理(NLI)通常用于解决一致性问题,预测前提和假设是必然的、中立的还是矛盾的。BoB (Song et al., 2021)用 NLI 数据训练了一个解码器,以确保一致性并最小化回复 R R R 和代理角色 P A P_A PA 之间的矛盾。

● 在 BoB 的基础上,PCF (Wang et al., 2023a)进一步在 R R R 和查询 Q Q Q 之间增加了另一个 NLI 模块,以保持对话的连贯性。LMEDR (Chen et al., 2023b)使用两个额外的矩阵参数对预训练的 NLI 模型进行了微调,这些矩阵参数作为语言建模的额外“记忆”,一个用于一致性,另一个用于一致性。SimOAP (Zhou等人,2023a)证明了高概率的回复并不总是优于低概率的回复。因此,他们的方法涉及生成一个广泛的候选回答列表和后过滤。首先,使用 TF-IDF 方法筛选候选人是否与 C C C 一致(Salton和Buckley, 1988),然后通过预训练的 NLI 模型选择与 P A P_A PA 一致。

3.2.2 角色-上下文的平衡(Persona-Context Balancing)

● 因为不是所有的回复都需要个性化,所以决定何时更多地根据上下文来设定条件,何时在回复中加入更多的个人信息是很重要的。角色自适应注意力(Persona-Adaptive Attention,PAA) (Huang et al., 2023)分别对 P A P_A PA 和 C C C 进行编码,然后设计注意力机制将两者动态结合。WWH (Kwon et al., 2023)将非个性化数据集与个性化数据集集成,根据每个数据集的大小调整训练数据采样,以产生更自然的回复。

3.2.3 相关角色选择(Relevant Persona Selection)

● 虽然并不是给定的角色 P ∈ { P A , P U } P∈\{P_A, P_U\} P∈{PA,PU} 中的所有信息都与对话 D ∈ { Q , C } D∈\{Q, C\} D∈{Q,C} 相关,但选择最相关的角色句对于生成自然和引人入胜的回复至关重要。PS-Transformer (Liu et al., 2022)和 FoCUS (Jang et al., 2022)为每个角色句子训练了一个二进制分类器,以评估它们被利用的可能性。相比之下,INFO (Lim et al., 2022)通过多分类器获得所有 P A P_A PA 候选的权重。DuLeMon (Xu et al., 2022b)和WWH (Kwon et al., 2023)训练 LLM 基于 C C C 来区分消极角色句和积极角色句。注意,具有角色基础标签的数据集——每个话语都与特定的角色属性相关联——通常是学习相关角色选择所需的。

3.2.4 未知角色建模(Unknown Persona Modeling)

● 在没有明确给出角色 P P P 的情况下,可以从说话人的对话历史( H A H_A HA 或 H U H_U HU)中提取个人信息(Ma等人,2021;钟等,2022;Xu等人,2022b),或隐变量建模(Cho等人,2022;Tang等,2023)。

● DHAP (Ma等人,2021)、MSP (Zhong等人,2022)和DuLeMon (Xu等人,2022b)从对话历史中提取显式(DuLeMon, MSP)或隐式(DHAP)个人信息。DuLeMon 首先对

U

U

U 和

A

A

A 进行了个人信息管理,训练了一个分类器来判断语句中的子句是否包含个人信息。在相似度检查之后,在

P

A

P_A

PA 或

P

U

P_U

PU 中添加或更新包含人物信息的子句。MSP 从用户

H

U

H_U

HU 和相似用户

H

s

i

m

H_{sim}

Hsim 的对话历史中派生出用户角色

P

U

P_U

PU。与查询

Q

Q

Q 无关的历史记录会被过滤掉。从剩余的历史记录中,基于

Q

Q

Q 和历史记录之间的注意力权重选择前 k 个 token。DHAP 将

H

A

H_A

HA 编码为隐式代理角色

P

A

P_A

PA,并从

H

A

H_A

HA 中提取词汇构建个性化词汇表。在解码过程中,DHAP 在这种个性化词汇表和通用词汇表之间切换。

● IUPD (Cho等人,2022)和 CLV (Tang等人,2023)都通过条件变分推理(CVAE)训练对来自 D D D 的隐式用户角色进行建模。CVAE已被用于对话生成,以解决为单个查询产生不同回答的挑战。它还有助于在各种条件下生成回复(Sohn等人,2015;赵等人,2017;Song等人,2019;陈等,2022)。【注:不包括在本工作中,因为它们不是专门为个性化对话生成而设计的】

● IUPD 提出了角色隐变量 Z P Z_P ZP 和因子隐变量 Z α Z_α Zα,以及特殊标记 t o k P tok_P tokP 和 t o k α tok_α tokα 作为输入。 Z P Z_P ZP 变量捕获了 P U P_U PU 的潜在分布,从而将上下文 C C C 与回复 R R R 联系起来。同时, Z α Z_α Zα 衡量了在 C C C 下 Z P Z_P ZP 的角色信息对 R R R 的影响程度。回复生成表示为: p ( R ∣ Z P , Z α , C ) = p ( R ∣ Z P , Z α , C ) p ( Z P ∣ C ) p ( Z α ∣ Z P , C ) p(R|Z_P, Z_α, C) = p(R|Z_P, Z_α, C)p(Z_P |C)p(Z_α|Z_P, C) p(R∣ZP,Zα,C)=p(R∣ZP,Zα,C)p(ZP∣C)p(Zα∣ZP,C),其中 p ( R ∣ Z P , Z α , C ) p(R|Z_P, Z_α, C) p(R∣ZP,Zα,C) 是生成器, p ( Z P ∣ C ) p(Z_P |C) p(ZP∣C), p ( Z α ∣ Z P , C ) p(Z_α|Z_P, C) p(Zα∣ZP,C) 是先验网络。对于 Z P Z_P ZP,它的先验网络和识别网络的输入将变量的 token 与条件相结合,即 [ t o k P , C ] [tok_P, C] [tokP,C] 和 [ t o k P , P ] [tok_P, P] [tokP,P]。对于 Z α Z_α Zα,它们是 [ t o k α , Z P , C ] [tok_α, Z_P, C] [tokα,ZP,C] 和 [ Z α , P , R ] [Z_α, P, R] [Zα,P,R]。

● CLV 还提出了角色隐变量 Z P Z_P ZP 和回复隐变量 Z R Z_R ZR。假设 Z P Z_P ZP 和 Z R Z_R ZR 是独立的。回复生成公式为: p ( R ∣ Z P , Z α , C ) = p ( R ∣ Z P , Z α , C ) p ( Z P ∣ C ) p ( Z P ∣ C ) p(R|Z_P, Z_α, C) = p(R|Z_P, Z_α, C)p(Z_P |C)p(Z_P |C) p(R∣ZP,Zα,C)=p(R∣ZP,Zα,C)p(ZP∣C)p(ZP∣C)。与 IUPD 相比,CLV 对 Z P Z_P ZP 的先验和识别网络利用了 Q Q Q 和 [ Q , P ] [Q, P] [Q,P]。对于 Z R Z_R ZR,输入是 Q Q Q 和 [ Q , R ] [Q, R] [Q,R]。

● 请注意,尽管 UA-CVAE(Lee等人,2022)也使用 CVAE,但它们在推理时将人物角色

P

A

P_A

PA 作为输入,如第 3.2.1 节所述。

3.2.5 数据缺乏(Data Scarcity)

● 如数据集部分(第 2 节)所示,基于角色的众包数据集通常具有更多的对话上下文,但因其有限的大小而引人注目。数据增强是解决数据稀缺问题的一个天真的答案。D (Cao等人,2022)是一种与模型无关的方法,纯粹操纵数据【注:不包括在本工作中,因为它们不是专门为个性化对话生成而设计的】。他们只保留了与角色相关

(

Q

,

R

)

(Q, R)

(Q,R) 的对话,删除了

R

R

R 不涉及的无关

P

A

P_A

PA,并通过 BERT、GPT2 和反向翻译技术将与角色相关的对话数量增加到 1.8 倍,将角色数量增加到 3 倍(Sennrich et al., 2016)。虽然没有使用 NLI 数据进行训练,但预训练的 NLI 模型已被广泛用于判断增强的

P

^

A

\hat P_A

P^A 和

R

^

\hat R

R^ 之间的一致性,以及评估增强的

Q

^

\hat Q

Q^ 和

R

^

\hat R

R^ 之间的一致性。

● 数据稀缺还引发了分布外(out-of-distribution,OOD)人物角色的问题。也就是说,有限的数据为代理提供了受限的角色 P A P_A PA,因此,与某些现实世界查询相关的角色可能在 P A P_A PA 中不存在(Liu等人,2022)。为了解决这个问题,Liu等人(2022)提出了基于 NLI 模型从外部角色池中检索未见过的角色。

● 然而,即使提供了看不见的角色,模型也很难基于分布外的角色,即长尾问题(Liu et al.,2022)。GME(Wu et al.,2021a)通过在原始回复中屏蔽角色片段(persona-spans),并重新生成以 P O O D P_{OOD} POOD、 Q Q Q 和屏蔽回复为条件的回复,在推理期间强制对看不见的角色 P O O D P_{OOD} POOD 进行接地,并生成基于 P P P。

3.3 大语言模型和语境学习(Large Language Models and In-Context Learning)

● 鉴于 ChatGPT 的日益突出,本文研究了大型语言模型(LLMs)和上下文学习对个性化对话生成的影响。如 Salewski 等人所示(2023);Jiang et al. (2023), LLMs 可以反映提示中提供的人物角色或人格特质,在相应的人格测试或写作或推理等任务中明显可见。最近的工作促使 LLMs 成为多智能体仿真或协作的各种角色(Chen等人,2023c;Qian等,2023;Park等人,2023;王等,2023b)。Tu等人(2023)提出了基于 MBTI 个性的 ChatGPT 来创建角色之间的对话数据集。Chen等人(2023a)使用扩充到原始对话上下文的人物角色信息对自己的 LLM 进行了预训练,并证明提出这样的模型可以提高智能体的人物角色一致性。

● 虽然人们热衷于使用 LLMs 的提示来为它们注入人物角色,但评估通常侧重于分配任务的成功率,而忽略了 LLMs 生成的对话的质量。据我们所知,现有工作集中于赋予智能体角色 P A P_A PA,没有研究探索使用上下文学习来提取或建模未知用户角色 P U P_U PU。

4 评估(Evaluation)

● 个性化对话生成文献通常评估不同维度上生成的回复的质量。最常考察的维度包括流利性、多样性、连贯性和个性化。

4.1 流畅性(Fluency)

● 流畅性评价通常使用通用的生成指标。困惑度(Perplexity,PPL)通常被认为是流利的标志。此外,大多数工作都是衡量生成的回复与参考回复之间的相似性。最流行的相似度指标包括词法重叠指标(lexical overlap metrics),如 F1、BLEU (Papineni等人,2002)、ROUGE (Lin, 2004)、NIST (Doddington, 2002)、METEOR (Banerjee和Lavie, 2005)、chrF++ (Popović, 2017),以及基于表示的指标(representation-based metrics),如词袋嵌入得分(bag-of-word embedding score)(Chan等人,2019)和 BERTScore (Zhang*等人,2020)。其他指标如 CIDEr (Vedantam et al., 2015)也被使用。

4.2 多样化(Diversity)

● Distinct-1(Dist-1)和Distinct-2 (Dist-2) (Li et al., 2016)是被最广泛采用的多样性评估指标。第 3 节的 17 篇论文中有 12 篇在评估中包括 Dist-1 和 Dist-2。Entropyn (Zhang et al., 2018b)是来自句子的 n 元分布的熵,衡量经验 n 元分布的均匀性。重复率(Repetition Rate, Rep) (Zhou et al., 2023a)是一种用于评估句子层次多样性的方法,它统计了候选人中与真实值不同的相同回答的数量。通过比较候选回复的重复度,这个指标是专门为他们对候选回复的后过滤方法设计的。

4.3 连贯性(Coherence)

● 连贯性(Coherence)是指对话的逻辑性和有意义的连续性。连贯的回复确保对话有意义,并从上一个回合自然地展开。尽管已经提出了一致性评估指标(Ghazarian等人,2022;Ye et al., 2021),它们没有被用于第 3 节的论文中。许多研究忽略了连贯性的评价,认为上一节中描述的流利度指标也可以衡量对话的连贯性。

● Zhou等人(2023a)计算了上下文和回复的 TF-IDF 向量(Salton and Buckley, 1988)之间的余弦相似度,作为一致性评估的度量。连贯一致性得分(Coherence-Consistency Score,Coh-Con.Score) (Tang等人,2023)同时衡量了对话连贯性和角色一致性。它将查询

Q

Q

Q、回复

R

R

R 和角色

P

P

P 作为输入,并分别为以下场景分配 2、1、0:

(

P

,

R

)

(P, R)

(P,R) 和

(

Q

,

R

)

(Q, R)

(Q,R) 都需要,只需要

(

P

,

R

)

(P, R)

(P,R),否则。

● 话语蕴涵得分(Utterance Entailment score,UE-Score) (Lee等人,2022)计算话语和回复之间的 NLI 得分作为一致性得分。

● 虽然 Coh-Con.Score 和 UE-Score 都利用了 NLI 模型,预训练数据和骨干网络不同。而 Coh-Con.Score 使用了 RoBERTa (Liu等人,2019)并在 Dialogue NLI 数据集(DNLI)上进行训练(Welleck等人,2019),并在 ConvAI2 和百度 PersonaChat 上进行微调,作为英语和汉语的 NLI 模型,UE-Score 在 SNLI 数据集上微调 BERT (Bowman等人,2015)。

4.4 个性化(Personalization)

● 个性化可以从一致性和覆盖度两个方面进行评估。

● 一致性反映了生成的回复

R

R

R 是否与给定的个人信息

P

P

P 一致。C-Score (Madotto等人,2019)在 DNLI 上对 BERT 进行了微调,并分别为蕴含、中性和矛盾分配了 1、0 和 -1。一个话语的最终 C-Score 是所有角色的总和:

C-Score(R)

=

∑

i

NLI

(

R

,

P

i

)

\text{C-Score(R)} =\sum_i \text{NLI}(R, P_i)

C-Score(R)=∑iNLI(R,Pi)。(Wu et al., 2021a)中提出的 P-Score 实际上与 C-Score 相同。一致性分数(Consistency Score)(Tang等人,2023)将 C-Score 中的 3 个类别减少为二分类,即将 1 分配为蕴含和中性标签,将 0 分配为矛盾标签。

● Li et al.(2020)首先指出了包含对话的困惑度(PPL)要低于矛盾对话。在此基础上,BoB (Song等人,2021)报告了蕴涵和矛盾对话的 PPL,以及它们的减法,称为 Delta Perplexity,以突出模型区分蕴涵和矛盾的能力。

● 覆盖率(Coverage) 显示生成的回复中反映了多少给定的个人信息。Persona-F1(Lian et al., 2019)由

R

R

R 和

P

P

P 之间的非停用词单字集合的重叠度确定,Persona Coverage(Song et al., 2019)量化了

R

R

R 和

P

P

P 之间的 IDF-weighted 单词重叠度。Persona Distance(Cho et al., 2022)定义为

R

R

R 和

P

P

P 的关键词之间的平均 word2vec 的余弦相似度,其中关键字由去除停用词后的词频决定。

5 讨论(Discussion)

5.1 数据集(Dataset)

● 基于人物角色的数据集的收集成本很高,并且因其有限的大小而引人注目。它们也被认为是人为的,因为注释者扮演给定的角色,而不是像他们自己。有限的大小还会导致 3.2.5 节讨论的域外人物问题,限制了对真实世界场景的适应。

● 从社交平台爬取可以解决数据大小的问题,并提供来自人类的原始言论。然而,这些数据集的质量是有问题的。它们来自社交媒体上的帖子和评论,而不是自然的对话,因此每“对话”的平均回合数相对较低。此外,提取的人物角色可能并不总是与实际的讨论主题一致。用户也可能发布相互矛盾的声明,这使得推断一致的人物形象变得困难。一些情境或稍为短暂的陈述可能会被无意中提取(Mazaré et al., 2018)。

● 此外,模型的多样性也是一种约束,特别是在领域和语言上的差异,如第 2.2.2 节所述。多语言对话数据在捕捉不同文化背景的细微差别方面至关重要。例如,考虑到英语的低语境交流风格和日语的高语境性质之间的鲜明对比,仅在英语或翻译后的对话数据集上训练的模型可能无法有效地迎合日语语境。

5.2 方法(Methodology)

● 许多工作都基于这样的假设:查询 Q Q Q、回复 R R R 和角色 P P P 是相互依赖的,也就是说,假设这三个组件是相互关联的,其中一个组件的变化或变化可能会影响另外两个组件。然而,一些工作忽略了并不是所有的R都是个性化的,并不是所有的个人信息都应该反映在给定的 P P P 中。

● 此外,个性化对话生成的研究分为两个主流,每个都只对对话说话者中的一方进行建模,如第 3.1 节所述。未来的研究可能会探索同时对

P

A

P_A

PA 和

P

U

P_U

PU 进行建模,以实现更全面的个性化对话生成。

5.3 评估(Evaluation)

● 最近论文中采用的主要评价指标可能不够充分。主要是生成指标,特别是基于相似性的指标,用于机器翻译(MT)或摘要任务。然而,它们已被证明对评估复杂的开放式任务无效,如对话生成(Gehrmann等人,2023;Yeh等人,2021;Deriu等人,2021;Liu等,2016)。虽然已经提出了更符合人工判断的高级指标用于对话评估,但在所审查的研究中,尚未应用任何指标。

● 此外,每个研究都使用自己的数据预处理,在评估方法上可能有不同的实现,使不同模型之间的直接比较复杂化。我们提倡一种标准化的数据预处理和评估方法。这种一致性将使各模式之间能够进行更精确的比较,并确保根据统一的基准来衡量该领域的进展。

6 结论(Conclusion)

● 本文深入研究了个性化对话生成,涵盖数据集、方法和评估技术。该领域的基础数据集是 PersonaChat。现代数据集的规模已经扩大,增加了人物角色基础,现在涵盖了更广泛的领域、会话、模式和语言。Persona 通过描述、键值属性或用于跟踪过去对话的基本用户 IDs 来表示。主要的方法是:(1)将角色传授给代理并确保其一致性;(2)确定用户角色或为上下文选择正确的角色。解决的核心挑战包括保持一致性和一致性,适当地平衡人物角色与上下文,选择相关的个人细节,在没有直接提供时建模人物角色,以及导航有限的数据。对于评估,流利度、多样性、连贯性和个性化等因素是至关重要的,困惑度(PPL)、BLEU 和 Distinct-N 是常用的指标。个性化评估主要衡量人物角色的一致性和覆盖度。

● 最后讨论了这三个维度的局限性。数据集的主要问题包括它们的规模有限,对质量的担忧,以及在领域和语言方面的多样性不足。在方法论方面,关于角色、查询和回复之间的相互依赖关系的错误假设可能会带来挑战。我们主张在各种模式和基准中采用一致的评估标准,以有效评估对话。

● 我们将包括本文分析的相关作品在内的相关作品的出版场所和仓库信息汇编在附录的表 5 中。

7 参考文献(References)

99 篇

⭐️ ⭐️ 写于2024年11月21日 23:01 教研室工位

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?