不仅仅是体感,Intel重新定义了“感知计算”的定义

当人们大谈特谈体感开发技术的时候,似乎对于这项前景广阔的技术已经下了定义,即通过探测设备(如3D摄像头等),追踪人体的肢体动作,从而产生新的人机交互体验。

这的确是一个很酷的改变,人们发现利用微软Kinect在电视前手舞足蹈是件很有趣的事情,Xbox+Kinect黄金组合的大卖不仅证明了消费者在最短时间内接受了体感技术这个新鲜事物,另一方面也似乎让开发者认为下一代人机交互体验的发展只是局限于肢体感应。

如果说“体感计算”是指针对肢体动作进行数字跟踪的开发技术,那“感知计算”又是什么意思呢?

当我第一次看到“感知计算”这个名词的时候,我首先想到的是,这是Intel为推广自家体感计算技术或设备而推出的新噱头,只是为了区别于日趋平淡、不再赋有炒作意义的老概念而重新包装的。但仔细阅读了相关新闻报道后,才发觉我的理解是多么的片面。

著名的贝雷帽邓慕理(Mooly Eden,英特尔公司高级副总裁兼感知计算业务总经理,因经常戴一顶贝雷帽而得名)在IDF 2013中国区大会上曾经激情洋溢地介绍了Intel的感知计算技术概念,从这个介绍里,我们不难看出,Intel的感知计算技术追求的已不单单是依靠肢体感应来改变人机交互的体验,而是将通过视觉、听觉、触觉、语音,甚至感情和情境等多重感官方式,让计算设备能够感知人类的意图,从而实现人与设备间更为自然的交互,重塑计算体验。从这个意义上讲,“感知计算”这个名词更应该理解为“感触、知觉”,这听着是不是很科幻?没错,Intel的确迈出了面向未来的重要一步。

贝雷帽邓慕理将担负起Intel感知计算未来发展的重任

不得不说,这是一个伟大的设想,这将让我们每天面对的计算机成为我们真正的伙伴,想象一下,你的计算机将会感觉到你失落的表情,从而放出一首优美的歌曲来安慰你;当你来到一家支持电子点餐的餐厅,你可以通过语音打开菜单,你的眼球将指挥屏幕为你呈现每一道菜品,选好后,你只需眨一眨眼睛,或者挥一挥手,就可以完成点菜。

你也许已经从我简单的介绍和想象中感受到Intel感知计算强大的应用潜力。据悉,Intel也将在未来的超级本中嵌入感知设备。现在,开发者可以通过购买价值149美金的Creative生产的开发版摄像头抢先体验并尝试开发基于Intel感知计算技术的应用程序。

Creative生产的开发版摄像头,这个pose像不像机器人“瓦力”?

这款漂亮、小巧的摄像头功能十分强大,它由一个高清摄像头、一个深度传感器、双阵列内置麦克风组成,开发人员可以利用Creative摄像头与英特尔最新的2013 Beta版感知计算开发工具包(SDK)开发诸如近距离手势跟踪、语音识别、人脸分析和2D/3D对象跟踪等创新应用。

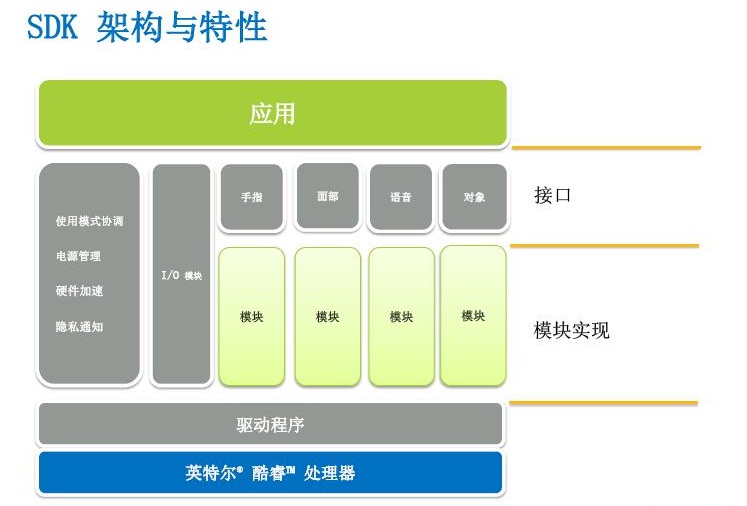

Intel感知计算开发工具包(SDK)架构与特性

搭建开发环境与测试

硬件安装。Creative摄像头安装十分方便,只需将USB连接上电脑,如果你想开始着手开发应用程序的话,还安装Intel感知计算开发工具包(SDK),否则它只能当作普通的摄像头使用。

SDK安装。开发者可以在http://software.intel.com/en-us/vcsource/tools/perceptual-computing-sdk下载最新SDK。安装SDK则需要满足以下环境:

硬件需求:

l Intel 32位或64位酷睿2处理器

l 500MB硬盘空间

l Creative感知摄像头

软件需求:

l Windows 7SP1或Windows 8操作系统

l MicrosoftVisual Studio C++ 2008 SP1或更高

需要大家注意的是,SDK安装共有11个part,非常缓慢,要提前做好思想准备呀。

安装完SDK,连接好Creative摄像头后,运行Capture Viewer程序,进行检测。非常重要的Depth(深度)测试感觉还是不错的,人从远至近的探测轨迹感觉较为平滑,没有发现较大的跳跃化的差异感。有效探测深度感觉大约为2米—2.5米以内(具体参数没有查到)。

在SDK中进行视频、色彩、深度、以及音频测试

Intel感知应用的开发主要针对近距离识别,这大大区别于微软的Kinect。这一点不难理解,微软的Kinect诞生就是为了与Wii、Sony抢夺娱乐市场,而Intel感知计算则是为了下一代人机交互体验的革命性创新而产生的。带给开发者最大的工作体验区别莫过于:Kinect的开发者往往需要在键盘上敲写代码,又要跑到2米之外去测试肢体感应,所以一般Kinect的开发工作最少需要同时两个人去完成;而Intel感知应用开发则要舒服的多,像平时一样坐在电脑前即可进行工作。

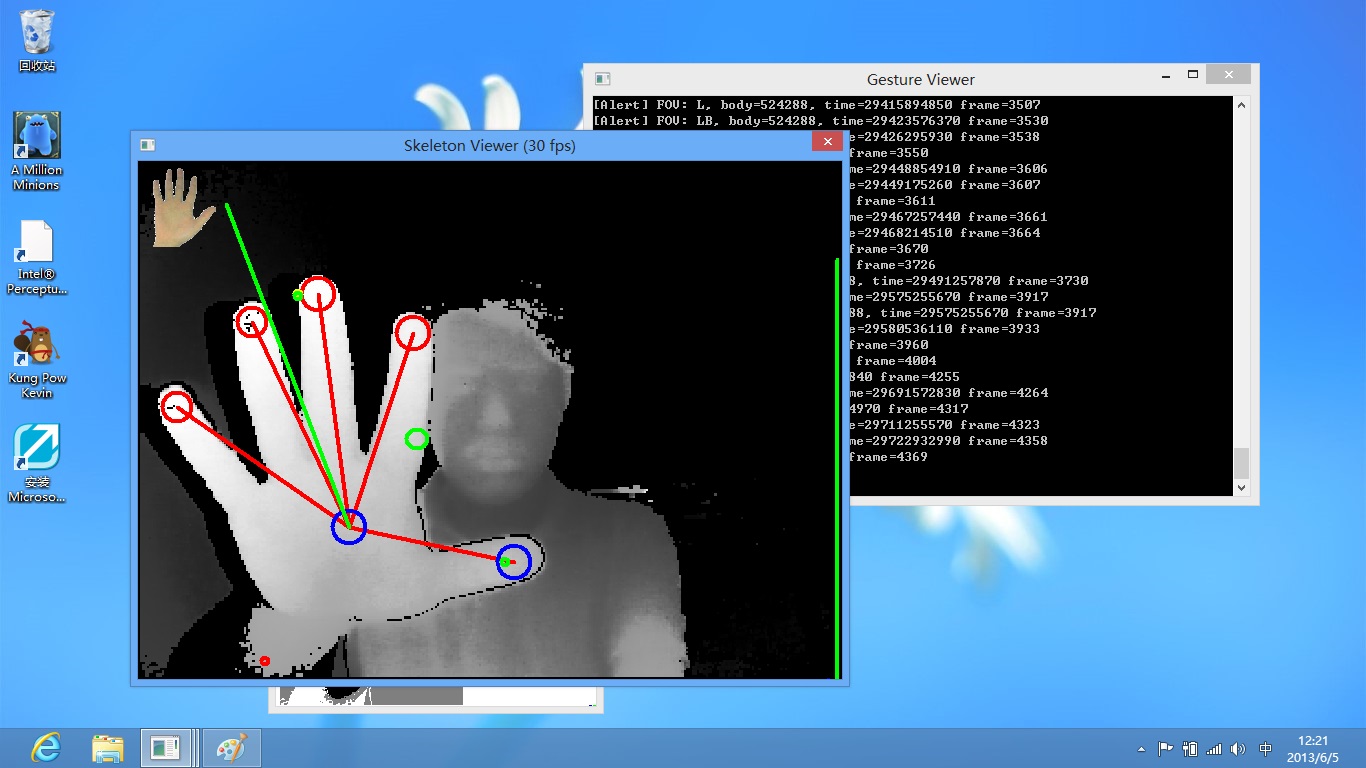

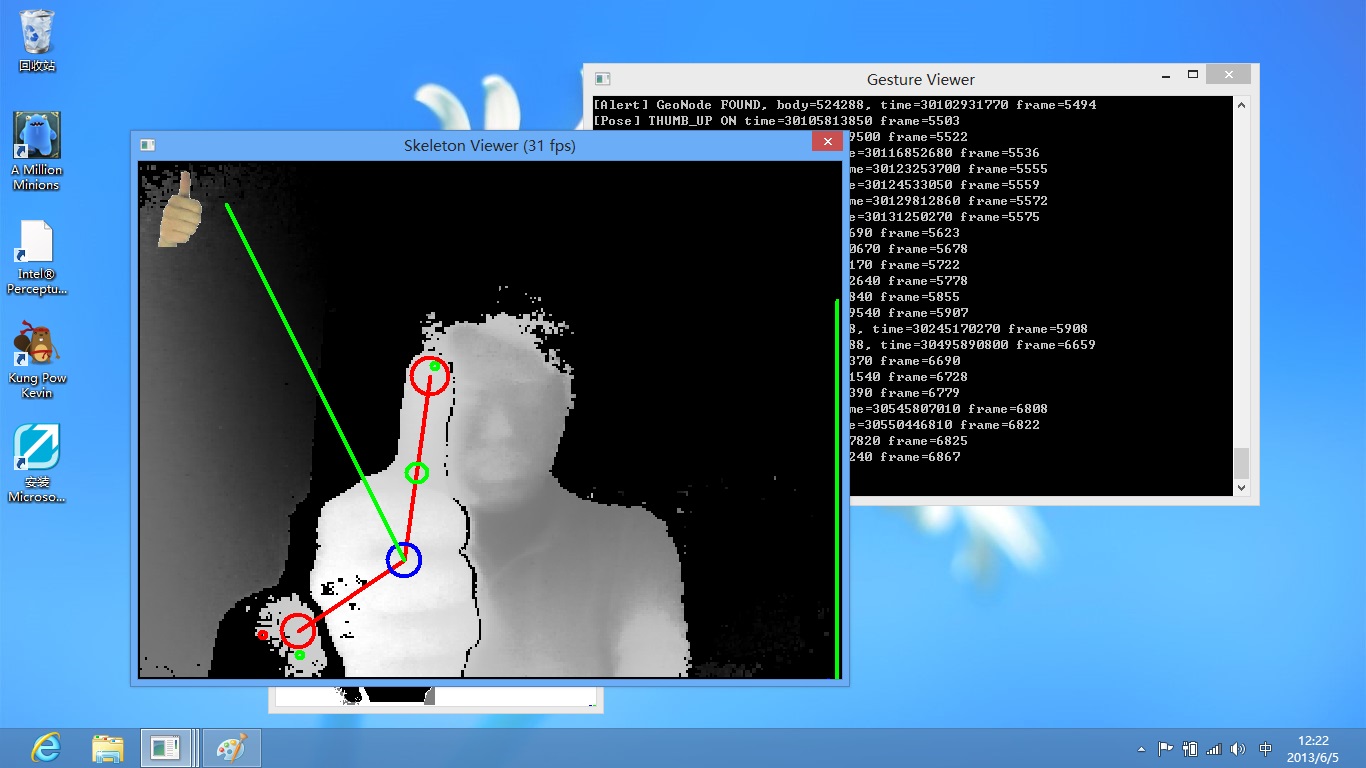

除此之外,开发者还可进行面部识别与手势跟踪的测试,这里着重说一下手势识别的测试,对于很多开发者来说,手势操控的应用可能是他们在Intel感知计算开发上的首选。

手势识别反应较为灵敏。通过测试可以发现,手势追踪通过几个维度可以识别出几种手势:手掌、象征赞扬的伸大拇指、象征胜利的伸出两根手指。识别时间瞬间完成,还是较为灵敏的。然而伸出3-4根手指,则无法识别。这一点开发者应当注意。

应用体验

Intel推出了多个应用Demo可供体验,其中不乏涉及到手势识别、人脸识别等多种应用,CSDN博客中有一篇高手的文章《Intel Perceptual Camera体验之旅》(http://blog.csdn.net/dscky/article/details/8933208)里面已经对应用体验的描述非常清晰,感兴趣的朋友可以去看看。

拉大旗,设重奖,Intel为感知计算召集开发者

Intel曾经在去年举办过一次感知计算大赛,令人惊喜的是,有一位中国的开发者(也许是团队)Liu Yanfan夺得了三个头奖中的一个。通过在优酷上的视频演示,我们可以欣赏到这个很酷的应用:

http://v.youku.com/v_show/id_XNTQ4ODkwODQw.html

这个叫做JOY-Gesture DynamicPhrase Synthesizer的应用解放了音乐人被键盘和鼠标束缚的双手,让他们重新回到为了音乐而激情四射的日子,音乐人可以使用双手控制音乐软件,调试效果完全随心所欲,今后在夜店中,我们也许就会看到挥舞双臂指挥音乐的新一代“DJ”了。

来自中国的JOY-Gesture Dynamic Phrase Synthesizer

今年的大赛已经在5月份拉开了大幕,Intel为此次大赛设立了重金,由此可见Intel对感知计算的未来是多么的重视。今年的大奖设置为10万美金巨奖+5万美金的市场推广支持费,除了之外,四个参赛分类里的第一名还可以获得7万5千美金+1万2千5百美金的市场推广费,其余奖项奖金也非常丰厚。有兴趣的开发者都可以看一下:http://intelperceptual.csdn.net/

大赛第一阶段非常简单,只是注册参赛与提交创意。我大概试了一下,如果你已经有了一个比较全面的应用创意,只需要花10分钟即可完成第一阶段的任务。所以,请大家多花一些心思,下载下SDK及使用文档(http://software.intel.com/en-us/articles/intel-perceptual-computing-sdk-getting-started-guide-version-10)后,好好研究思索一番,想想如何利用SDK完成一个创新、有趣的创意,然后以英文在官方网站填写内容,完成创意提交。

248

248

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?