核函数

在节中,我们的SVM分类器可以实现分类了

对于一个新的样本x,我们只需要计算这个新样本与训练集的內积即可,而且只会计算支持向量的內积,因为其他向量的=0。

实际上,对于一个线性不可分样本集,我们一般做法是将其映射到更高甚至无限高的维度空间,来在高维情况下进行SVM分类

例如

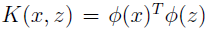

这时,我们用代替x即可。并令

其中

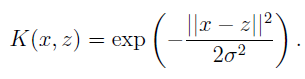

即被称为核函数

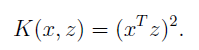

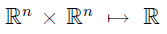

假设

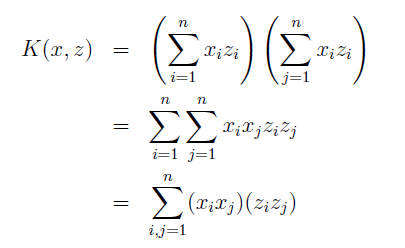

可以写成,

以n=3为例,

可以看出没有核函数,计算复杂度为,利用核函数只有

直观上来说,如果

还有一种常用的核函数是

定理(Mercer):给定K,

实际上核函数是一个比SVM更广泛的概念,只有遇到內积形式,都可以转换为核函数,从而在高维解决低维不可分问题。

软边界

正则化和不可分的例子(regularization and the non-separable case)

到目前为止,我们讨论SVM时认为数据是线性可分的, 把数据映射到高维空间一般会增加线性可分的可能性,但是我们不能保证一定可以.

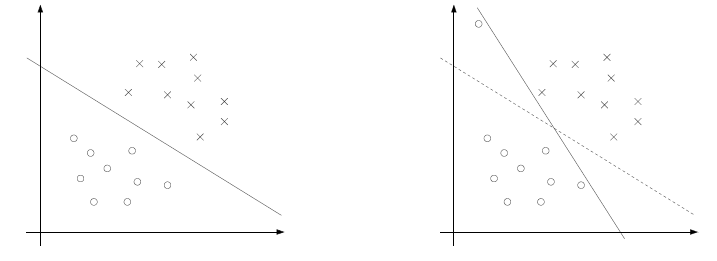

左图显示的是一个最优间隔分类器,但是如果在左上区域加上一个异常值,决定边界线会发生剧烈的变化,

导致分类器有更小的边界.

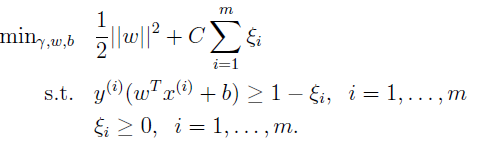

为了使算法能够处理非线性可分的数据集并且对异常值不会这么敏感, 修订优化问题如下,加了一个正则化因子:

因此,样本现在允许边界小于1.

其对偶问题为:

而且我们可以得出:

SMO算法

SMO = sequential minimal optimization

坐标上升(Coordinate ascend)

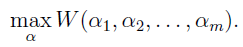

对于没有限制的优化问题:

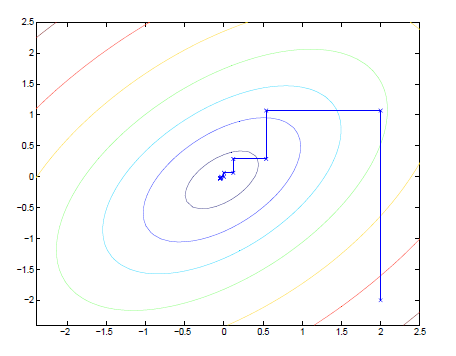

下图是坐标上升执行的一个过程:

但是我们现在解决的问题是有约束的

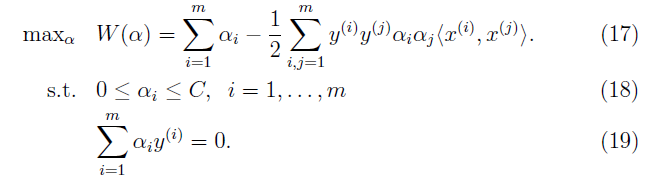

这是我们要解决的对偶问题:

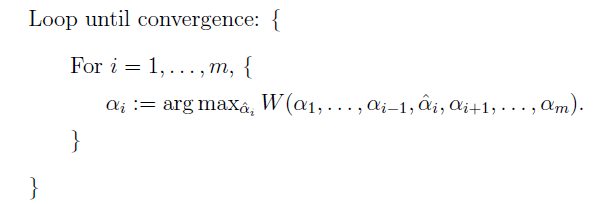

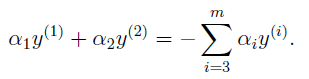

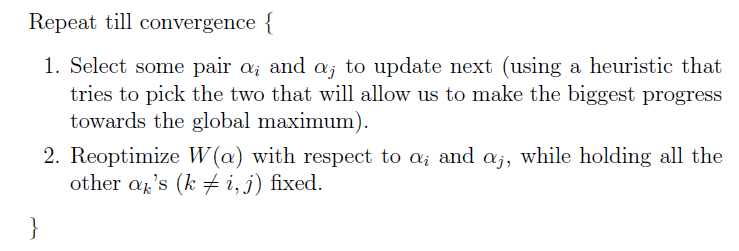

这里不能直接使用坐标上升算法,因此(19)的限制. 因此我们至少要同时改变两个才能满足限制. 因此:

SMO算法之所以高效是能够很高效的计算出ai,aj.

以改变a1,a2为例,

)所以

带入到W中,我们得到W关于一个二次函数,很容易求得

的最优值

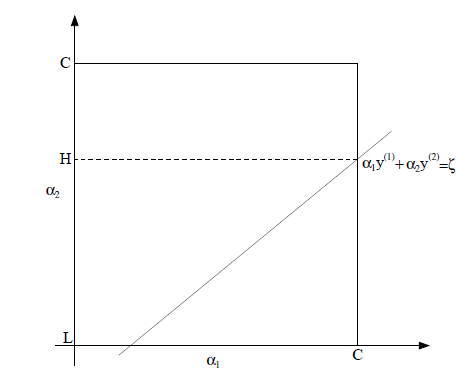

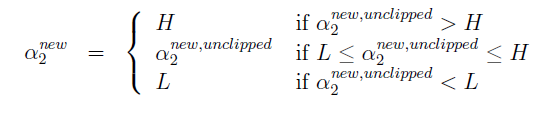

a1、a2的限制如下图所示:

得到:

之后计算出a1的值.

12万+

12万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?