2021/11/23 from Xwhite

离散信源及其信息测度(补充)

离散无记忆信源的扩展信源

信源模型

信源模型这里我们在上一篇文章已经叙述过了,在N次扩展哪里

信息熵

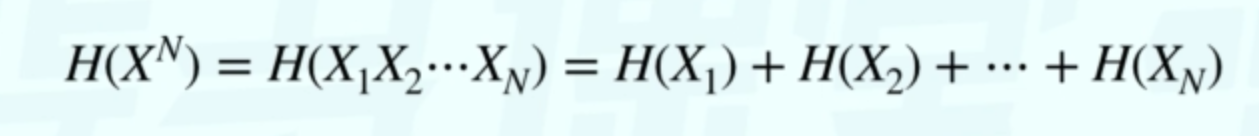

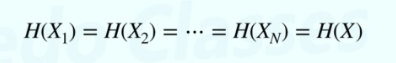

由于离散无记忆信源的扩展信源序列中前后符号的出现相互独立,彼此无关,因此有

符号序列中各符号取自同一个信源空间[X,P],故有

所以离散无记忆信源扩展信源的熵为H(XN)=NH(X)

离散无记忆信源扩展信源的熵和N长序列变量独立同分布的信源熵相同。

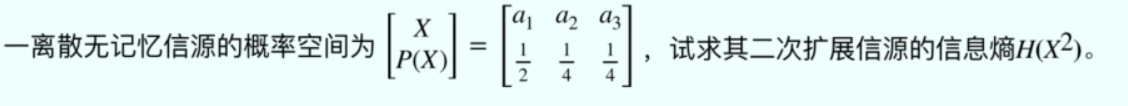

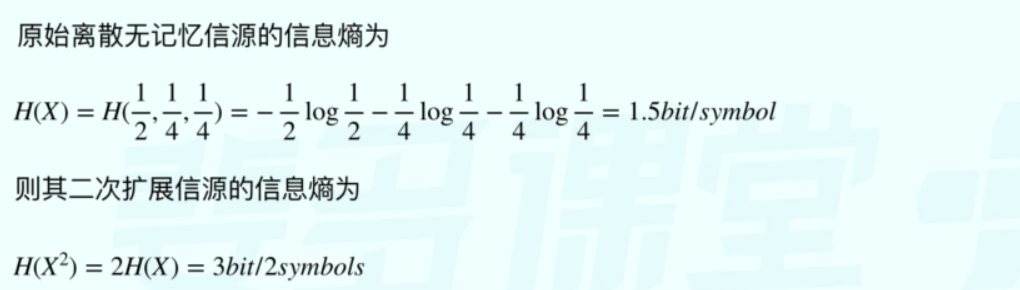

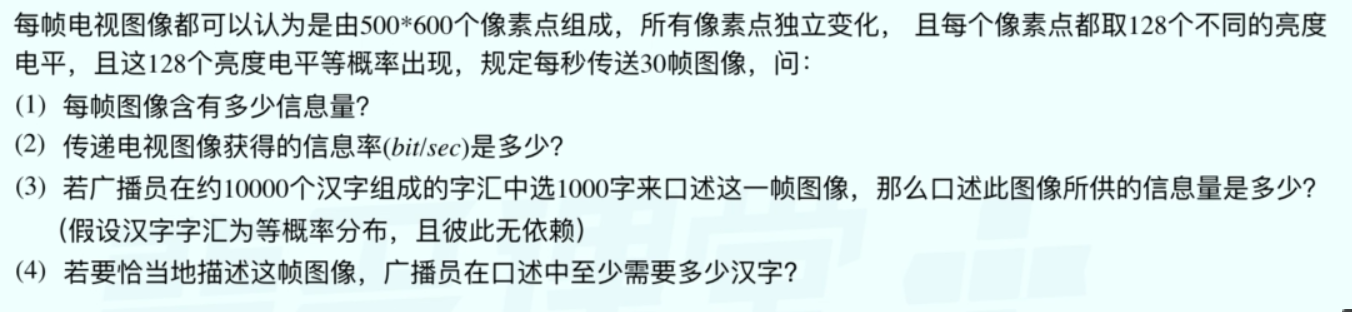

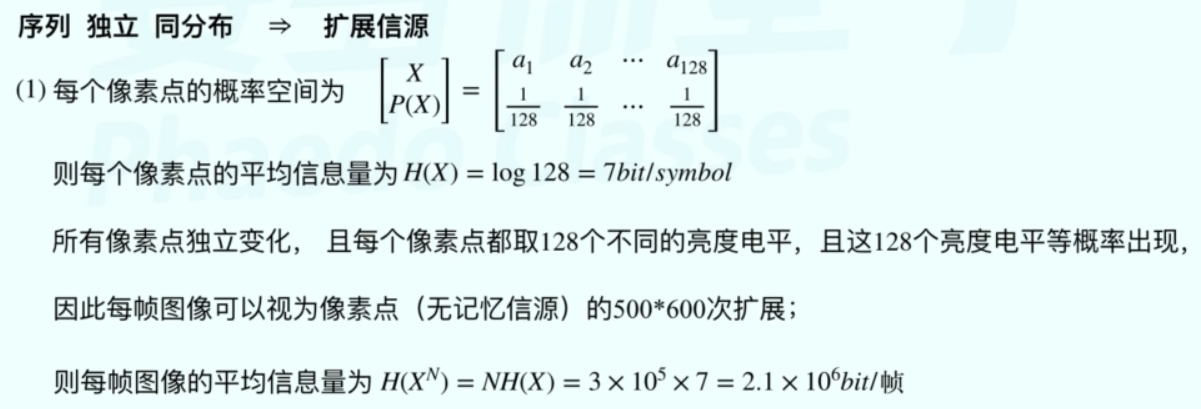

例题

例题

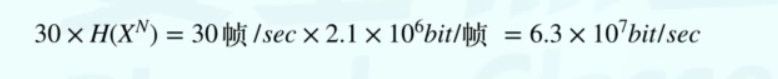

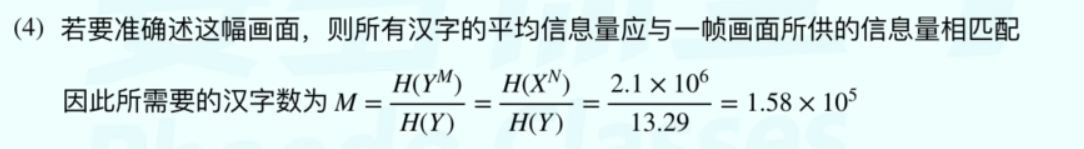

第二问,每秒传输30帧,而一帧又是2.1x106bit,所以信息率就是 帧/sec * bit/帧

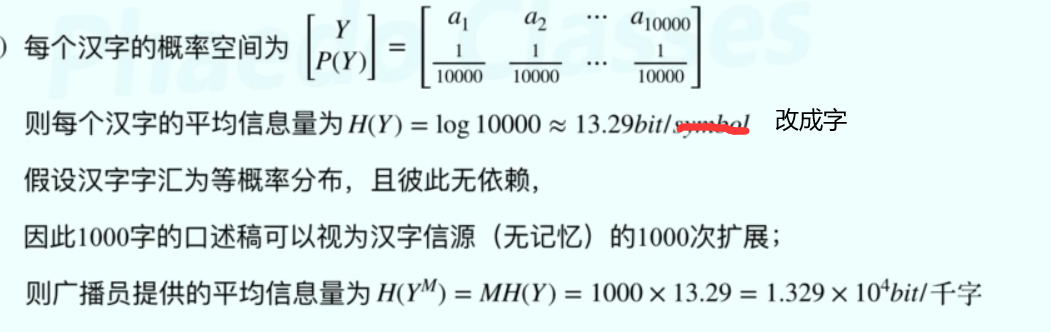

第三问,提供的信息量就是平均信息量=信源熵

离散平稳信源及极限熵(非重点)

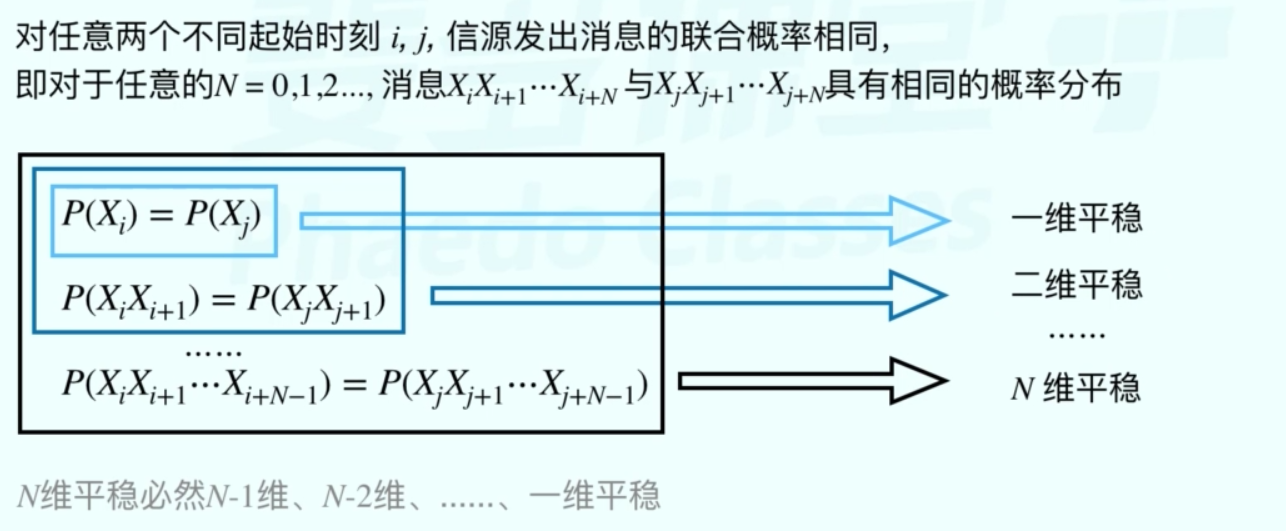

离散平稳信源

信源输出的随机序列中每个随机变量Xi都是取值离散的离散型随机变量,且随机变量的各维概率分布都与时间起点无关(平稳)。

N维平稳要在N-1维平稳的前提下发生。

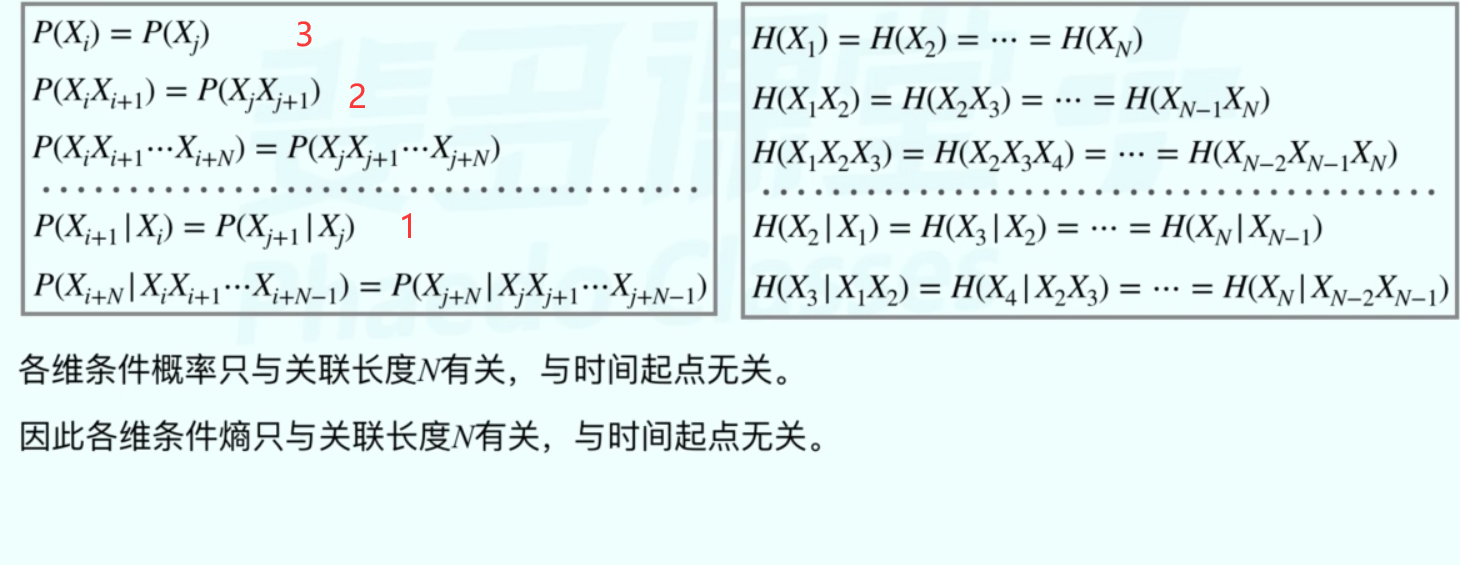

离散平稳信源的特点

这里说一下,1这个式子时利用条件概率公式 用2式 除以 3式得来的

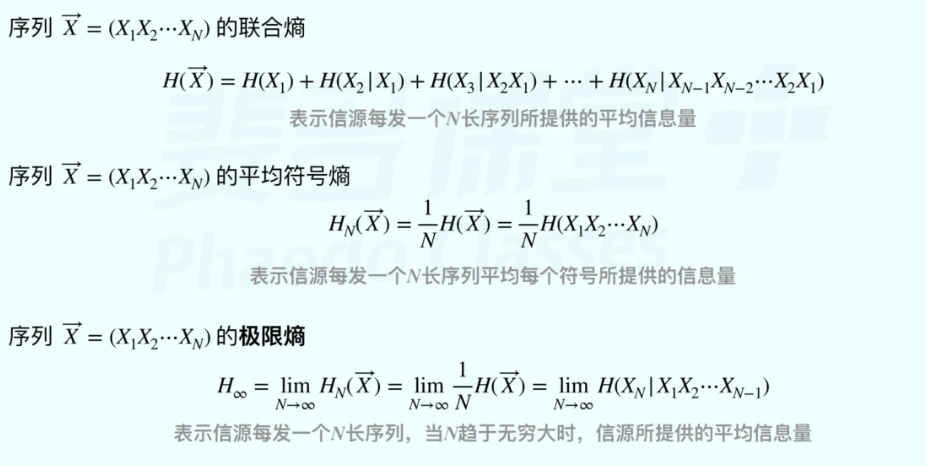

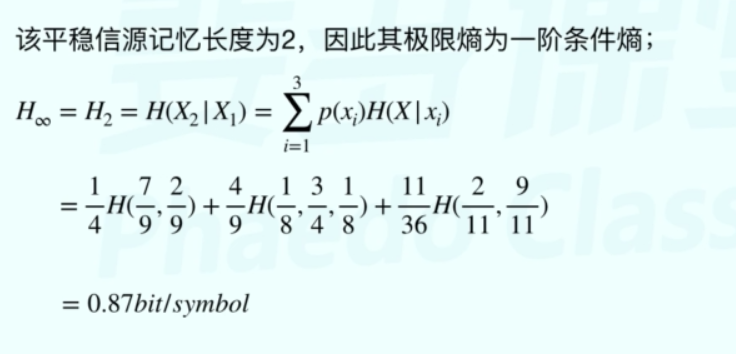

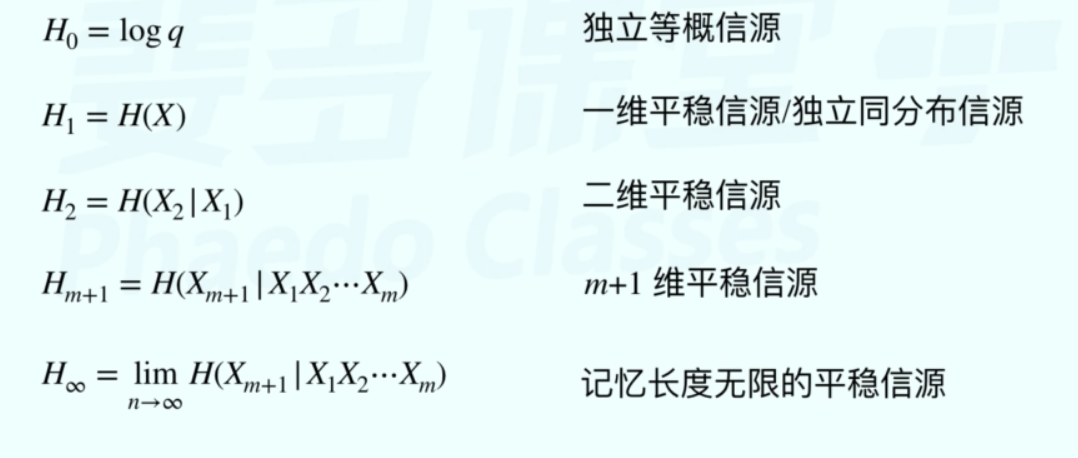

极限熵

离散平稳信源的三种信息测度方式(考虑信源的记忆性)

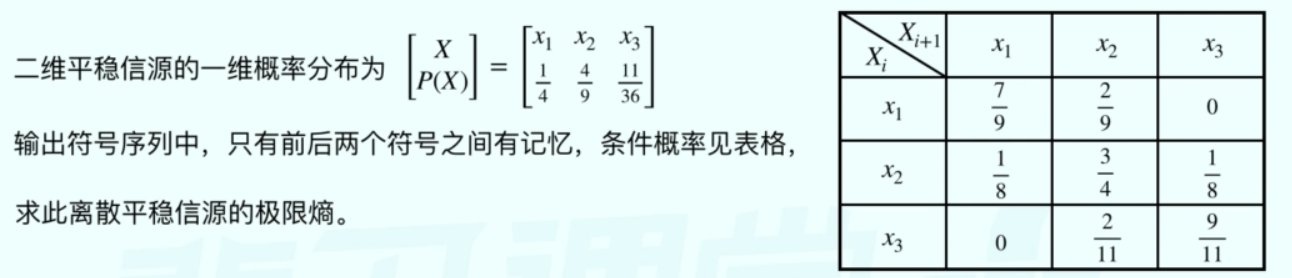

例题

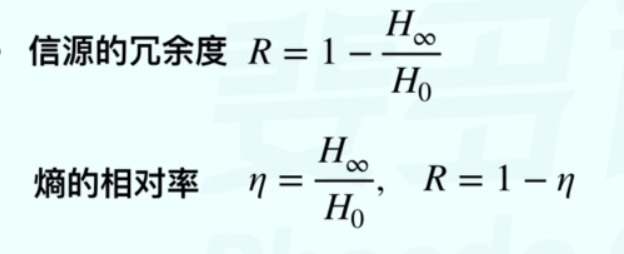

信息冗余度(了解)

信源的相关性与冗余度

- 信源的相关性 信源输出符号之间的依赖程度

熟记几个离散平稳信源的符号及其熵(设信源有q各符号)

- 冗余度:也称多余度或剩余度,表示给定信源在实际发出消息时所包含的多余信息

来自两方面 一是信源符号间的相关性,二是信源符号分布的不均匀性

862

862

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?