(一)安装Spark

1.下载安装包

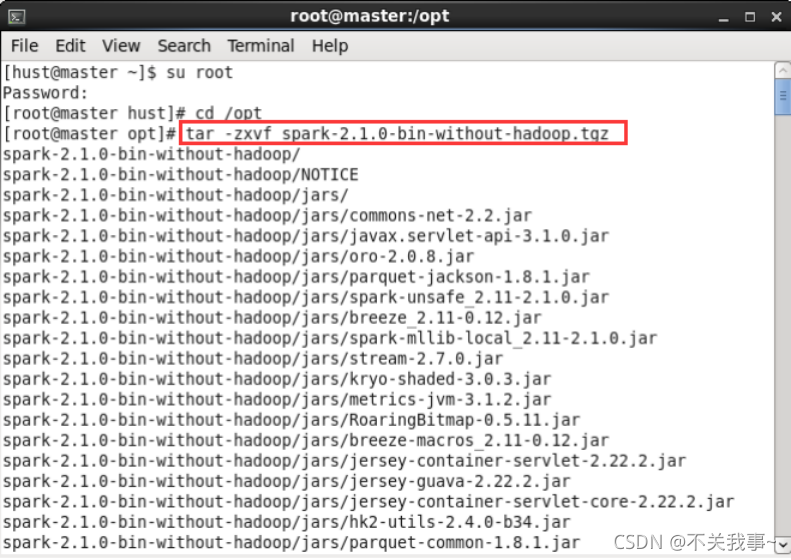

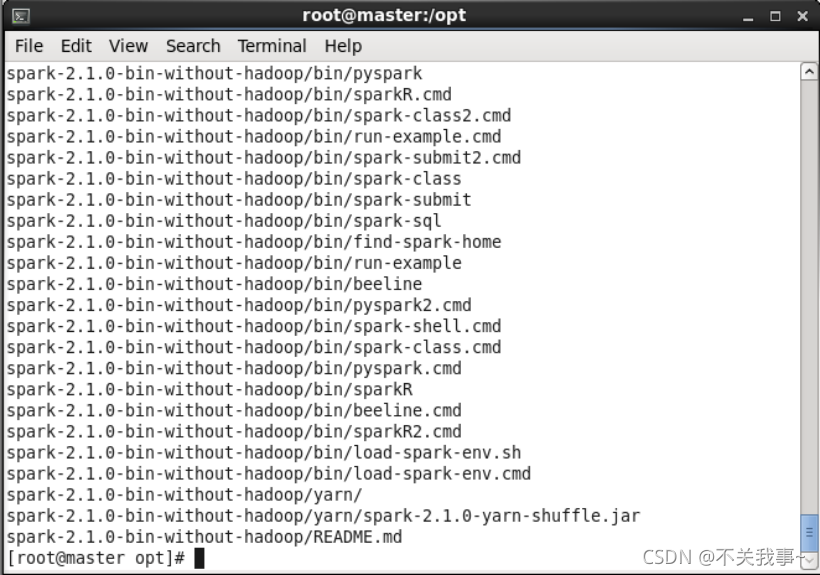

2.解压安装包

解压安装包spark-2.1.0-bin-without-hadoop.tgz至路径 /opt

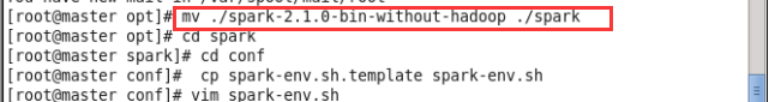

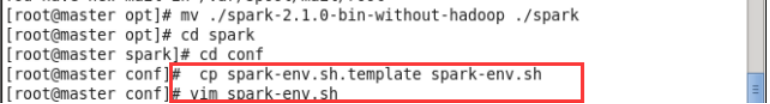

$ sudo mv ./spark-2.1.0-bin-without-hadoop/ ./spark # 更改文件夹名

3.修改配置文件

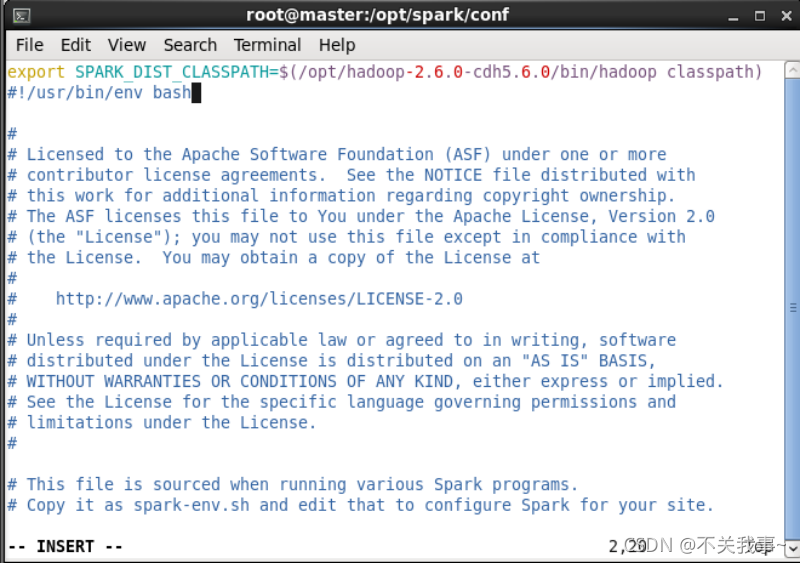

配置Spark 的classpath

cp ./conf/spark-env.sh.template ./conf/spark-env.sh #拷贝配置文件

使用vim编辑器打开spark-env.sh文件进行编辑,添加配置信息,在文件最后面加上如下一行内容:

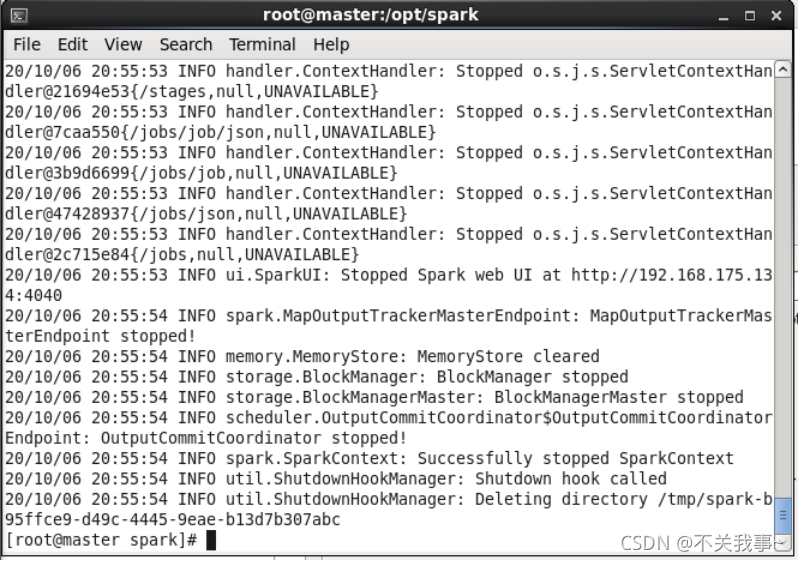

保存配置文件后,就可以启动、运行Spark了

若需要使用HDFS中的文件,则在使用Spark前需要启动Hadoop

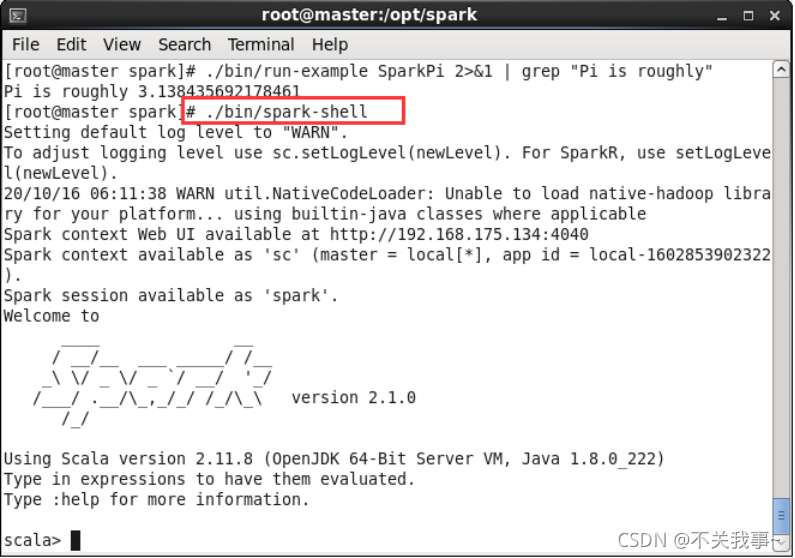

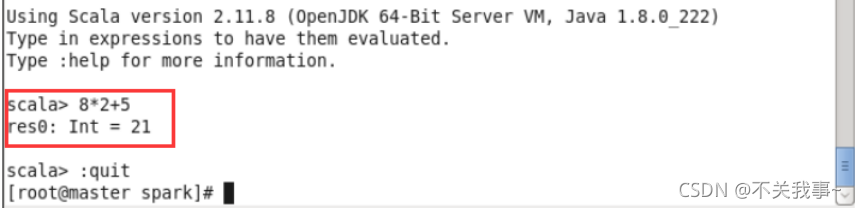

4.启动Spark

运行计算测试

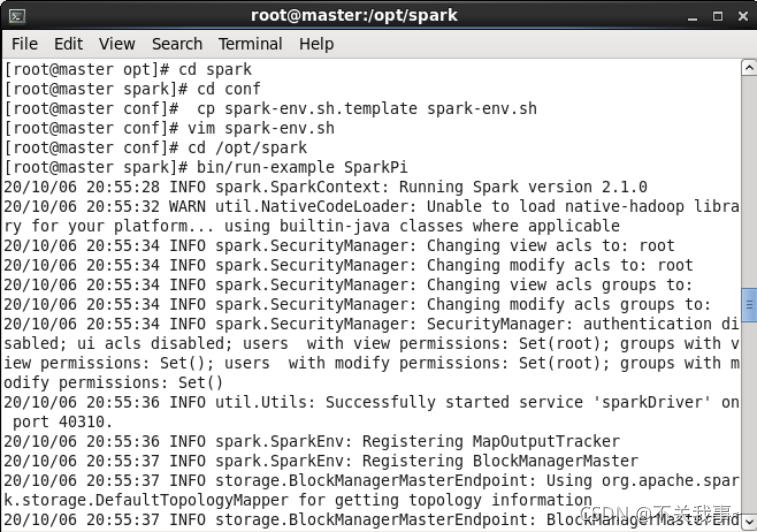

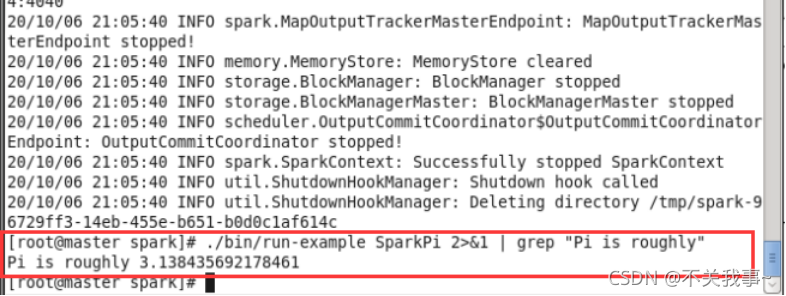

5.运行实例

运行spark自带的实例SparkPi,可以验证Spark是否安装成功

使用grep命令过滤:

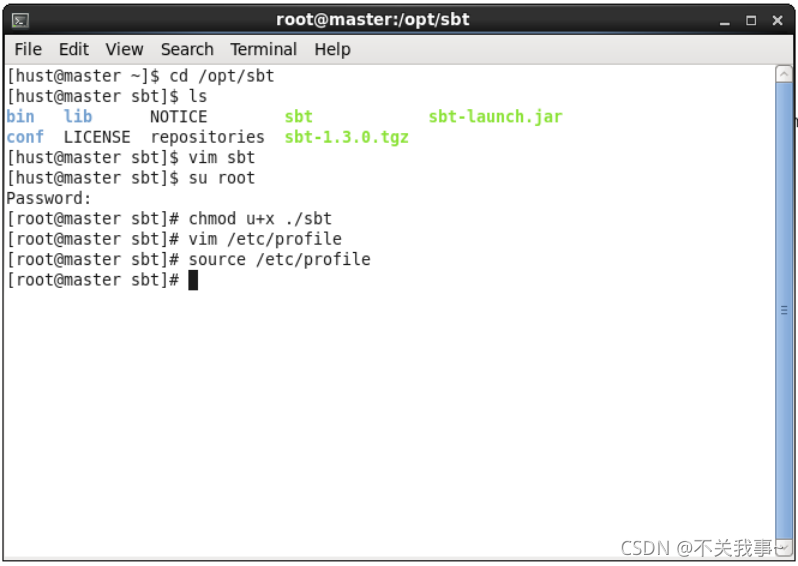

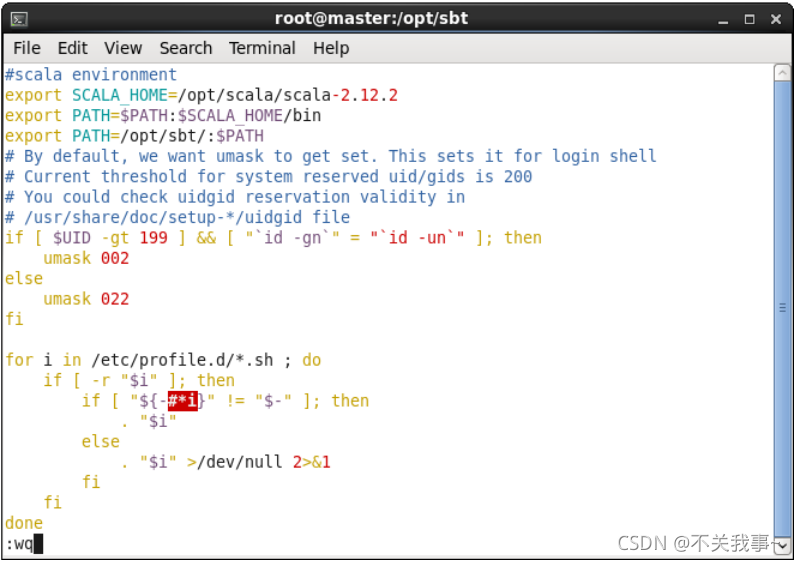

(二)安装sbt

sbt是一款Spark用来对scala编写程序进行打包的工具,Spark 中没有自带 sbt,需要下载安装

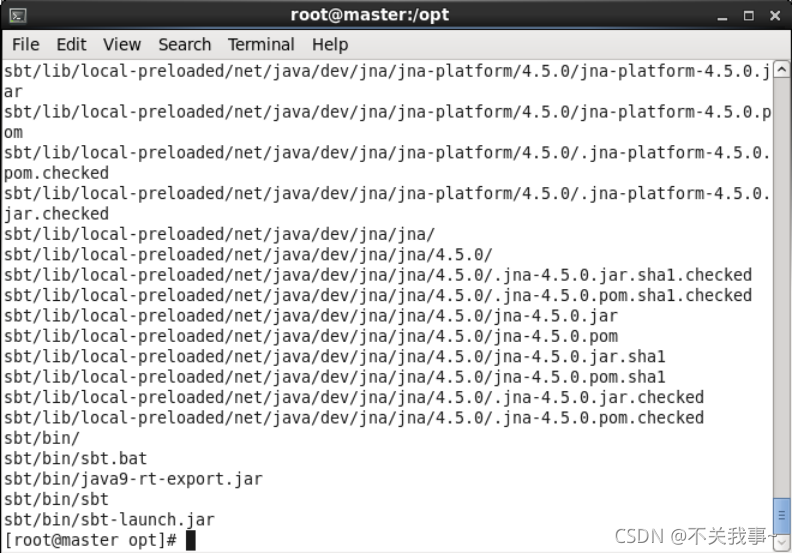

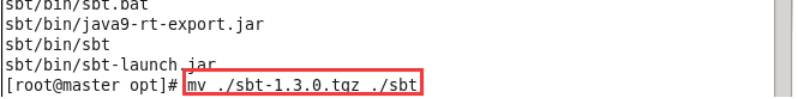

1.下载并解压安装包

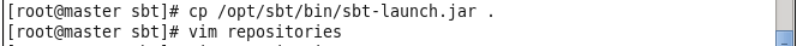

下载sbt安装包以后,执行如下命令拷贝至 /opt/sbt 中:

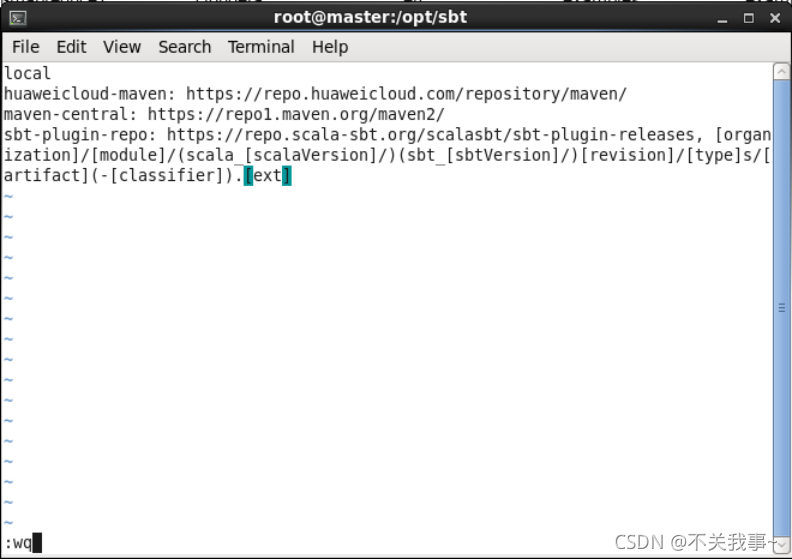

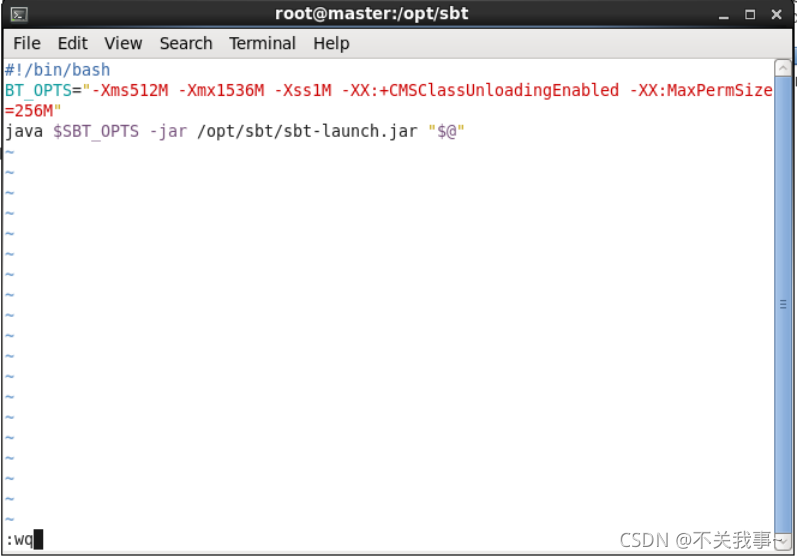

2.接着在 /opt/sbt 中创建 sbt 脚本(vim ./sbt),添加如下内容:

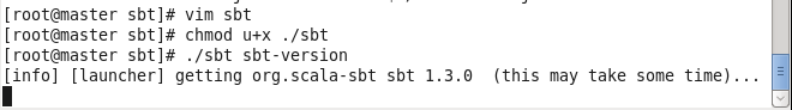

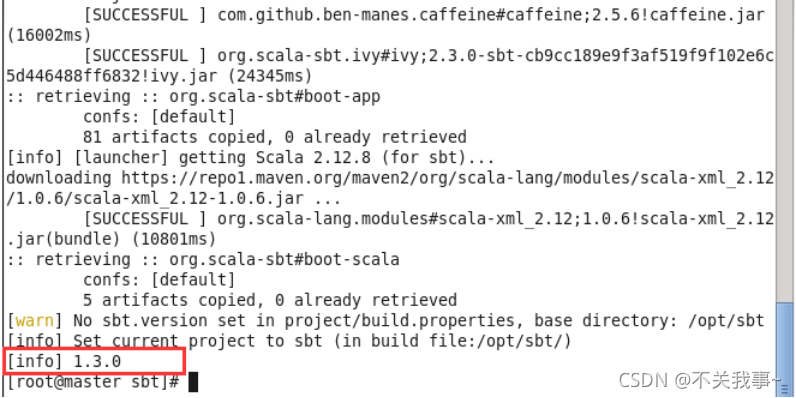

3.授权并查看sbt版本

4.打包代码

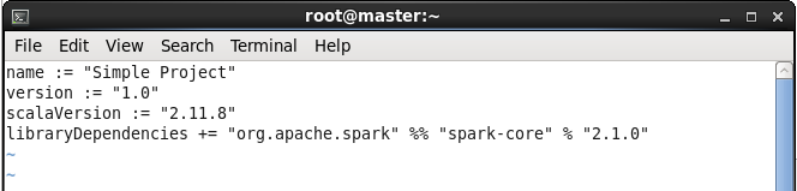

请在./sparkapp 中新建文件 simple.sbt(vim ./sparkapp/simple.sbt),添加内容如下,声明该独立应用程序的信息以及与 Spark 的依赖关系:

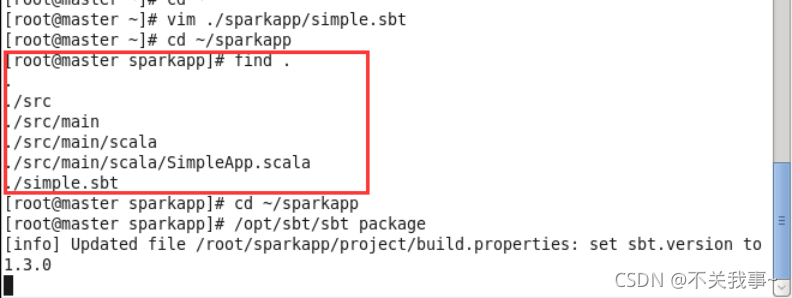

为保证 sbt 能正常运行,先执行如下命令检查整个应用程序的文件结构:

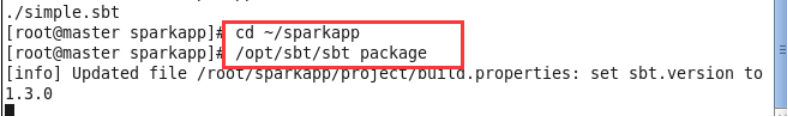

接着,我们就可以通过如下代码将整个应用程序打包成 JAR(首次运行同样需要下载依赖包 ):

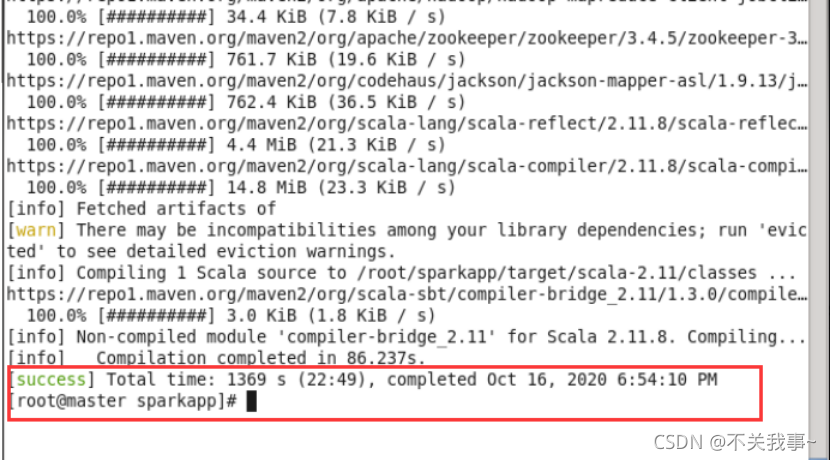

打包成功的话,会输出类似如下信息:

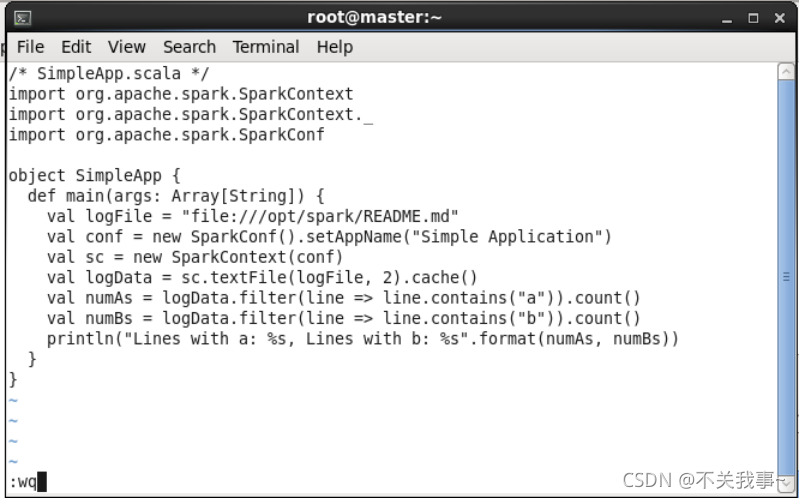

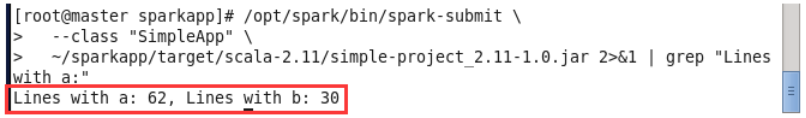

5.运行代码

运行结果

665

665

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?