树模型-CART决策树-撸清算法逻辑

CART决策树:

CART决策树,称为分类与回归树,是一种既可以进行分类,也可以完成回归任务的树模型。CART决策树是一种二叉树,内部节点特征取值表现为‘是’和‘否’。

在选择特征上,分类任务选择基尼系数最小化准则,回归任务选择平方误差最小准则。

回归树生成:

回归树生成的思路是最容易令人理解的,先从回归的角度来讲解。

假定给一个数据集合D,在数据集D所在的数据空间中,递归的将每个区域划分为两个子区域并决定每个子区域上的输出值,来构造二叉决策树。

算法流程:

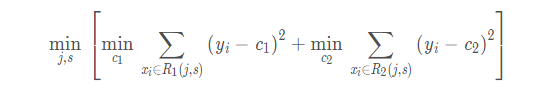

(1) 遍历变量j,对于固定切分变量j扫描切分点s,使得下列公式达到最小,从而找到相应的j和s。

举例说明: 对于切分变量J(年龄),他的数据点为[11,22,30,41,51,60,70,80,90,11,13]

首先,CART树依次选取切分点如[x<41,x>41],并将集合D划分为两个部分[11,22,30,41]和[51,60,70,80,90,11,13],将两部的均值C1、C2计算出来,之后计算两部分的平方差和,找到当前最小的平方差和对应的S,即找到了一个切分变量和切分点对(J,S)。最后对所有的切分变量J做如上的计算,找到所有最小平方差和对应的最优切分变量和最优切分点(J,S)。

(2) 用选择的最优切分变量和最优切分点划分区域,并决定划分后的区域的取值。这里的取值是取区域的平均值。

(3) 继续对上述两个子区域调用步骤(1),(2),直到满足停止条件,树的生成结束。

分类树生成:

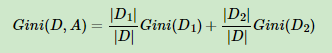

基尼系数衡量一个集合的不确定性,基尼系数越大,说明集合的不确定性越大。

算法流程:

(1) 根据每个特征A,对其可能的取值a,根据样本点对A=a测试为‘是’或者‘否’将数据集D分割为D1和D2两部分,利用下式计算相应的基尼系数。

(2) 在上步骤计算得到的所有特征A和它们的所有可能的切分点a中,选择基尼系数最小的对应的最优特征和最优切分点。依据最优特征和最优切分点,将数据集切分到两个子节点

(3) 对两个子节点递归的调用上述(1)、(2),直至基尼系数满足阈值或样本数量过少,就停止分裂。

CART决策树剪枝步骤:

1.从生成的决策树T0的低端开始不断剪枝,直到T0的根节点,然后形成一个子树序列{T0,T1,T2,T3……Tn};

2.利用独立的验证集,测试子树集合{T0,T1,T2,T3……Tn}中各子树的平方误差或基尼系数,其中最小的平方误差或基尼系数的决策树即为最优的。

6489

6489

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?