点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

在CVer微信公众号后台回复:ChatGPT,可以下载AIGC最全学习资料,学起来!

转载自:新智元 | 编辑:编辑部

【导读】连续多日的AI末日论大佬口水战,炮火还在持续升级。吴恩达、LeCun和Hinton、Bengio分站两队,集中开火当面对喷,可谓盛况空前。

关于AI风险监管的大佬论战,还在不断升级。整个晋西北已经乱成一锅粥了!

而美国政府刚刚发布的关于人工智能系统的首个法规,也正是导火索之一。

图灵三巨头关于AI监管必要性的大混战不断升级中,还引来了吴恩达的下场。

上一次看到几大巨头纷纷正面对峙的盛况,还是在上一次!

相对Hinton、Bengio等人呼吁加强对AI技术监管,否则可能引发危险的「AI末日论」,LeCun和吴恩达坚决站在另一边——

与其担心「AI引发世界末日」这种虚无缥缈的风险,AI强监管所带来的巨头垄断,才是从业者和政策制定者该真正关心的问题。

现在,各位支持AI末日论的大佬们,已经被划分派别了:

马斯克属于救世主情结;Hinton被划为世界级的怪人;Bengio则是无可救药的天真理想主义者。

Sam Altman获得的评语是:对AI风险表现出认真的态度,是推销的其中一环。

LeCun转发了华盛顿大学计算机教授Domingos的这个帖子,评论道:我需要忏悔——我不厚道地笑了。

扫码加入CVer知识星球,可以最快学习到最新顶会顶刊上的论文idea和CV从入门到精通资料,以及最前沿项目和应用!发论文强推!

白宫发布AI监管法规,引马斯克惊呼

美国最近新颁布的AI法规规定,对美国国家安全、经济、公共卫生或安全构成风险的AI系统开发商在向公众发布前,需要与美国政府分享安全测试结果。

符合以下条件的模型,都要受到监管——

(i) 使用超过10^26次整数或浮点运算算力训练的任何模型,或主要使用生物序列数据并使用超过 10^23次整数或浮点运算算力训练的任何模型;

(ii) 任何计算集群,拥有一组物理上共用一个数据中心的机器,通过100 Gbit/s以上的数据中心网络横向连接,并且理论上具有每秒10^20次整数或浮点运算的最大计算能力,用于训练AI。

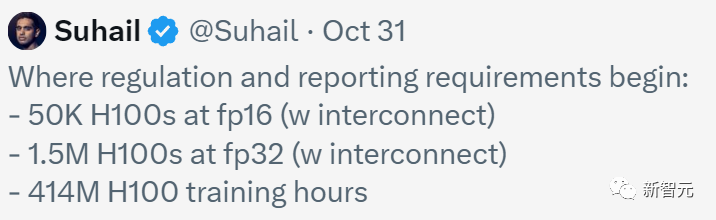

初创公司Playground的创始人Suhail Doshi把这些标准高亮出来,评论道:终有一天,我们会后悔对自己做了这样的事。

这条推文获得了LeCun的转发,甚至马斯克都在下面留言——的确有可能。

Suhail总结道,美国政府对监管和报告要求的起点是——

- fp16时为50K H100s(带互连)

- fp32处为1.5M H100s(带互连)

- 414M H100训练时数

大家都对这些阈值表示疑惑:太蠢了吧,这不会让算法效率的提高陷入困境吗?

有人发现了华点——白宫知道什么是浮点运算,什么是10^26吗?是谁在向他们提供信息,谁在幕后监管?

Hinton和吴恩达正式开呛

AI末日论的口水战,依旧在持续升级。

Hinton直接发推,点名吴恩达——

「吴恩达声称,AI末日论是一个大型科技公司的阴谋。可是和这个阴谋论相悖的是,我离开了谷歌,就是为了自由地谈论生存威胁。」

吴恩达则回怼道:我没说这是一个阴谋。

我没说这是阴谋。但我认为,对末日论的过度恐惧正在造成真正的伤害:

- 一些年轻学生不愿意进入人工智能领域,因为他们不想为人类灭绝做出贡献。- 关于危害的炒作也被用来促进全球范围内的不良监管,例如要求对大模型进行许可,这将粉碎开源,扼杀创新。

我相信你对AI灭绝人类的担忧是真诚的。我只是恭敬地不同意你的观点,并且认为它弊大于利。

同时,吴恩达还发表了一篇长文,表示自己对AI最大的担忧是,如果AI末日论被过度炒作,技术游说者就会促成更多压制开源、压制创新的法规被制定出来。

文章地址:https://www.deeplearning.ai/the-batch/issue-220/

在这篇长文下,Hinton立马赶来留言——

「所以,如果AI不受到严格监管,你对在未来30年内导致人类灭绝的可能性的最高估计是多少?如果你是一个真正的贝叶斯主义者,你一定能给出一个数字。我目前的估计是0.1。 我怀疑LeCun是<0.01。」

有许多人表示,Hinton曾在2016年就预言,DL将在5年内完全取代放射科医生。

实际上,工作市场对于放射科医生需求量愈来愈大。

对此,Hinton承认自己预测错了,但是AI已经在几种放射图像分析上媲美医生了。

看起来在几年内它就能常规地提供第二诊断意见,再过10年,它提供的第二诊断意见甚至会比人类医生的诊断更好。

LeCun在推文下评论:

你和Yoshua Bengio无意中正帮助那些想要把AI研究和开发锁起来,通过禁止开放研究、开放源代码、以及开放模型来保护自己业务的人。

从中期来看,这将不可避免地导致不良后果。

扫码加入CVer知识星球,可以最快学习到最新顶会顶刊上的论文idea和CV从入门到精通资料,以及最前沿项目和应用!发论文强推!

LeCun「迎战」Hinton

另一边,Hinton和LeCun也吵起来了。

Round 1,LeCun提问——

既然许多AI末日场景听起来都像科幻小说,那我就问一句:如果天网是开源的,《终结者》中的天网接管就会发生吗?

Hinton反讽道,让我们把核武器也开源了,让它们更安全。好人(我们)永远比坏人(他们)拥有更大的核武器,所以一切都应该没问题。

Round 2,LeCun表示,「好吧,这也算是『相互保证毁灭』这一理论背后的基本思想,不过算了吧。人工智能的目的是让人类变得更聪明,而不是摧毁整个城市。我看不出这个比喻有任何意义。」

站队Hinton

对此,支持Hiton的人认为,AI虽然还没有到达毁天灭地程度,但是所有公司真能做到开源吗?AI难道就没有扼杀人类创新力吗?

作为代表之一,马库斯表示,吴恩达在描述这件事的时候笔调太过宽泛。

其他网友也表示,AI本应帮助人类发现真理,而不是掩盖真相、让人成为奴隶。

然而,现在AI却被用来:

- 被用来控制我们大众,让一切都「个性化」(上瘾性强),导致文化和社会凝聚力的消亡

- 通过夺走工作机会让人感到无价值。

甚至,「AI末日派」已经发起了「#BelieveHinton」的话题,并开启了示威游行。

站队LeCun

You.com的首席执行官Richard Socher表示,LLM和核武器的区别在于,如果你不喜欢LLM的输出,你完全可以不关注它,但如果核弹落在你身上,你就很难忽视它了......这种区别,足以使这种类比站不住脚,不是吗?

Perplexity AI的首席执行官称,Hinton可能患有阿尔茨海默症,但仍不影响他在深度学习领域「AI之父」的声誉。

不过,这条推文随后就被他删除了,并对Hinton表达歉意。

我不同意你对AI存在风险的看法,并认为你在开源方面施加了更多规定和困难,无意中损害了AI初创企业的竞争格局。我是LeCun阵营的。

AI平台Metaspectral的首席执行官好奇问道,「Hinton,你究竟在谷歌看到了什么,让你如此惊恐?我只是想了解事情的来龙去脉。」

我个人在站在LeCun这边——我训练LLM并开源代码。我的一些模型甚至在MMLU和其他一些测试中击败了GPT-3.5。

除此之外,还有AI圈没有站队的大佬们,也对Hinton等人宣传AI危险的观点提出异议。

马毅教授此前曾表示,请停止传播关于当前AI有多么危险或神秘的错误信息了。我们已经知道,当前的技术相当原始和机械,从根本上说是不完整和有局限,远谈不上危险。大多数恐惧源自无知。

LeCun:幸好及时开源了 vs 马库斯:Meta很危险

关于开源的问题,LeCun非常自豪地转发了一名网友的评论——

我终于意识到,LeCun团队让Llama 2开源是多么重要!

A)以后可能就不合法了。

B)如果他们不这样做,可能我们永远都看不到开源的可能性(Llama2下游的所有工作),还会认为做LLM的权利只属于2到4个公司。

LeCun欣慰地解释道:业内对Llama 1(以及Meta之前的所有开源AI包,如PyTorch、DINO、SAM、NLLB、wav2vec等)的兴趣激增,让Meta领导层相信Llama-2开源的好处会远大于风险,并且让AI格局变得更好。

马库斯则开始呛起了小扎。

「我理解人们为什么会对开源AI持有不同看法。但我不理解大家觉得把人类的未来放在一个拥有巨大经济利益的亿万富翁手中,就是一个好主意。现在事情就在朝这个方向发展。」

他甚至发起了投票——关于AI风险的重大决定应该由谁做出?

A.相关领域专家

B.马克·扎克伯格

马库斯在评论中解释道,自己是担心Llama以某种灾难性的方式被滥用。

很快就有网友呛起他来:「所以Meta要开源,这样Llama就掌握在我们手中,而不是他手中了,就像Linux一样。」

别的网友也表示他过虑了,现在已经有多个开源模型,小扎本人也无法阻止他人做出更好的开源模型。甚至一家小初创公司的Mistral,已经获得比Llama更好的结果。

Bengio:我参与创造的AI未来,让我夜不能寐

这次大佬口水战中,虽没有Bengio本人的发言,但他曾多次公开表示自己对AI风险的担忧,与Hinton意见一致。

就在前几天,他本人发表了一篇文章「我参与创造的AI未来,让我夜不能寐」,自述对技术发展前景的焦虑。

文章地址:https://www.theglobeandmail.com/opinion/article-the-future-of-artificial-intelligence-a-future-i-helped-create-keeps/

大约十年前,深度学习开始被广泛应用,AI产业获得了巨大投资。

2019年,当与Geoffrey Hinton和Yann LeCun一起获得图灵奖时,Bengio甚至对AI为世界带来的巨大进步和创新感到自豪、乐观和兴奋。

但是,最近看到ChatGPT等大型语言模型的进步,让他意识到没有限制的AI发展,会带来巨大的风险。

事实上,重大的人工智能风险是我严重担忧的根源,让我夜不能寐,尤其是当我想到我们将留下一代人这样的遗产时。

他预测到,达到人类水平级别的AI可能在未来几年,或几十年内实现,但社会还没有准备好应对其带来的影响。

而现在,我们需要将重点放在避免AI的潜在危害上,比如强大的AI可能被利用进行虚假信息、网络攻击、生化武器设计等等。

另外,Bengio还呼吁各国政府应对AI带来的威胁采取干预措施。

他希望,各国能共同努力,在发展AI的同时保障人权和社会利益。

吴恩达:美国政府对AI的监管完全扭曲了

对于美国政府的新AI法规,吴恩达痛心疾首地表示:白宫对于《国防生产法》的使用(用于战争或国家紧急状态),已经从安全的角度完全扭曲AI的作用!

在他看来,虽然白宫的命令目前还没有扼杀初创公司和开源,但已经有这个苗头了。

比如条例中这句「开发任何对国家安全构成严重风险的基础模型的公司」。

他表示,AI就如同电力和加密一样,某种意义上是属于双重用途,既可以民用,也可以用于军事目的。但把民用AI和军用AI安全混为一谈,完全是错误的。

他认为,根据模型训练的计算阈值设置报告要求,也是错误的。这会扼杀开源和创新:

(i)随着AI的发展,越来越多的参与者(包括没有大科技公司合规能力的小公司)都会抵达这个门槛。

(ii) 随着时间推移,政府的报告要求会变得越来越繁重,就像税法一样。

在吴恩达看来,监管AI的正确位置,是在应用层,比如核保软件、医疗应用、自动驾驶、聊天应用等AI应用。但是,给基础模型开发增加负担,会减缓AI的进步。

发长文呼吁

在最新的博客中,吴恩达表示,目前对于AI毁灭人类的讨论不仅很模糊,而且结论也只是「有可能发生」。

我们无法证明AI不会导致人类灭绝,就像无法证明从地球发射的无线电波不会导致外星人找到并消灭我们一样。

有些人可能的确是在为AI担忧,但不可否认的是,很多人的目的就是「钱」:

1. 个人可以博得关注,从而赚取演讲费或其他收入

2. 组织可以筹集资金,来对抗他们自己制造的幽灵

3. 立法者可以通过对科技公司采取强硬措施,来获得竞选捐款

诚然,AI远非完美,为了让它变得更安全、更负责任,我们还有很多工作要做。

但AI已经为人类带来了巨大的利益,而且未来还会有更多。

现在我们要做的,就是确保未经证实的恐惧不会阻碍这一进步。

科技巨头安全评级,Meta最低

有趣的是,前段时间,英国的人工智能学者对全球科技公司的「AI安全最佳实践」进行了评级。

结果显示,Meta评级最低,仅有48%。而Anthropic是这些公司中得分最高的。

对于Meta评分最低的原因,还是在于「开源」了许多模型。

因为开源模型的开发者们,通常对下游的使用监管很少。

但是,通过API发布模型,为前沿人工智能组织提供了更多手段来解决模型滥用问题。

参考资料:

https://twitter.com/geoffreyhinton/status/1719447980753719543

https://twitter.com/ylecun/status/1719432967729369577

ICCV / CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:ICCV2023,即可下载ICCV 2023论文和代码开源的论文合集计算机视觉和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer444,即可添加CVer小助手微信,便可申请加入CVer-计算机视觉或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer444,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集近万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?