点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer2233,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

该工作由南洋理工大学陶大程教授团队与武汉大学罗勇教授、杜博教授团队等合作完成。

近些年,多模态大语言模型(MLLMs)在视觉问答、推理以及 OCR 等任务上取得了显著的成功。然而,早期的 MLLMs 通常采用固定的分辨率(例如 LLaVA-v1.5 将输入图像缩放为),对于输入图像为高分辨率图像(例如 8K 分辨率)会导致图像变得模糊,损失大量有效的视觉信息。

为了解决上述问题,目前的解决方案分为三类:

1. 基于裁剪的方法:对于高分辨率图像裁剪成多个子图,每个子图分别通过视觉编码器提取视觉特征后再进行拼接。然而对于 8K 的图像,假设采用 ViT-L/14 就需要接近 300K 的 visual token 长度,这对于目前大语言模型(LLM)的长上下文建模能力是一个巨大的挑战。

2. 采用处理高分图像的视觉编码器:使用能处理更高分辨率图像的视觉编码器代替基于 CLIP 训练的 ViT。然而,对于 8K 分辨率的图像,依旧会缩放到对应视觉编码器能接受的输入分辨率 (例如 ConvNeXt-L 的分辨率为 )。

)。

3. 基于搜索的方法:这类方法不需要训练,通过将高分辨率图像构建成树结构,在树结构上进行搜索。然而,这类方法在搜索的开始阶段输入的是高分辨率图像,从而容易搜索错误的路径,导致推理时延增加甚至搜索到错误的结果。

事实上,在自然语言处理领域,对于长上下文建模,通过检索增强生成技术(RAG),检索关键的文本片段代替原始的长上下文作为输入,从而提高 LLM 回复的准确度。那么在 MLLM 中,是否也可以基于 RAG 技术提高 MLLM 对高分辨率图像的感知?

为了回答上述问题,研究人员通过实验,探索 RAG 应用在 MLLM 对于高分辨率图像感知的可行性。基于实验发现,提出了 Retrieval-Augmented Perception (RAP), 一种无需训练的基于 RAG 技术的高分辨率图像感知插件。该工作已被 ICML 2025 接收,并获评为 Spotlight 论文(top 2.6%)。

论文链接:https://arxiv.org/abs/2503.01222

主页链接:https://dreammr.github.io/RAP

代码链接:https://github.com/DreamMr/RAP

思考

为了探究将 RAG 应用于 MLLM 的高分辨率图像感知,研究人员提出了三个问题:

1. 检索出来的图像块如何布局?

2. 检索的图像块数量对最终性能的影响如何?

3. 如何基于上述发现,将 RAG 更好的应用于 MLLMs 对高分辨率图像的感知?

检索出来的图像块布局方式

为了探究检索图像块布局的影响,研究人员设计了三种策略:1)按照检索的分数从高到低进行排列;2)按照原始顺序进行排列和 3)维持检索图像块的相对位置关系。具体的布局例子见下图。

如下表所示,在三种布局方案中,对于单实例感知任务(FSP)都有显著提升,然而 1)和 2)在跨实例感知任务(FCP)上相较于 baseline 有明显性能下降。而 3)由于维持了图像块之间的相对位置关系,因此 3)在 FCP 任务上在三种策略中取得更好的效果。

结论 1: 维持检索图像块之间的相对位置关系是有必要的,特别是对于需要空间感知的任务。

检索的图像块数对最终性能的影响

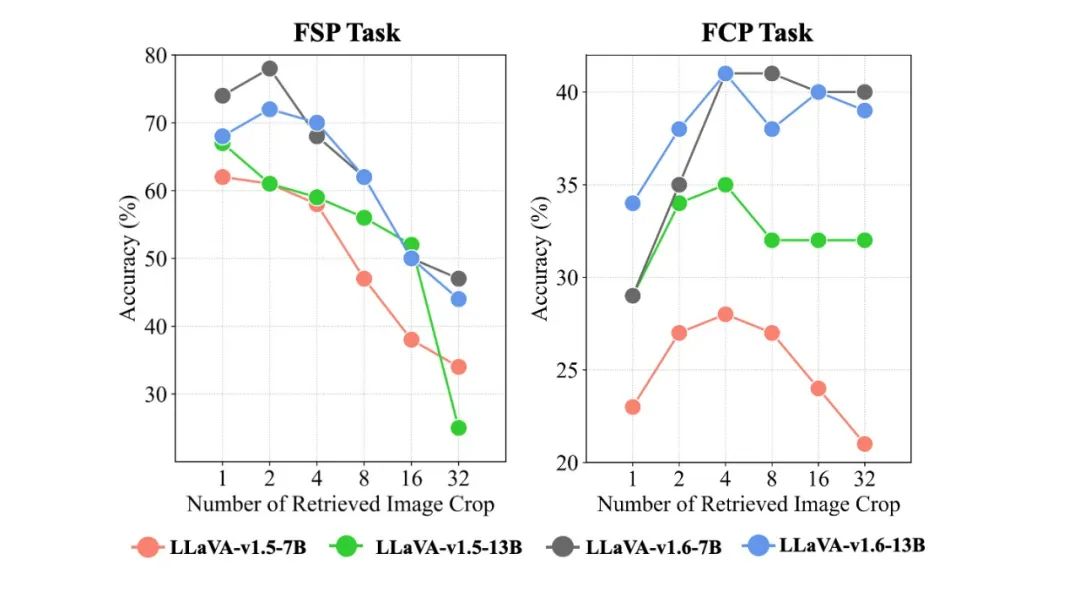

为了探究检索的图像块数的影响,研究人员使用 LLaVA-v1.5 和 LLaVA-v1.6 7B & 13B 在高分图像感知评测数据集 HR-Bench 上进行实验。

如下图所示,当检索的数量 (K) 增加时,由于提供了更多的视觉信息,在 FCP 任务上的性能逐渐增加。然而,当K增加时,输入图像的分辨率也相应增加,导致模型输出的结果准确性下降。相反,对于 FSP 任务而言,较小的 K 便能取得更好的效果,但是在 FCP 任务上效果较差。

结论 2: 不同的任务类型需要保留的图像块数不同。对于 FSP 任务而言,仅需要较少的图像块数便能取得较好的效果,更多的图像块数反而影响模型的性能。对于 FCP 任务而言,更多的图像块数能够保留足够的视觉信息,但是依旧受到输入图像分辨率的限制。

方法

基于上述实验发现,研究人员提出了一种无需训练的高分图像检索增强框架 —— Retrieval-Augmented Perception (RAP)。RAP 的设计原理是通过检索和用户问题相关的图像块,代替原始的高分辨率图像输入到 MLLMs 中。该方法有效地降低输入图像的分辨率,并且保留和用户问题相关的关键视觉信息。为了维持检索图像块之间的相对位置关系,研究人员设计了 Spatial-Awareness Layout 算法,通过确定关键的图像块的位置,剔除无效的行和列,在降低图像分辨率的同时,有效保持图像块之间的相对位置关系。此外,为了自适应选择合适的K,研究人员提出了 Retrieved-Exploration Search (RE-Search),通过检索的相似度分数和模型的置信度分数作为启发式函数,引导模型搜索合适的K。方法架构图如下图所示:

Spatial-Awareness Layout: 对于一张高分辨率图像,首先对其进行裁剪成多个图像块 (V)。接着通过检索器 VisualRAG 计算每个图像块和用户问题 (q) 的相似度分数 :

:

然后根据预先设定要保留的图像块数K,筛选出 top - K图像块,并构建 0-1 矩阵M标记要保留的图像块的位置为 1,其余位置标记为 0。接着对矩阵M进行扫描,提取其中非零行和列的索引,其余位置删除,从而生成压缩矩阵 。最后根据压缩矩阵

。最后根据压缩矩阵 提取出相应的图像块合成新的图像

提取出相应的图像块合成新的图像 。

。

RE-Search: 为了自适应选择保留的图像块数K,研究人员受到 算法的启发提出了 RE-Search。研究人员将当前的图像按照不同的保留图像块数的比例,通过 Spatial-Awareness Layout 算法对图像进行压缩,生成子节点。与之前基于搜索的方法不同,为了避免在搜索的初始阶段受到图像分辨率的影响,RE-Search 引入了每个图像块和用户问题的相似度分数

算法的启发提出了 RE-Search。研究人员将当前的图像按照不同的保留图像块数的比例,通过 Spatial-Awareness Layout 算法对图像进行压缩,生成子节点。与之前基于搜索的方法不同,为了避免在搜索的初始阶段受到图像分辨率的影响,RE-Search 引入了每个图像块和用户问题的相似度分数 :

:

这里 表示有效的图像块,n表示有效的图像块的数量,g(t)表示当前的图像与用户问题的语义相似度。在

表示有效的图像块,n表示有效的图像块的数量,g(t)表示当前的图像与用户问题的语义相似度。在 算法中通过启发式函数h估计从当前状态到目标状态的花费。这里通过让 MLLM 自身判断当前的图像

算法中通过启发式函数h估计从当前状态到目标状态的花费。这里通过让 MLLM 自身判断当前的图像 是否有足够的视觉信息回答用户的问题:

是否有足够的视觉信息回答用户的问题:

其中 表示 MLLM,

表示 MLLM, 是提示模板用于构造文本问题(例如:“Question: {q} Could you answer the question based on the available visual information?”)。这里计算模型对于回复为 “Yes” 的置信度分数作为启发式函数。

是提示模板用于构造文本问题(例如:“Question: {q} Could you answer the question based on the available visual information?”)。这里计算模型对于回复为 “Yes” 的置信度分数作为启发式函数。

由于在最开始图像的分辨率较大,模型输出的结果h(t)不可靠。因此在最开始搜索过程中降低h(t)的权重,随着搜索深度加深,逐渐增加h(t)的权重,具体计算公式如下:

其中b是一个超参数,具体实现时设置为0.2,d是搜索的深度。

实验结果

本文在高分辨率图像评测数据集 Bench 和 HR-Bench 上进行评测。对比的方法包括基于裁剪的方法(LLaVA-v1.6, InternVL-1.5 等)以及使用处理高分辨率图像的视觉编码器的方法(LLaVA-HR-X),实验结果如下表所示,RAP 在单实例感知和多实例感知任务上都能带来明显的性能提升。特别是在 HR-Bench 4K 和 8K 上分别带来最大 21% 和 21.7% 的准确率提升。

Bench 和 HR-Bench 上进行评测。对比的方法包括基于裁剪的方法(LLaVA-v1.6, InternVL-1.5 等)以及使用处理高分辨率图像的视觉编码器的方法(LLaVA-HR-X),实验结果如下表所示,RAP 在单实例感知和多实例感知任务上都能带来明显的性能提升。特别是在 HR-Bench 4K 和 8K 上分别带来最大 21% 和 21.7% 的准确率提升。

论文中还对比了基于搜索的方法(结果见下表),RAP 相比于 和 Zoom Eye 在吞吐量和准确率上都取得更好的效果。

和 Zoom Eye 在吞吐量和准确率上都取得更好的效果。

此外,消融实验表明 (见下表),如果仅加入 VisRAG 检索和用户问题相关的图像块,仅带来 6.5% 的提升,通过维持检索图像块之间的相对位置关系在 FCP 任务上能够有所改进。通过引入 RE-Search 自适应选择合适的K,最终能够带来 21.7% 的性能提升。

总结

综上,该工作提出了 Retrieval-Augmented Perception (RAP),一种无需训练基于 RAG 技术提高 MLLM 对高分辨率图像感知的方法。该方法使用 Spatial-Awareness Layout 算法维持检索的图像块之间的相对位置信息,通过 RE-Search 自适应选择合适的K值,在保留关键视觉信息的同时有效降低图像的分辨率。实验结果表明,RAP 在 MLLM 高分辨率图像感知的场景中展现出显著优势。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

CVPR 2025 论文和代码下载

在CVer公众号后台回复:CVPR2025,即可下载CVPR 2025论文和代码开源的论文合集ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集

CV垂直方向和论文投稿交流群成立

扫描下方二维码,或者添加微信号:CVer2233,即可添加CVer小助手微信,便可申请加入CVer-垂直方向和论文投稿微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。 一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者论文投稿+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer2233,进交流群

CVer计算机视觉(知识星球)人数破万!如果你想要了解最新最快最好的CV/DL/AI论文、实战项目、行业前沿、从入门到精通学习教程等资料,一定要扫描下方二维码,加入CVer知识星球!最强助力你的科研和工作!

▲扫码加入星球学习

▲扫码或加微信号: CVer2233,进交流群

CVer计算机视觉(知识星球)人数破万!如果你想要了解最新最快最好的CV/DL/AI论文、实战项目、行业前沿、从入门到精通学习教程等资料,一定要扫描下方二维码,加入CVer知识星球!最强助力你的科研和工作!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号 整理不易,请点赞和在看

5196

5196

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?