点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信:CVer5555,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

作者 | Chai Zenghao

单位 | 新加坡国立大学博士生 研究方向 | 3D生成

背景

在计算机图形学和数字虚拟人领域,从简单的文本提示生成更真实、可交互的虚拟人物是是目前广受关注的研究课题。然而,先前的 3D Avatar 生成方法存在一些问题,如生成的人物在动作和细节上往往不够真实。

新加坡国立大学和清华大学的研究团队提出了“STAR: Skeleton-aware Text-based 4D Avatar Generation with in-network motion Retargeting”。该算法通过引入角色相关的骨骼感知技术,能够从文本描述生成高质量的 4D Avatar,显著提升了虚拟人物外观和动作的真实性和自然性。本文将简要介绍 STAR 算法的核心创新及其在文本到 Avatar 生成领域的贡献。

论文链接:

https://arxiv.org/abs/2406.04629

项目主页:

https://star-avatar.github.io/

代码链接:

https://github.com/czh-98/STAR

本文动机

近年来,基于扩散模型的文本到图像生成(T2I generation)领域取得了显著的进展。通过利用 T2I Diffusion 先验,从文本描述生成 3D 内容(特别是类人角色)在计算机视觉和图形学社区引起了广泛关注。进一步地,4D 角色的创建(即合成具有真实人类动作的可动画角色)也在电影和游戏行业中引起了极大关注。

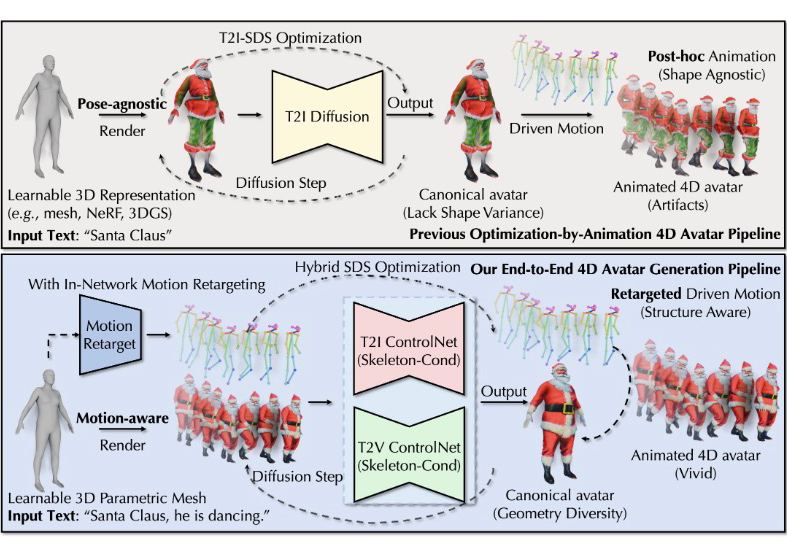

然而,目前主流的基于文本的 4D Avatar 生成通常采用先优化后驱动的策略。即,首先通过基于 T2I 的 Score Distillation Sampling(SDS)优化 Canonical 3D 表示,生成特定的 3D Avatar;然后再通过给定的动作进行人物驱动。这种典型的生成流程面临以下主要挑战,导致现有模型难以生成具有丰富几何和纹理多样性以及准确动作的生动 4D Avatar:

多面问题(Janus-Problem):一些先前的方法仅仅使用T2I扩散模型作为先验,并依赖于视角相关的文本提示来提供T2I模型稀疏的监督信号。因此,生成的结果往往不够精确,并可能出现不同视角下多个人脸的问题。

域间隙(Domain Gap):由于扩散模型是使用自然姿态下的人脸或人体图像进行训练的,而当前的文本到 3D 方法则是通过训练固定姿态的渲染图像来进行训练的。因此,存在渲染的 2D 图像与真实图像之间的姿态分布差异。这种基于标准姿态(Canonical Pose)的优化存在潜在的域间隙问题,不利于生成具有多样体型的 3D Avatar。

动画穿模(Animation Artifact):当简单地将文本到动作模型中的源动作应用于目标角色时,由于源模板(如 SMPL 模板)和目标角色之间的骨架和几何差异,可能会导致错误的驱动结果,例如手臂与身体相交等穿模问题。

STAR简介

为了解决上述挑战,本文提出了 STAR(如图所示)。相比于先前的 4D Avatar 生成方法,STAR 的核心在于通过在优化过程中考虑骨架(Skeleton)、几何(Geometry)以及姿势(Pose)的影响,利用运动重定向(motion retarget)技术获得更准确的骨架控制信号,用于 SDS 的优化。这一方法显著提升了 4D Avatar 的生成质量。

▲ 图1:文本驱动的 4D Avatar 生成:典型的优化-驱动流程(上)与本文的方法(下)比较。

优化结束后,借助 mesh 的表示,STAR 能够灵活地与来自文本、音频或视频的任意生成的运动结合,并兼容当前的图形软件(如 Blender)。给定人物和动作的文本描述,训练 4D Avatar 的整体算法流程如下:

▲ 图2:STAR的训练算法伪代码表示

STAR 的主要流程如下图所示,其核心包括以下几个方面:

▲ 图3:STAR 整体框架图。左:给定文本描述,我们使用预训练的文本到动作模型初始化人体动作。需要注意的是,典型的优化-驱动范式在 4D Avatar 生成中往往会导致不合理的结构和动画穿模等问题。右:STAR 通过集成重定向的动作来消除基于 SDS 优化中的潜在姿态分布偏差。利用角色相关和遮挡感知的骨架结构,并结合混合的 T2I 和 T2V 扩散模型,提供一致的 3D 先验。这一流程逐步优化几何、纹理和动作,以端到端的方式生成 4D Avatar。

Skeleton-aware, geometry-aware, motion-aware 的训练过程:在训练过程中,STAR 通过骨架感知、几何感知和动作感知来更新几何和纹理,同时同步调整源动作以匹配个性化 Avatar 的骨架和几何特征。这一方法有效提升了 Avatar 的外观多样性和动作真实性,显著减少了最终生成的 4D Avatar 中的穿模问题。

优化中的 motion retarget:通过及时更新运动,STAR 能够获得更准确的渲染图像,并为 ControlNet 提供骨架条件时提供更精确的结构信息。这使得渲染的 3D Avatar 与扩散模型中自然姿势分布更一致,有助于减少扩散模型先验与渲染图像之间的域间隙问题。更新的运动和骨架确保具有目标 3D 角色的精确结构信息,同时保持文本描述的语义一致。

混合 SDS 方法:为了消除时间不一致和视角无关的干扰,STAR 在 T2I 先验的基础上,引入了免训练的 T2V 模型,以提供不同时间和视角下的一致性先验。同时,STAR 提出了结合了骨架感知、遮挡感知和掩模感知的混合 SDS 方法,以强化视角一致性的监督信号,从而提高生成质量。

分层 Regularization:为了稳定混合 SDS 的优化过程,STAR 提出了分层的正则化方法,通过不同粒度的约束项对全局体型、顶点偏移和五官结构进行约束。这些约束项有助于提升角色在几何结构上的合理性,从而改善生成结果的几何质量和整体外观。

实验结果

定性结果表明,STAR 能够生成具有多样体型特征的角色,并通过 3D mesh 表示,在不同视角下展现更真实的动画效果。每个示例中展示了脸部和身体的纹理(左侧)以及法线贴图(右侧)的结果。

▲ 图4:STAR 生成的 4D Avatar 示例

在定量评估方面,本文利用 CLIP-Score、VQA-Score 和 User Study 验证了 STAR 相较于先前的一些方法能够生成更加真实的结果。

▲ 表1:Canonical 3D Avatar 和 4D Avatar 的定量比较。我们使用 CLIP-Score 和 VQA-Score 指标,得分越高表示生成结果与文本描述的一致性越好。

▲ 表2:User Study 结果。我们展示了不同方法在三个方面被选为“最佳”的平均百分比:Q1.几何质量,Q2.外观质量,以及 Q3.动作质量。

结论

本文提出了 STAR,一种能够从文本描述中生成高质量 4D Avatar 的方法。STAR 的关键创新在于充分考虑了动作多样性和真实性对于基于文本生成 4D Avatar 的重要性。与传统的先优化后驱动方法不同,STAR 引入了 Motion Retarget 和 Hybrid SDS 技术,显著改善了生成的 Avatar 的质量和一致性。通过逐步优化几何、纹理和动作,特别是在解决源模板与目标 Avatar 之间的骨架和几何差异方面,STAR 展示了在提升虚拟人物生成技术方面的潜力和优越性。

有关更多信息和细节,欢迎查阅本文、项目主页以及相关的代码。

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信:CVer5555,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer5555,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集近万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

897

897

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?