点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer111,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

衡宇 发自 凹非寺

转载自:量子位(QbitAI)

Transformer大模型尺寸变化,正在重走CNN的老路!

看到大家都被LLaMA 3.1吸引了注意力,贾扬清发出如此感慨。

拿大模型尺寸的发展,和CNN的发展作对比,就能发现一个明显的趋势和现象:

在ImageNet时代,研究人员和技术从业者见证了参数规模的快速增长,然后又开始转向更小、更高效的模型。

听起来,是不是和GPT哐哐往上卷模型参数,业界普遍认同Scaling Law,然后出现GPT-4o mini、苹果DCLM-7B、谷歌Gemma 2B如出一辙?

贾扬清笑称,“这是前大模型时代的事儿,很多人可能都不咋记得了:)”。

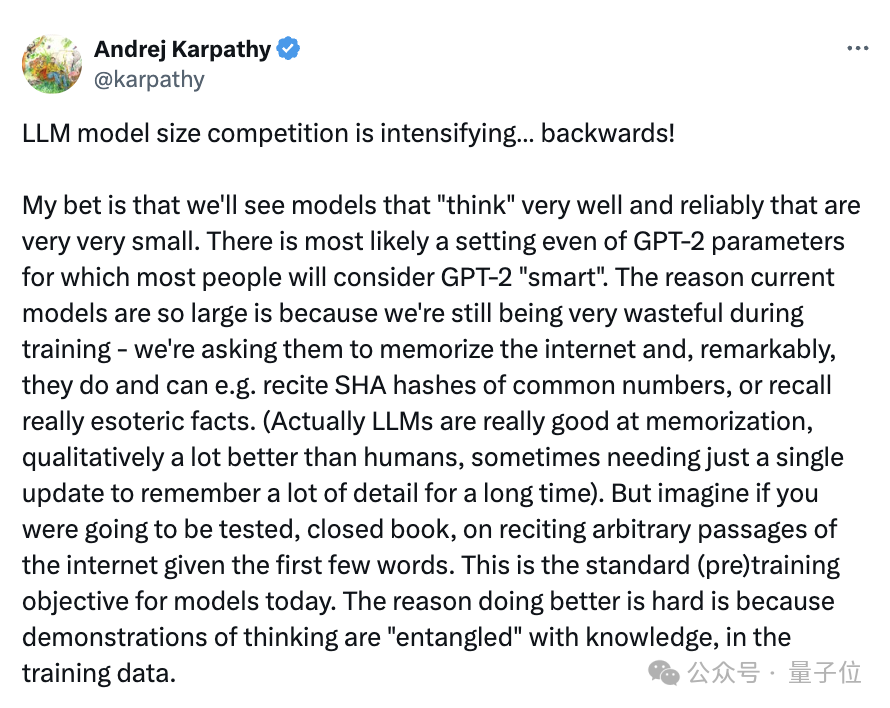

而且,贾扬清不是唯一一个感知到这一点的人,AI大神卡帕西也这么觉得:

大模型尺寸的竞争正在加剧……但是卷的方向反着来了!

模型必须先追求“更大”,然后才能追求“更小”,因为我们需要这个过程,帮咱把训练数据重构成理想的、合成的格式。

他甚至拍着胸脯打赌,表示我们一定能看到又好、又能可靠地思考的模型。

而且是参数规模很小很小的那种。

连马斯克都在卡帕西的评论区连连称是:

以上,大概可以称之为“大佬所见略同”。

展开说说

贾扬清的感慨,要从只在最强王座上短暂待了一天的LLaMA 3.1说起。

那是首次实现“最强开源模型=最强模型”,不出意外,万众瞩目。

However,贾扬清在这个时候提出了一个观点:

“但我认为,行业会因小型垂直模型而真正蓬勃发展。”

至于啥是小型垂直模型,贾扬清也说得很清楚,比如以Patrouns AI的Iynx(该公司的幻觉检测模型,在幻觉任务上超过GPT-4o)为代表的那些很棒的中小模型。

贾扬清表示,就个人喜好而言,他本人是非常喜欢千亿参数模型的。

但现实情况里,他观察留意到,7B-70B参数规模之间的大模型,大家用起来更顺手:

它们更容易托管,不需要巨大的流量即可盈利;

只要提出明确的问题,就能得到质量还不错的输出——与和之前的一些看法相反。

与此同时,他听说OpenAI最新的、速度很快的模型也开始变得比“最先进的”大模型尺寸更小。

“如果我的理解是正确的,那么这绝对表明了行业趋势。”贾扬清直接表明了自己的观点,“即在现实世界中,使用适用的、具有成本效益、且仍然强大的模型。”

于是乎,贾扬清简单梳理了CNN的发展历程。

首先,是CNN的崛起时代。

以AlexNet(2012)为起点,开启了大约三年的模型规模增长时期。

2014年出现的VGGNet就是一个性能和规模都非常强大的模型。

其次,是缩小规模时期。

2015年,GoogleNet把模型大小从“GB”缩小到了“MB”级别,即缩小了100倍;但模型性能并没有因此骤减,反而保持了不错的性能。

遵循类似趋势的还有2015年面世的SqueezeNet模型等。

然后的一段时间,发展重点在追求平衡。

后续研究,如ResNet(2015)、ResNeXT(2016)等,都保持了一个适中的模型规模。

值得注意的是,模型规模的控制并没有带来计算量的减少——其实,大伙儿都愿意投入更多的计算资源,寻求一种“同等参数但更高效”的状态。

紧接着就是CNN在端侧起舞的一段时期。

举个例子,MobileNet是谷歌在2017年推出的一项有趣的工作。

有趣就有趣在它占用的资源超级少,但是性能却非常优异。

就在上周,还有人跟贾扬清提到:“Wow~我们现在还在用MobileNet,因为它可以在设备上运行,而且在出色的特征嵌入泛化(Feature Embedding Generality)。”

最后,贾扬清借用了来源于Ghimire等人的《A Survey on Efficient Convolutional Neural Networks and Hardware Acceleration》里的一张图:

并再一次发出自己的疑问:

大模型尺寸,会遵循与CNN时代相同的趋势来发展吗?

网友怎么看?

其实GPT-4o mini这样走在大模型发展道路上“不大反小”的例子不在少数。

当上述几位表达出这样的观点后,立马有人点头如捣蒜,还拿出了一些别的类似例子,证明他们看到了相同的趋势。

有人立马跟上:

我这儿有个新的正面例子!Gemma-2就是把27B参数大小的模型知识蒸馏成更小的版本。

还有网友表示,开发更大的模型,意味着能给后续几代更小、更垂直的模型的训练“上强度”。

这个迭代过程最终会产生所谓的“完美训练集”。

这样一来,较小的大模型在特定领域,能与现在参数巨大的大模型一样聪明,甚至更聪明。

一言以蔽之,模型必须先变大,然后才能变小。

大多数讨论此观点的人,还是对这个趋势比较认同,有人直言“这是一件好事,比‘我的模型比你的模型大’参数竞赛更实用和有用。”

但是,当然了!

翻遍网络评论区,也有人发出不同的声音。

比如下面这位朋友就在贾扬清推文底下留言:

Mistral Large(背后公司Mistral AI)、LLaMA 3.1(背后公司Meta)和OpenAI,持有最强竞争力模型的公司,目前可能都正在训练更大的模型。

我没发现有“更小型号模型搞定技术突破”的趋势哟。

面对这个问题,贾扬清倒也及时回复了。

他是这么说的:“没错!我说大模型尺寸可能在走CNN的老路,绝对不意味着号召大家停止训练更大的模型。”

他进一步解释道,这么说的本意是,随着技术(包括CNN和大模型)落地实践越来越广,大家已经开始越来越关注性价比更高的模型了。”

所以,或许更高效的小·大模型,能够重新定义AI的“智能”,挑战“越大越好”的假设。

你赞同这个观点不?

参考链接:

[1]https://x.com/jiayq/status/1818703217263624385

[2]https://x.com/fun000001/status/1818791560697594310

[3]https://www.patronus.ai/

[4]https://twitter.com/karpathy/status/181403809621808349

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer111,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer111,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?