点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

添加微信号:CVer111,小助手会拉你进群!

扫描下方二维码,加入CVer学术星球!可以获得最新顶会/顶刊上的论文idea和CV从入门到精通资料,及最前沿应用!发论文/搞科研/涨薪,强烈推荐!

转载自:新智元 | 编辑:LRST

【导读】AnyGraph聚焦于解决图数据的核心难题,跨越多种场景、特征和数据集进行预训练。其采用混合专家模型和特征统一方法处理结构和特征异质性,通过轻量化路由机制和高效设计提升快速适应能力,且在泛化能力上符合Scaling Law。

图数据,作为一种不可或缺的数据表现形式,广泛渗透于社交网络、学术科研网络、交通管理系统及生物信息网络等诸多领域。作为最广泛应用的图学习范式,图表征学习致力于学习图中节点的表示向量,融合结构特性与节点特征,以实现精准的预测与分析。

近年来涌现出了大量的图学习方法,包括图神经网络、图自监督学习、图预训练和微调方法、以及图大语言模型。这些方法不断精进图学习模型的建模能力和预测精度,近年的一些方法探索了增强图模型泛化能力的途径。

然而,当前方法普遍依赖于复杂的调优流程,难以灵活应对实际图数据复杂多变的结构与特征特性。当图数据涉及多个领域,且模型在训练阶段未曾见过时,当前模型难以处理,体现了现有方法在跨领域的零样本预测任务上泛化性能的不足。

为了解决这一问题,香港大学的研究人员提出AnyGraph这一图基础模型。

论文链接:https://arxiv.org/pdf/2408.10700

项目地址:https://github.com/HKUDS/AnyGraph

基于图数据的独特性质,AnyGraph聚焦于攻克一下几个方面的核心难题,模型预训练跨越了8种场景、10类特征、以及38个数据集, 以实现搭建图基础模型的目标:

结构和特征异质性

不同应用场景下的图数据,其结构形态千差万别,包括节点连接密度、密集子图分布、数据噪声与缺失情况等。现有的方法,例如图神经网络,往往被训练用于预测一类具有固定特点的图数据,其模型本身的容纳能力,也无法处理真实世界中跨场景的复杂多样数据。

此外,不同数据集往往存在严重的特征异质性。节点特征是图数据的核心组成部分之一,但在不同数据集中展现出极大的差异性。从离散类别到连续数值,从文本嵌入到图统计特征,乃至特征向量的维度都各不相同。如何在零样本场景下处理这些多样化的特征,成为图基础模型必须跨越的障碍。

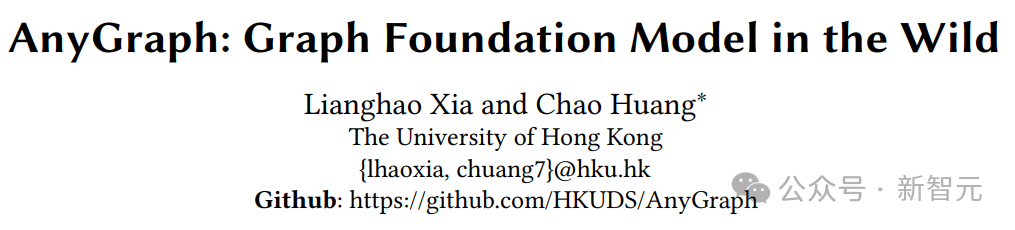

为了应对结构和特征的异质性挑战,AnyGraph采用混合专家模型(MoE)架构,在模型中集成了同构但参数不同、互不耦合的多个专家图模型。基于一种高效且强大的专家路由算法,将不同的输入数据分配给适合的专家模型进行学习和预测。通过这种方式,AnyGraph可以轻松集成针对不同图数据特点的专家模型,从而达到更强的模型鲁棒性。

另一方面,AnyGraph的每个专家模型都采用了统一的结构和特征统一方法,基于特征值分解方法,专家模型将具有不同维度、不同语义的邻接矩阵数据和节点特征数据,都映射为具有统一长度和相近语义的统一表征。在这一基础上,即使不同数据的表征仍存在一些差异,也可以轻易被专家集成的MoE架构解决。

快速适应能力

一个高效的图基础模型应具备快速适应新数据集和领域的能力,能够在不依赖大量重新训练或微调的情况下,迅速调整其参数和学习策略,以应对未知图数据的挑战。然而,现有的图基础模型通常基于大规模的预训练语言模型,难以进行快速的模型调整。这种对新图域的低效适应性,成为限制图学习技术广泛应用的瓶颈。

针对这一问题,AnyGraph设计了轻量化的图专家路由机制,使用自监督任务来快速评测多个专家任务对输入数据的预测准确性。在不引入额外标签数据的情况下,这一方法可以准确找到最优的专家模型,在仅使用单个专家模型、极少数模型参数的情况下,达到优于与大规模预训练模型的效果。

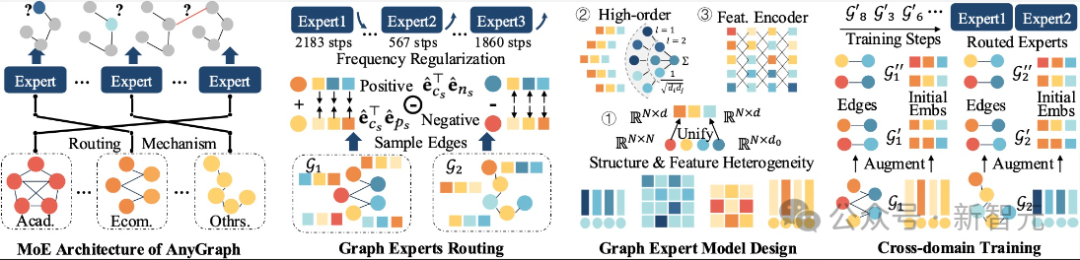

下图展示了AnyGraph专家路由机制的分配结果,可以看到,同源(例如ML1M和ML10M)以及使用相同特征构建方法(例如YelpT, SteamT, AmazT)的数据集,被分到了同样的专家模型。

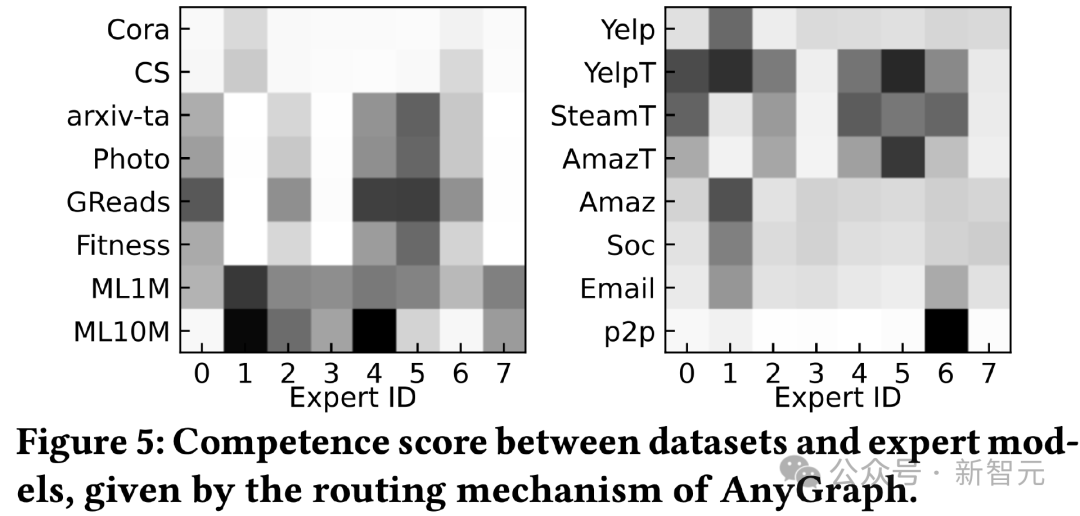

此外,AnyGraph的专家模型采用一种简单高效的设计,数据集的大部分信息可以预处理成高度有效的初始表征,而专家模型仅需要采用多层感知机模型,就能通过专家集成达到大规模模型的效果,从而减少模型前向和反向传播的开销。

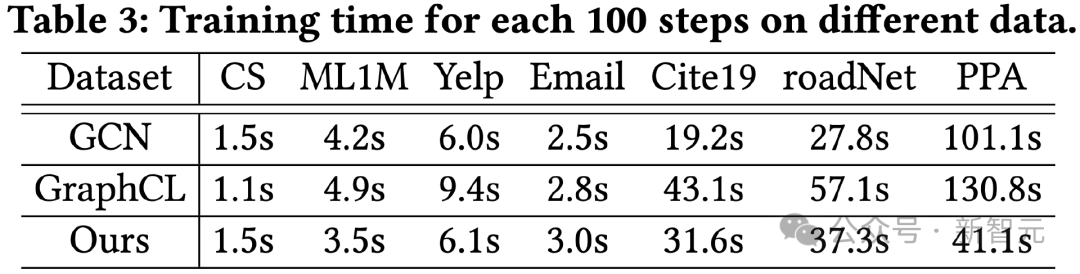

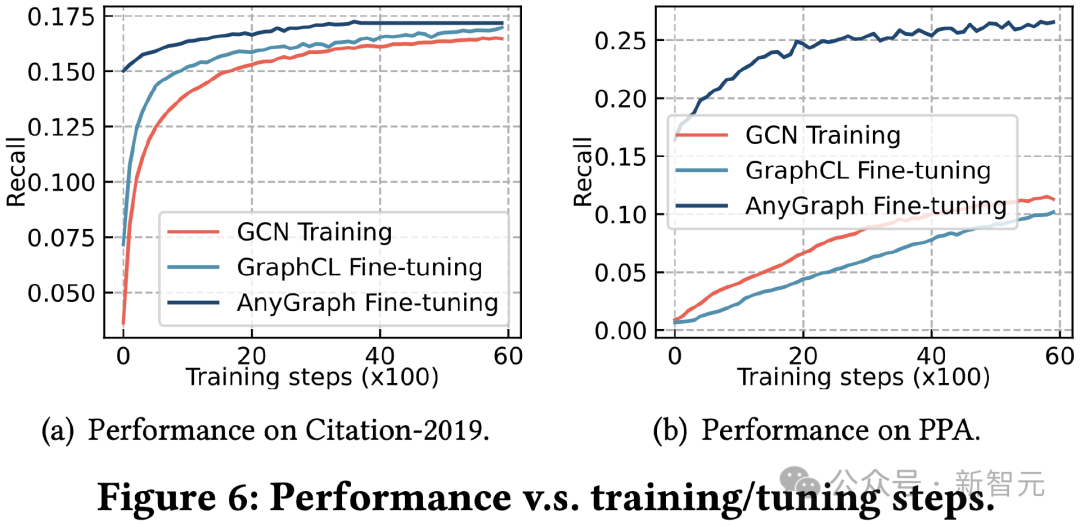

下图展示了AnyGraph在限定训练步数上花费的计算时间,以及在fine-tune情况下的效果曲线,均展示了AnyGraph在快速适应能力上的优势。

Scaling Law

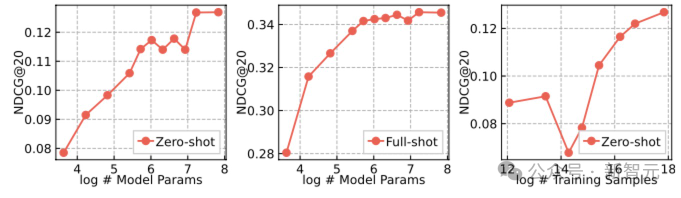

在视觉和文本领域,大规模基础模型的一个标志性现象是Scaling Law,即随着模型参数量和训练数据量的增加,模型效果不断提升。本文探索了图基础模型是否存在这样的特点。

本文对AnyGraph的多个模型大小影响参数,以及训练数据量进行了调整,以测试模型性能随着这些因素的变化情况。结果如下所示:

可以看到,在零样本预测能力上,AnyGraph保持了随参数量和数据量增长而不断上升的趋势,这一现象在训练数据集上未能观测到。这展示了AnyGraph在泛化能力上符合Scaling Law。这同时也说明,这种突破性的模型性能增长应该在更具挑战性的任务上寻找,例如跨领域的零样本预测。

这种不断增长的突破性模型性能,来源于AnyGraph通用的模型设计,以及其在大量跨领域数据上的充分训练。

参考资料:

https://arxiv.org/pdf/2408.10700

何恺明在MIT授课的课件PPT下载

在CVer公众号后台回复:何恺明,即可下载本课程的所有566页课件PPT!赶紧学起来!

ECCV 2024 论文和代码下载

在CVer公众号后台回复:ECCV2024,即可下载ECCV 2024论文和代码开源的论文合集CVPR 2024 论文和代码下载

在CVer公众号后台回复:CVPR2024,即可下载CVPR 2024论文和代码开源的论文合集Mamba、多模态和扩散模型交流群成立

扫描下方二维码,或者添加微信号:CVer111,即可添加CVer小助手微信,便可申请加入CVer-Mamba、多模态学习或者扩散模型微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF、3DGS、Mamba等。

一定要备注:研究方向+地点+学校/公司+昵称(如Mamba、多模态学习或者扩散模型+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群▲扫码或加微信号: CVer111,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉(知识星球),已汇集上万人!

▲扫码加入星球学习▲点击上方卡片,关注CVer公众号

整理不易,请赞和在看

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?