最近在学习B站一个up主的视频,很棒。故决定在学习过程中进行笔记整理和总结。(无它,自用自勉)

给出收藏的博主笔记及up主笔记,以便自己日后查找翻阅。博主链接-AlexNet

(内里给出几篇参考博客可读)

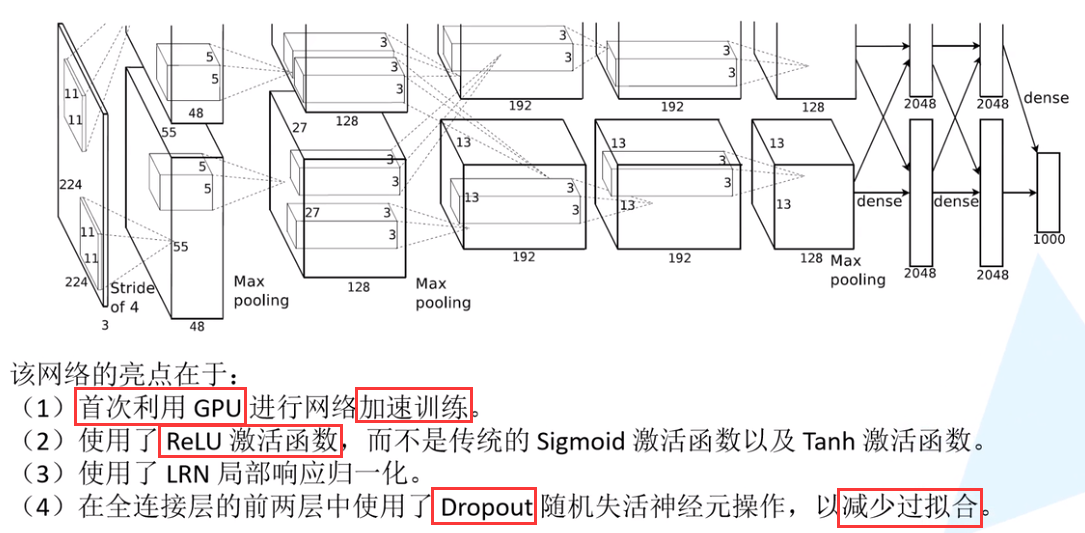

AlexNet详解

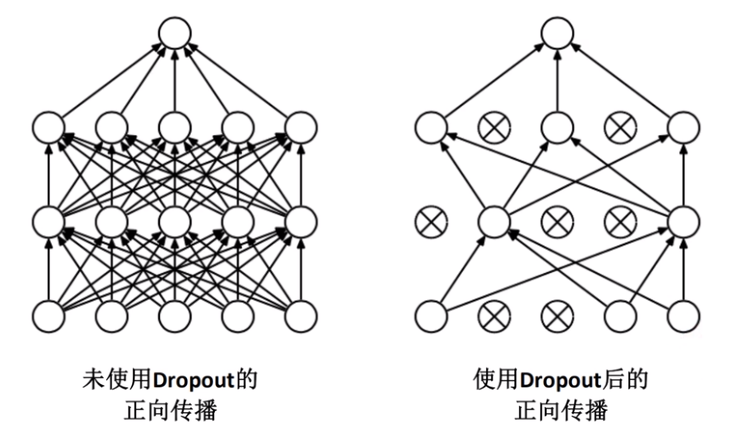

AlexNet与LeNet的架构非常相似,但也存在显著差异。其比LeNet5要深得多,由八层组成:五个卷积层、两个全连接隐藏层和一个全连接输出层;AlexNet采用ReLU而非Sigmoid作为激活函数。由于早期的GPU显存有限,所以原版AlexNet采用了双数据流设计,使每个GPU只负责存储和计算模型的一半参数。同时,AlexNet通过dropout控制全连接层的模型复杂度,而LeNet只使用了权重衰减。

使用Dropout的方式在网络正向传播过程中随机失活一部分神经元,以减少过拟合

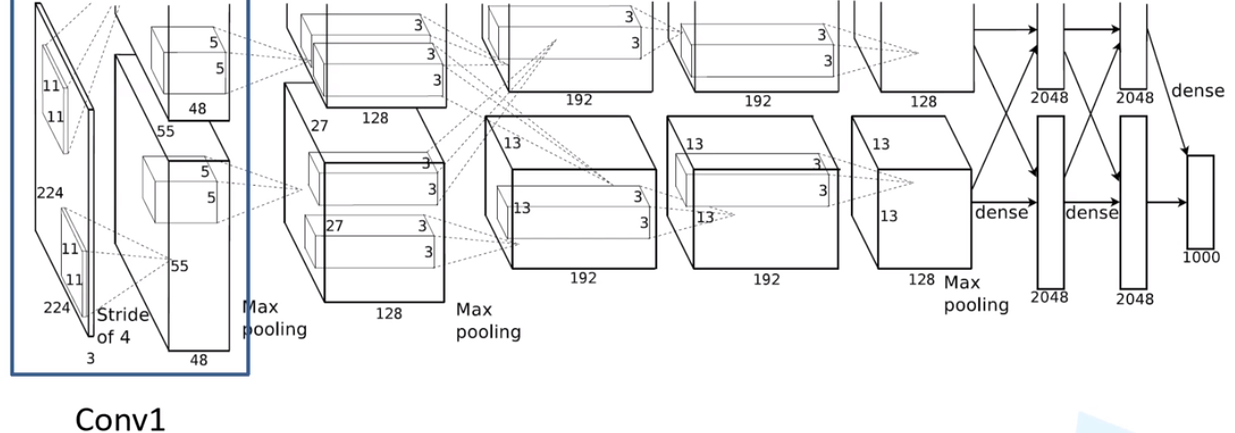

可以发现,除 Conv1 外,AlexNet 的其余卷积层都是在改变特征矩阵的深度,而池化层则只改变(减小)其尺寸。

1.各层详解

Conv1

注意:原作者实验时用了两块GPU并行计算,上下两组图的结构是一样的。

- 输入:input_size = [224, 224, 3]

- 卷积层:

kernels = 48 * 2 = 96 组卷积核(输出深度)、kernel_size = 11

padding = [1, 2] ()、stride = 4

- 输出:output_size = [55, 55, 96]

经 Conv1 卷积后的输出层尺寸为:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?