简要

自动检测表现攻击的方法对于确保人脸识别技术的可靠使用来说至关重要。现有的大多数文献中的攻击检测(PAD)方法对于未见过的攻击检测泛化性能很差。近年来,为了提高PAD系统的鲁棒性,人们提出了多通道方法。通常,用于多通道方法的数据量是有限的,这限制了这些方法的有效性。在本文中,我们提出了一个新的PAD框架,该框架使用RGB和深度通道和一个新的损失函数进行结合。新的架构使用了两种模式的互补信息,同时减少了过度拟合的影响。本质上说,一个跨模态的焦点损失函数被提出,该函数作为通道置信度函数用来调节不同通道的损失贡献。在两个公开的数据集中进行了广泛的评估,证明了该方法的有效性。

一. 介绍

人脸识别技术已经成为普遍的生物认证方法,但在安全场景中使用时,呈现攻击(也称为“欺骗攻击”)的脆弱性是一个主要问题[9],[12]。这些攻击可以是模拟攻击也可以是混淆攻击。模拟攻击试图通过伪装他人获得访问权限,混淆攻击试图逃避人脸识别系统。虽然许多解决该问题的方法在文献中被提出,但大多数方法对于未见过的攻击测试都以失败告终[10]。在实际场景中,在训练PAD模型时,不可能对所有类型的攻击都进行预测。此外,PAD系统期望能检测到新的高水平的类型攻击。因此,在PAD模型中具有对抗不可见类型的攻击鲁棒性是很重要的。

大部分的文献都是基于RGB像机来检测攻击。这些年来,许多基于特征的方法已经被提出,如使用颜色、纹理、运动、生动性线索、直方图特征[7]、局部二值模式[25]、[8]和运动模式[3]来执行PAD。近些年来基于CNN的方法也被提出,包括3D-CNN[13]、基于零件的模型[22]等。一些研究表明,使用二进制或深度监督形式的辅助信息可以提高性能[4,14]。然而,这些方法中的大多数都是专门为2D攻击设计的,而且这些方法对具有挑战性的3D和部分攻击的性能很差[24]。此外,这些方法对不可见攻击的鲁棒性较差。

单RGB模型的性能随着攻击复杂性的提高(如3D掩码和部分攻击)而下降。由于可见光光谱的局限性,一些多通道人脸检测方法,如[30]、[12]、[31]、[11]、[2]、[6]、[5]、[15-18]被提出用于PAD系统。从本质上说,当多通道PAD系统从不同的通道捕获互补信息时,它变得更难欺骗。同时欺骗不同的渠道需要更多的努力。多通道方法已经被证明是有效的,但是它带来了昂贵的硬件成本。这会导致这些系统难以广泛部署,即使它们很有效。PAD有多种通道可供选择,例如RGB、深度、热、近红外光谱、SWIR光谱、紫外线、光场成像等。在这些不同的模式中,RGB-D设备价格相当低廉,在市场上容易买到,因此可以在实际场景中部署它们。Intel RealSense系列,devices、Microsoft Kinect和OpenCV AI Kit(OAKD)[1]是该设备的标准示例,这些设备不需要任何额外的工作就可以获得多通道图像。由于这些通道被集成在一个包中,而且广泛可用性,我们选择RGB和Depth作为这项工作中使用的两个通道。然而,所提出的框架可以简单地扩展到任何信道组合。

即使在使用多个通道时,模型也倾向于过度适应训练集中的攻击。虽然模型对于训练集中看到的攻击中可以执行的很完美,但在现实场景中遇到未见过的攻击时,性能通常会下降。这是大多数机器学习算法中普遍存在的现象,在训练数据量有限的情况下,问题会更加严重。在缺乏强先验知识的情况下,这些模型可能会过度适应它所训练的特定数据集的统计偏差,并且可能无法推广到未见过的样本。多通道方法由于额外的通道而增加了参数的数量,因此过度拟合的可能性也会增加。

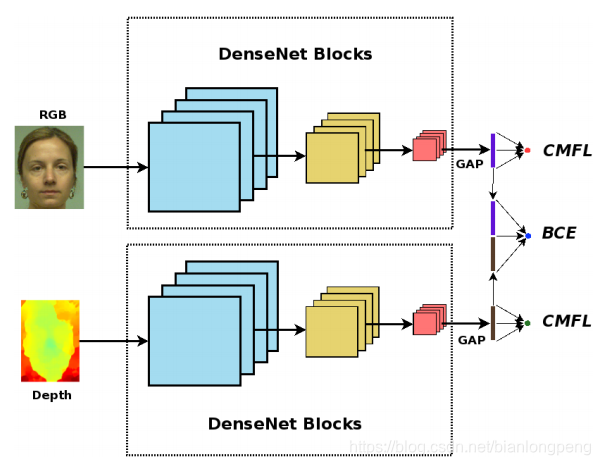

本文的工作中,我们从两个不同的方向来解决这个问题。首先,我们使用一个多头部架构,它遵循一个后期融合策略来组合不同的通道信息。我们没有将表示连接到一个联合的最终节点,而是为各个分支和联合分支分别保留三个不同的头,这可以看作是一种架构规则化的形式。所提出的架构如图1所示。这使我们能够同时监督单个通道和联合表示,确保在单个分支和联合分支中学习鲁棒性表示。其次,我们提出了一个跨模态的焦点损失函数来监督各个通道,该损失函数能够调节不同通道的置信度。

图1:PAD系统框架。采用了两路流多头结构和后期融合策略。各个通道对应的头部由所提出的跨模态损失(CMFL)进行监督,而联合模型则由二进制交叉熵(BCE)进行监督。

本文的主要贡献如下:

- 提出一种帧级的PAD人脸方法,该方法用来同步捕获RGB-D样本

- 提出了一种新的损失函数,称为跨模态焦点损失(CMFL),可用于多流结构中单信道的监督。

- 尽管该模型是针对多通道场景进行训练的,但也可以通过使用与通道对应的头部得分来部署单个通道

- 我们在两个公开的数据集上展示了该框架的有效性,这两个数据集由多种具有挑战性的未见过的攻击组成

二. 提出的方法

本节描述了所提出的PAD框架的不同阶段

2.1 预处理

PAD框架路线中数据采用的是裁剪过的面部图像。对于RGB图像,预处理阶段包括使用MTCNN[32]框架进行人脸检测和关键点定位,然后进行对齐。检测到的人脸是通过使眼睛中心水平对齐,然后将其调整到224×224的分辨率。对于深度图像,使用使用中值绝对偏差(MAD)[27]的归一化方法来归一化面部图像到8位范围。RGB和深度原始图像已经在空间上注册,以便可以使用相同的变换来对齐深度图像中的脸部。

2.2 网络结构和损失函数

本节用来描述提出的网络结构和损失函数

2.2.1 网络结构

根据现有文献,多通道的方法对多种范围的攻击都具有鲁棒性[15–18]。概括地说,基本有四种不同的策略来融合来自多个通道的信息,它们是:1. 早期融合,这意味着通道是在输入层进行堆叠(例如,MC-PixBiS[18])。2. 后期融合,这意味着来自不同网络的表示在后期进行组合,类似于特征融合(例如MCCNN[17]),3. 得分融合,针对不同的通道信息分别训练各个网络,并且对每个通道的得分执行分数级融合。4. 是一种混合方法,即来自多个级别的信息被组合在一起,如[28]。

尽管多通道信息可以很好地对抗各种各样的攻击,但当所有通道一起使用并作为二进制分类器训练时,它们往往会过拟合那些训练数据中已知的攻击。为了避免这种情况,我们提出了一种遵循后期融合策略的多头体系结构。所提出的网络的、架构如图1所示。基本上,该体系结构由一个双流网络组成,该网络具有用于分通道(RGB和Depth)的独立分支。来自两个通道词向量组合形成第三个分支。全连接层被添加到这些分支中来形成最终的分类器头。这三个头被一个损失函数共同监督,从而使网络从单个通道和及联表示中学习区分信息,来减少过拟合。多头部结构还能使得即使在测试阶段缺少通道信息也可以通过得分机制执行,这意味着即使网络在RGB-D数据上训练,我们也可以单独使用RGB分支(单独使用来自RGB头部的得分)进行评分。

这些分支由Huang等人提出的DenseNet 结构(densenet161)的前八个区块组成。[19]. 在DenseNet架构中,每一层都与其他层相连,减少了梯度消失问题,同时减少了参数量。我们使用来自图像网络数据集的预先训练的权重来初始化各个分支。RGB和深度通道的输入通道数分别修改为3和1。对于深度分支,使用三个通道权值的平均值来初始化第一层中修改的卷积核的权值。在每个分支中,在密集层之后添加一个全局平均池化(GAP)层,以获得384维的词向量。将RGB和深度通道词嵌入连接起来形成联合嵌入层。全连接层跟一个sigmoid激活层被添加到每个嵌入的顶部,以形成框架中的不同头。在训练阶段,每个头部都由一个单独的损失函数进行监督。在测试时,来自RGB-D分支的得分被用作PAD分数。

2.2.2跨模型聚焦损失

有了单独的头后,就有可能训练出一个多通道模型,该模型能够在测试时处理丢失的通道情况。现在,监督这个网络的一个简单方法就是用二进制交叉熵损失(BCE)。

但是,在单通道中使用BCE可能并不理想。问题在于:我们可以将不同的通道视为同一样本的不同视图,对于某些攻击,仅从一个视图可能无法区分。当仅在一个通道中查看时,某些攻击的图像可能看起来非常像真实的样本。例如,当在深度通道中查看时,面部化妆看起来与真实样本的深度图完全相同。在这种情况下,用BCE监督深度通道分支的简单方法可能会导致过拟合。然而,在相同的场景中,在RGB和联合表示中,区分度将会很明显。从这个例子可以看出,单独地监督各个分支可能不会产生鲁棒的决策边界。解决该类问题的一种方法是利用当前分支和另一分支的预测概率来改变每个分支中样本的损失贡献。我们提出了一个跨模型的焦点损失函数来监督各个通道,它根据当前通道和备用通道的置信度来调节损失。

对于每个分支,样本可以在得分空间被很好分类。同时,我们鼓励各个分支在没有足够区分信息时产生不确定分数,而不是过度拟合训练数据中的某些统计偏差。但是,这些只有当其他分支能够完全正确分类样本时才适用。

更准确得讲,考虑一个二值分类问题中样本是多模型的,即每个样本是一对图像或特征集,这些图像或特征集捕获了具有互补信息的不同视图。现在假设分类问题不能单独用一个通道信息来解决(或者是一个非常困难的问题)。将两个通道的特征结合起来,并使用联合特征的学习策略可以提供一个解决方案。但是,这可能会导致过拟合,并且无法在测试阶段处理丢失的通道得情况。

如果我们在单独得分支上使用BCE,损失将严重影响那些无法用特定渠道的可用信息进行分类的样本。在这种情况下,模型可能开始过度拟合数据集中的偏差以最小化损失函数,从而导致模型过拟合。

为了避免这种情况,我们提出了跨模型焦点损失(CMFL)来监督各个通道。其核心思想是,当其中一个通道能够以高置信度正确地对样本进行分类时,则可以减少样本在另一个分支中的损失贡献。如果一个通道能够完全正确分类一个样本,那么我们就不希望另一个分支对模型进行更多的惩罚。CMFL迫使每个分支学习单个信道的鲁棒表示,然后可以与联合分支一起使用,有效地充当辅助损失函数。

松散化正确分类样本的损失贡献与目标检测问题中使用的焦点损失[23]类似。在焦点损失中,使用调制因子来减少由具有高置信度的正确分类的样本所造成的损失贡献。我们通过调整当前和备用支路中样本置信度的损失因子来实现相似的思想。

考虑二元分类问题中的交叉熵(CE)表达式:

C

E

(

p

,

y

)

=

{

−

l

o

g

(

p

)

if y=1

−

l

o

g

(

1

−

p

)

if y=0

CE(p,y)= \begin{cases} -log(p)& \text{if y=1}\\ -log( 1-p)& \text{if y=0} \end{cases}

CE(p,y)={−log(p)−log(1−p)if y=1if y=0

其中

y

∈

{

0

,

1

}

y∈\{0,1\}

y∈{0,1}表示类标签(y:0攻击,y:1真实),

p

∈

[

0

,

1

]

p∈[0,1]

p∈[0,1]表示类的概率。我们遵循与[23]类似的符号pt,即目标类的概率:

p

t

=

{

p

if y=1

1

−

p

otherwise

p_t= \begin{cases} p& \text{if y=1}\\ 1-p& \text{otherwise} \end{cases}

pt={p1−pif y=1otherwise

这里

C

E

(

p

,

y

)

=

C

E

(

p

t

)

=

l

o

g

(

p

t

)

CE(p,y)=CE(pt)=log(pt)

CE(p,y)=CE(pt)=log(pt)。在α-平衡形式中,CE损失可以写为:

C

E

(

p

t

)

=

−

α

t

l

o

g

(

p

t

)

CE(p_t)=-\alpha_tlog(p_t)

CE(pt)=−αtlog(pt)

标准的α-平衡焦点损失(FL)[23],通过添加一个调制因子

(

1

−

p

t

)

γ

(1-p_t)^γ

(1−pt)γ到交叉熵损失中,其中

γ

≥

0

γ≥0

γ≥0,其损失函数为:

F

L

(

p

t

)

=

−

α

t

(

1

−

p

t

)

γ

l

o

g

(

p

t

)

FL(p_t)=-\alpha_t(1-p_t)^\gamma log(p_t)

FL(pt)=−αt(1−pt)γlog(pt)

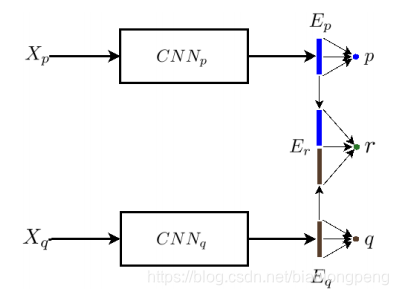

考虑如图3中的双流多分支多头模型。

X

p

Xp

Xp和

X

q

Xq

Xq表示来自不同模型的图像输入,

E

p

Ep

Ep、

E

q

Eq

Eq和

E

r

Er

Er表示单通道和联合表示的相应嵌入。在每个分支中,嵌入层后面跟一个全连层+sigmod层来生成分类概率。变量

p

p

p,

q

q

q和

r

r

r表示对应的概率。

图3:双流多头模型图,展示了单分支和联合分支的嵌入、概率。同时该方法也可以扩展到更多的head头。

所提出的跨模型焦点损失函数(CMFL)如下所示:

C

M

F

L

p

t

,

q

t

=

−

α

t

(

1

−

w

(

p

t

,

q

t

)

γ

l

o

g

(

p

t

)

)

CMFL_{p_t},q_t=-\alpha_t(1-w(p_t,q_t)^\gamma log(p_t))

CMFLpt,qt=−αt(1−w(pt,qt)γlog(pt))

函数

w

(

p

t

,

q

t

w(pt,qt

w(pt,qt的大小取决于来自两个单分支通道的概率。这个调节因子会随着其他分支概率的增加而增加,同时能够防止完全确定概率的错误。因此,在本研究中,我们使用两个分支的调和平均数,并与另一个分支的概率加权。当另一个分支给出confident的预测时,就减少损失贡献。这个函数的表达式如下:

w

(

p

t

,

q

t

)

=

q

t

2

p

t

q

t

p

t

+

q

t

w(p_t,q_t)=q_t\frac{2p_tq_t}{p_t+q_t}

w(pt,qt)=qtpt+qt2ptqt

需要注意的是函数

w

w

w是非对称的,即

w

(

q

t

,

p

t

)

w(qt,pt)

w(qt,pt)的表达式是:

w

(

q

t

,

p

t

)

=

p

t

2

p

t

q

t

p

t

+

q

t

w(q_t,p_t)=p_t\frac{2p_tq_t}{p_t+q_t}

w(qt,pt)=ptpt+qt2ptqt

这意味着权重函数取决于另一个分支的概率。现在我们使用提出的损失函数作为辅助监督,要最小化的总体损失函数如下所示:

L

=

(

1

−

λ

)

L

C

E

(

r

t

)

+

λ

(

L

C

M

F

L

p

t

,

q

t

+

L

C

M

F

L

q

t

,

p

t

)

L = (1- λ)L_{CE}(r_t) + λ(L_{CMFL_{pt,qt}} + L_{CMFL_{qt,pt}})

L=(1−λ)LCE(rt)+λ(LCMFLpt,qt+LCMFLqt,pt)

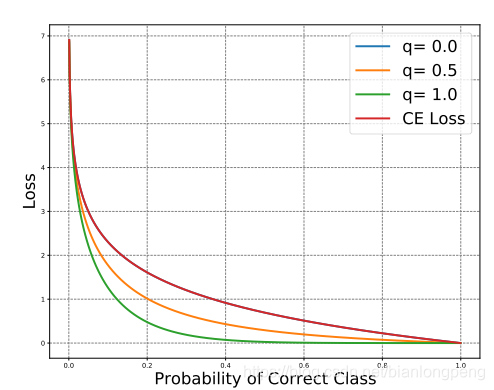

在本研究中,我们将λ值设为0.5。交叉熵的损失曲线和提出的损失函数曲线如图2所示。当其他分支的概率为零时,整个损失等价于标准交叉熵。当另一个分支能够正确分类样本时,整个损失贡献就减少了。即,当网络

C

N

N

p

CNNp

CNNp对攻击样本进行错误分类时,除非

C

N

N

q

CNNq

CNNq模型能够对攻击样本进行高置信度分类,否则网络

C

N

N

p

CNNp

CNNp将受到惩罚。当

w

(

p

,

q

)

→

1

w(p,q)→1

w(p,q)→1时,调制因子变为零,这意味着如果一个通道能够完美地对其进行分类,则另一个分支的惩罚较小。此外,参数γ可以用来改变损耗曲线的特性。在我们的所有实验中,γ=3。

图2,对于所提出的损失函数(γ=3)曲线,变量

q

q

q表示双流网络中另一分支正确分类的概率。可以看出,当q=0时,损失曲线收敛于交叉熵损失。当q→1时,整个损失的贡献减小。

在损失函数适用的前提下,该框架还可以推广到其它多通道分类问题。

2.2.3 配置细节

在训练阶段,我们进行了数据增强,图片随机水平翻转的概率设为0.5。用Adam优化器[21]将组合损失函数最小化。学习率为 1 × 1 0 − 4 1×10^{-4} 1×10−4,权重衰减参数为 1 × 1 0 − 5 1×10^{-5} 1×10−5。mini batch 设为64,GPU上网络迭代25个epochs。在模型的评价中,使用RGB-D头的分数计算最终PAD得分。框架结构约有6.39M参数和9.16 GFLOPS。该框架基于PyTorch[29]库实现。

3. 实验及结果

3.1 数据

在实验中我们使用了两个公开可用的数据集,即WMCA和HQ-WMCA,其中包含多种2D、3D和部分攻击。

3.1.1 WMCA数据

(WMCA)[17]数据库包含各种各样的2D和3D呈现攻击,总共有来自72名受试者的1679个视频样本。使用两个消费级设备“英特尔®RealSense”SR300(用于颜色、深度和红外)和Seek Thermal CompactPRO(用于热通道)同步采集的多个通道,即颜色、深度、红外和热通道™。尽管此数据库中有四个不同的通道,但在本工作中,我们将重点关注从Intel®RealSenseSR300获取的RGB和深度数据。

3.1.2 HQ-WMCA数据

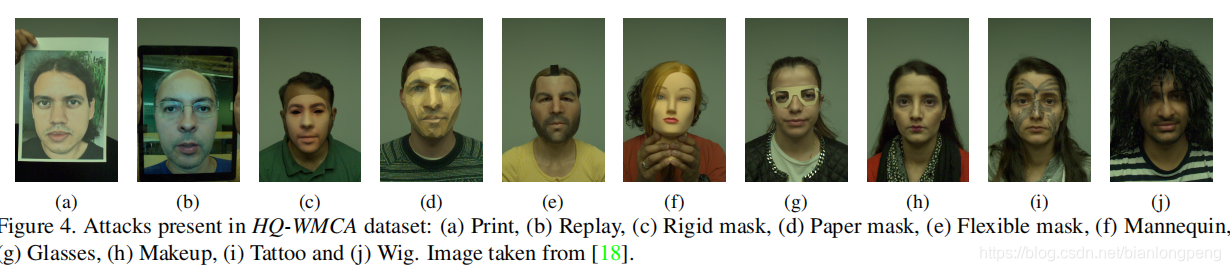

高质量广域多通道攻击(HQ-WMCA)[18,26]数据集由2904个真实攻击和表示攻击的短多模式视频记录组成。这个数据库同样包含各种各样的攻击,包括混淆和模拟攻击。具体来说,考虑的攻击包括打印、回放、硬面具、纸面具、软面具、人体模型、眼镜、化妆品、纹身和假发(图4)。该数据库由51个不同主题的记录组成,包括颜色、深度、热、红外(光谱)和短波红外(光谱)等多个通道。在这项工作中,我们考虑了用Basler acA1921-150uc相机捕获的RGB通道和用Intel RealSense D415捕获的深度图像。

3.2 协议

由于这两个数据集都包含各种各样的攻击,因此我们分别为这两个数据集创建了leave one out(LOO)攻击协议。具体地说,在训练集和开发集中遗漏了一个攻击,而评估集由真实攻击和在训练集和开发集中遗漏的攻击组成。这就构成了隐形攻击协议或零射击攻击协议。在这些协议中,PAD方法的性能给出了一个更真实的估计,即它们对不可见数据的鲁棒性真实场景中的攻击。此外,对于跨数据集的实验,我们在两个数据集中都创建了grandtest协议,这些协议由分布在train、development和test集中的攻击组成(具有跨折叠的不相交身份)。

3.3 度量标注

为了评估算法,我们使用了ISO/IEC 30107-3度量[20]、攻击表示分类错误率(APCER)和真实表示分类错误率(BPCER)以及评估集中的平均分类错误率(ACER)。我们在dev集合中计算BPCER值为1%的阈值。

A

C

E

R

=

A

P

C

E

R

+

B

P

C

E

R

2

ACER=\frac{APCER+BPCER}{2}

ACER=2APCER+BPCER

对于跨数据库测试,根据[16]中的约定,采用半总错误率(HTER),该约定计算错误拒绝率(FRR)和错误接受率(FAR)的平均值。HTER在eval集合中使用在dev集合中使用相等错误率准则(EER)计算的阈值来计算。

3.4 基准方法

为了与现有技术进行公平的比较,我们从文献中为RGB-D通道实现了3种不同的多通道PAD方法。此外,我们还介绍了所提出的单用BCE监督的多头部结构,作为比较的另一个基准。实施的基线如下所示。

- MC-PixBiS:这是一个基于CNN的系统[14],扩展到多通道场景,如[18]所述,使用二进制和像素级二进制损失函数进行训练。此模型使用RGB和深度通道叠加在输入。

- MCCNN-OCCL-GMM:该模型是利用一类对比损失(OCCL)和高斯混合学习一类模型的多通道CNN系统,模型见[16]。该模型采用RGB-D通道作为输入。

- MC-ResNetDLAS:这是对[28]中的架构的重新实现,该架构在“CASIA-SURF”挑战赛中获得一等奖,基于开源实现将其扩展到RGB-D通道*。我们使用[28]中建议的最佳预训练模型的初始化,然后使用RGB-D通道在当前原型中进行再训练。

- RGBD-MH-BCE:这使用了图1所示的新提出的多头架构,其中所有分支都由二进制交叉熵(BCE)监督。本质上,这相当于在交叉模态损失函数的表达式中设置γ=0的值。这显示为一个基线,以展示新的多头架构单独的改进,并与新的损失功能的性能变化进行对比。

- 提出的结构:这是我们提出的框架,它使用了我们提出的多头架构,如图1所示,以获得新提出的损失函数。更具体地说,单个通道分支由新提出的跨模型焦点损失函数(CMFL)进行监督,基线方法的参数细节可以在我们的开源实现中找到。

3.5 实验

我们在WMCA和HQWMCA数据集中进行了实验,特别是在leave-one-out协议中评估了对未知攻击的鲁棒性。结果将在以下部分中描述。

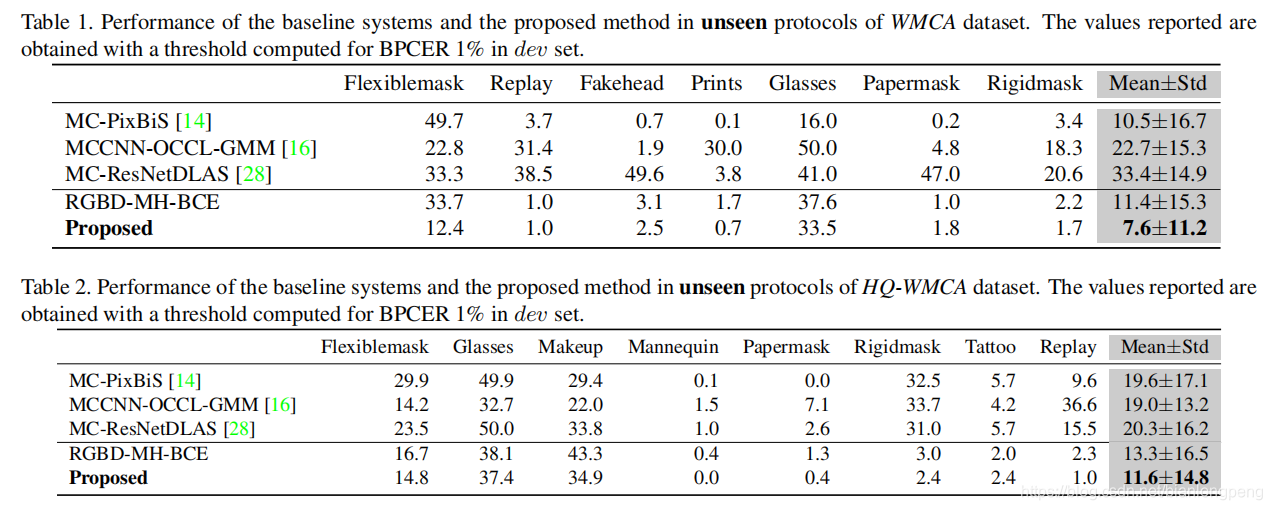

3.5.1 在WMCA数据集上的结果

该系统的性能和WMCA LOO协议的基线如表1所示。可以看出,基准MCCNN-OCCL-GMM和MC-ResNetDLAS在具有挑战性的未知攻击场景中表现不佳。MC-PixBiS模型的平均ACER为10.5±16.7%。与基准相比,采用新架构的模型RGBD MH-BCE具有合理的性能。然而,提出的方法结合新的CMFL损失达到最佳的平均精度。此外,与RGBD-MH-BCE相比,所提出的损失函数在性能上有明显的提高,平均ACER为7.6±11.2%。

3.5.2 在HQ-WMCA数据上的结果

与WMCA相比,HQ-WMCA数据集包含更具挑战性的攻击。具体来说,有不同类型的面部纹身和局部攻击,它们只占据面部的一部分。如果在训练集中看不到这些攻击,则很难检测到它们,因为它们看起来与真实的样本非常相似。HQ-WMCA的实验结果如表2所示。与WMCA数据库类似,基线MCCNN-OCCL-GMM和MC ResNetDLAS在HQ-WMCA数据库的LOO协议中表现不好。此外,MC-PixBiS方法在WMCA中取得了合理的性能,但在HQ-WMCA数据集上表现较差。这可能是因为数据库中的攻击具有挑战性。可以看出,新的多头架构的提出,RGBD-MH-BCE与所有基线相比,结果已经有所改善,平均ACER为13.3±16.5。此外,随着CMFL损失的增加,ACER进一步提高到11.6±14.8%。结果表明,该体系结构已经提高了系统的性能,在具有挑战性的攻击中,所提出的损失进一步提升了在HQ-WMCA数据集中达到的最好结果。

综上所述,新提出的多头体系结构与其他基线相比性能有所提升。结合添加的CMFL损失进一步提高了WMCA和HQ-WMCA数据集的性能。

3.6 消融实验

为了进一步分析性能,我们使用所提出的方法进行了各种消融实验。我们在HQ-WMCA数据集中进行了这些实验,因为它包含了更具挑战性的攻击。

3.6.1 γ \gamma γ的影响

首先,我们使用不同的γ值进行实验,我们报告了HQ-WMCA数据集中所有攻击的平均值(值),以便进行比较。不同γ值的结果如表3所示。可以看出,γ=3为最佳值。γ=0等价于于每个分支都是BCE损失。

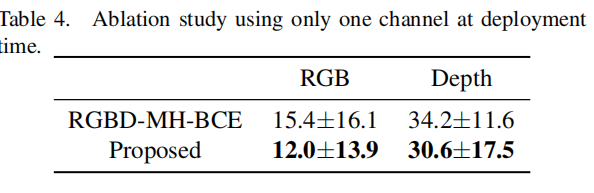

3.6.2 缺少通道时的表现效果

其次,我们在测试时仅用一个通道评估模型的性能。考虑一个场景,其中模型使用RGB和depth进行训练,并且在测试时,只有一个通道可用。我们比较了HQ-WMCA数据集在RGB和深度通道单独测试时的平均性能。结果见表4。对于基线RGBD-MH-BCE,在测试时单独使用RGB,错误率为15.4±16.1,而对于所提出的方法,错误率提高到12.0±13.9。对于深度通道,性能也有所提高。

从表4可以清楚地看到,当在部署时使用单个通道与BCE相比,性能有所提高。这表明,当不可能通过该模型分类的样本的损失贡献减少时,系统的性能提高。强迫单个网络学习决策边界会导致过拟合,导致泛化能力差。在所提出的方法中,网络也可以学习单个通道的鲁棒分类器。这一观察结果为在训练时使用多通道数据集和部署时仅为RGB通道提供了可能性。在部署时禁止使用额外硬件的场景中,这可能具有实际意义,即需要使用传统RGB相机部署PAD系统。

3.6.3 得分的细节分析

这里我们分析了所提出模型在HQ-WMCA数据集grandtest t c协议中的得分贡献。与LOO协议不同,grandtest tc包含在训练、开发和评估过程中大致平均分布的不同类型的攻击折叠。多头模型提供了各自个分支的三个不同的分数,即RGB、depth和RGB-D分支。这里我们展示了HQ-WMCA数据集测试集中的不同类型攻击的得分分布。

从图5可以看出,与深度通道相比,RGB头部的攻击更紧凑。在深度通道中,分类攻击比较困难,真实分布会向左移动。这也可以从深度通道攻击的得分分布可以看出,虽然攻击得分并没有我们期望的那么低,但它仍然很不真实,这种损失并不能促使深度分支正确地对所有攻击进行分类,它在深度通道包含区分信息的攻击中表现良好。从最后的RGB-D部分可以看出,所提出的损失函数使得使用来自各个通道的联合表示的分类具有鲁棒性。总之,该框架鼓励各个分支对另一个分支自信地分类的攻击生成非自信分数。以这种方式学习的来自联合分支的区分表示,产生了一个鲁棒的PAD系统。

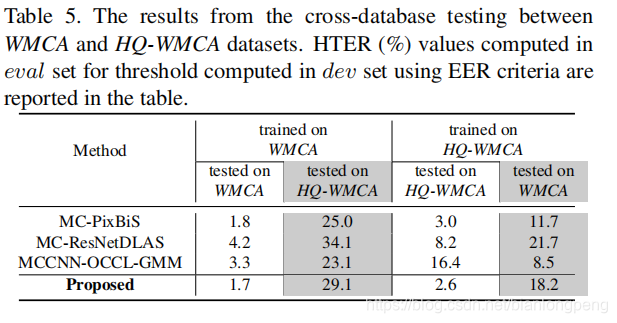

3.6.4 跨数据集评估

为了评估跨数据库场景中的稳健性,我们在WMCA和HQ-WMCA训练的模型之间进行了跨数据库实验。这种评估同时涉及到交叉传感器和不可见攻击,这比典型的交叉数据库评估更具挑战性。WMCA数据库使用Intel Realsense SR300相机,可返回RGB和深度流。IntelRealsense SR300使用点模式投影进行深度计算。而在HQ-WMCA中,RGB通道是使用高质量的Basler acA1921-150uc相机获取的,深度图像是使用Intel RealSense D415(使用立体声计算深度)捕获的。传感器之间的不匹配以及这些数据集中使用的传感器之间的质量使性能降低。交叉数据集测试的结果如表5所示。模型在每个数据集的grandtest协议上进行训练,并在另一个数据集的dev和eval集上进行评估。为了完整性,我们报告了数据库内和数据库间的性能。可以看出,在数据集内评估中,该方法在两个数据集中都取得了良好的性能。然而,在跨数据库评估中,性能会下降。传感器之间的不匹配可能是性能下降的原因之一。当在WMCA上评估HQ-WMCA训练的模型时,性能稍微好一些,这可能是由于训练集中存在更广泛的攻击种类。此外,可以看出,在目标数据集中性能较好的方法在源数据集中的性能较差。

3.7讨论

在WMCA和HQ-WMCA上的实验表明,该方法的性能优于现有的方法。我们还表明,所提出的方法在训练时有多个通道,部署时单个通道的情况下是有用的。尽管所提出的方法在数据集内的情况下工作得很好,但跨数据库的性能还需要进一步提高。在未来的工作中,可以开发更多的预处理和数据扩充策略来缓解数据集之间的差异,提高跨数据库的性能。虽然我们在本研究中选择了RGB和depth通道,主要是由于由这些通道组成的现成设备的可用性,但将本研究扩展到其他通道组合(例如RGB红外和RGB热通道)也很简单。

4. 结论

在这项工作中,我们提出了一种新的RGBD表示攻击检测体系结构,也适用于其他多通道的分类问题。此外,我们还提出了一种新的适用于双流网络的跨模型焦点损失函数。所提出的函数基于单个通道的置信度来调节样本的损耗贡献。该框架可以简单地扩展到多个通道和其中仅一个通道的信息不足以进行分类的问题。这种损失迫使网络学习互补的,有区别的,和稳健的代表性组成的渠道。该框架的结构使得使用所有可用通道来训练模型和使用通道子集来部署模型成为可能。在两个公开的数据集中进行了广泛的评估,证明了该方法的有效性。

5.Reference

[1] OpenCV AI Kit. https://opencv.org/introducing-oak-spatial-ai-powered-by-opencv/,2020. [Online; accessed 19-July-2020]. 2

[2] A. Agarwal, D. Yadav, N. Kohli, R. Singh, M. Vatsa, and A. Noore. Face presentation attack with latex masks in multispectral videos. In 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), pages 275–283, July 2017. 1

[3] A. Anjos and S. Marcel. Counter-measures to photo attacks in face recognition: a public database and a baseline. In Biometrics (IJCB), 2011 international joint conference on, pages 1–7. IEEE, 2011.1

[4] Y. Atoum, Y. Liu, A. Jourabloo, and X. Liu. Face antispoofing using patch and depth-based cnns. In Biometrics(IJCB), 2017 IEEE International Joint Conference on, pages 319–328. IEEE, 2017. 1

[5] S. Bhattacharjee and S. Marcel. What you can’t see can help you–extended-range imaging for 3d-mask presentation attack detection. In Proceedings of the 16th International Conference on Biometrics Special Interest Group., number EPFL-CONF-231840. Gesellschaft fuer Informatik eV (GI), 2017. 1

[6] S. Bhattacharjee, A. Mohammadi, and S. Marcel. Spoofing deep face recognition with custom silicone masks. Biometrics Theory, Applications and Systems (BTAS), 2018 IEEE 9th International Conference on, 2018. 1

[7] Z. Boulkenafet, J. Komulainen, and A. Hadid. Face antispoofing based on color texture analysis. In Image Processing (ICIP), 2015 IEEE International Conference on, pages 2636–2640. IEEE, 2015. 1

[8] I. Chingovska, A. Anjos, and S. Marcel. On the effectiveness of local binary patterns in face anti-spoofing. In Proceedings of the 11th International Conference of the Biometrics Special Interest Group, number EPFL-CONF-192369, 2012. 1

[9] A. Costa-Pazo, S. Bhattacharjee, E. Vazquez-Fernandez, and S. Marcel. The replay-mobile face presentation-attack database. In Biometrics Special Interest Group (BIOSIG), 2016 International Conference of the, pages 1–7. IEEE, 2016. 1

[10] T. de Freitas Pereira, A. Anjos, J. M. De Martino, and S. Marcel. Can face anti-spoofing countermeasures work in a real world scenario? In 2013 international conference on biometrics (ICB), pages 1–8. IEEE, 2013. 1

[11] T. I. Dhamecha, A. Nigam, R. Singh, and M. Vatsa. Disguise detection and face recognition in visible and thermal spectrums. In Biometrics (ICB), 2013 International Conference on, pages 1–8. IEEE, 2013. 1

[12] N. Erdogmus and S. Marcel. Spoofing face recognition with 3d masks. IEEE transactions on information forensics and security, 9(7):1084–1097, 2014. 1

[13] J. Gan, S. Li, Y. Zhai, and C. Liu. 3d convolutional neural network based on face anti-spoofing. In Multimedia and Image Processing (ICMIP), 2017 2nd International Conference on, pages 1–5. IEEE, 2017. 1

[14] A. George and S. Marcel. Deep pixel-wise binary supervision for face presentation attack detection. International Conference on Biometrics, 2019. 1, 5, 7

[15] A. George and S. Marcel. Can your face detector do antispoofing? face presentation attack detection with a multichannel face detector. Idiap Research Report, Idiap-RR-12- 2020, 2020. 1, 2

[16] A. George and S. Marcel. Learning one class representations for face presentation attack detection using multi-channel convolutional neural networks. IEEE Transactions on Information Forensics and Security, pages 1–1, 2020. 1, 2, 5, 6, 7

[17] A. George, Z. Mostaani, D. Geissenbuhler, O. Nikisins, A. Anjos, and S. Marcel. Biometric face presentation attack detection with multi-channel convolutional neural network. IEEE Transactions on Information Forensics and Security, pages 1–1, 2019. 1, 2, 5

[18] G. Heusch, A. George, D. Geissb¨uhler, Z. Mostaani, and S. Marcel. Deep models and shortwave infrared information to detect face presentation attacks. IEEE Transactions on Biometrics, Behavior, and Identity Science (T-BIOM), 2020. 1, 2, 5, 6

[19] G. Huang, Z. Liu, L. Van Der Maaten, and K. Q. Weinberger. Densely connected convolutional networks. In CVPR, volume 1, page 3, 2017. 3

[20] ISO/IEC JTC 1/SC 37 Biometrics. Information technology International Organization for Standardization. Iso standard, International Organization for Standardization, Feb. 2016. 5

[21] D. P. Kingma and J. Ba. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980, 2014. 5

[22] L. Li, Z. Xia, L. Li, X. Jiang, X. Feng, and F. Roli. Face anti-spoofing via hybrid convolutional neural network. In the Frontiers and Advances in Data Science (FADS), 2017 International Conference on, pages 120–124. IEEE, 2017. 1

[23] T.-Y. Lin, P. Goyal, R. Girshick, K. He, and P. Doll´ar. Focal loss for dense object detection, 2018. 4

[24] Y. Liu, J. Stehouwer, A. Jourabloo, and X. Liu. Deep tree learning for zero-shot face anti-spoofing. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4680–4689, 2019. 1

[25] J. M¨a¨att¨a, A. Hadid, and M. Pietik¨ainen. Face spoofing detection from single images using micro-texture analysis. In Biometrics (IJCB), 2011 international joint conference on, pages 1–7. IEEE, 2011. 1

[26] Z. Mostaani, A. George, G. Heusch, D. Geissenbuhler, and S. Marcel. The high-quality wide multi-channel attack (hqwmca) database, 9 2020. 5

[27] O. Nikisins, A. George, and S. Marcel. Domain adaptation in multi-channel autoencoder based features for robust face anti-spoofing. In 2019 International Conference on Biometrics (ICB), pages 1–8. IEEE, 2019. 2

[28] A. Parkin and O. Grinchuk. Recognizing multi-modal face spoofing with face recognition networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, pages 0–0, 2019. 2, 6, 7

[29] A. Paszke, S. Gross, S. Chintala, G. Chanan, E. Yang, Z. DeVito, Z. Lin, A. Desmaison, L. Antiga, and A. Lerer. Automatic differentiation in pytorch. In NIPS-W, 2017. 5

[30] R. Raghavendra, K. B. Raja, S. Venkatesh, and C. Busch. Extended multispectral face presentation attack detection: An approach based on fusing information from individual spectral bands. In Information Fusion (Fusion), 2017 20th International Conference on, pages 1–6. IEEE, 2017. 1

[31] H. Steiner, A. Kolb, and N. Jung. Reliable face anti-spoofing using multispectral swir imaging. In Biometrics (ICB), 2016 International Conference on, pages 1–8. IEEE, 2016. 1

[32] K. Zhang, Z. Zhang, Z. Li, and Y. Qiao. Joint face detection and alignment using multitask cascaded convolutional networks. IEEE Signal Processing Letters, 23(10):1499–1503, 2016. 2

817

817

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?