本术语表中列出了一般的机器学习术语和 TensorFlow 专用术语的定义。

以下内容可下载:https://download.csdn.net/download/bigdata_wangzhe/15543442

A

A/B 测试 (A/B testing)

一种统计方法,用于将两种或多种技术进行比较,通常是将当前采用的技术与新技术进行比

较。A/B 测试不仅旨在确定哪种技术的效果更好,而且还有助于了解相应差异是否具有显著

的统计意义。A/B 测试通常是采用一种衡量方式对两种技术进行比较,但也适用于任意有限

数量的技术和衡量方式。

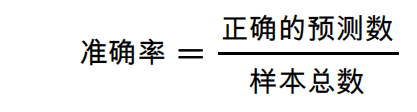

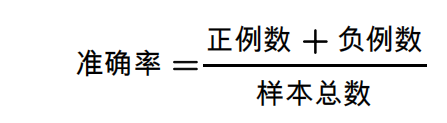

准确率 (accuracy)

分类模型 (#classi¦cation_model)的正确预测所占的比例。在多类别分类 (#multi-class)中,准确

率的定义如下:

在二元分类 (#binary_classi¦cation)中,准确率的定义如下:

请参阅正例 (#TP)和负例 (#TN)。

激活函数 (activation function)

一种函数(例如 ReLU (#ReLU) 或 S 型函数 (#sigmoid_function)),用于对上一层的所有输入求加权和,然后生成一个输出值(通常为非线性值),并将其传递给下一层。

AdaGrad

一种先进的梯度下降法,用于重新调整每个参数的梯度,以便有效地为每个参数指定独立的

学习速率 (#learning_rate)。如需查看完整的解释,请参阅这篇论文

(http://www.jmlr.org/papers/volume12/duchi11a/duchi11a.pdf)。

ROC 曲线下面积 (AUC, Area under the ROC Curve)

一种会考虑所有可能分类阈值 (#classi¦cation_threshold)的评估指标。

ROC 曲线 (#ROC)下面积是,对于随机选择的正类别样本确实为正类别,以及随机选择的负类

别样本为正类别,分类器更确信前者的概率。

B

反向传播算法 (backpropagation)

在神经网络 (#neural_network)上执行梯度下降法 (#gradient_descent)的主要算法。该算法会先按前向传播方式计算(并缓存)每个节点的输出值,然后再按反向传播遍历图的方式计算损失

函数值相对于每个参数的偏导数 (https://en.wikipedia.org/wiki/Partial_derivative)。

基准 (baseline)

一种简单的模型 (#model)或启发法,用作比较模型效果时的参考点。基准有助于模型开发者

针对特定问题量化最低预期效果。

批次 (batch)

模型训练 (#model_training)的一次迭代 (#iteration)(即一次梯度 (#gradient)更新)中使用的样本

集。

批次大小 (batch size)

一个批次 (#batch)中的样本数。例如,SGD (#SGD) 的批次大小为 1,而小批次 (#mini-batch)的

大小通常介于 10 到 1000 之间。批次大小在训练和推断期间通常是固定的;不过,

TensorFlow 允许使用动态批次大小。

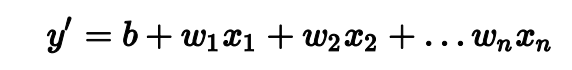

偏差 (bias)

距离原点的截距或偏移。偏差(也称为偏差项)在机器学习模型中用 b 或 w0 表示。例如,

在下面的公式中,偏差为 b:

请勿与预测偏差 (#prediction_bias)混淆。

二元分类 (binary classi‹cation)

一种分类任务,可输出两种互斥类别之一。例如,对电子邮件进行评估并输出“垃圾邮

件”或“非垃圾邮件”的机器学习模型就是一个二元分类器。

分箱 (binning)

请参阅分桶 (#bucketing)。

分桶 (bucketing)

将一个特征(通常是连续 (#continuous_feature)特征)转换成多个二元特征(称为桶或箱),

通常根据值区间进行转换。例如,您可以将温度区间分割为离散分箱,而不是将温度表示成

单个连续的浮点特征。假设温度数据可精确到小数点后一位,则可以将介于 0.0 到 15.0 度之

间的所有温度都归入一个分箱,将介于 15.1 到 30.0 度之间的所有温度归入第二个分箱,并

将介于 30.1 到 50.0 度之间的所有温度归入第三个分箱。

C

校准层 (calibration layer)

一种预测后调整,通常是为了降低预测偏差 (#prediction_bias)的影响。调整后的预测和概率应

与观察到的标签集的分布一致。

候选采样 (candidate sampling)

一种训练时进行的优化,会使用某种函数(例如 softmax)针对所有正类别标签计算概率,

但对于负类别标签,则仅针对其随机样本计算概率。例如,如果某个样本的标签为“小猎

犬”和“狗”,则候选采样将针对“小猎犬”和“狗”类别输出以及其他类别(猫、棒棒糖、栅栏)的

随机子集计算预测概率和相应的损失项。这种采样基于的想法是,只要正类别

(#positive_class)始终得到适当的正增强,负类别 (#negative_class)就可以从频率较低的负增强

中进行学习,这确实是在实际中观察到的情况。候选采样的目的是,通过不针对所有负类别

计算预测结果来提高计算效率。

分类数据 (categorical data)

一种特征 (#feature),拥有一组离散的可能值。以某个名为 house style 的分类特征为例,该

特征拥有一组离散的可能值(共三个),即 Tudor, ranch, colonial。通过将 house style 表示成分类数据,相应模型可以学习 Tudor、ranch 和 colonial 分别对房价的影

响。

有时,离散集中的值是互斥的,只能将其中一个值应用于指定样本。例如,car maker 分类

特征可能只允许一个样本有一个值 (Toyota)。在其他情况下,则可以应用多个值。一辆车可

能会被喷涂多种不同的颜色,因此,car color 分类特征可能会允许单个样本具有多个值

(例如 red 和 white)。

分类特征有时称为离散特征 (#discrete_feature)。 与数值数据 (#numerical_data)相对。

形心 (centroid)

聚类的中心,由 k-means (#k-means) 或 k-median (#k-median) 算法决定。例如,如果 k 为 3,则 k-means 或 k-median 算法会找出 3 个形心。

检查点 (checkpoint)

一种数据,用于捕获模型变量在特定时间的状态。借助检查点,可以导出模型权重 (#weight)

,跨多个会话执行训练,以及使训练在发生错误之后得以继续(例如作业抢占)。请注意,

图 (#graph)本身不包含在检查点中。

类别 (class)

为标签枚举的一组目标值中的一个。例如,在检测垃圾邮件的二元分类 (#binary_classi¦cation)

模型中,两种类别分别是“垃圾邮件”和“非垃圾邮件”。在识别狗品种的多类别分类

(#multi_class_classi¦cation)模型中,类别可以是“贵宾犬”、“小猎犬”、“哈巴犬”等等。

分类不平衡的数据集 (class-imbalanced data set)

分类不平衡的数据集 (class-imbalanced data set)

一种二元分类 (#binary_classi¦cation)问题,在此类问题中,两种类别的标签 (#label)在出现频率

方面具有很大的差距。例如,在某个疾病数据集中,0.0001 的样本具有正类别标签,0.9999

的样本具有负类别标签,这就属于分类不平衡问题;但在某个足球比赛预测器中,0.51 的样

本的标签为其中一个球队赢,0.49 的样本的标签为另一个球队赢,这就不属于分类不平衡问

题。

分类模型 (classi‹cation model)

一种机器学习模型,用于区分两种或多种离散类别。例如,某个自然语言处理分类模型可以

确定输入的句子是法语、西班牙语还是意大利语。请与回归模型 (#regression_model)进行比

较。

分类阈值 (classi‹cation threshold)

一种标量值条件,应用于模型预测的得分,旨在将正类别 (#positive_class)与负类别

(#negative_class)区分开。将逻辑回归 (#logistic_regression)结果映射到二元分类

(#binary_classi¦cation)时使用。以某个逻辑回归模型为例,该模型用于确定指定电子邮件是垃

圾邮件的概率。如果分类阈值为 0.9,那么逻辑回归值高于 0.9 的电子邮件将被归类为“垃圾

邮件”,低于 0.9 的则被归类为“非垃圾邮件”。

聚类 (clustering)

将关联的样本 (#example)分成一组,一般用于非监督式学习 (#unsupervised_machine_learning)。

在所有样本均分组完毕后,相关人员便可选择性地为每个聚类赋予含义。

聚类算法有很多。例如,k-means (#k-means) 算法会基于样本与形心 (#centroid)的接近程度聚

类样本,如下图所示:

之后,研究人员便可查看这些聚类并进行其他操作,例如,将聚类 1 标记为“矮型树”,将聚

类 2 标记为“全尺寸树”。

再举一个例子,例如基于样本与中心点距离的聚类算法,如下所示:

协同过滤 (collaborative ‹ltering)

根据很多其他用户的兴趣来预测某位用户的兴趣。协同过滤通常用在推荐系统中。

混淆矩阵 (confusion matrix)

一种 NxN 表格,用于总结分类模型 (#classi¦cation_model)的预测效果;即标签和模型预测的

分类之间的关联。在混淆矩阵中,一个轴表示模型预测的标签,另一个轴表示实际标签。N

表示类别个数。在二元分类 (#binary_classi¦cation)问题中,N=2。例如,下面显示了一个二元

分类问题的混淆矩阵示例:

上面的混淆矩阵显示,在 19 个实际有肿瘤的样本中,该模型正确地将 18 个归类为有肿瘤

(18 个正例),错误地将 1 个归类为没有肿瘤(1 个假负例)。同样,在 458 个实际没有肿

瘤的样本中,模型归类正确的有 452 个(452 个负例),归类错误的有 6 个(6 个假正

例)。

多类别分类问题的混淆矩阵有助于确定出错模式。例如,某个混淆矩阵可以揭示,某个经过

训练以识别手写数字的模型往往会将 4 错误地预测为 9,将 7 错

本文提供了机器学习领域的术语表,涵盖了从A到Z的关键概念,包括A/B测试、准确率、激活函数、反向传播算法、损失函数、梯度下降法、超参数等多个方面,帮助读者理解机器学习模型的基本组成部分和训练过程。

本文提供了机器学习领域的术语表,涵盖了从A到Z的关键概念,包括A/B测试、准确率、激活函数、反向传播算法、损失函数、梯度下降法、超参数等多个方面,帮助读者理解机器学习模型的基本组成部分和训练过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

353

353

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?