大家好,我是程序员小灰。

说起NVIDIA这个名字,大家一定不会陌生。

NVIDIA,中文名为英伟达,是全球知名的科技公司。NVIDIA早期专注于图形处理器(GPU)的设计和制造,近年来又成为了全球领先的人工智能公司,其产品和服务体系涵盖了人工智能应用的各个环节。

如今,在这个AI的黄金时代,NVIDIA已正式成为全球AI加速计算领域的领导者。

(图片来源:Bloomberg/GettyImages)

NVIDIA不仅在GPU技术上首屈一指,面向广大的AI开发者也十分友好。

为了能让众多开发者和企业更加丝滑地使用强大的AI模型,NVIDIA推出了一款端到端的云原生AI和数据分析软件套件NVIDIA AI Enterprise,提供企业级的安全性、支持服务和稳定性,能够确保以AI为基础开展业务的企业从原型到生产的平稳过渡。我们可以把NVIDIA AI Enterprise理解为企业AI的“操作系统”。

NVIDIA AI Enterprise经过不断迭代研究,于今年3月推出了最新的5.0版本。该版本包含许多新的功能,其中最重要的新功能之一,是一套加速推理微服务,名为NVIDIA NIM。

今天,小灰会为大家重点介绍这个全新的微服务。

一、什么是NVIDIA NIM推理微服务?

首先,我来简要介绍一下微服务的概念。

微服务架构是一种软件开发模式,将应用程序拆分成一组小型、自治的服务。每个服务都独立运行,并通过网络接口进行通信的架构模式称为微服务。那么微服务这种架构有什么好处?

最明显的优点,微服务架构风格有助于提高灵活性、可扩展性和可维护性,因为每个服务都可以独立开发、测试、部署和扩展。

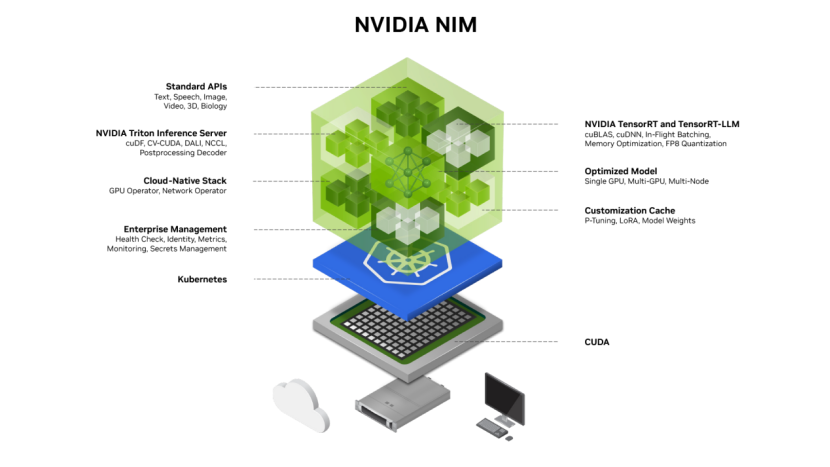

今天要给大家介绍的NVIDIA推出的NIM推理微服务则也是将大模型的推理调用算法模型服务封装成固定的接口,将大模型的运行与调用放在容器中进行隔离运行。

NIM的核心优势可以简要总结如下:

1.随时随地部署算法模型推理服务

NIM专为可移植性和可控性而构建,可以使得算法模型的部署与调用支持跨各种基础设施。

2.使用行业标准API与优化的推理引擎

开发者可以通过符合每个领域行业标准的API访问AI模型,从而简化AI应用的开发。NIM针对每个模型和硬件设置利用经过优化的推理引擎,在加速基础设施上提供尽可能好的延迟和吞吐量,从而优化算法调用推理的耗时。

3.体验优化性能

部署于系统内的NIM接口,对调用的延时有着严格的要求,NIM的底层集成了众多获取来自NVIDIA和社区的优化推理引擎,包括TensorRT、TensorRT-LLM、Triton推理服务器等,可提高AI接口服务的应用性能和效率,同时提供更低延迟、更高吞吐量的推理效果。

4.使用自定义AI模型

支持自定义化构建AI模型,NIM除提供官网的通用化大模型接口外,更多的提供了容器化部署模型的机制,无论是官网发布的通用类大模型,还是通过LoRA进行微调获得的自定义模型,都可以通过部署模型的接口,以便为特定用例提供模型接口调用,并且其后台使用Docker容器技术,将不同模型进行隔离处理,各个算法模型的调用互不影响。

5.适用于生产环境的构建

NIM的环境运维技术十分先进,拥有具有专属功能分支和严格验证流程的企业级软件,确保算法应用程序准备就绪,可以进行生产部署,除适用于个人环境下的算法模型接口的部署,更适用于企业级稳定要求的生产环境构建。

二、如何使用NVIDIA NIM推理微服务

在第一节中我们介绍了NIM的工作原理,那么剩下的我们废话不多说,直接讲解如何使用NVIDIA发布的NIM推理微服务。其实NVIDIA NIM的入门非常简单。在NVIDIA API目录,开发者可以访问各种AI模型,这些模型可用于构建和部署自己的AI应用。

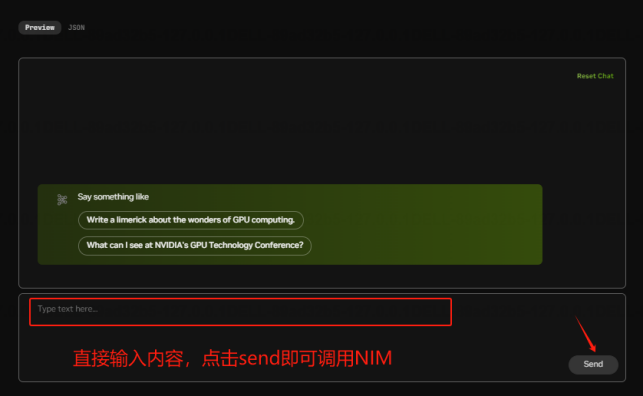

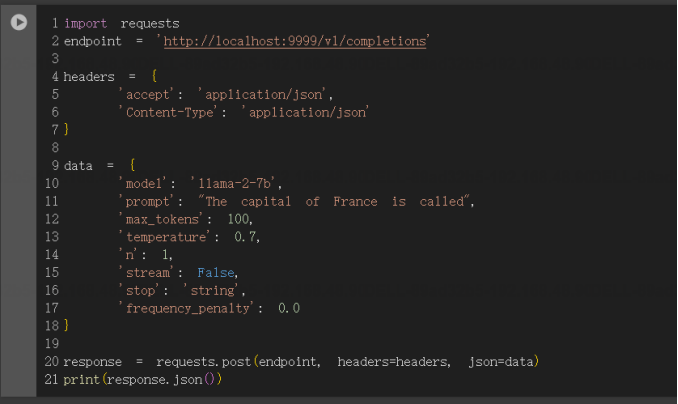

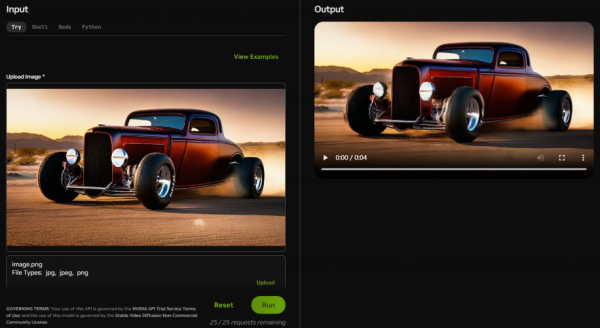

通过图形用户界面直接在目录中开始原型设计,或直接与API免费交互。NVIDIA的NIM推理微服务调用方法分为:容器化调用以及API的接口的调用。

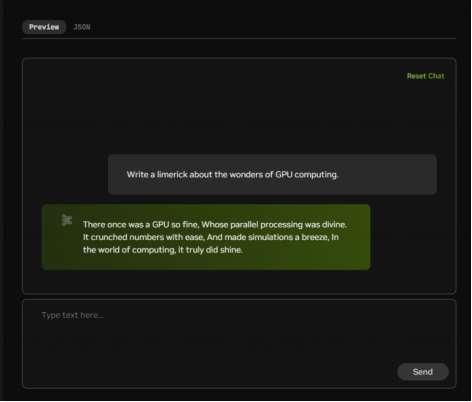

1.图形化界面调用使用:

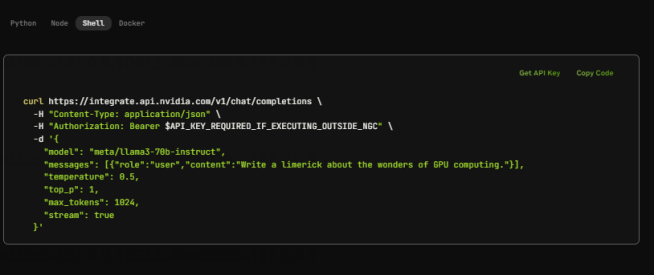

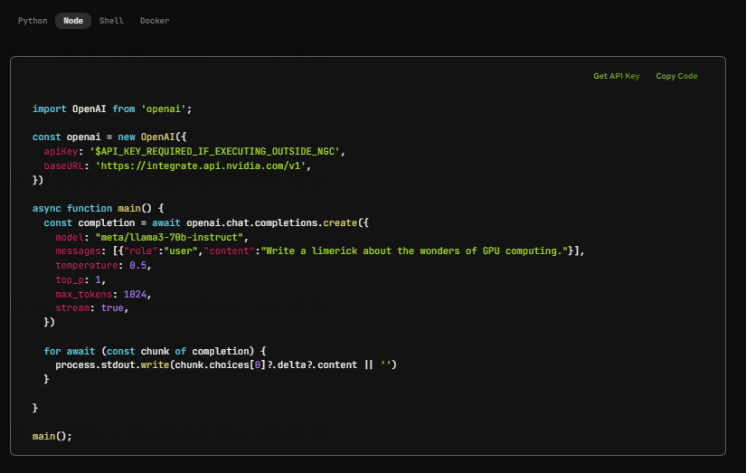

2.官网提供的API接口调用使用:

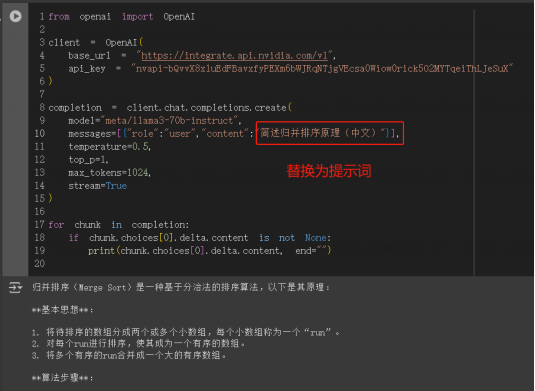

这一部分的调用方法是常用在工程角度的,通过HTTP请求的格式访问部署的API接口。

通过Linux系统中的curl请求API的接口链接,返回模型的推理结果进行后续的逻辑处理,进而成功集成到系统里面。

要在基础设施上部署微服务,只需注册NVIDIA AI Enterprise 90天评估许可证,并按照以下步骤操作即可部署我们自己的算法服务了!

·试用链接:

申请免费的90天NVIDIA AI Enterprise许可证

https://www.nvidia.cn/data-center/products/ai-enterprise/

·查看NIM官方页面,了解更多信息:

https://developer.nvidia.cn/nim

下面正式进入NIM的部署流程,详细阐述一下最新的NIM应该如何进行部署使用:

部署环境条件准备:

·NVIDIA GPU要求:

支持任何带有足够GPU内存的NVIDIA GPU。

支持具有张量并行性的同质多GPU系统。

·CPU要求:仅支持x86_64架构。

·CUDA驱动程序:

建议通过网络仓库使用包管理器安装,无需安装CUDA工具包,因为库文件将包含在NIM容器中。

为了检验以上系统环境的可用性,执行以下命令:

docker run --rm --runtime=nvidia --gpus all ubuntu nvidia-smi生成部署私有Key

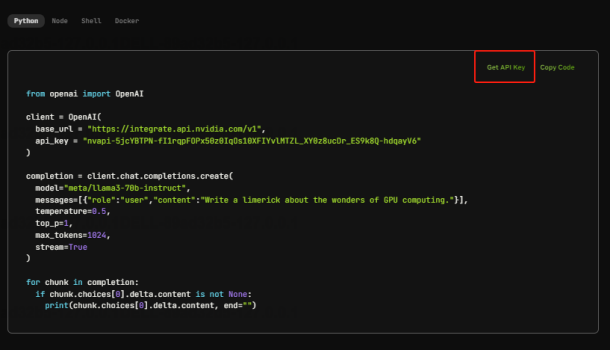

点击Python脚本的右上角的“get API key”

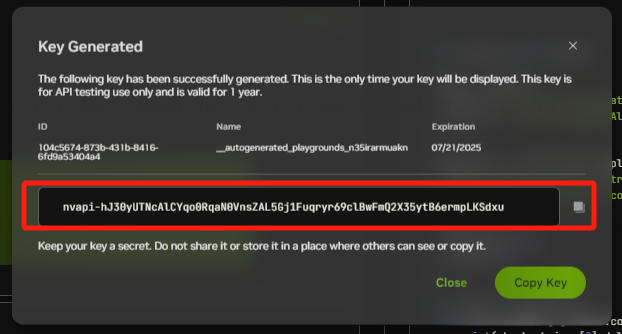

获取生成的API key的字符串,放入请求脚本内的API key字段即可实现正常调用。

以下则为完整的调用脚本,即可集成到自己的系统中,可以看到调用成功,将请求变量中的content字段转为自己的提示词即可。

工程中集成NIM的微服务,大多数的时候是使用Python的API库进行调用使用的,可以开始使用标准REST API发出请求,以下是请求的客户端的环境要求:

首先需要安装OpenAI的第三方库:

pip install openai编写Python请求代码:

三、NVIDIA NIM推理微服务的领域应用

学会了NIM的基本使用,我们可以怎么样去使用NIM推理微服务优化我们自己的系统服务呢?

1.首先是通过可交互API的使用(部署在NGC https://catalog.ngc.nvidia.com/上,网页端则是提供给用户交互测试)

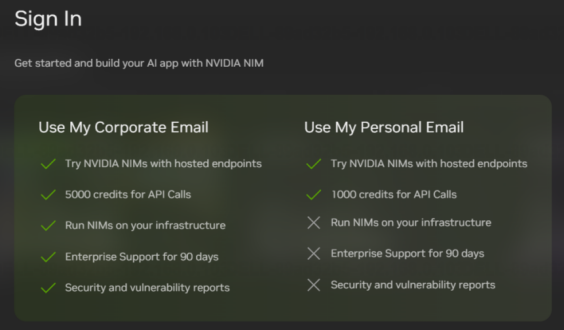

2.通过容器化部署(可以部署在自己的基础设施上),大家记得在使用之前需要先注册账号,才有接口的调用额度:

在这里个人邮箱注册与企业邮箱注册存在区别,对于大部分人来说,使用个人邮箱注册即可,一个邮箱就有1000的API调用额度。

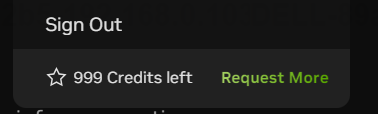

使用个人邮箱账户注册即可,注册过程稍微有点繁琐,需要验证邮箱的链接地址,一直到最后你可以看到账户的余额。

好的,有了接口的调用额度,在这里小灰主要以以下几个行业中的AI服务接入NVIDIA NIM推理微服务,进行讲解:

3.1使用Llama 3模型接入智能问答系统的使用:

NIM的推理大模型最出色的功能就是文本的问答功能,比较具代表性的有Llama 3大模型,Llama 3:Meta的新一代开源大语言模型,可以代替人工对话的场景部分,以下是使用的场景之一。

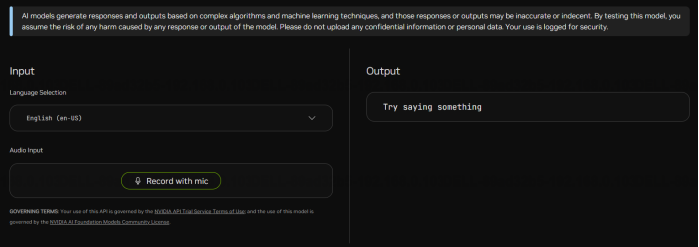

并且进行对话的过程,语言中文以及英文都可以支持,同时还可以融合语音识别的功能,将打字输入转换为语音识别输入。

十分适合接入智能问答系统,从而代替人工的问题解答。

语音识别部分:

NVIDIA NIM推理微服务的功能实现的语音识别服务接口,通过调用PC机的麦克风实现录音识别文字。再将识别的文字放入以上的Llama 3模型接入智能问答系统进行问题的回答,即可实现语音对话了。

如以上图,将智能对话部分加入语音合成模块,即可实现机器人自由对话。

当然真正的融入我们的项目系统中,使用的是API接口形式;

前端界面调用方式:

Python代码调用方式:

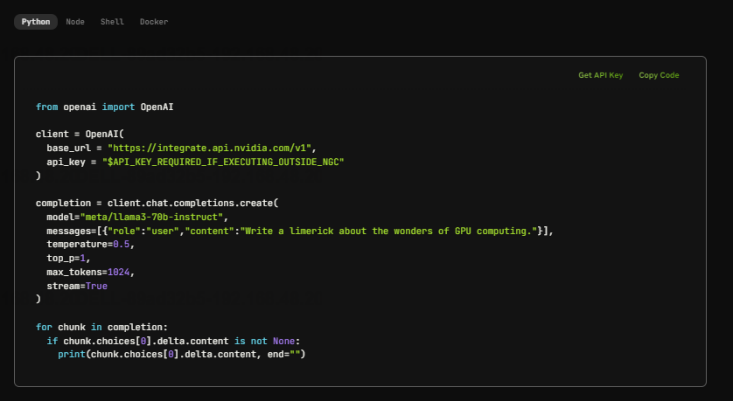

3.2将NVIDIA NIM助力于游戏设计行业:

说起来,目前最为火爆的当属于游戏行业,NVIDIA NIM推理微服务可以对游戏行业很多领域的工作进行助力提效。

游戏中的角色绘制以及场景环境使用,文本转换为3D建模的接口服务功能,快速绘制游戏中的角色以及坐骑。

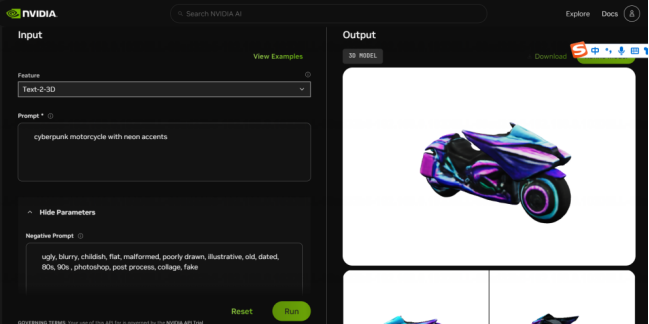

类似游戏制作,一些开头的动画也可以使用NIM进行调用生成,不仅如此,NVIDIA NIM形成了基于图片生成视频的算法模型:

用于快速生成赛车游戏中的一些经典动画,可以看到生成的效果还是很逼真的!

3.3NVIDIA NIM引领各行业应用:

NIM对于手术规划、数字助理、药物研发和临床试验优化等有广泛的用例,以前文提到的Llama 3为例,开发者可以使用Llama 3为copilot、聊天机器人等轻松部署经过优化的生成式AI模型。以下是目前正在被广泛使用的几种NIM落地医疗场景的应用:

1.Transcripta Bio: 使用Llama 3和BioNeMo加速智能药物研发,通过Drug-Gene Atlas预测新药效果。

2.ConcertAI: 集成Llama 3 NIM支持临床试验患者匹配、研究自动化和现场助手。

3.Mendel AI: 部署Llama 3 NIM用于临床研究,性能提升36%,并探索从患者记录中提取临床信息和生成临床查询。

这些应用展示了Meta Llama 3和NVIDIA的生成式AI技术如何显著提升医疗健康和生命科学工作流的效率和效果,推动数字生物学、手术、药物研发、临床试验以及数字健康的创新发展。NVIDIA于6月在COMPUTEX上宣布,数百个AI生态系统合作伙伴正在将NIM嵌入他们的解决方案中。

其中有超过40个合作伙伴是医疗健康和生命科学初创公司和企业,他们使用Llama 3 NIM来构建和运行可加速数字生物学、数字手术和数字健康的各种应用。

NIM可以通过上述中的开发者会员机制以及90天免费使用的办法获取,推荐大家申请免费的90天NVIDIA AI Enterprise许可证,仅仅需要一个邮箱即可,赶快尝试搞起来吧。

https://developer.nvidia.cn/nim

四、写在最后

小灰初次接触AI领域是在2023年的3月,如今仅仅过去一年多,AI技术就有了沧海桑田的变化。难怪行业里有人调侃:AI一天,人间一年。

看到AI技术越来越强大、应用越来越广泛,我感到的是惊奇和兴奋。很感谢这个全新的AI时代,为我们普通人带来无数宝贵的机会。

希望大家继续关注AI领域,关注NVIDIA,关注小灰。AI未来的美丽蓝图,将由我们一起来谱写!

963

963

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?