一、什么是稀疏激活函数(ReLU)

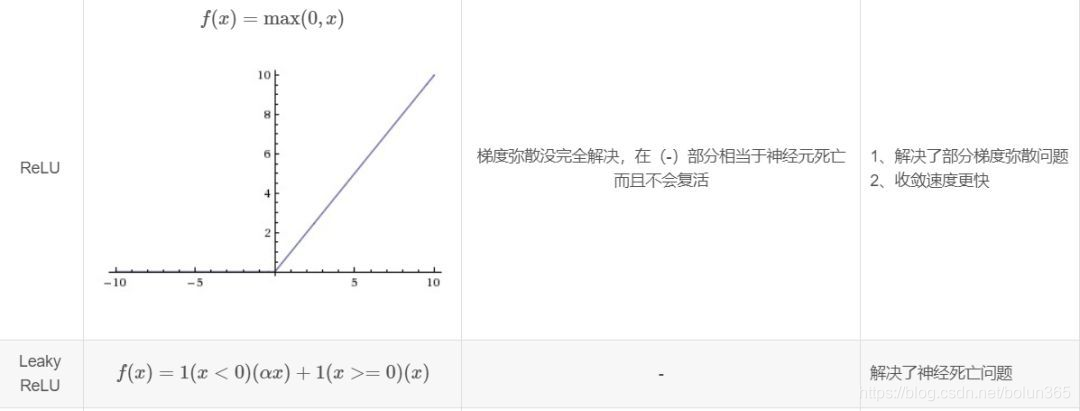

ReLU全称是Rectified Liner Uints,其具体形式为y=max(0,x)。

ReLU具有:1、单侧抑制;2、相对宽阔的兴奋边界;3、稀疏激活性等优点。

二、为什么ReLU更有效?

生物研究表明:生物神经元只对输入信号中很少部分进行响应,大部分信号则被刻意屏蔽掉了。这样做可以更好的提高学习精度,更好更快的提取稀疏特征。这表现为生物神经元的稀疏激活性。

三、稀疏性的优势

1、信息解离。原始输入数据往往缠绕着高密度特征,特征之间相互耦合,表现出强烈的非线性特征。传统学习算法往往是采用高维映射等手段进行信息解理,但是往往难以很好的进行解耦。若能通过手段将这些特征转换为稀疏特征,则特征之间耦合更小,特征鲁棒性更强。

2、线性可分。稀疏性特征之间耦合更小,具有更好的线性可分性,对非线性映射机制依赖性更小,用一些简单的线性分类器就可以达到很好的分类效果。

3、稠密但稀疏。原始数据所表现出来的稠密特性,其包含的信息远多于局部特征点;而稀疏性是从稠密特征中解耦得来,在线性可分的同时也保留了原始稠密特征的性能,具有很大的潜力。

四、稀疏激活函数的优势

若激活函数具有稀疏性,则可以更好的从有效的数据维度上,学习到相对稀疏的特征,起到特征自动解耦的作用。

1、非饱和线性端。相比于BP网络、SVM等分类器。采用线性激活函数,网络更快更高效。

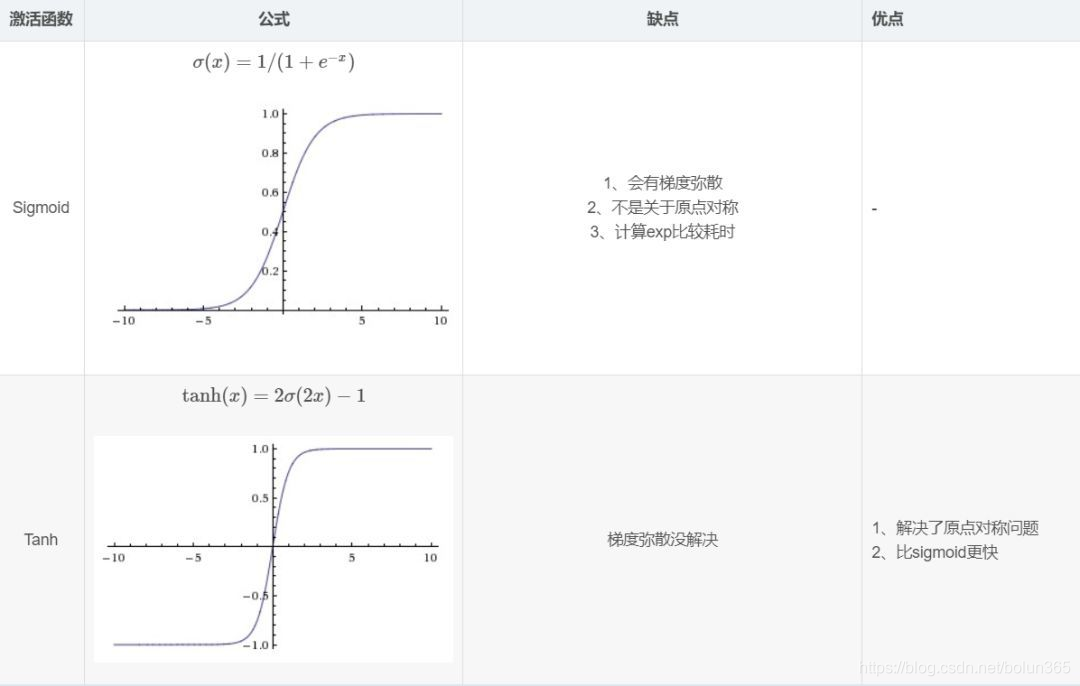

2、消失的梯度问题。传统的Sigmoid函数在反向传播中,随着传播层数的增加,误差梯度急剧衰减,导致学习效率低下。这也是为什么传统神经网络往往都是浅层神经网络,因为随着隐藏层的增加,误差梯度在反向传播时对前几层的影响几乎减小至零。但是ReLU的误差梯度是1,可以很好的在网络之间传播,相比于sigmoid、tanh激活函数,学习速度更快。

3、目前的DL架构中,合理的稀疏性比率为70~80%,否则屏蔽特征多过,容易出现欠拟合现象。

五. relu不足:

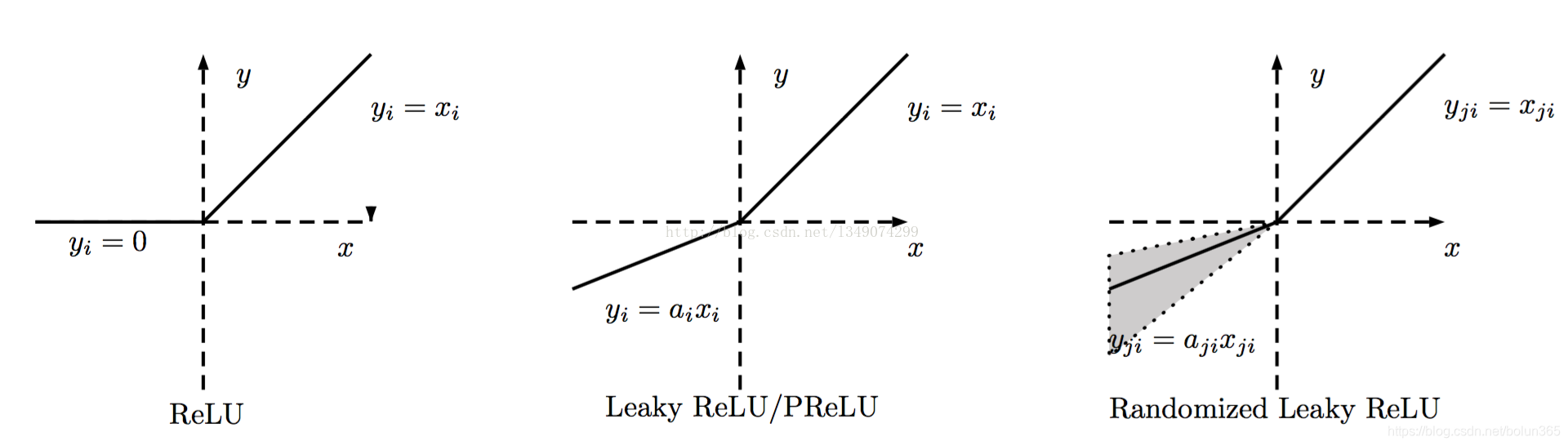

在学习率较大时容易出现死神经元, 使梯度稀疏. 在DCGAN网络的判别器中, 会使用leakrelu减小影响, 生成器输出层使用tanh代替.

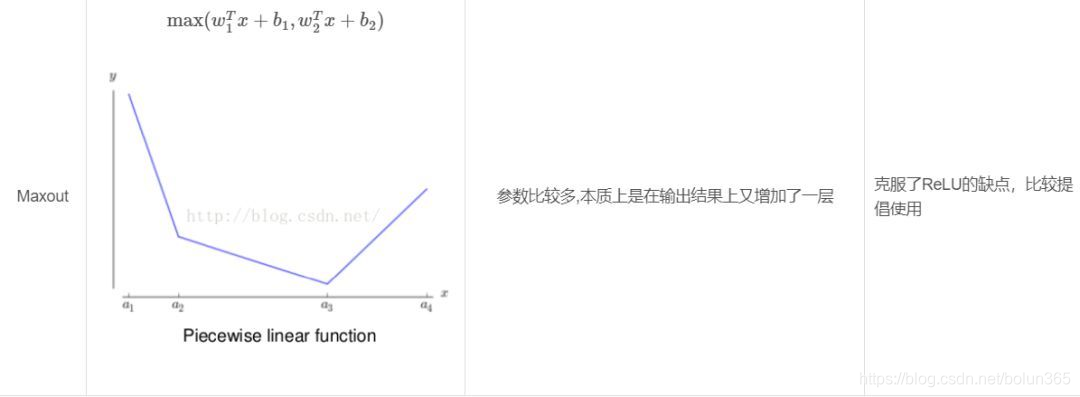

六. relu与其它激活函数比较

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?