虽然Linux环境下已经安装了Spark,但很多时候,在IDEA中使用Spark环境开发也是很有必要的;

本例中选择Spark的版本号2.4.5,scala工具包的版本是2.11:

1.新建一个maven工程,选择org.scala-tools.archetypes:scala-archetype-simple (假定idea中已经配了scala插件包)

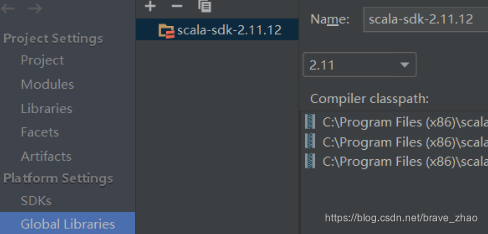

2.进入Maven后,检查Project Structure中Global Libraries(公共库),scala工具包是不是scala-sdk-2.11.12版本,移除不对的版本

3.配置pom.xml文件:

(1).修改scala.version为2.11.12

(2).搜索mavenrepository --> Spark Project Core和Spark ProjectSQL,选择spark版本是2.4.5,scala版本为2.11,maven开启自动导包下载

<!-- https://mvnrepository.com/artifact/org.apache.spark/spark-core -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.11</artifactId>

<version>2.4.5</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.spark/spark-sql -->

<dependency>

<groupId>org.apache.spark</groupId>

< IDEA中搭建Spark 2.4.5开发环境教程

IDEA中搭建Spark 2.4.5开发环境教程

本文手把手教你如何在IDEA中搭建Spark 2.4.5的开发环境,包括创建Maven工程,配置Scala版本,添加Spark依赖,解决 jar 包问题,删除测试文件,调整日志级别,最终实现干净的控制台输出。

本文手把手教你如何在IDEA中搭建Spark 2.4.5的开发环境,包括创建Maven工程,配置Scala版本,添加Spark依赖,解决 jar 包问题,删除测试文件,调整日志级别,最终实现干净的控制台输出。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

593

593

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?