论文题目:

CoDA: Collaborative Novel Box Discovery and Cross-modal Alignment for Open-vocabulary 3D Object Detection

论文地址:

https://arxiv.org/pdf/2310.02960

代码地址:

https://github.com/yangcaoai/CoDA_NeurIPS2023

研究背景

计算机视觉中的 3D 目标检测(3D Object Detection)是一项重要而具有挑战性的任务,在自动驾驶、工业制造和机器人等领域有着广泛的应用。然而,传统的 3D 目标检测方法通常依赖于预定义的已知类别(Base Categories)集合,无法有效处理新类别物体的检测,但在实际应用场景中通常会出现新物体类别(Novel Categories),导致传统 3D 目标检测出错。

为了解决这一关键问题,开放词汇 3D 目标检测(Open-Vocabulary 3D Object Detection)开始得到关注。开放词汇 3D 目标检测模型可以在应用(测试)场景中,灵活地调整要检测的类别列表和检测新类别,更加贴近实际场景。

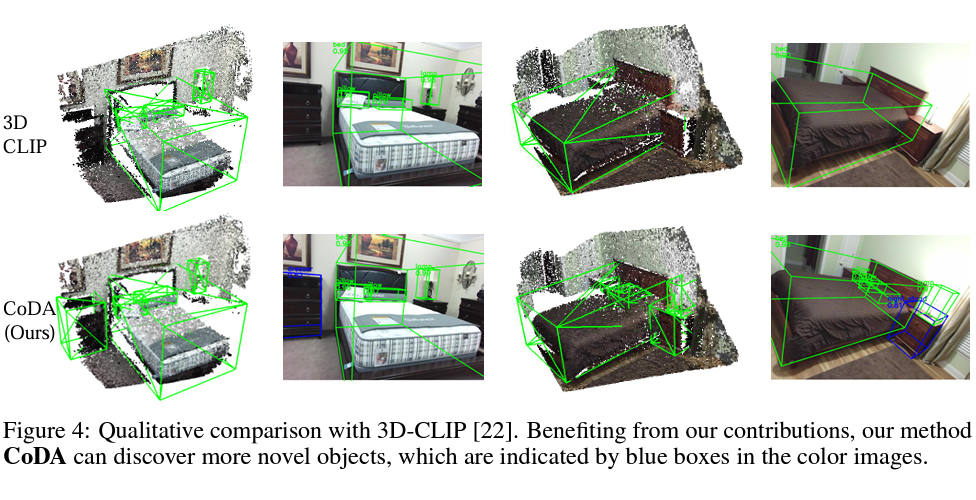

如 Fig.1 所示,开放词汇 3D 目标检测模型 CoDA 只由绿色框 label 训练,但可以检测到蓝色框标注的物体。目前开放词汇 3D 目标检测这个研究方向刚刚发展,研究空间大。

该 NuerIPS2023 论文专注于开放词汇 3D 目标检测,提出了一种名为 CoDA 的协同式新物体发掘与跨模态对齐方法(Collaborative Novel Box Discovery and Cross-modal Alignment),以在训练中同时学习对新类别物体的定位和分类。首次在不引入 2D 物体检测模型的前提下实现了开放词汇 3D 目标检测,检测效果在 SUN-RGBD 上超过其他方法 80% 以上。该研究工作的代码和模型已全部开源在:

https://github.com/yangcaoai/CoDA_NeurIPS2023

主要贡献

本论文的主要贡献如下:

提出了端到端的开放词汇 3D 检测框架 CoDA,该框架通过设计协同式 3D 新物体发掘(3D Novel Object Discovery)与发掘驱动的跨模态对齐方法(Discovery-driven Cross-modal Alignment)解决了开放词汇 3D 目标检测中对新类别物体进行定位和分类问题。

设计了 3D Novel Object Discovery(3D-NOD)模块,通过利用 3D 几何先验和 2D 开放语义先验,实现了对新类别对象的定位。

设计了 Discovery-Driven Cross-Modal Alignment(DCMA)模块:基于 3D-NOD 发现的新物体,对 3D 点云、2D 图像、文本之间进行跨模态对齐,实现了对新类别对象的分类。

在两个具有挑战性的数据集 SUN-RGBD 和 ScanNet 上进行了广泛的实验评估,验证了 CoDA 框架的效果优势。

框架

CoDA 框架由以下关键组件组成:3D Novel Object Discovery(3D-NOD)模块、Discovery-Driven Cross-Modal Alignment(DCMA)模块。一方面,3D-NOD 模块利用 3D 几何先验和 2D 开放语义先验生成新对象的伪标签,以实现对新类别物体的定位。另一方面,DCMA 基于 3D-NOD 发现的新物体,对 3D 点云、2D 图像和文本进行跨模态对齐,实现了对新类别物体的分类。

技术细节

3D Novel Object Discovery(3D-NOD):

在 3D-NOD 模块中,利用 3D 几何先验和 2D 开放词汇语义先验生成新类别的伪标签。

具体而言,3D 检测器的定位头(Localization head)预测 3D box,然后基于相机参数将 3D box 映射到 2D 图像上的 2D box,取出对应的 2D 物体区域,再通过 CLIP 的 image encoder 得到 2D image features,继而和 CLIP 的 text encoder 输出 Open Categories 的 text features 计算相似矩阵,以得到 2D 开放词汇语义先验。会输出 3D 几何先验(分类头预测的 objectness 得分)。当 2D 开放词汇语义先验和 3D 几何先验

都超过阈值,并且和已知物体标签的 IoU 小于 0.25,则认定该物体为新类别物体,并更新到 novel label pool 里。随着训练,novel label pool 和模型都得到了迭代式的更新。

Discovery-Driven Cross-Modal Alignment(DCMA):

DCMA 模块基于 novel label pool,通过类别匿名的特征蒸馏(Class-Agnostic Distillation)和类别特定的特征对齐(Class-Specific Contrastive Alignment),在更广的语义上进行跨模态对齐。

详细而言,每个 object query 会预测得到(3D box,3D objectness, 3D object features)。在 Class-Agnostic Distillation Module,每个 3D box 会映射到 2D 图像上的 2D box,再取出对应的 2D 物体区域,继而输入到 CLIP Image Encoder 中得到 2D object features,然后对该 2D object features 和与之对应的 3D object features 计算蒸馏 loss(L1 loss),到此实现了 3D 和 2D features 的对齐。

在 Class-Specific Contrastive Alignment Module 中,会把预测的 3D box 与 novel label pool 里的伪 label 和人工标注的已知类别 label 进行二分图匹配(Bipartite Matching),以此为该 3D box 匹配到类别 text 标签,再对 3D features 和 text features 进行 contrastive loss,到此实现了 3D 和 text features 对齐。综上所述,DCMA 实现了 3D、2D 和 text features 之间的对齐。

消融实验

围绕着 CoDA 的两个核心创新点 3D-NOD 和 DCMA,该论文做了一系列消融实验,如 Tab.1 所示,相对于 3DETR+CLIP 的朴素的开放词汇检测方法,CoDA 取得了显著的提升。当去掉 3D-NOD 时,效果显著下降,证明了 3D-NOD 本身带来了显著提升。当把 DCMA 替换成朴素的跨模态对齐时,3D-NOD+DCMA 的效果有显著优势,证明了 DCMA 相对于其他对齐的优越性。

在训练过程中,该论文持续监控评测了中间模型的检测效果。可以看到在进入 3D-NOD 阶段后,Novel 类别的 AP 和 AR 都得到了显著提升,显示了 3D-NOD 的有效性。

实验结果

本研究在两个具有挑战性的 3D 数据集 SUN-RGBD 和 ScanNet 进行了广泛的实验评估。在 Tab.4 和 Tab.5 可以看到,CoDA 框架对 Novel 类别和已知类别(Base Category)的检测取得了显著的性能优势。从 Fig.4 和 Fig.F 中,CoDA 能够准确检测到蓝色框框住的 Novel category 物体,同时对绿色框框住的 Base category 物体的检测也更加准确。

结论

本论文提出的 CoDA 包含了协同式新物体发掘与跨模态对齐方法(Collaborative Novel Box Discovery and Cross-modal Alignment),解决了开放词汇 3D 目标检测中的 Novel 类别物体定位和分类问题。实验证明,CoDA 在 Novel 类别检测上具有显著的性能优势。未来,可以进一步改进 CoDA 框架,比如采用更强的检测框架、更强的 2D 开放词汇模型等思路,提高其在更复杂场景和真实应用中的鲁棒性和泛化能力。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

·

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?