摘要

由于视点变化、光照变化和外观变化等原因,属性识别是一项重要而又具有挑战性的任务。以往的工作大多只考虑属性级特征嵌入,在复杂的多类别识别条件下性能较差。为了解决这一问题,我们提出了一种层次特征嵌入(HFE)框架,该框架通过结合属性和ID信息学习细粒度特征嵌入。在HFE中,我们同时维护了类间和类内特征的嵌入。将具有相同属性的样本和具有相同ID的样本更紧密地聚集在一起,限制了视觉上的难样本在属性方面的特征嵌入,提高了对变化条件的鲁棒性。我们利用由属性和ID约束组成的HFE loss建立了该层次结构。我们还引入了绝对边界正则化和动态损失权作为辅助组件,以帮助建立特征嵌入。实验表明,我们的方法在两个行人属性数据集和一个人脸属性数据集上都达到了最先进的效果。

说明

性别、头发长度、服装款式等属性可作为区分性语义描述符,用于视觉监测的软生物识别。属性识别集中于识别给定图像中目标人体的这些属性。它包括行人属性识别(PAR)、人脸属性识别(FAR)等。近年来,属性识别因其在行人重识别(reid)[22,26,36]、人脸验证[21,6,46,34,45]和行人识别[15]等方面的潜在应用而备受关注。它本质上是一个分类问题,在现实场景中仍然面临着巨大的挑战,原因如下:(1)由于镜头距离或行人的移动,图像可能是低分辨率或模糊的。(2)不同的场景、时间段、角度和姿势会导致光照变化、视角变化和外观变化。(3)物体的某些部分可能被其他部分遮挡,导致不可见或模糊。

最近,一些方法被介绍来解决这些问题,并取得了令人满意的性能。A-AOG[35]明确表示身体各部分的分解和清晰度,并解释了姿态和属性之间的相关性。LGNet[28]根据预先提取的建议和属性位置之间的相关性,将属性特定的权重分配给局部特征。这些方法旨在利用图像的关键部分或注意模块在一定程度上减少不相关因素的影响,但它们并没有直接处理属性的视觉外观变化和遮挡。这些方法只关注属性级优化,而来自属性识别相关领域的信息,如person Re-ID,可以通过施加更强的约束来帮助缓解变化和遮挡问题。

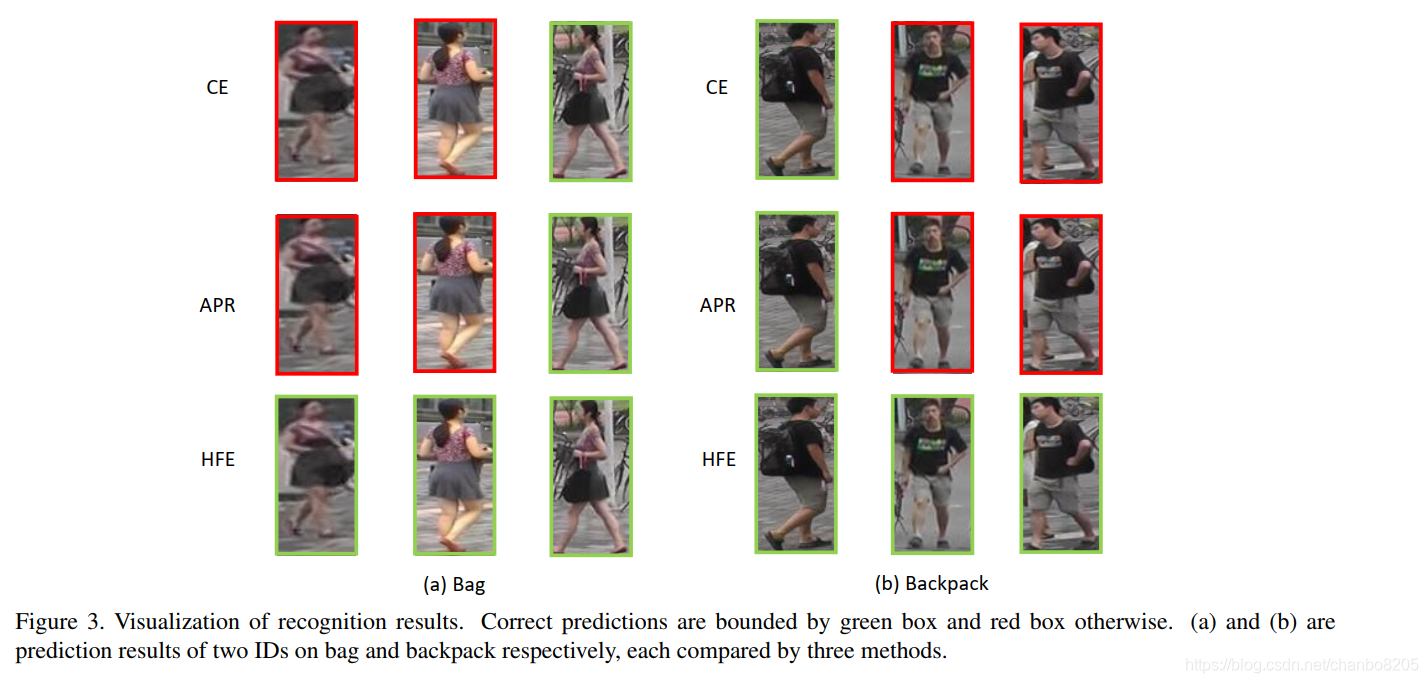

从数据的角度来看,当前属性数据集均按ID或跟踪粒度进行标记[25,32],以减少工作量。因此,我们假设从相同身份捕获的图像应该具有相同的属性,但不反之亦然。对于每个属性,由于昂贵的注释成本,标签通常是粗粒度的。不同的人可能得到相同的属性标签,但在外观上有细微的差异。例如,不同颜色和质地的背包都被标记为backpack。因此,需要细粒度的特征嵌入属性来表示类内的变化。利用身份信息,我们可以建立两级特征嵌入,即类间和类内(下图)。对于每个属性,具有相同属性的样本形成粗粒度类,而在每个属性类中,来自同一个人(绝对具有相同属性)的样本构建细粒度ID簇。引入层次特征嵌入模型的动机如下:

(1)ID聚类将相同ID但不同视点、光照和外观的图像更紧密地聚集在一起,嵌入具有场景不变性的属性特征,提高鲁棒性。

(2)属性的难例可以通过ID约束很容易地处理,并被相同ID的其他简单样本拉回,这只在属性层很难学习。

(3)与属性标签一样,ID标签也在属性语义中使用,保持上述假设,避免了以往的工作直接将不同的语义特征整合到同一特征空间中[25]

基于上述观察,我们提出了一个层次特征嵌入(HFE)框架,通过结合属性和ID信息来维持类间和类内特征嵌入。引入HFE loss用于细粒度特征嵌入,该方法包括两个triplet loss和与所选五元组(quintuplets)的绝对边界正则化。有了HFE loss约束,每个类别可以更紧密地聚集在一起,导致类别之间更明显的边界。对于附加的绝对约束,我们提出了绝对边界正则化,因为triplet loss只考虑了两个距离的差值,而忽略了绝对值,类内triplet loss可能与类间边界间接相互作用。另外,五元组(quintuplets)的选择与当前的特征空间有关。但是,在训练初期,特征空间对五元组(quintuplets)选择的信心不够,所以我们设计了一个动态的减权,使HFE的减权随着学习过程逐渐增加。综上所述,本文的贡献有:

•我们提出了基于属性语义集成ID信息的HFE框架,以实现细粒度特征嵌入。针对类间和类内约束,提出了一种新的HFE loss。

•我们构造了一个绝对边界正则化,通过在一个绝对约束下强化原来的triplet loss。

•我们引入了动态损失权值,迫使特征空间从原点过渡到改进的HFE 受限空间。

•在两个行人属性数据集和一个人脸属性数据集上对该方法进行评估。实验结果表明,我们的方法在所有三个数据集上都达到了最先进的结果。

相关工作

1.属性识别

近年来,基于深度学习的属性识别方法取得了令人瞩目的成绩。在PAR中,这些方法包括基于全局的[23,41,1,7]、基于局部部分的[28]、基于视觉注意的[31]、基于序列预测的[55]等。其中,DeepMar[23]是一个早期全球基于PAR的作品。考虑到数据分布的不平衡,提出代价敏感交叉熵(CE)损失分类方法。提出了处理不平衡数据的新损失和新的注意机制。LGNet[28]根据预先提取的建议和属性位置之间的相关性,将属性特定的权重分配给局部特征。Hydraplus-Net[31]提出了一种基于注意力的模型,利用单个行人图像的多层次特征融合来挖掘全局和局部内容。ALM[47]的目标是通过属性定位学习属性感知表示。基于属性感知的注意模型[11]利用全局特征和属性特定特征之间的相关性,以交互的方式生成注意掩码。通过描述[30]的局部化,在弱监督的情况下,利用设计的奖励函数强化算法,明确学习属性位置相关的包围盒。为了解决数据不平衡问题,[39]设计了一种融合多尺度特征的注意机制,并设计了一个类似于焦点损失[24]的损失函数。GRL[55]提出了一种基于RNN的分组递归学习方法,利用组内互斥和组间相关性。FAR还可以分为基于部分的方法和整体方法[38,12]。

ReID的目标是在一组查询行人图像中匹配目标人物。大量基于深度学习的ReID工作提供了很有前景的解决方案[48,8,4,2,9,37]。现有的一些识别方法依赖于利用判别特征,这与细粒度识别具有相同的精神。属性和ReID是高度相关的行人视觉外观表征,但在语义和粒度上有所不同。尽管它们是不同的任务,但它们的共同特征可以对两者都有利,这就是开发区别性特征。因此,联合处理是合理的。一些研究利用这两种信息进行多任务学习[42]或辅助主要任务[25,27]。这些方法可以概括为两类:(1)共享主干网和任务无关分支;(2)任务无关模型,并以某种方式组合高级特征(如级联FC)。例如,APR[25]同时学习ReID嵌入属性和行人属性,共享同一主干,拥有分类FC层。UF[42]为两个任务训练两个不同的模型,并为ReID将分支连接到一个恒等向量。这些方法在一定程度上结合了这两种特征。然而,由于属性识别与ReID本质上是不同的,因此不加区分地将它们纳入系数特征表示中并不是很有效。具有相似属性的人也可以是不同的身份。因此,需要一种更合理的方法来结合这两种信息。

2.度量学习

度量学习的目标[54,17]是学习一个合适的度量特征空间,使相似样本之间的距离减小,而不相似样本之间的距离增大。传统的度量学习算法[19]是基于线性变换、非线性模型等,而由于深度学习的最新进展,卷积神经网络已经成为学习特定任务度量的强大工具,在广泛的任务中取得了令人印象深刻的结果。在图像检索[50]、ReID[5]、人脸识别[40,44,29,53]等领域,已经提出了许多度量学习算法。比较有代表性的方法是对比损失和三重损失。

对比损失[10]限制了对的输入,使得相似对之间的距离尽可能接近,而不相似对之间的距离大于边距。Triplet loss[40]采用Triplet作为输入,保证(anchor, negative) feature和(anchor, positive) feature的距离差大于margin。除了三联损耗外,还引入了四联损耗[5]和五联损耗[13]以提高性能。中心损失[52]是专为人脸识别而设计的,力求将样本推到各自的聚类中心。我们通过对细粒度约束应用类间和类内三重损耗提出了HFE损耗

HFE算法介绍

问题的定义。给定N个图像{I1, I2,…, IN},每幅图像Ij有M个视觉属性标签yj = {yj1, yj2,…, yjM}与ReID标记lj。同一个人的图像被标记为相同的属性,即∀li=lj,yi = yj。ReID辅助属性识别的目的是训练一个包含属性和ID信息的模型来预测不可见图像Ik中人物特征的属性yk。

网络体系结构。如图2 (a)所示,本文提出的层次特征嵌入(hierarchical feature embedding, HFE)网络由一个主干模型组成,其中M个属性的M个分支连接在该骨干模型上。在共享主干中,模型学习了所有属性的共同特征嵌入。

对于每个属性,我们分别构造分支的原因有两个:(1)年龄、性别等不同属性应该有各自特定的特征嵌入。(2)我们为每个属性在各自的特征空间中构造度量损失,这不能应用于共享特征空间。例如,有两个来自不同id的图像I1和I2,属性是(长发,携带背包)和(长发,没有背包)。我们应该把他们拉近头发长度的特点,而把他们推到背包的特点。每个属性分支都包含conv-bn - relupool-fc序列层。计算了各分支的交叉熵损失和度量损失

损失计算。与大多数工作一样,我们对属性分类应用CE损失(Eq. 1)。此外,利用HFE loss进行权值w (Eq. 2)的辅助度量学习。HFE损耗包括inter-triplet loss, intra-triplet loss和绝对边界正则化,这将在下一节介绍。

提出的层次特征嵌入(HFE)框架的概述,它由一个主干模型组成,由M个分支连接M个属性。在各支路的五组选择基础上,计算了各支路的CE loss和HFE loss。(b)和(c)分别为三联体和五联体选择,其中橙色和蓝色分别表示不同的属性类。

1.Hierarchical Feature Embedding

triplet loss。triplet loss已广泛应用于度量学习。如图(b)所示,它对一系列{xa i, xp i, xn i}三元组进行训练,其中xa i和xp i是来自同一标签的图像特征,xn i是来自不同标签的图像特征。a、p、n分别是anchor、positive、negative sample的缩写。公式如下:

这里d(.)代表欧氏距离,α是使d(xa i, xn i)和d(xa i, xp i)的距离大于α的边界。[z]+表示最大(z, 0),当间隙大于α时,triplet losss为零

Inter-class 类间Triplet Loss。我们可以将triplet loss扩展到属性分类场景中。如Eq. 4所示,xa ij为样本Ii的第j个属性的特征,与xa ij的正、负样本的特征相关联,即xp3 ij, xn1 ij。这里我们在属性级别上定义三元组,α1是类间边界

我们batch采用困难样本模式[40]进行三元组选择。在每个batch,我们以最接近的负样本作为困难负样本![]() 和最远的困难正样本样本

和最远的困难正样本样本![]()

![]() ,也称为类内的三元组损失。

,也称为类内的三元组损失。

Intra-class 类内Triplet Loss. 利用属性类间triplet loss,可以分离类别间的特征嵌入。然而,每个类中的特征嵌入仍然混合在一起。直观上,外观相似或ID相同的样本特征应该比其他样本特征更接近。然而,如果在类内没有额外的约束,想获得较好的特征嵌入是不容易的。为了形成有序和细粒度的类内特征嵌入,我们利用ID信息来加强属于同一个人的特征,这些特征更紧密地聚集在一起。我们构建类内特性有两个原因:(1)类内triplet loss限制了来自同一个人的特征更紧密地聚集,使嵌入对场景变化更鲁棒。(2)在属性特征嵌入中,ID聚类可以很容易地解决属性而非ID的困难情况。这里我们引入了一种困难类内triplet loss,类似于困难类间triplet loss,而困难负样本被最接近的具有不同ID但相同属性的正样本代替。![]()

![]()

将困难正样本转化为具有相同ID(绝对具有相同属性)的最远正样本![]() ,类内triplet loss如式5所示,α2为类内边缘。

,类内triplet loss如式5所示,α2为类内边缘。

为了同时保持类间和类内特征嵌入的结构,我们考虑了类间和类内triplet loss。如图2 (c)所示,HFE损耗以五组样本{xa ij, xp ij1, xp ij2, xp ij3, xn ij1}为输入,管理维持多个相对关系,d(xa ij, xp ij1) < d(xa ij, xp ij2) < d(xa ij, xp ij3) <

d(xa ij, xn ij)。五组样本的摘要见表1。在类间和类内的约束下,我们可以构造一个层次特征嵌入,将属性信息和ID信息嵌入属性特征空间中

xa为anchor样本,xn1为不同ID不同属性,xp1为同ID同属性, xp2不同ID相同属性, xp3为不同ID相同属性

两组triplet loss,第一组计算XA和XP3,XN的损失,计算类间损失。第二组计算XA和XP1,XP2的损失,计算类内损失。

2.Absolute Boundary Regularization

triplet losss仅限制d(xa ij, xp ij)与d(xa ij, xn ij)的差值,而忽略绝对值。该差异依赖于批量选择的三元组,在整个训练数据集中很难保证d(xa ij, xp ij) < d(xa ij, xn ij)。

在我们的约束条件中,为了保证属性具有判别性的类内特征嵌入,我们从xa ij中提取相对于xp ij1的xp ij2。虽然margin α2 < α1,Lintra可以间接与类间边界相互作用。

考虑这两个因素,我们强迫d(xa ij, xn ij)大于绝对距离α3,称为绝对边界正则化(ABR)。

我们将Eq. 7中的这三个部分组成HFE loss,其目的是进行分层特征嵌入,不仅考虑类间特征,也考虑类内特征,不仅考虑相对距离,而且考虑绝对,以确保边界更有鉴别性。

3.Dynamic Loss Weight

在训练初期,特征空间不够好,无法进行五元组选择。因此,一开始对HFE loss施加较大的权值可能会放大了初始模型产生的噪声。为了解决这个问题,我们在一开始设置HFE loss的小权值,使原始的CE loss在训练优化中发挥主要作用,产生基本的特征空间。然后我们扩大权重,细化原始特征空间,使其更具有细粒度。因此,我们引入动态损失权值,对由[51]提出的复合函数进行非线性地控制从小到大的损失权值。式8中,T为训练总迭代次数,iter为当前迭代次数。w0是一个给定值

在训练过程中,我们将HFE loss的权值从0增加到给定值,迫使特征空间从原点逐步过渡到改进的HFE受限空间。

实验结果

4012

4012

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?